FTD(Firepower 위협 방어) 클러스터 문제 해결

다운로드 옵션

편견 없는 언어

본 제품에 대한 문서 세트는 편견 없는 언어를 사용하기 위해 노력합니다. 본 설명서 세트의 목적상, 편견 없는 언어는 나이, 장애, 성별, 인종 정체성, 민족 정체성, 성적 지향성, 사회 경제적 지위 및 교차성에 기초한 차별을 의미하지 않는 언어로 정의됩니다. 제품 소프트웨어의 사용자 인터페이스에서 하드코딩된 언어, RFP 설명서에 기초한 언어 또는 참조된 서드파티 제품에서 사용하는 언어로 인해 설명서에 예외가 있을 수 있습니다. 시스코에서 어떤 방식으로 포용적인 언어를 사용하고 있는지 자세히 알아보세요.

이 번역에 관하여

Cisco는 전 세계 사용자에게 다양한 언어로 지원 콘텐츠를 제공하기 위해 기계 번역 기술과 수작업 번역을 병행하여 이 문서를 번역했습니다. 아무리 품질이 높은 기계 번역이라도 전문 번역가의 번역 결과물만큼 정확하지는 않습니다. Cisco Systems, Inc.는 이 같은 번역에 대해 어떠한 책임도 지지 않으며 항상 원본 영문 문서(링크 제공됨)를 참조할 것을 권장합니다.

목차

소개

이 문서에서는 NGFW(Firepower Next-Generation Firewall)에서 클러스터 설정을 해결하는 방법에 대해 설명합니다.

사전 요구 사항

요구 사항

Cisco에서는 다음 항목에 대해 알고 있는 것이 좋습니다(링크는 관련 정보 섹션 참조).

- Firepower 플랫폼 아키텍처

- Firepower 클러스터 컨피그레이션 및 운영

- FTD 및 FXOS(Firepower eXtensible Operating System) CLI 숙지

- NGFW/데이터 플레인 로그

- NGFW/데이터 플레인 패킷 추적기

- FXOS/데이터 플레인 캡처

사용되는 구성 요소

- 하드웨어: Firepower 4125

- 소프트웨어: 6.7.0(빌드 65) - 데이터 플레인 9.15(1)

이 문서의 정보는 특정 랩 환경의 디바이스를 토대로 작성되었습니다. 이 문서에 사용된 모든 디바이스는 초기화된(기본) 컨피그레이션으로 시작되었습니다. 현재 네트워크가 작동 중인 경우 모든 명령의 잠재적인 영향을 미리 숙지하시기 바랍니다.

배경 정보

이 문서에서 다루는 대부분의 항목은 ASA(Adaptive Security Appliance) 클러스터 트러블슈팅에도 완전하게 적용됩니다.

구성

클러스터 구축의 컨피그레이션 부분은 FMC 및 FXOS 컨피그레이션 가이드에서 다룹니다.

클러스터 기본 사항

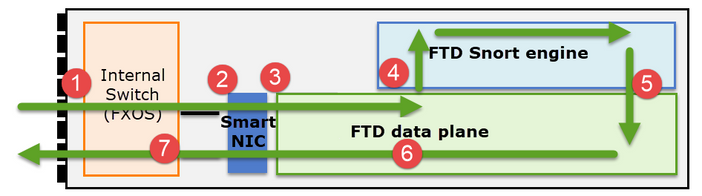

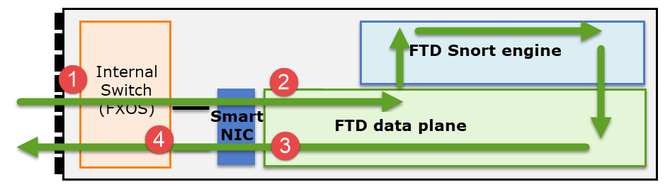

NGFW 아키텍처

firepower 41xx 또는 93xx 시리즈에서 전송 패킷을 처리하는 방법을 이해하는 것이 중요합니다.

- 패킷은 인그레스 인터페이스로 들어가며 섀시 내부 스위치에 의해 처리됩니다.

- 패킷이 Smart NIC를 통과합니다. 플로우가 오프로드된 경우(HW 가속), 패킷은 Smart NIC에 의해서만 처리된 다음 네트워크로 다시 전송됩니다.

- 패킷이 오프로드되지 않은 경우, 주로 L3/L4 검사를 수행하는 FTD 데이터 플레인으로 들어갑니다.

- 정책에 필요한 경우 Snort 엔진에서 패킷을 검사합니다(주로 L7 검사).

- Snort 엔진은 패킷에 대한 판정(예: 허용 또는 차단)을 반환합니다.

- 데이터 평면은 Snort의 판정을 기반으로 패킷을 삭제하거나 전달합니다.

- 패킷이 내부 섀시 스위치를 통해 섀시를 이그레스(egress)합니다.

클러스터 캡처

Firepower 어플라이언스는 전송 흐름에 대한 가시성을 제공하는 여러 캡처 지점을 제공합니다. 문제를 해결하고 클러스터를 활성화하면 다음과 같은 주요 문제가 발생합니다.

- 캡처 수는 클러스터의 유닛 수가 증가함에 따라 증가합니다.

- 클러스터가 특정 플로우를 처리하는 방법을 알아야 클러스터를 통해 패킷을 추적할 수 있습니다.

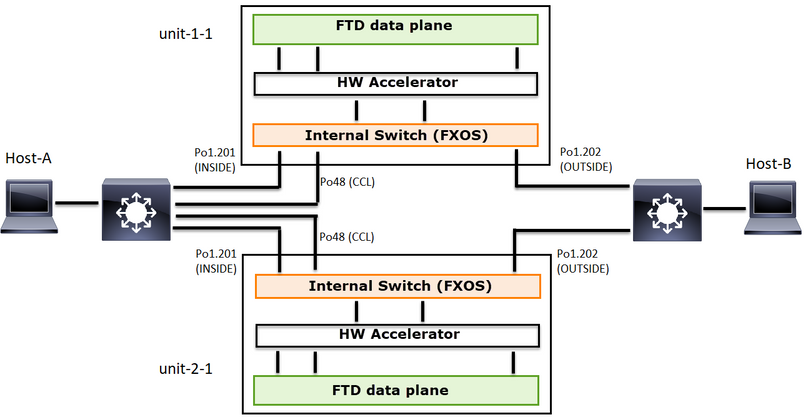

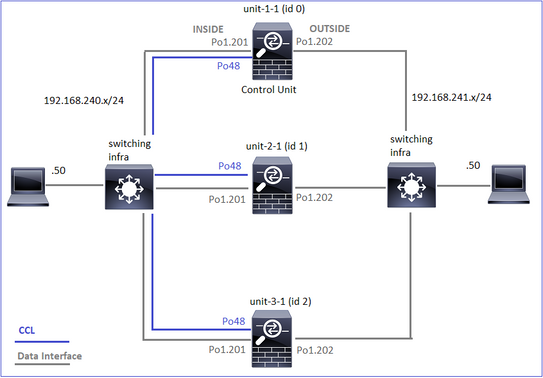

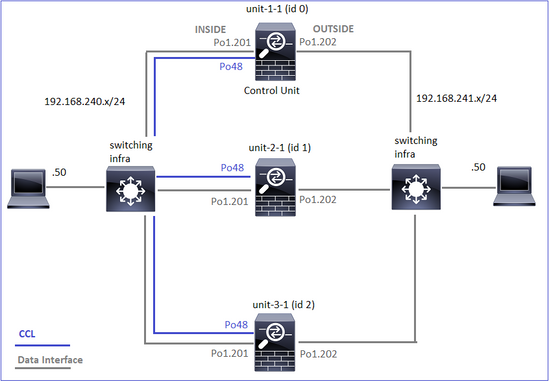

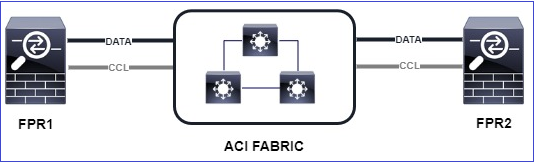

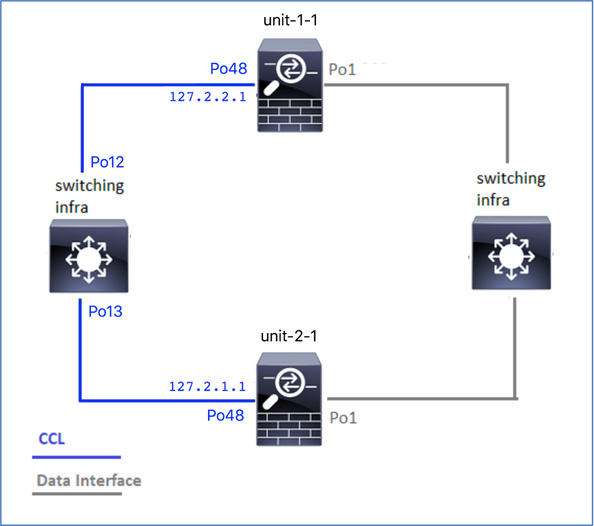

이 다이어그램은 2유닛 클러스터(예: FP941xx/FP9300)를 보여줍니다.

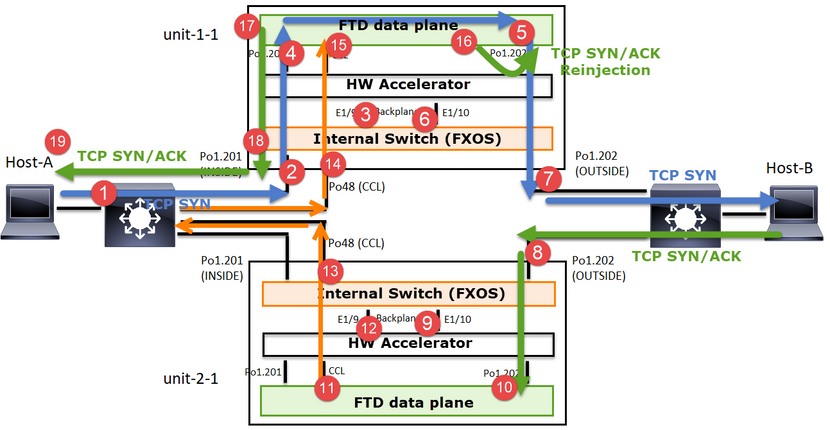

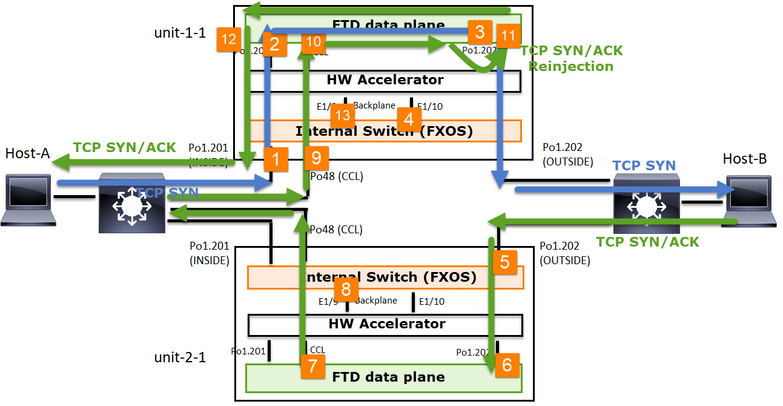

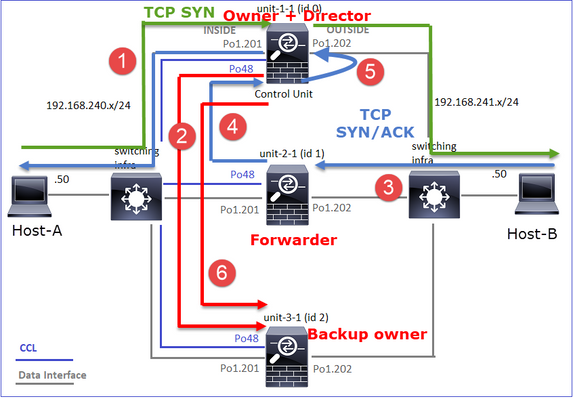

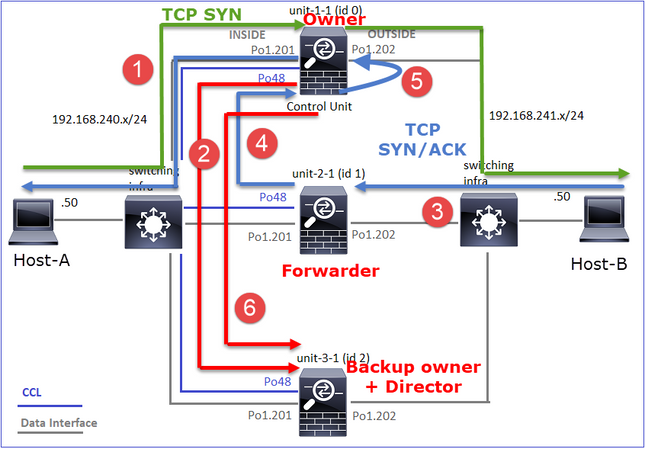

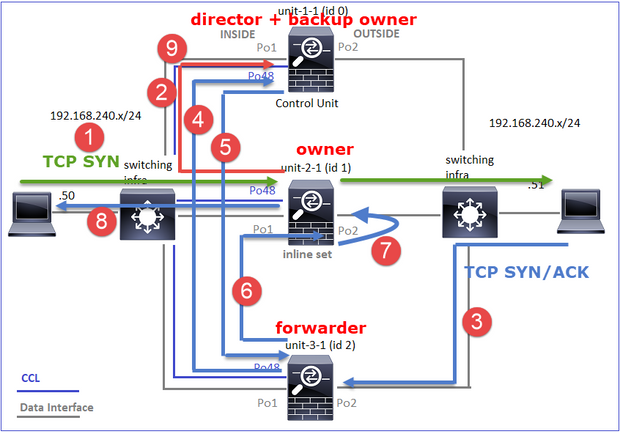

비대칭 TCP 연결 설정의 경우 TCP SYN, SYN/ACK 교환은 다음과 같습니다.

전달 트래픽

- TCP SYN은 Host-A에서 Host-B로 전송됩니다.

- TCP SYN이 섀시(Po1 멤버 중 하나)에 도착합니다.

- TCP SYN은 섀시 백플레인 인터페이스(예: E1/9, E1/10 등) 중 하나를 통해 데이터 플레인으로 전송됩니다.

- TCP SYN은 데이터 플레인 인그레스 인터페이스(Po1.201/INSIDE)에 도착합니다. 이 예에서 unit1-1은 플로우의 소유권을 가져오고, ISN(Initial Sequence Number) 임의 지정을 수행하고, 소유권(쿠키) 정보를 Seq 번호로 인코딩합니다.

- TCP SYN은 Po1.202/OUTSIDE(데이터 플레인 이그레스 인터페이스)에서 전송됩니다.

- TCP SYN은 섀시 백플레인 인터페이스(예: E1/9, E1/10 등) 중 하나에 도착합니다.

- TCP SYN은 섀시 물리적 인터페이스(Po1 멤버 중 하나)에서 Host-B로 전송됩니다.

반환 트래픽

- TCP SYN/ACK가 Host-B에서 전송되어 unit-2-1(Po1의 멤버 중 하나)에 도착합니다.

- TCP SYN/ACK는 섀시 백플레인 인터페이스 중 하나(예: E1/9, E1/10 등)를 통해 데이터 플레인으로 전송됩니다.

- TCP SYN/ACK가 데이터 플레인 인그레스 인터페이스(Po1.202/OUTSIDE)에 도착합니다.

- TCP SYN/ACK가 CCL(Cluster Control Link)에서 유닛-1-1로 전송됩니다. 기본적으로 ISN이 활성화되어 있습니다. 따라서 전달자는 디렉터의 개입 없이 TCP SYN+ACK에 대한 소유자 정보를 찾습니다. 다른 패킷의 경우 또는 ISN이 비활성화된 경우 디렉터를 쿼리합니다.

- TCP SYN/ACK는 섀시 백플레인 인터페이스(예: E1/9, E1/10 등) 중 하나에 도착합니다.

- TCP SYN/ACK는 섀시 물리적 인터페이스(Po48 멤버 중 하나)에서 unit-1-1로 전송됩니다.

- TCP SYN/ACK가 unit-1-1(Po48 멤버 중 하나)에 도착합니다.

- TCP SYN/ACK는 섀시 백플레인 인터페이스 중 하나를 통해 데이터 플레인 CCL 포트 채널 인터페이스(nameif 클러스터)로 전달됩니다.

- 데이터 플레인에서는 TCP SYN/ACK 패킷을 데이터 플레인 인터페이스 Po1.202/OUTSIDE로 다시 전달합니다.

- TCP SYN/ACK는 Po1.201/INSIDE(데이터 플레인 이그레스 인터페이스)에서 HOST-A로 전송됩니다.

- TCP SYN/ACK는 섀시 백플레인 인터페이스 중 하나(예: E1/9, E1/10 등)를 통과하고 Po1의 멤버 중 하나를 이그레스(egress)합니다.

- TCP SYN/ACK가 호스트 A에 도착합니다.

이 시나리오에 대한 자세한 내용은 Cluster Connection Establishment Case Studies(클러스터 연결 설정 사례 연구)의 관련 섹션을 참조하십시오.

이 패킷 교환을 기반으로 가능한 모든 클러스터 캡처 포인트는 다음과 같습니다.

전달 트래픽(예: TCP SYN) 캡처의 경우

- 섀시 물리적 인터페이스(예: Po1 멤버). 이 캡처는 CM(Chassis Manager) UI 또는 CM CLI에서 구성합니다.

- 데이터 플레인 인그레스 인터페이스(예: Po1.201 INSIDE).

- 데이터 플레인 이그레스 인터페이스(예: Po1.202 OUTSIDE).

- 섀시 백플레인 인터페이스. FP4100에는 2개의 백플레인 인터페이스가 있습니다. FP9300에는 총 6개(모듈당 2개)가 있습니다. 패킷이 어느 인터페이스에 도착하는지 알 수 없으므로 모든 인터페이스에서 캡처를 활성화해야 합니다.

반환 트래픽(예: TCP SYN/ACK) 캡처의 경우

- 섀시 물리적 인터페이스(예: Po1 멤버). 이 캡처는 CM(Chassis Manager) UI 또는 CM CLI에서 구성합니다.

- 데이터 평면 인그레스 인터페이스(예: Po1.202 OUTSIDE).

- 패킷이 리디렉션되므로 다음 캡처 포인트는 데이터 플레인 CCL입니다.

- 섀시 백플레인 인터페이스. 두 인터페이스에서 모두 캡처를 활성화해야 합니다.

- Unit-1-1 섀시 CCL 멤버 인터페이스.

- 데이터 플레인 CCL 인터페이스(nameif 클러스터).

- 인그레스 인터페이스(Po1.202 OUTSIDE) CCL에서 데이터 평면으로 재삽입된 패킷입니다.

- 데이터 플레인 이그레스 인터페이스(예: Po1.201 INSIDE).

- 섀시 백플레인 인터페이스.

클러스터 캡처를 활성화하는 방법

FXOS 캡처

이 프로세스는 FXOS 컨피그레이션 가이드에서 설명합니다. 패킷 캡처

참고: FXOS 캡처는 내부 스위치 관점에서 인그레스 방향으로만 수행할 수 있습니다.

데이터 플레인 캡처

모든 클러스터 멤버에서 캡처를 활성화하는 권장 방법은 cluster exec 명령을 사용하는 것입니다.

3-유닛 클러스터를 고려합니다.

모든 클러스터 유닛에 활성 캡처가 있는지 확인하려면 다음 명령을 사용합니다.

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Po1.201(INSIDE)의 모든 유닛에서 데이터 플레인 캡처를 활성화하려면 다음을 수행합니다.

firepower# cluster exec capture CAPI interface INSIDE

캡처 필터를 지정하고, 트래픽이 많을 것으로 예상되는 경우 캡처 버퍼를 늘리는 것이 좋습니다.

firepower# cluster exec capture CAPI buffer 33554432 interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

확인

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 5140 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 260 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

모든 캡처의 내용을 보려면(이 출력은 매우 길 수 있음)

firepower# terminal pager 24

firepower# cluster exec show capture CAPI

unit-1-1(LOCAL):******************************************************

21 packets captured

1: 11:33:09.879226 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: S 2225395909:2225395909(0) win 29200 <mss 1460,sackOK,timestamp 1110209649 0,nop,wscale 7>

2: 11:33:09.880401 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45456: S 719653963:719653963(0) ack 2225395910 win 28960 <mss 1380,sackOK,timestamp 1120565119 1110209649,nop,wscale 7>

3: 11:33:09.880691 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: . ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

4: 11:33:09.880783 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: P 2225395910:2225396054(144) ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

unit-2-1:*************************************************************

0 packet captured

0 packet shown

unit-3-1:*************************************************************

0 packet captured

0 packet shown

추적 캡처

각 유닛의 데이터 플레인에서 인그레스 패킷을 처리하는 방법을 보려면 trace 키워드를 사용합니다. 그러면 처음 50개의 인그레스 패킷이 추적됩니다. 최대 1000개의 인그레스 패킷을 추적할 수 있습니다.

참고: 인터페이스에 여러 캡처가 적용된 경우 단일 패킷을 한 번만 추적할 수 있습니다.

모든 클러스터 유닛의 인터페이스 OUTSIDE에서 첫 1,000개의 인그레스 패킷을 추적하려면

firepower# cluster exec cap CAPO int OUTSIDE buff 33554432 trace trace-count 1000 match tcp host 192.168.240.50 host 192.168.241.50 eq www

관심 플로우를 캡처한 후에는 각 유닛의 관심 패킷을 추적해야 합니다. 기억해야 할 중요한 것은 특정 패킷을 유닛-1-1에 #1 수 있지만 다른 유닛에 #2 수 있다는 것입니다.

이 예에서는 SYN/ACK가 unit-2-1에서는 패킷 #2, unit-3-1에서는 패킷 #1을 확인할 수 있습니다.

firepower# cluster exec show capture CAPO | include S.*ack

unit-1-1(LOCAL):******************************************************

1: 12:58:31.117700 802.1Q vlan#202 P0 192.168.240.50.45468 > 192.168.241.50.80: S 441626016:441626016(0) win 29200 <mss 1380,sackOK,timestamp 1115330849 0,nop,wscale 7>

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

로컬 유닛에서 패킷 #2(SYN/ACK)를 추적하려면 다음을 수행합니다.

firepower# cluster exec show cap CAPO packet-number 2 trace

unit-1-1(LOCAL):******************************************************

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

원격 유닛에서 동일한 패킷(SYN/ACK)을 추적하려면

firepower# cluster exec unit unit-3-1 show cap CAPO packet-number 1 trace

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

CCL 캡처

CCL 링크(모든 장치에서)에서 캡처를 활성화하려면

firepower# cluster exec capture CCL interface cluster

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

다시 삽입 숨기기

기본적으로 데이터 플레인 데이터 인터페이스에서 활성화된 캡처는 모든 패킷을 표시합니다.

- 물리적 네트워크에서 전송되는 것은

- CCL에서 재삽입된 것

재삽입된 패킷을 표시하지 않으려면 reinject-hide 옵션을 사용합니다. 이는 플로우가 비대칭적인지 확인하려는 경우 유용할 수 있습니다.

firepower# cluster exec capture CAPI_RH reinject-hide interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

이 캡처는 로컬 유닛이 실제로 특정 인터페이스에서 다른 클러스터 유닛이 아닌 물리적 네트워크로부터 직접 수신한 것을 보여줍니다.

ASP 삭제

특정 흐름에 대한 소프트웨어 삭제를 확인하려면 asp-drop capture를 활성화할 수 있습니다. 초점을 두어야 할 삭제 이유를 모를 경우 all 키워드를 사용합니다. 또한 패킷 페이로드에 관심이 없는 경우 headers-only 키워드를 지정할 수 있습니다. 이렇게 하면 20-30배 많은 패킷을 캡처할 수 있습니다.

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

또한 ASP 캡처에서 원하는 IP를 지정할 수 있습니다.

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only match ip host 192.0.2.100 any

캡처 지우기

모든 클러스터 단위로 실행되는 모든 캡처의 버퍼를 지웁니다. 이렇게 하면 캡처가 중지되지 않고 버퍼만 지워집니다.

firepower# cluster exec clear capture /all

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

캡처 중지

모든 클러스터 유닛에서 활성 캡처를 중지하는 방법에는 두 가지가 있습니다. 나중에 다시 시작할 수 있습니다.

방법 1

firepower# cluster exec cap CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

다시 시작하려면

firepower# cluster exec no capture CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

2단계

firepower# cluster exec no capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

다시 시작하려면

firepower# cluster exec capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

캡처 수집

캡처를 내보내는 방법에는 여러 가지가 있습니다.

방법 1 - 원격 서버로

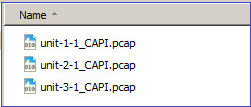

이렇게 하면 데이터 플레인에서 원격 서버(예: TFTP)로 캡처를 업로드할 수 있습니다. 소스 유닛을 반영하도록 캡처 이름이 자동으로 변경됩니다.

firepower# cluster exec copy /pcap capture:CAPI tftp://192.168.240.55/CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Address or name of remote host [192.168.240.55]?

Destination filename [CAPI.pcap]?

INFO: Destination filename is changed to unit-1-1_CAPI.pcap !!!!!!!

81 packets copied in 0.40 secs

unit-2-1:*************************************************************

INFO: Destination filename is changed to unit-2-1_CAPI.pcap !

unit-3-1:*************************************************************

INFO: Destination filename is changed to unit-3-1_CAPI.pcap !

업로드된 pcap 파일:

Way 2 - FMC에서 캡처 가져오기

이 방법은 FTD에만 적용됩니다. 먼저 캡처를 FTD 디스크에 복사합니다.

firepower# cluster exec copy /pcap capture:CAPI disk0:CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Destination filename [CAPI.pcap]?

!!!!!

62 packets copied in 0.0 secs

expert 모드에서 파일을 /mnt/disk0/에서 /ngfw/var/common/ 디렉토리로 복사합니다.

> expert

admin@firepower:~$ cd /mnt/disk0

admin@firepower:/mnt/disk0$ sudo cp CAPI.pcap /ngfw/var/common

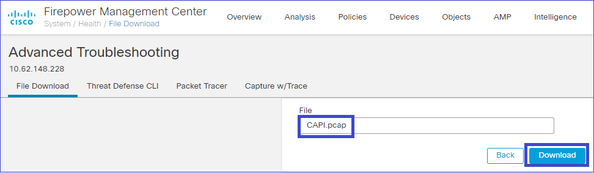

마지막으로 FMC에서 System > Health > Monitor 섹션으로 이동합니다. View System & Troubleshoot Details(시스템 및 문제 해결 세부사항 보기) > Advanced Troubleshooting(고급 문제 해결)을 선택하고 캡처 파일을 가져옵니다.

캡처 삭제

모든 클러스터 유닛에서 캡처를 제거하려면 다음 명령을 사용합니다.

firepower# cluster exec no capture CAPI

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

오프로드된 플로우

FP41xx/FP9300에서 플로우는 정적(예: Fastpath 규칙) 또는 동적으로 HW Accelerator로 오프로드될 수 있습니다. 플로우 오프로드에 대한 자세한 내용은 다음 문서를 참조하십시오.

플로우가 오프로드되면 일부 패킷만 FTD 데이터 플레인을 통과합니다. 나머지는 HW 가속기(Smart NIC)에서 처리합니다.

캡처 관점에서 보면, 이는 FTD 데이터 플레인 레벨 캡처만 활성화할 경우 디바이스를 통과하는 모든 패킷이 표시되지 않음을 의미합니다. 이 경우 FXOS 섀시 레벨 캡처도 활성화해야 합니다.

CCL(Cluster Control Link) 메시지

CCL에서 캡처를 수행하면 클러스터 유닛에서 서로 다른 유형의 메시지를 교환하는 것을 확인할 수 있습니다. 관심 분야:

| 프로토콜 |

설명 |

| UDP 49495 |

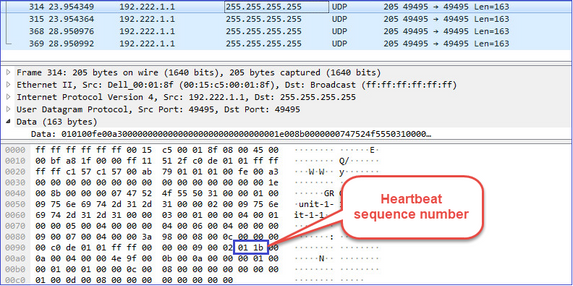

클러스터 하트비트(킵얼라이브) · L3 브로드캐스트(255.255.255.255) · 이러한 패킷은 모든 클러스터 유닛에서 상태 점검 보류 시간 값의 1/3로 전송됩니다. · 캡처에 표시된 모든 UDP 49495 패킷이 하트비트는 아닙니다 · 하트비트에는 시퀀스 번호가 포함됩니다. |

| UDP 4193 |

클러스터 제어 프로토콜 데이터 경로 메시지 ·유니캐스트 · 이러한 패킷에는 플로우 소유자, 디렉터, 백업 소유자 등에 대한 정보(메타데이터)가 포함됩니다. 예: · 새 플로우가 생성되면 소유자로부터 디렉터로 '클러스터 추가' 메시지가 전송됩니다. · 플로우가 종료되면 소유자로부터 디렉터로 '클러스터 삭제' 메시지가 전송됩니다. |

| 데이터 패킷 |

클러스터를 통과하는 다양한 트래픽 흐름에 속하는 데이터 패킷 |

클러스터 하트비트

CCP(Cluster Control Point) 메시지

하트비트 메시지 외에도 특정 시나리오에서 CCL을 통해 교환되는 다수의 클러스터 제어 메시지가 있습니다. 일부는 유니캐스트 메시지이고 다른 일부는 브로드캐스트입니다.

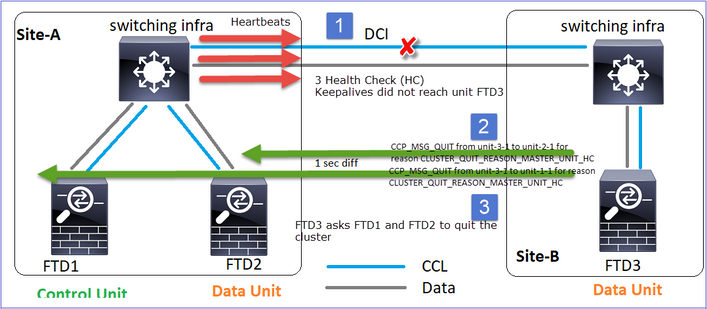

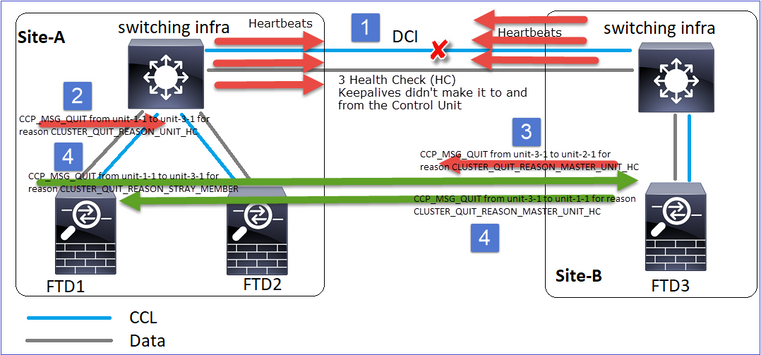

CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

유닛이 제어 노드에서 3개의 연속 하트비트 메시지를 잃을 때마다 CCL을 통해 CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC 메시지를 생성합니다. 이 메시지는 다음과 같습니다.

- 유니캐스트

- 각 유닛에 1초 간격으로 전송됩니다.

- 유닛에서 이 메시지를 수신하면 클러스터를 종료하고(DISABLED) 다시 조인합니다.

Q. CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC의 목적은 무엇입니까?

A. unit-3-1(Site-B)의 관점에서 볼 때 사이트 A에서 unit-1-1 및 unit-2-1에 대한 연결이 모두 끊기므로 가능한 한 빨리 구성원 목록에서 제거해야 합니다. 그렇지 않으면 unit-2-1이 여전히 구성원 목록에 있고 unit-2-1이 연결의 디렉터인 경우 패킷이 손실될 수 있으며 unit-2-1에 대한 흐름 쿼리가 실패합니다.

CLUSTER_QUIT_REASON_UNIT_HC

제어 노드는 데이터 노드에서 3개의 연속 하트비트 메시지를 잃을 때마다 CCL을 통해 CLUSTER_QUIT_REASON_UNIT_HC 메시지를 전송합니다. 이 메시지는 유니캐스트입니다.

CLUSTER_QUIT_REASON_STRAY_MEMBER

분할 파티션이 피어 파티션과 다시 연결되면, 새로운 데이터 노드는 우세 제어 유닛에 의해 미처 멤버로 취급되며 CLUSTER_QUIT_REASON_STRAY_MEMBER를 이유로 하는 CCP 종료 메시지를 받습니다.

CLUSTER_QUIT_MEMBER_DROPOUT

데이터 노드에 의해 생성되고 브로드캐스트로 전송되는 브로드캐스트 메시지입니다. 유닛에서 이 메시지를 수신하면 DISABLED 상태로 이동합니다. 또한 자동 재연결은 킥오프되지 않습니다.

firepower# show cluster info trace | include DROPOUT

Nov 04 00:22:54.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:22:53.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

클러스터 내역은 다음과 같습니다.

PRIMARY DISABLED Received control message DISABLE (member dropout announcement)

HC(Cluster Health-Check) 메커니즘

중요 사항

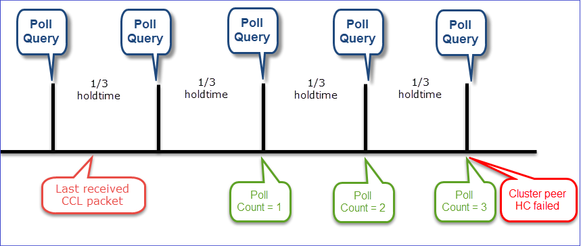

- 각 클러스터 유닛은 상태 확인 보류 시간 값의 1/3마다 하트비트를 다른 모든 유닛(브로드캐스트 255.255.255.255)으로 전송하고 CCL을 통한 전송으로 UDP 포트 49495을 사용합니다.

- 각 클러스터 유닛은 Poll 타이머와 Poll 카운트 값을 사용하여 다른 모든 유닛을 독립적으로 추적합니다.

- 클러스터 유닛이 하트비트 간격 내에 클러스터 피어 유닛으로부터 어떤 패킷(하트비트 또는 데이터 패킷)도 수신하지 못하면 Poll count 값이 증가합니다.

- 클러스터 피어 유닛의 폴링 카운트 값이 3이 되면 피어는 중단된 것으로 간주됩니다.

- 하트비트가 수신될 때마다, 그 시퀀스 번호가 체크되고 이전에 수신된 하트비트와의 차이가 1과 다른 경우, 하트비트 드롭 카운터가 그에 따라 증가한다.

- 클러스터 피어에 대한 Poll 카운트 카운터가 0과 다르고 피어에서 패킷을 수신하면 카운터가 0으로 재설정됩니다.

클러스터 상태 카운터를 확인하려면 다음 명령을 사용합니다.

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 650| 0| 4999| 1| 0|

| unit-3-1 ( 2)| 650| 0| 4999| 1| 0|

----------------------------------------------------------------------------------

기본 열에 대한 설명

| 열 |

설명 |

| 장치(ID) |

원격 클러스터 피어의 ID입니다. |

| 하트비트 수 |

CCL을 통해 원격 피어에서 받은 하트비트 수입니다. |

| 하트비트 삭제 |

누락된 하트비트 수입니다. 이 카운터는 수신된 하트비트 시퀀스 번호에 기초하여 계산된다. |

| 평균 격차 |

수신된 하트비트의 평균 시간 간격입니다. |

| 폴링 카운트 |

이 카운터가 3이 되면 유닛이 클러스터에서 제거됩니다. 폴링 쿼리 간격은 하트비트 간격과 동일하지만 독립적으로 실행됩니다. |

카운터를 재설정하려면 다음 명령을 사용합니다.

firepower# clear cluster info health details

Q. 하트비트 빈도를 어떻게 확인합니까?

A. 평균 간격 값을 확인합니다.

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 3036| 0| 999| 1| 0|

----------------------------------------------------------------------------------

Q. FTD에서 클러스터 보류 시간을 변경하려면 어떻게 해야 합니까?

A. FlexConfig 사용

Q. 스플릿 브레인 후 누가 제어 노드가 됩니까?

A. 우선순위가 가장 높은(가장 낮은) 장치:

firepower# show run cluster | include priority

priority 9

자세한 내용은 HC 실패 시나리오 1을 참조하십시오.

클러스터 HC 메커니즘 시각화

알림 타이머: 최소값과 최대값은 마지막으로 수신된 CCL 패킷 도착에 따라 달라집니다.

| 보류 시간 |

쿼리 검사 폴링 (빈도) |

최소 탐지 시간 |

최대 탐지 시간 |

| 3초(기본값) |

~1초 |

~3.01초 |

~3.99초 |

| 4초 |

~1.33초 |

~4.01초 |

~5.32초 |

| 5초 |

~1.66초 |

~5.01초 |

~6.65초 |

| 6초 |

~2초 |

~6.01초 |

~7.99초 |

| 7초 |

~2.33초 |

~7.01초 |

~9.32초 |

| 8초 |

~2.66초 |

~8.01초 |

~10.65초 |

클러스터 HC 오류 시나리오

이 섹션의 목표는 다음을 시연하는 것입니다.

- 다른 클러스터 HC 실패 시나리오

- 서로 다른 로그와 명령 출력의 상관 관계 분석 방법

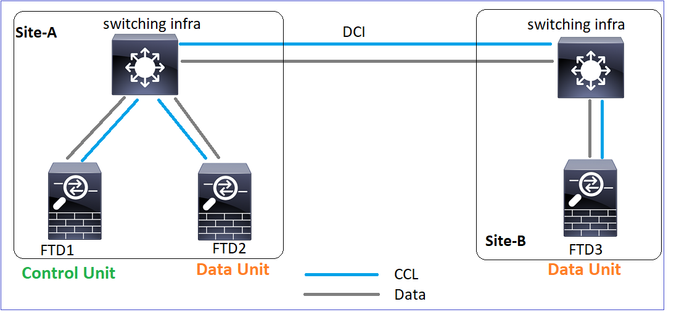

토폴로지

클러스터 컨피그레이션

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

cluster group GROUP1 |

cluster group GROUP1 |

cluster group GROUP1 |

클러스터 상태

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

시나리오 1

양방향으로 ~4초 이상 CCL 통신 손실이 발생했습니다.

실패 전

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 제어 노드 |

데이터 노드 |

데이터 노드 |

복구 후(유닛 역할이 변경되지 않음)

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 제어 노드 |

데이터 노드 |

데이터 노드 |

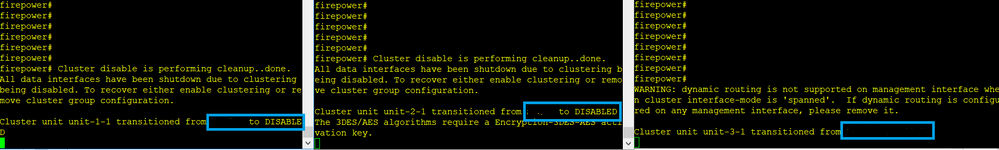

분석

실패(CCL 통신이 끊김).

unit-3-1의 데이터 플레인 콘솔 메시지:

firepower#

WARNING: dynamic routing is not supported on management interface when cluster interface-mode is 'spanned'.

If dynamic routing is configured on any management interface, please remove it.

Cluster unit unit-3-1 transitioned from SECONDARY to PRIMARY

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled.

To recover either enable clustering or remove cluster group configuration.

Unit-1-1 클러스터 추적 로그:

firepower# show cluster info trace | include unit-3-1

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8918307fb 0x000055a8917fc6e8 0x000055a8917f79b5

Nov 02 09:38:14.239 [INFO]FTD - CD proxy received state notification (DISABLED) from unit unit-3-1

Nov 02 09:38:14.239 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8917eb596 0x000055a8917f4838 0x000055a891abef9d

Nov 02 09:38:14.239 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Nov 02 09:38:14.239 [CRIT]Received heartbeat event 'SECONDARY heartbeat failure' for member unit-3-1 (ID: 1).

스플릿 브레인

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

클러스터 기록

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

| 이벤트 없음 |

이벤트 없음 |

09:38:16 UTC Nov 2 2020 |

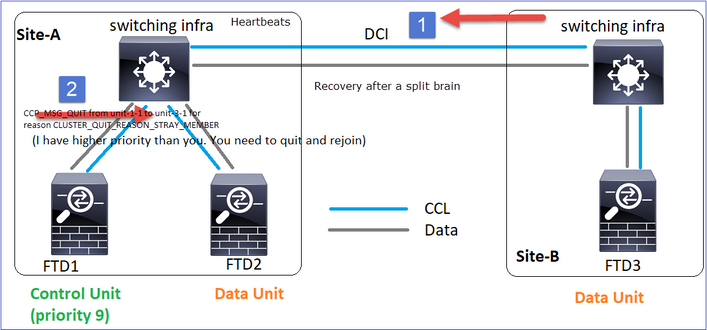

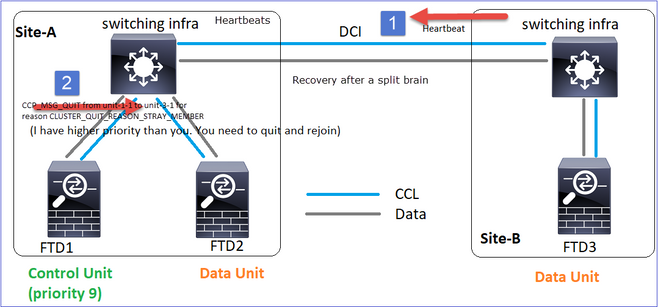

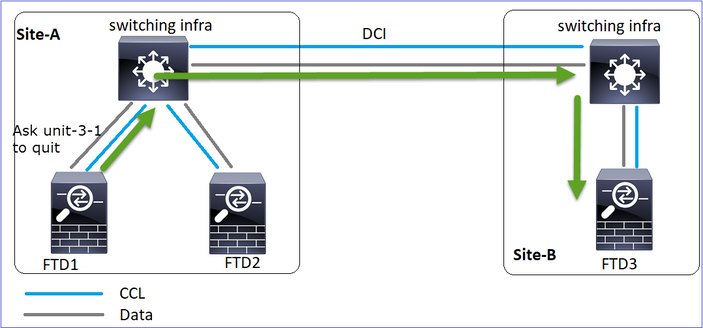

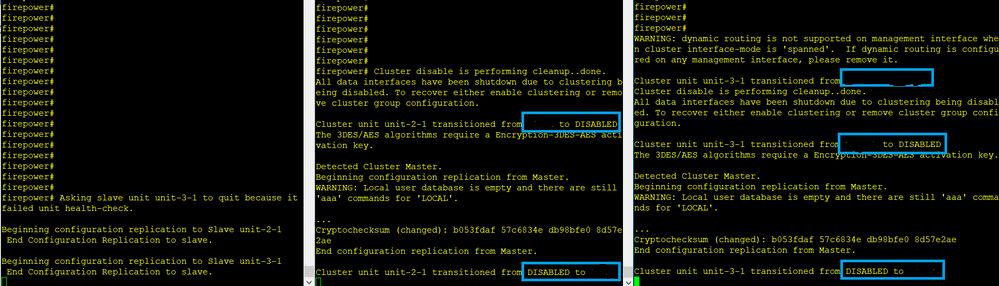

CCL 통신 복원

Unit-1-1은 현재 제어 노드를 탐지하며, unit-1-1의 우선순위가 더 높기 때문에 유닛-3-1에 CLUSTER_QUIT_REASON_STRAY_MEMBER 메시지를 보내 새 선택 프로세스를 트리거합니다. 결국 unit-3-1은 데이터 노드로 다시 합류하게 된다.

스플릿 파티션이 피어 파티션과 다시 연결되면, 데이터 노드는 우세 제어 노드에 의해 스트레이 멤버로 취급되며 CLUSTER_QUIT_REASON_STRAY_MEMBER를 이유로 하는 CCP quit 메시지를 받습니다.

Unit-3-1 console logs show:

Cluster unit unit-3-1 transitioned from PRIMARY to DISABLED

The 3DES/AES algorithms require a Encryption-3DES-AES activation key.

Detected Cluster Primart.

Beginning configuration replication from Primary.

WARNING: Local user database is empty and there are still 'aaa' commands for 'LOCAL'.

..

Cryptochecksum (changed): a9ed686f 8e2e689c 2553a104 7a2bd33a

End configuration replication from Primary.

Cluster unit unit-3-1 transitioned from DISABLED to SECONDARY

두 유닛(unit-1-1 및 unit-3-1) 모두 클러스터 로그에 표시됩니다.

firepower# show cluster info trace | include retain

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

스플릿 브레인에 대해 생성되는 syslog 메시지도 있습니다.

firepower# show log | include 747016

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

클러스터 기록

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

| 이벤트 없음 |

이벤트 없음 |

09:47:33 UTC Nov 2 2020 |

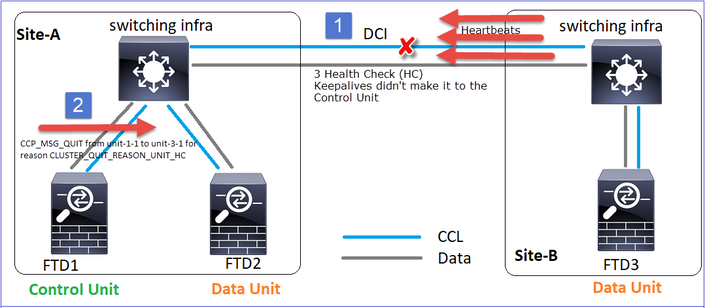

시나리오 2

양방향으로 ~3-4초 동안 CCL 통신 손실이 발생했습니다.

실패 전

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 제어 노드 |

데이터 노드 |

데이터 노드 |

복구 후(유닛 역할이 변경되지 않음)

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 제어 노드 |

데이터 노드 |

데이터 노드 |

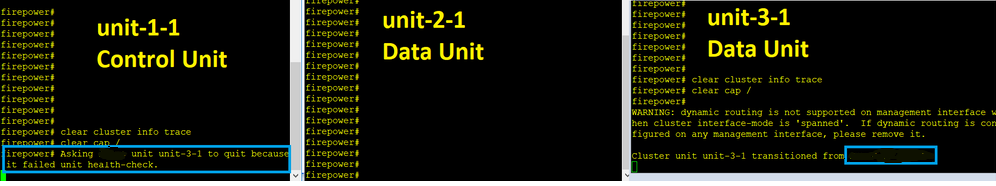

분석

이벤트 1: 제어 노드는 유닛-3-1에서 3 개의 HC를 손실하고 유닛-3-1로 메시지를 보내 클러스터를 떠난다.

이벤트 2: CCL이 매우 빠르게 복구되었고 제어 노드의 CLUSTER_QUIT_REASON_STRAY_MEMBER 메시지가 원격 측에 전달되었습니다. Unit-3-1은 DISABLED 모드로 직접 전환되며 스플릿 브레인(split-brain)이 없습니다.

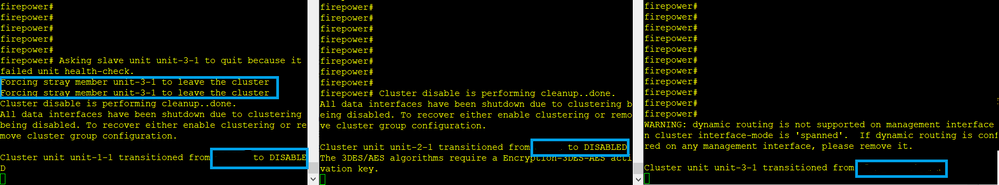

unit-1-1(control)에서 다음을 볼 수 있습니다.

firepower#

Asking SECONDARY unit unit-3-1 to quit because it failed unit health-check.

Forcing stray member unit-3-1 to leave the cluster

unit-3-1(데이터 노드)에서 다음을 볼 수 있습니다.

firepower#

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled. To recover either enable clustering or remove cluster group configuration.

Cluster unit unit-3-1 transitioned from SECONDARY to DISABLED

클러스터 유닛 unit-3-1이 DISABLED 상태로 전환되었으며 CCL 통신이 복원되면 데이터 노드로 다시 연결됩니다.

firepower# show cluster history

20:58:40 UTC Nov 1 2020

SECONDARY DISABLED Received control message DISABLE (stray member)

20:58:45 UTC Nov 1 2020

DISABLED ELECTION Enabled from CLI

20:58:45 UTC Nov 1 2020

ELECTION SECONDARY_COLD Received cluster control message

20:58:45 UTC Nov 1 2020

SECONDARY_COLD SECONDARY_APP_SYNC Client progression done

20:59:33 UTC Nov 1 2020

SECONDARY_APP_SYNC SECONDARY_CONFIG SECONDARY application configuration sync done

20:59:44 UTC Nov 1 2020

SECONDARY_CONFIG SECONDARY_FILESYS Configuration replication finished

20:59:45 UTC Nov 1 2020

SECONDARY_FILESYS SECONDARY_BULK_SYNC Client progression done

21:00:09 UTC Nov 1 2020

SECONDARY_BULK_SYNC SECONDARY Client progression done

시나리오 3

양방향으로 ~3-4초 동안 CCL 통신 손실이 발생했습니다.

실패하기 전에요

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 제어 노드 |

데이터 노드 |

데이터 노드 |

복구 후(제어 노드가 변경됨).

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 데이터 노드 |

제어 노드 |

데이터 노드 |

분석

- CCL이 다운되었습니다.

- Unit-1-1은 unit-3-1에서 3개의 HC 메시지를 받지 못하고 unit-3-1로 QUIT 메시지를 보냅니다. 이 메시지는 unit-3-1에 도달하지 않습니다.

- 장치-3-1은 장치-2-1에 QUIT 메시지를 보냅니다. 이 메시지는 장치-2-1에 도달하지 않습니다.

CCL 복구.

- Unit-1-1은 유닛-3-1이 자신을 제어 노드로 광고한 것을 확인하고 QUIT_REASON_STRAY_MEMBER 메시지를 유닛-3-1로 보냅니다. 유닛-3-1이 이 메시지를 DISABLED 상태로 전환하면 됩니다. 그와 동시에 unit-3-1은 QUIT_REASON_PRIMARY_UNIT_HC 메시지를 unit-1-1로 전송하여 종료를 요청합니다. unit-1-1에서 이 메시지를 가져오면 DISABLED 상태가 됩니다.

클러스터 기록

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

19:53:09 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

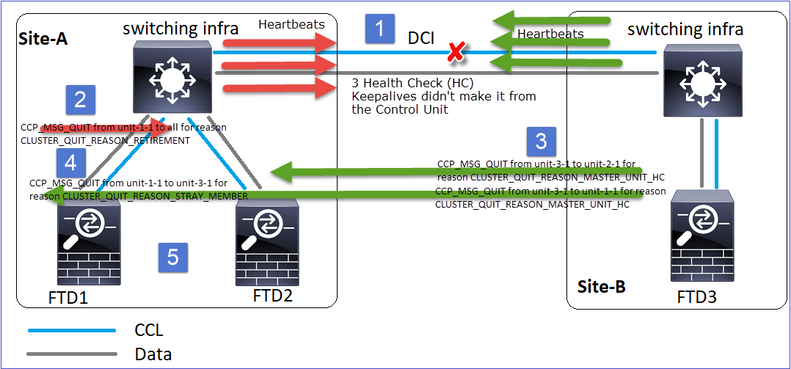

시나리오 4

~3~4초 동안 CCL 통신 손실

실패 전

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 제어 노드 |

데이터 노드 |

데이터 노드 |

복구 후(제어 노드가 사이트를 변경함)

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 데이터 노드 |

데이터 노드 |

제어 노드 |

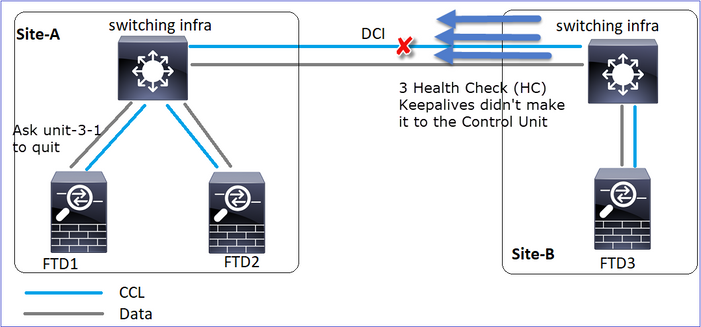

분석

실패

같은 실패의 다른 취향. 이 경우 unit-1-1도 unit-3-1로부터 3개의 HC 메시지를 받지 못했고, 일단 새 keepalive가 생기고 나면 STRAY 메시지를 사용하여 unit-3-1을 종료하려고 했지만 메시지가 유닛-3-1에 전달되지 않았습니다.

- CCL은 몇 초 동안 단방향이 됩니다. Unit-3-1은 상기 unit-1-1로부터 3개의 HC 메시지를 수신하지 못하고 제어 노드가 된다.

- Unit-2-1은 CLUSTER_QUIT_REASON_RETIREMENT 메시지(브로드캐스트)를 전송합니다.

- Unit-3-1은 QUIT_REASON_PRIMARY_UNIT_HC 메시지를 unit-2-1로 전송합니다. Unit-2-1은 이를 수신하여 클러스터를 종료합니다.

- Unit-3-1은 QUIT_REASON_PRIMARY_UNIT_HC 메시지를 unit-1-1로 전송합니다. Unit-1-1은 이를 수신하여 클러스터를 종료합니다. CCL 복구.

- 유닛-1-1 및 유닛-2-1은 데이터 노드로 클러스터에 다시 가입합니다.

참고: 5단계에서 CCL이 복구되지 않으면 site-A에서 FTD1이 새 제어 노드가 되고, CCL 복구 후 새 선택에서 승리합니다.

유닛 1-1의 Syslog 메시지:

firepower# show log | include 747

Nov 03 2020 23:13:08: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-3-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:09: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY to DISABLED

Nov 03 2020 23:13:12: %FTD-7-747006: Clustering: State machine is at state DISABLED

Nov 03 2020 23:13:12: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MY_STATE (state DISABLED,0x0000000000000000,0x0000000000000000)

Nov 03 2020 23:13:18: %FTD-6-747004: Clustering: State machine changed from state ELECTION to ONCALL

유닛 1-1의 클러스터 추적 로그:

firepower# show cluster info trace | include QUIT

Nov 03 23:13:10.789 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:10.769 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 03 23:13:10.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:09.789 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:09.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:08.559 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 03 23:13:08.559 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

유닛 3-1의 Syslog 메시지:

firepower# show log | include 747

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-1-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state SECONDARY to PRIMARY

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_FAST to PRIMARY_DRAIN

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_DRAIN to PRIMARY_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_CONFIG to PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_POST_CONFIG to PRIMARY

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY

클러스터 기록

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

23:13:13 UTC Nov 3 2020 |

23:13:12 UTC Nov 3 2020 |

23:13:10 UTC Nov 3 2020 |

시나리오 5

실패 전

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 제어 노드 |

데이터 노드 |

데이터 노드 |

복구 후(변경 사항 없음)

| FTD1 |

FTD2 |

FTD3 |

| 사이트 A |

사이트 A |

사이트 B |

| 제어 노드 |

데이터 노드 |

데이터 노드 |

실패

Unit-3-1은 unit-1-1과 unit-2-1 모두에 QUIT 메시지를 보냈지만 연결 문제로 인해 unit-2-1만 QUIT 메시지를 받았습니다.

Unit-1-1 클러스터 추적 로그:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.429 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.059 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:45.429 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:51:45.429 [DBUG]Send CCP message to unit-3-1(1): CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Unit-2-1 클러스터 추적 로그:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.019 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:46.999 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 04 00:51:45.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

클러스터 기록

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

| 이벤트 없음 |

00:51:50 UTC Nov 4 2020 |

00:51:47 UTC Nov 4 2020 |

클러스터 데이터 플레인 연결 설정

NGFW 캡처 포인트

NGFW는 다음과 같은 점에서 캡처 기능을 제공합니다.

- 섀시 내부 스위치(FXOS)

- FTD 데이터 플레인 엔진

- FTD Snort 엔진

클러스터에서 데이터 경로 문제를 해결할 때 대부분의 경우 사용되는 캡처 지점은 FXOS 및 FTD 데이터 플레인 엔진 캡처입니다.

- 물리적 인터페이스의 FXOS 인그레스 캡처

- 데이터 플레인 엔진의 FTD 인그레스 캡처

- 데이터 플레인 엔진의 FTD 이그레스 캡처

- 백플레인 인터페이스의 FXOS 인그레스 캡처

NGFW 캡처에 대한 자세한 내용은 다음 문서를 참조하십시오.

클러스터 유닛 플로우 역할 기본 사항

클러스터를 통해 다음과 같은 요인에 따라 다양한 방식으로 연결을 설정할 수 있습니다.

- 트래픽 유형(TCP, UDP 등)

- 인접한 스위치에 구성된 로드 밸런싱 알고리즘

- 방화벽에 구성된 기능

- 네트워크 조건(예: IP 프래그먼트화, 네트워크 지연 등)

| 흐름 역할 |

설명 |

플래그 |

| 소유자 |

일반적으로 연결을 처음 수신하는 유닛입니다 |

UIO |

| 이사 |

전달자의 소유자 조회 요청을 처리하는 장치입니다. |

Y |

| 백업 소유자 |

이사가 소유자와 동일한 단위가 아닌 한, 이사가 백업 소유자이기도 합니다. 소유자가 자신을 디렉터로 선택하면 별도의 백업 소유자가 선택됩니다. |

Y(디렉터도 백업 소유자인 경우) y(디렉터가 백업 소유자가 아닌 경우) |

| 전달자 |

소유자에게 패킷을 전달하는 유닛 |

z |

| 조각 소유자 |

프래그먼트된 트래픽을 처리하는 유닛 |

- |

| 섀시 백업 |

섀시 간 클러스터에서 디렉터/백업 및 소유자 플로우가 모두 동일한 섀시의 유닛에서 소유하는 경우 다른 섀시 중 하나의 유닛이 보조 백업/디렉터가 됩니다. 이 역할은 블레이드가 2개 이상인 Firepower 9300 Series의 섀시 간 클러스터와 관련이 있습니다. |

w |

- 자세한 내용은 컨피그레이션 가이드의 관련 섹션을 참조하십시오(관련 정보의 링크 참조).

- 특정 시나리오에서(사례 연구 섹션 참조) 일부 플래그는 항상 표시되지 않습니다.

클러스터 연결 설정 사례 연구

다음 섹션에서는 클러스터를 통해 연결을 설정하는 몇 가지 방법을 보여 주는 다양한 사례 연구를 다룹니다. 목표는 다음과 같습니다.

- 다른 유닛 역할에 대해 숙지하십시오.

- 다양한 명령 출력의 상관 관계를 보여 줍니다.

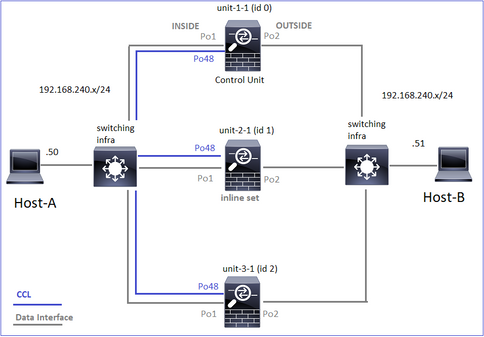

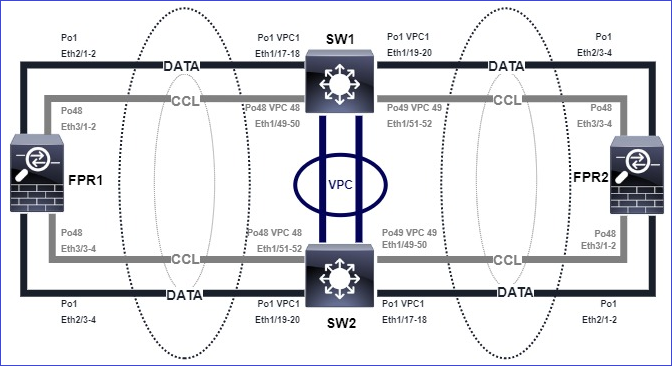

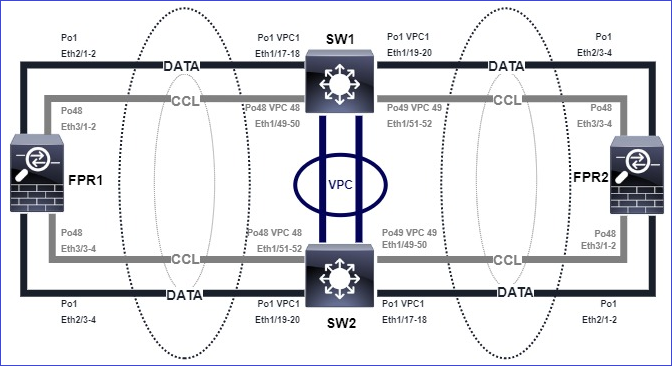

토폴로지

클러스터 유닛 및 ID:

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

Cluster GROUP1: On |

Unit "unit-2-1" in state SECONDARY |

Unit "unit-3-1" in state SECONDARY |

클러스터 캡처 사용:

cluster exec cap CAPI int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPI_RH reinject-hide int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO_RH reinject-hide int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CCL int cluster buffer 33554432

참고: 이러한 테스트는 클러스터를 통과하는 트래픽이 최소화된 랩 환경에서 실행되었습니다. 프로덕션 환경에서는 가능한 한 특정 캡처 필터(예: 대상 포트 및 가능한 경우 소스 포트)로 사용하여 캡처의 '노이즈'를 최소화하려고 합니다.

사례 연구 1. 대칭 트래픽(소유자도 책임자)

관찰 1. reinject-hide 캡처는 unit-1-1에서만 패킷을 표시합니다. 이는 양방향의 흐름이 unit-1-1을 통과했음을 의미합니다(대칭 트래픽).

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data interface cluster [Capturing - 33513 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-2-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 23245 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-3-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 24815 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

관찰 2. 소스 포트 45954의 흐름에 대한 연결 플래그 분석

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

22 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 2 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:00, bytes 487413076, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:443 NP Identity Ifc 192.168.240.50:39698, idle 0:00:23, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:06, bytes 0, flags y

| 단위 |

플래그 |

메모 |

| Unit-1-1 |

UIO |

· Flow Owner(플로우 소유자) - 디바이스가 플로우를 처리합니다. · Director - unit-3-1은 'y'를 갖고 'Y'는 갖고 있지 않으므로 이 플로우의 디렉터로 unit-1-1이 선택되었음을 의미합니다. 그리하여 소유자이기도 하므로 백업 소유자로 다른 유닛(이 사건 unit-3-1)을 선출하였다 |

| Unit-2-1 |

- |

- |

| Unit-3-1 |

y |

장치가 백업 소유자입니다. |

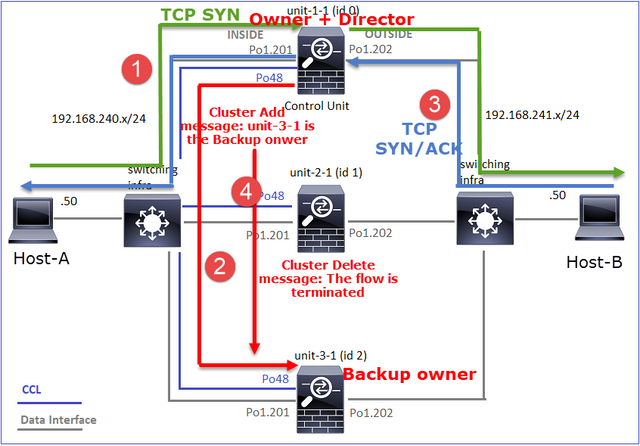

이는 다음과 같이 시각화할 수 있습니다.

- TCP SYN 패킷이 Host-A에서 unit-1-1로 도착합니다. Unit-1-1이 흐름 소유자가 됩니다.

- Unit-1-1도 유동 이사로 선출됩니다. 따라서 유닛 3-1도 백업 소유자(클러스터 추가 메시지)로 선택합니다.

- TCP SYN/ACK 패킷이 Host-B에서 unit-3-1로 도착합니다. 흐름은 대칭입니다.

- 연결이 종료되면 소유자는 클러스터 삭제 메시지를 보내 백업 소유자에서 플로우 정보를 제거합니다.

관찰 3. 흔적으로 캡처하면 양 방향이 유닛-1-1을 통해서만 진행된다는 것을 알 수 있다.

1단계. 소스 포트를 기준으로 모든 클러스터 유닛에서 관심 있는 흐름 및 패킷을 식별합니다.

firepower# cluster exec show capture CAPI | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363521 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45954: S 4042762409:4042762409(0) ack 992089270 win 28960 <mss 1380,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363827 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 4042762410 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower# cluster exec show capture CAPO | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362987 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: S 2732339016:2732339016(0) win 29200 <mss 1380,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363903 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 3603655983 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

2단계. TCP 흐름 추적이므로 3방향 핸드셰이크 패킷을 추적합니다. 이 출력에서 볼 수 있듯이 unit-1-1이 소유자입니다. 간소화하기 위해 관련되지 않은 추적 단계는 생략됩니다.

firepower# show cap CAPI packet-number 1 trace

25985 packets captured

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

...

반환 트래픽(TCP SYN/ACK):

firepower# show capture CAPO packet-number 2 trace

25985 packets captured

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

...

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9364, using existing flow

관찰 4. FTD 데이터 플레인 syslog는 모든 유닛에서 연결 생성 및 종료를 보여줍니다.

firepower# cluster exec show log | include 45954

unit-1-1(LOCAL):******************************************************

Dec 01 2020 08:42:09: %FTD-6-302013: Built inbound TCP connection 9364 for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302014: Teardown TCP connection 9364 for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 08:42:09: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

사례 연구 2. 대칭 트래픽(디렉터와 다른 소유자)

- 사례 연구 #1와 동일하지만, 본 사례 연구에서는 플로우 오너가 디렉터와 다른 단위이다.

- 모든 출력은 사례 연구 #1와 유사합니다. 사례 연구 #1와 비교했을 때 주요 차이점은 시나리오 1의 'y' 플래그를 대체하는 'Y' 플래그입니다.

관찰 1. 소유주가 감독과 다릅니다.

소스 포트 46278의 흐름에 대한 연결 플래그 분석

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:00, bytes 508848268, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46276, idle 0:00:03, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46276, idle 0:00:02, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:06, bytes 0, flags Y

| 단위 |

플래그 |

메모 |

| Unit-1-1 |

UIO |

· Flow Owner(플로우 소유자) - 디바이스가 플로우를 처리합니다. |

| Unit-2-1 |

- |

- |

| Unit-3-1 |

Y |

· 디렉터 및 백업 소유자 - 유닛 3-1에는 플래그 Y(디렉터)가 있습니다. |

이는 다음과 같이 시각화할 수 있습니다.

- TCP SYN 패킷이 Host-A에서 unit-1-1로 도착합니다. Unit-1-1이 흐름 소유자가 됩니다.

- Unit-3-1이 플로우 디렉터로 선택됩니다. Unit-3-1도 백업 소유자(CCL을 통한 UDP 4193의 '클러스터 추가' 메시지)입니다.

- TCP SYN/ACK 패킷이 Host-B에서 unit-3-1로 도착합니다. 흐름은 대칭입니다.

- 연결이 종료되면 소유자는 UDP 4193에서 'cluster delete' 메시지를 CCL을 통해 전송하여 백업 소유자의 흐름 정보를 제거합니다.

관찰 2. 흔적으로 캡처하면 양 방향이 유닛-1-1을 통해서만 진행된다는 것을 알 수 있다

1단계. 사례 연구 1과 동일한 접근 방식을 사용하여 소스 포트를 기반으로 모든 클러스터 유닛에서 관심 있는 플로우 및 패킷을 식별합니다.

firepower# cluster exec show cap CAPI | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842317 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3524167695:3524167695(0) ack 1972783999 win 28960 <mss 1380,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842592 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3524167696 win 229 <nop,nop,timestamp 503529073 513884542>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

외부 인터페이스에서 캡처:

firepower# cluster exec show cap CAPO | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841921 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: S 2153055699:2153055699(0) win 29200 <mss 1380,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842638 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3382481338 win 229 <nop,nop,timestamp 503529073 513884542>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

2단계. 인그레스 패킷(TCP SYN 및 TCP SYN/ACK)에 초점을 맞춥니다.

firepower# cluster exec show cap CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

824 packets captured

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

unit-1-1에서 SYN/ACK 추적:

firepower# cluster exec show cap CAPO packet-number 4 trace

unit-1-1(LOCAL):******************************************************

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9583, using existing flow

관찰 3. FTD 데이터 플레인 syslog는 소유자 및 백업 소유자에 대한 연결 생성 및 종료를 보여줍니다.

firepower# cluster exec show log | include 46278

unit-1-1(LOCAL):******************************************************

Dec 01 2020 11:01:44: %FTD-6-302013: Built inbound TCP connection 9583 for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302014: Teardown TCP connection 9583 for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024001808 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 11:01:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

사례 연구 3. 비대칭 트래픽(디렉터가 트래픽 전달)

관찰 1. reinject-hide는 unit-1-1 및 unit-2-1(비대칭 흐름)의 show 패킷을 캡처합니다.

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554320 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99932 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553268 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 53815 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

관찰 2. 소스 포트 46502의 흐름에 대한 연결 플래그 분석

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 448760236, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46500, idle 0:00:06, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 1 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 0, flags Y

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 0 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

| 단위 |

플래그 |

메모 |

| Unit-1-1 |

UIO |

· Flow Owner(플로우 소유자) - 디바이스가 플로우를 처리합니다. |

| Unit-2-1 |

Y |

· Director - unit-2-1에는 'Y' 플래그가 있으므로 이 플로우의 Director로 unit-2-1이 선택되었음을 의미합니다. · 백업 소유자 · 마지막으로, 이 출력에서 명확하지 않지만 show capture 및 show log 출력에서 유닛-2-1이 소유자에게 이 플로우를 전달하는 것이 분명합니다(이 시나리오에서는 기술적으로 전달자로 간주되지 않지만). 참고: 한 유닛은 디렉터(Y 흐름)와 전달자(z 흐름)가 모두 될 수 없으며, 이 두 역할은 상호 배타적입니다. 디렉터(Y 흐름)는 여전히 트래픽을 전달할 수 있습니다. 이 사례 연구의 뒷부분에 나오는 show log 출력을 참조하십시오. |

| Unit-3-1 |

- |

- |

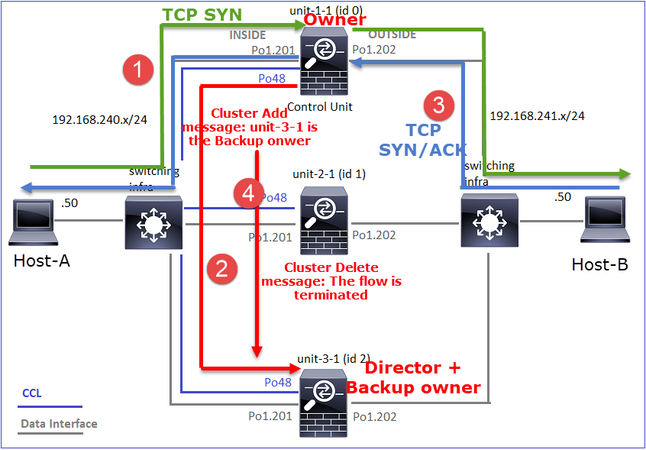

이는 다음과 같이 시각화할 수 있습니다.

- TCP SYN 패킷이 Host-A에서 unit-1-1로 도착합니다. Unit-1-1이 흐름 소유자가 됩니다.

- Unit-2-1은 플로우 디렉터 및 백업 소유자로 선택됩니다. 흐름 소유자가 백업 소유자에게 흐름에 대해 알리기 위해 UDP 4193에서 '클러스터 추가' 유니캐스트 메시지를 보냅니다.

- TCP SYN/ACK 패킷이 Host-B에서 unit-2-1로 도착합니다. 흐름이 비대칭적입니다.

- Unit-2-1은 TCP SYN 쿠키로 인해 패킷을 CCL을 통해 소유자에게 전달합니다.

- 소유자는 인터페이스 OUTSIDE의 패킷을 다시 거부한 다음 패킷을 Host-A로 전달합니다.

- 연결이 종료되면 소유자는 클러스터 삭제 메시지를 보내 백업 소유자에서 플로우 정보를 제거합니다.

관찰 3. 추적을 사용하여 캡처하면 비대칭 트래픽과 유닛-2-1에서 유닛-1-1로의 리디렉션이 표시됩니다.

1단계. 관심 흐름에 속하는 패킷을 식별합니다(포트 46502).

firepower# cluster exec show capture CAPI | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.357037 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46502: S 883000451:883000451(0) ack 4124514681 win 28960 <mss 1380,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357357 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 883000452 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

반환 방향:

firepower# cluster exec show capture CAPO | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356426 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: S 1434968587:1434968587(0) win 29200 <mss 1380,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.356915 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357403 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 4257314723 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

2: 12:58:33.360302 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . ack 1434968736 win 235 <nop,nop,timestamp 520893005 510537536>

3: 12:58:33.361004 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . 4257314723:4257316091(1368) ack 1434968736 win 235 <nop,nop,timestamp 520893006 510537536>

…

unit-3-1:*************************************************************

2단계. 패킷 추적 기본적으로 처음 50개의 인그레스 패킷만 추적됩니다. 간소화하기 위해 관련되지 않은 추적 단계는 생략됩니다.

Unit-1-1(소유자):

firepower# cluster exec show capture CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Unit-2-1(전달자)

반환 트래픽(TCP SYN/ACK) 관심 유닛은 유닛-2-1입니다. 유닛-2-1은 디렉터/백업 소유자이며 트래픽을 소유자에게 전달합니다.

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

관찰 4. FTD 데이터 플레인 syslog는 모든 유닛에서 연결 생성 및 종료를 보여줍니다.

firepower# cluster exec show log | i 46502

unit-1-1(LOCAL):******************************************************

Dec 01 2020 12:58:33: %FTD-6-302013: Built inbound TCP connection 9742 for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302014: Teardown TCP connection 9742 for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 bytes 2048000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 12:58:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46502 (192.168.240.50/46502)

Dec 01 2020 12:58:33: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46502 duration 0:00:00 forwarded bytes 0 Forwarding or redirect flow removed to create director or backup flow

Dec 01 2020 12:58:33: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 forwarded bytes 2048316300 Cluster flow with CLU closed on owner

unit-3-1:*************************************************************

firepower#

사례 연구 4. 비대칭 트래픽(소유자가 책임자)

관찰 1. reinject-hide는 unit-1-1 및 unit-2-1(비대칭 흐름)의 show 패킷을 캡처합니다.

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554229 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99924 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33552925 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 227690 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 4754 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

관찰 2. 소스 포트 46916의 흐름에 대한 연결 플래그 분석

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46916, idle 0:00:00, bytes 414682616, flags UIO N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46916, idle 0:00:00, bytes 0, flags z

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 0 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46916, idle 0:00:04, bytes 0, flags y

| 단위 |

플래그 |

메모 |

| Unit-1-1 |

UIO |

· Flow Owner(플로우 소유자) - 디바이스가 플로우를 처리합니다. · Director - unit-3-1은 'y'를 갖고 'Y'는 갖고 있지 않으므로 이 플로우의 디렉터로 unit-1-1이 선택되었음을 의미합니다. 그리하여 소유자이기도 하므로 백업 소유자로 다른 유닛(이 사건 unit-3-1)을 선출하였다 |

| Unit-2-1 |

z |

· 전달자 |

| Unit-3-1 |

y |

- 백업 소유자 |

이는 다음과 같이 시각화할 수 있습니다.

- TCP SYN 패킷이 Host-A에서 unit-1-1로 전달됩니다. Unit-1-1이 플로우 소유자가 되고 이사가 선택됩니다.

- Unit-3-1이 백업 소유자로 선택됩니다. 흐름 소유자가 백업 소유자에게 흐름에 대해 알리기 위해 UDP 4193에서 유니캐스트 '클러스터 추가' 메시지를 보냅니다.

- TCP SYN/ACK 패킷이 Host-B에서 unit-2-1로 도착합니다. 흐름이 비대칭적입니다.

- Unit-2-1은 TCP SYN 쿠키로 인해 패킷을 CCL을 통해 소유자에게 전달합니다.

- 소유자는 인터페이스 OUTSIDE의 패킷을 다시 거부한 다음 패킷을 Host-A로 전달합니다.

- 연결이 종료되면 소유자는 클러스터 삭제 메시지를 보내 백업 소유자에서 플로우 정보를 제거합니다.

관찰 3. 추적을 사용하여 캡처하면 비대칭 트래픽과 유닛-2-1에서 유닛-1-1로의 리디렉션이 표시됩니다.

Unit-2-1(전달자)

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 16:11:33.653164 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46916: S 1331019196:1331019196(0) ack 3089755618 win 28960 <mss 1460,sackOK,timestamp 532473211 522117741,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

관찰 4. FTD 데이터 플레인 syslog는 모든 유닛에서 연결 생성 및 종료를 보여줍니다.

- Unit-1-1(소유자)

- Unit-2-1(전달자)

- Unit-3-1(백업 소유자)

firepower# cluster exec show log | i 46916

unit-1-1(LOCAL):******************************************************

Dec 01 2020 16:11:33: %FTD-6-302013: Built inbound TCP connection 10023 for INSIDE:192.168.240.50/46916 (192.168.240.50/46916) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 16:11:42: %FTD-6-302014: Teardown TCP connection 10023 for INSIDE:192.168.240.50/46916 to OUTSIDE:192.168.241.50/80 duration 0:00:09 bytes 1024010016 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 16:11:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46916 (192.168.240.50/46916)

Dec 01 2020 16:11:42: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46916 duration 0:00:09 forwarded bytes 1024009868 Cluster flow with CLU closed on owner

unit-3-1:*************************************************************

Dec 01 2020 16:11:33: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/46916 (192.168.240.50/46916) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 16:11:42: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/46916 to OUTSIDE:192.168.241.50/80 duration 0:00:09 forwarded bytes 0 Cluster flow with CLU closed on owner

사례 연구 5. 비대칭 트래픽(소유자가 디렉터와 다름)

관찰 1. reinject-hide는 unit-1-1 및 unit-2-1(비대칭 흐름)의 show 패킷을 캡처합니다.

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553207 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 99396 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99224 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 99396 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99928 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554251 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 131925 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 2592 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

관찰 2. 소스 포트 46994의 흐름에 대한 연결 플래그 분석:

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46994, idle 0:00:00, bytes 406028640, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46994, idle 0:00:00, bytes 0, flags z

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 2 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46994, idle 0:00:05, bytes 0, flags Y

| 단위 |

플래그 |

메모 |

| Unit-1-1 |

UIO |

· Flow Owner(플로우 소유자) - 디바이스가 플로우를 처리합니다. |

| Unit-2-1 |

z |

· 전달자 |

| Unit-3-1 |

Y |

· 백업 소유자 · 디렉터 |

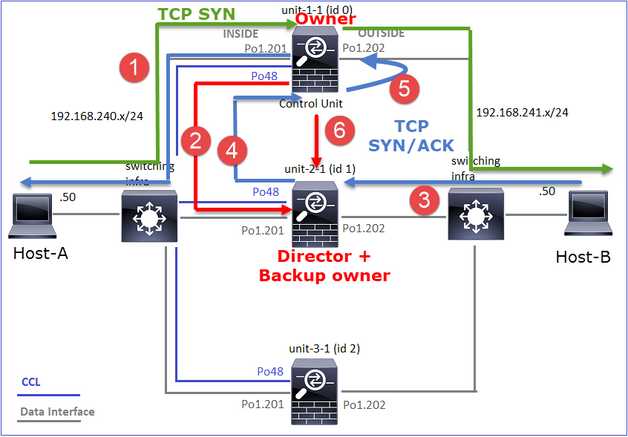

이는 다음과 같이 시각화할 수 있습니다.

- TCP SYN 패킷이 Host-A에서 unit-1-1로 도착합니다. Unit-1-1이 흐름 소유자가 됩니다.

- Unit-3-1은 이사 및 백업 소유자로 선출됩니다. 흐름 소유자가 백업 소유자에게 흐름에 대해 알리기 위해 UDP 4193에서 '클러스터 추가' 유니캐스트 메시지를 보냅니다.

- TCP SYN/ACK 패킷이 Host-B에서 unit-2-1로 도착합니다. 흐름은 비대칭입니다

- Unit-2-1은 TCP SYN 쿠키로 인해 패킷을 CCL을 통해 소유자에게 전달합니다.

- 소유자는 인터페이스 OUTSIDE의 패킷을 다시 거부한 다음 패킷을 Host-A로 전달합니다.

- 연결이 종료되면 소유자는 클러스터 삭제 메시지를 보내 백업 소유자에서 플로우 정보를 제거합니다.

관찰 3. 추적을 사용하여 캡처하면 비대칭 트래픽과 유닛-2-1에서 유닛-1-1로의 리디렉션이 표시됩니다.

Unit-1-1(소유자)

firepower# cluster exec show cap CAPI packet-number 1 trace

unit-1-1(LOCAL):******************************************************

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Unit-2-1(전달자)

firepower# cluster exec unit unit-2-1 show cap CAPO packet-number 1 trace

1: 16:46:44.232074 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46994: S 2863659376:2863659376(0) ack 2879616990 win 28960 <mss 1460,sackOK,timestamp 534583774 524228304,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

관찰 4. FTD 데이터 플레인 syslog는 모든 유닛에서 연결 생성 및 종료를 보여줍니다.

- Unit-1-1(소유자)

- Unit-2-1(전달자)

- Unit-3-1(백업 소유자/책임자)

firepower# cluster exec show log | i 46994

unit-1-1(LOCAL):******************************************************

Dec 01 2020 16:46:44: %FTD-6-302013: Built inbound TCP connection 10080 for INSIDE:192.168.240.50/46994 (192.168.240.50/46994) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 16:46:53: %FTD-6-302014: Teardown TCP connection 10080 for INSIDE:192.168.240.50/46994 to OUTSIDE:192.168.241.50/80 duration 0:00:09 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 16:46:44: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46994 (192.168.240.50/46994)

Dec 01 2020 16:46:53: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46994 duration 0:00:09 forwarded bytes 1024000292 Cluster flow with CLU closed on owner

unit-3-1:*************************************************************

Dec 01 2020 16:46:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46994 (192.168.240.50/46994) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 16:46:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46994 to OUTSIDE:192.168.241.50/80 duration 0:00:09 forwarded bytes 0 Cluster flow with CLU closed on owner

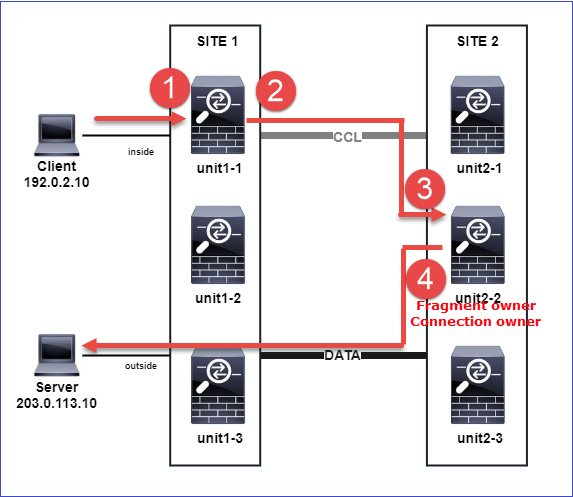

다음 사례 연구에서는 인라인 집합이 있는 클러스터를 기반으로 하는 토폴로지를 사용합니다.

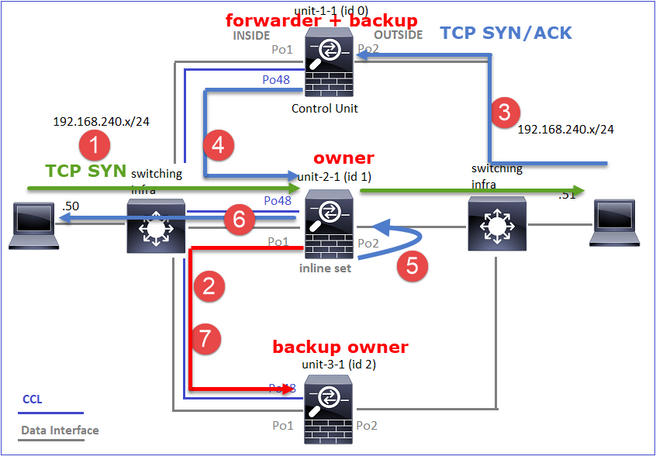

사례 연구 6. 비대칭 트래픽(Inline-set, 소유자가 디렉터)

관찰 1. reinject-hide는 unit-1-1 및 unit-2-1(비대칭 흐름)의 show 패킷을 캡처합니다. 또한 소유자는 unit-2-1입니다(reinject-hide 캡처에 대해 INSIDE 및 OUTSIDE 인터페이스 모두에 패킷이 있는 반면, unit-1-1에는 OUTSIDE에만 패킷이 있습니다).

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553253 bytes]

capture CAPO type raw-data trace interface OUTSIDE [Buffer Full - 523432 bytes]

match tcp host 192.168.240.50 host 192.168.240.51 eq www

capture CAPI type raw-data trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.240.51 eq www

capture CAPO_RH type raw-data reinject-hide interface OUTSIDE [Buffer Full - 523432 bytes]

match tcp host 192.168.240.50 host 192.168.240.51 eq www

capture CAPI_RH type raw-data reinject-hide interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.240.51 eq www

unit-2-1:*************************************************************