소개

이 문서에서는 Cisco IOS® XE 디바이스의 기본 컨피그레이션 및 문제 해결에 대해 설명합니다.

사전 요구 사항

요구 사항

다음 주제에 대한 지식을 보유하고 있으면 유용합니다.

- DCI 오버레이 및 멀티캐스트에 대한 기본 이해

사용되는 구성 요소

이 문서의 정보는 다음 소프트웨어 및 하드웨어 버전을 기반으로 합니다.

- ASR1004 실행 소프트웨어 03.16.00.S

- 소프트웨어 3.16.03.S를 실행하는 CSR100v(VXE)

이 문서의 정보는 특정 랩 환경의 디바이스를 토대로 작성되었습니다. 이 문서에 사용된 모든 디바이스는 초기화된(기본) 컨피그레이션으로 시작되었습니다. 현재 네트워크가 작동 중인 경우 모든 명령의 잠재적인 영향을 미리 숙지하시기 바랍니다.

배경 정보

VXLAN(Virtual Extensible LAN)은 DCI(Data Center Interconnect) 솔루션으로 더욱 각광받고 있습니다. VXLAN 기능은 레이어 3/공용 라우팅 도메인 상에서 레이어 2 확장을 제공하는 데 사용됩니다. 이 문서에서는 Cisco IOS XE 디바이스의 기본 컨피그레이션 및 문제 해결에 대해 설명합니다.

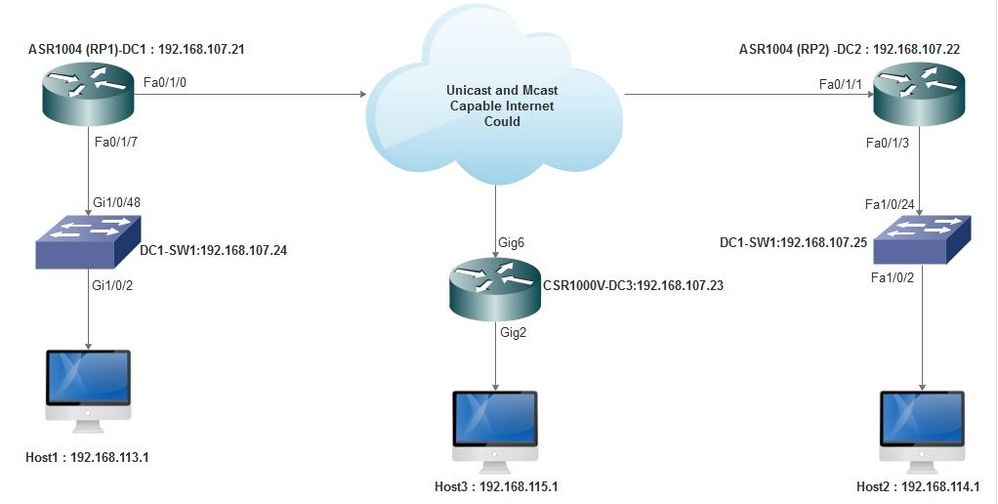

이 문서의 Configure(구성) 및 Verify(확인) 섹션에서는 다음 두 가지 시나리오를 다룹니다.

- 시나리오 A는 멀티캐스트 모드의 세 데이터 센터 간의 VXLAN 컨피그레이션에 대해 설명합니다.

- 시나리오 B는 유니캐스트 모드의 두 데이터 센터 간 VXLAN 컨피그레이션에 대해 설명합니다.

구성

시나리오 A: 멀티캐스트 모드에서 세 데이터 센터 간에 VXLAN 구성

기본 컨피그레이션

멀티캐스트 모드를 사용하려면 사이트 간에 유니캐스트 연결과 멀티캐스트 연결이 모두 필요합니다. 이 컨피그레이션 가이드에서는 OSPF(Open Shortest Path First)를 사용하여 유니캐스트 연결을 제공하고 PIM(Bidirectional Protocol Independent Multicast)을 사용하여 멀티캐스트 연결을 제공합니다.

다음은 멀티캐스트 작동 모드를 위한 3개의 데이터 센터 모두에 대한 기본 컨피그레이션입니다.

!

DC1#show run | sec ospf

router ospf 1

network 10.1.1.1 0.0.0.0 area 0

network 10.10.10.4 0.0.0.3 area 0

!

PIM 양방향 구성:

!

DC1#show run | sec pim

ip pim bidir-enable

ip pim send-rp-discovery scope 10

ip pim bsr-candidate Loopback1 0

ip pim rp-candidate Loopback1 group-list 10 bidir

!

access-list 10 permit 239.0.0.0 0.0.0.255

!

DC1#

!

또한 PIM 스파스 모드는 루프백을 포함하여 모든 L3 인터페이스에서 활성화됩니다.

!

DC1#show run interface lo1

Building configuration...

Current configuration : 83 bytes

!

interface Loopback1

ip address 10.1.1.1 255.255.255.255

ip pim sparse-mode

end

또한 디바이스에서 멀티캐스트 라우팅이 활성화되어 있고 멀티캐스트 mroute 테이블이 채워져 있는지 확인합니다.

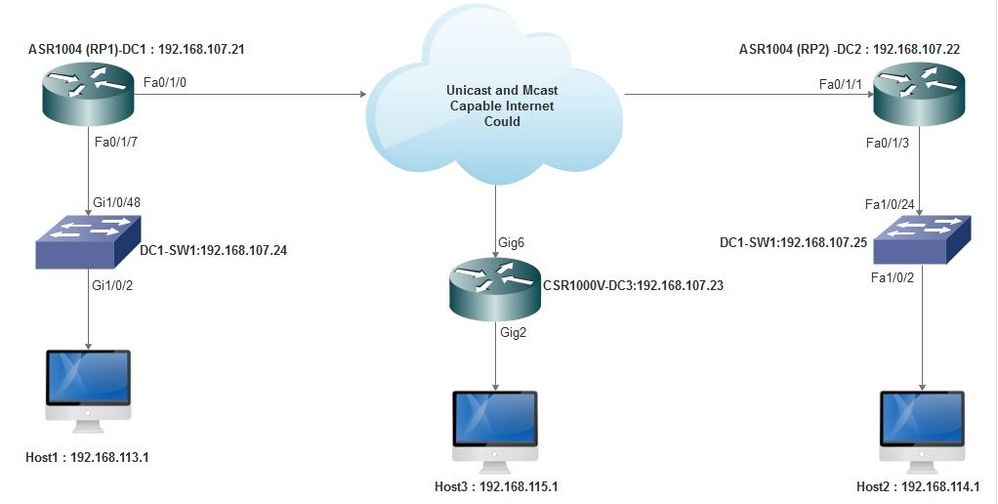

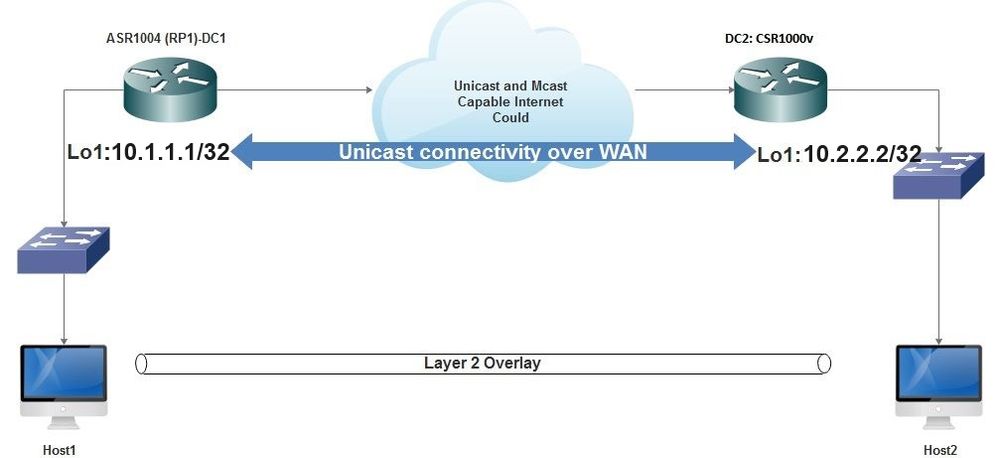

네트워크 다이어그램

유니캐스트 및 멀티캐스트 지원 인터넷

유니캐스트 및 멀티캐스트 지원 인터넷

DC1(VTEP1) 컨피그레이션

!

!

Vxlan udp port 1024

!

Interface Loopback1

ip address 10.1.1.1 255.255.255.255

ip pim sparse-mode

!

브리지 도메인 컨피그레이션에서 VNI 멤버 및 멤버 인터페이스를 정의합니다.

!

bridge-domain 1

member vni 6001

member FastEthernet0/1/7 service-instance 1

!

NVE(Network Virtual Interface)를 생성하고 WAN을 통해 다른 데이터 센터로 확장해야 하는 VNI 멤버를 정의합니다.

!

interface nve1

no ip address

shut

member vni 6001 mcast-group 10.0.0.10

!

source-interface Loopback1

!

LAN 인터페이스(즉, LAN 네트워크를 연결하는 인터페이스)를 통해 서비스 인스턴스를 생성하여 특정 VLAN(802.1q 태그 트래픽)을 오버레이합니다. 이 경우 VLAN 1은 다음과 같습니다.

!

interface FastEthernet0/1/7

no ip address

negotiation auto

cdp enable

no shut

!

오버레이를 통해 트래픽을 전송하기 전에 VLAN 태그를 제거하고 반환 트래픽을 VLAN으로 전송한 후에 푸시합니다.

!

service instance 1 ethernet

encapsulation unagged

!

DC2(VTEP2) 컨피그레이션

!

!

Vxlan udp port 1024

!

interface Loopback1

ip address 10.2.2.2 255.255.255.255

ip pim sparse-mode

!

!

bridge-domain 1

member vni 6001

member FastEthernet0/1/3 service-instance 1

!

!

interface nve1

no ip address

member vni 6001 mcast-group 10.0.0.10

!

source-interface Loopback1

shut

!

!

interface FastEthernet0/1/3

no ip address

negotiation auto

cdp enable

no shut

!

service instance 1 ethernet

encapsulation untagged

!

DC3(VTEP3) 컨피그레이션

!

!

Vxlan udp port 1024

!

interface Loopback1

ip address 10.3.3.3 255.255.255.255

ip pim sparse-mode

!

!

bridge-domain 1

member vni 6001

member GigabitEthernet2 service-instance 1

!

interface nve1

no ip address

shut

member vni 6001 mcast-group 10.0.0.10

!

source-interface Loopback1

!

interface gig2

no ip address

negotiation auto

cdp enable

no shut

!

service instance 1 ethernet

encapsulation untagged

!

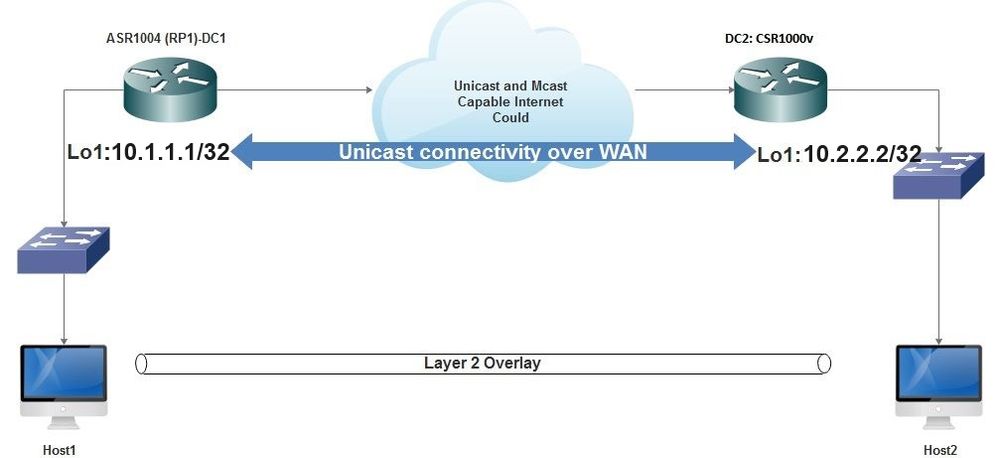

시나리오 B: 유니캐스트 모드에서 두 데이터 센터 간에 VXLAN 구성

네트워크 다이어그램

WAN을 통한 유니캐스트 연결

WAN을 통한 유니캐스트 연결

DC1 컨피그레이션

!

interface nve1

no ip address

member vni 6001

! ingress replication shold be configured as peer data centers loopback IP address.

!

ingress-replication 10.2.2.2

!

source-interface Loopback1

!

!

interface gig0/2/1

no ip address

negotiation auto

cdp enable

!

service instance 1 ethernet

encapsulation untagged

!

!

!

bridge-domain 1

member vni 6001

member gig0/2/1 service-instance 1

DC2 컨피그레이션

!

interface nve1

no ip address

member vni 6001

ingress-replication 10.1.1.1

!

source-interface Loopback1

!

!

interface gig5

no ip address

negotiation auto

cdp enable

!

service instance 1 ethernet

encapsulation untagged

!

!

bridge-domain 1

member vni 6001

member gig5 service-instance 1

다음을 확인합니다.

시나리오 A: 멀티캐스트 모드에서 세 데이터 센터 간에 VXLAN 구성

시나리오 A에 대한 컨피그레이션을 완료한 후에는 각 데이터 센터의 연결된 호스트가 동일한 브로드캐스트 도메인 내에서 서로 연결할 수 있어야 합니다.

컨피그레이션을 확인하려면 다음 명령을 사용합니다. 일부 예는 시나리오 B에 나와 있습니다.

Router#show nve vni

Router#show nve vni interface nve1

Router#show nve interface nve1

Router#show nve interface nve1 detail

Router#show nve peers

시나리오 B: 유니캐스트 모드에서 두 데이터 센터 간에 VXLAN 구성

DC1의 경우:

DC1#show nve vni

Interface VNI Multicast-group VNI state

nve1 6001 N/A Up

DC1#show nve interface nve1 detail

Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan

source-interface: Loopback1 (primary:10.1.1.1 vrf:0)

Pkts In Bytes In Pkts Out Bytes Out

60129 6593586 55067 5303698

DC1#show nve peers

Interface Peer-IP VNI Peer state

nve1 10.2.2.2 6000 -

DC2의 경우:

DC2#show nve vni

Interface VNI Multicast-group VNI state

nve1 6000 N/A Up

DC2#show nve interface nve1 detail

Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan

source-interface: Loopback1 (primary:10.2.2.2 vrf:0)

Pkts In Bytes In Pkts Out Bytes Out

70408 7921636 44840 3950835

DC2#show nve peers

Interface Peer-IP VNI Peer state

nve 10.1.1.1 6000 Up

DC2#show bridge-domain 1

Bridge-domain 1 (3 ports in all)

State: UP Mac learning: Enabled

Aging-Timer: 300 second(s)

BDI1 (up)

GigabitEthernet0/2/1 service instance 1

vni 6001

AED MAC address Policy Tag Age Pseudoport

0 7CAD.74FF.2F66 forward dynamic 281 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 B838.6130.DA80 forward dynamic 288 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 0050.56AD.1AD8 forward dynamic 157 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

문제 해결

Verify 섹션에 설명된 명령은 기본적인 트러블슈팅 단계를 제공합니다. 이러한 추가 진단은 시스템이 작동하지 않을 때 도움이 될 수 있습니다.

참고: 이러한 진단 기능 중 일부는 메모리 및 CPU 사용률을 높일 수 있습니다.

진단 디버그

#debug nve error

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes eer nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

#show nve log error

[01/01/70 00:04:34.130 UTC 1 3] NVE-MGR-STATE ERROR: vni 6001: error in create notification to Tunnel

[01/01/70 00:04:34.314 UTC 2 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 00:04:34.326 UTC 3 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:50:59.650 UTC 4 3] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:50:59.654 UTC 5 3] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:50:59.701 UTC 6 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:50:59.705 UTC 7 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:54:55.166 UTC 8 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:54:55.168 UTC 9 61] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:55:04.432 UTC A 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:55:04.434 UTC B 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:55:37.670 UTC C 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

#show nve log event

[01/04/70 19:48:51.883 UTC 1DD16 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD17 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD18 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD19 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD1A 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1B 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1C 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1D 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1E 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD1F 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD20 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:21.884 UTC 1DD21 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

임베디드 패킷 캡처

Cisco IOS XE 소프트웨어에서 제공되는 EPC(Embedded Packet Capture) 기능은 문제 해결을 위한 추가 정보를 제공할 수 있습니다.

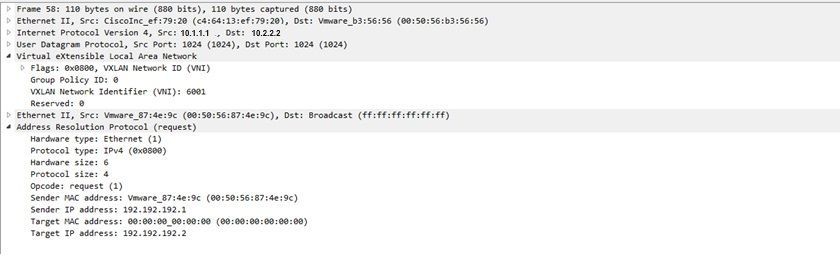

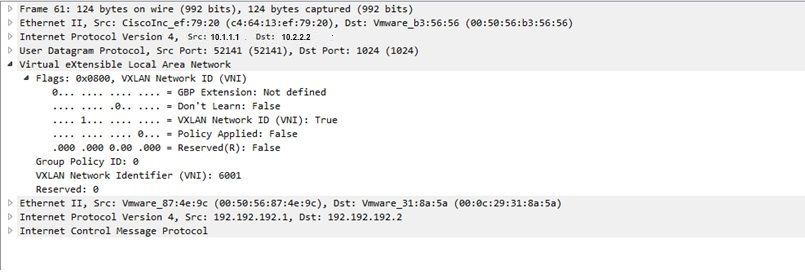

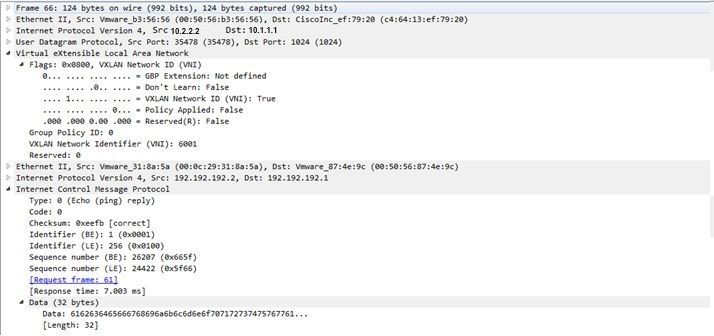

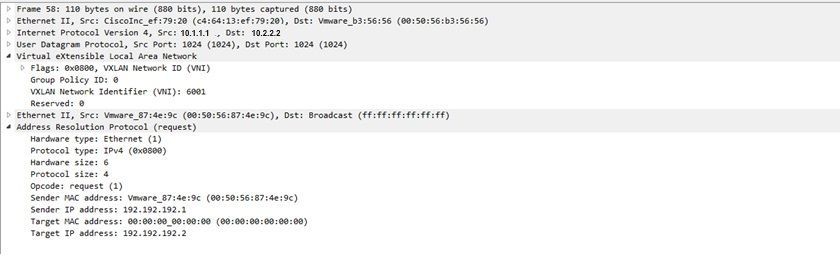

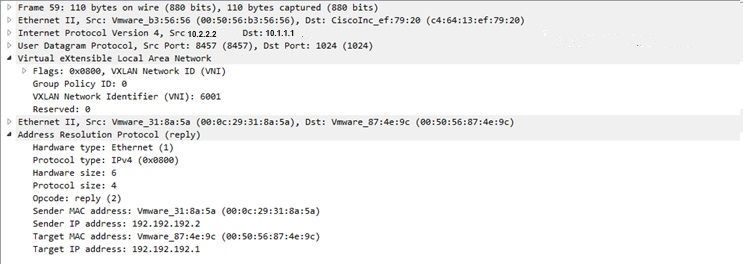

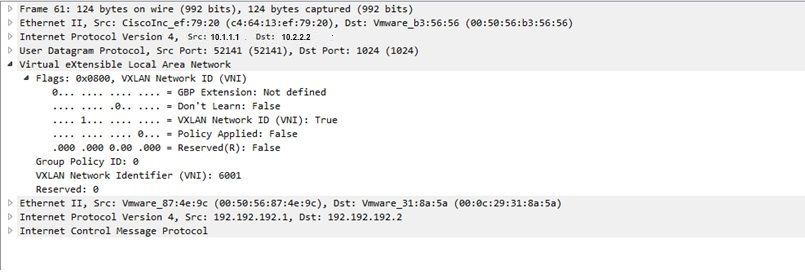

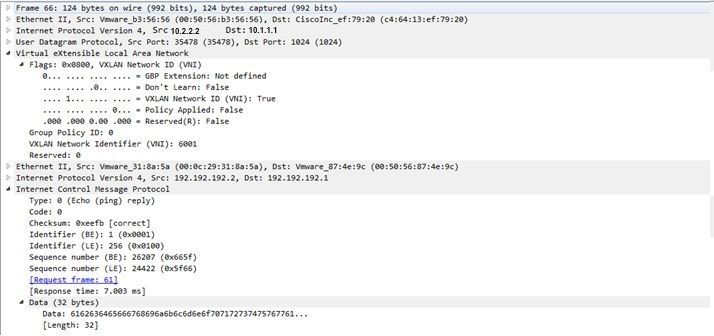

예를 들어 이 캡처에서는 VXLAN에서 캡슐화하는 패킷을 설명합니다.

EPC 컨피그레이션(TEST_ACL은 캡처 데이터를 필터링하는 데 사용되는 액세스 목록):

#monitor capture TEST access-list TEST_ACL interface gigabitEthernet0/2/0 both #monitor capture TEST buffer size 10 #monitor capture TEST start

다음과 같은 결과로 발생하는 패킷 덤프입니다.

# show monitor capture TEST buffer dump # monitor capture TEST export bootflash:TEST.pcap // with this command you can export the capture in pcap format to the bootflash, which can be downloaded and opened in wireshark.

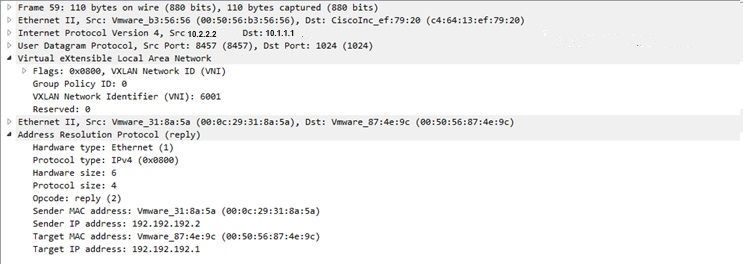

다음은 간단한 ICMP(Internet Control Message Protocol)가 VXLAN을 통해 작동하는 방식을 설명하는 예입니다.

VXLAN 오버레이를 통해 전송되는 ARP(Address Resolution Protocol):

ARP 응답:

ICMP 요청:

ICMP 응답:

추가 디버그 및 문제 해결 명령

이 섹션에서는 몇 가지 추가 디버그 및 문제 해결 명령에 대해 설명합니다.

이 예에서, 디버그의 강조 표시된 부분은 NVE 인터페이스가 멀티캐스트 그룹에 조인할 수 없음을 보여줍니다. 따라서 VXLAN 캡슐화는 VNI 6002에서 활성화되지 않았습니다. 이러한 디버그 결과는 네트워크의 멀티캐스트 문제를 가리킵니다.

#debug nve all

*Jan 5 06:13:55.844: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:13:55.846: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was failure

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:13:55.851: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:13:55.857: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:13:55.857: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Down

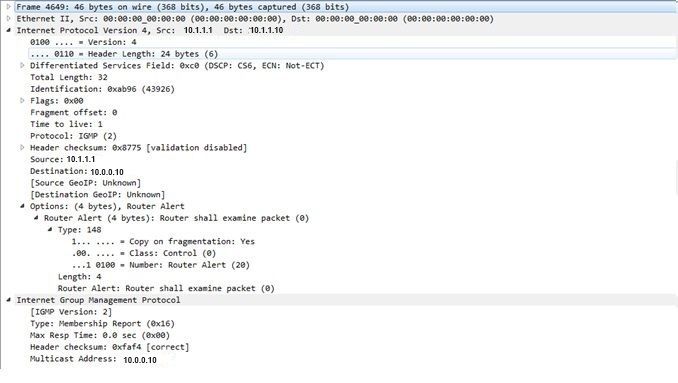

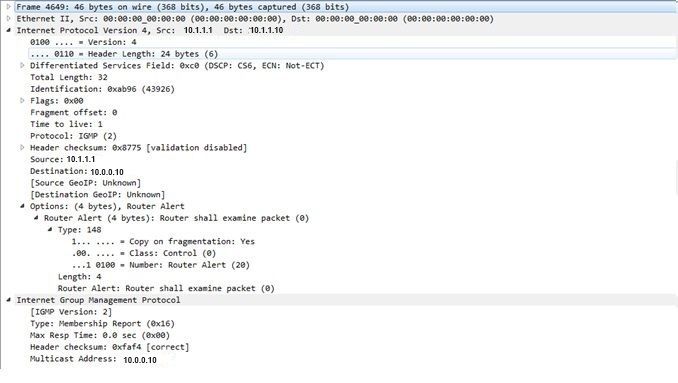

다음은 VNI가 멀티캐스트 그룹에 조인하면 전송할 수 있는 IGMP(Internet Group Management Protocol) 멤버십 보고서입니다.

다음 예에서는 멀티캐스트가 예상대로 작동하는 경우 멀티캐스트 모드에 대해 NVE에서 VNI를 구성한 후 예상 디버그 결과를 보여 줍니다.

*Jan 5 06:19:20.335: NVE-MGR-DB: [IF 0x14]VNI node creation

*Jan 5 06:19:20.335: NVE-MGR-DB: VNI Node created [437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 create notification to PD

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 Create notif successful, map [pd 0x1020017] to [pi 0x437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:19:20.342: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was successful

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:19:20.347: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:19:20.347: NVE-MGR-DB: Return pd_hdl[0x1020017] for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.347: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.351: NVE-MGR-EI: L2FIB query for info 0x437C9B28

*Jan 5 06:19:20.351: NVE-MGR-EI: PP up notification for bd_id 3

*Jan 5 06:19:20.351: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.352: NVE-MGR-STATE: vni 6002: Notify clients of state change Create to Up

*Jan 5 06:19:20.352: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.353: NVE-MGR-PD: VNI 6002 Create to Up State update to PD successful

*Jan 5 06:19:20.353: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: No state change Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: New State as a result of create Up

관련 정보

피드백

피드백