Konfigurieren des CVP Customer Virtual Assistant (CVA)

Download-Optionen

-

ePub (1.5 MB)

In verschiedenen Apps auf iPhone, iPad, Android, Sony Reader oder Windows Phone anzeigen

Inklusive Sprache

In dem Dokumentationssatz für dieses Produkt wird die Verwendung inklusiver Sprache angestrebt. Für die Zwecke dieses Dokumentationssatzes wird Sprache als „inklusiv“ verstanden, wenn sie keine Diskriminierung aufgrund von Alter, körperlicher und/oder geistiger Behinderung, Geschlechtszugehörigkeit und -identität, ethnischer Identität, sexueller Orientierung, sozioökonomischem Status und Intersektionalität impliziert. Dennoch können in der Dokumentation stilistische Abweichungen von diesem Bemühen auftreten, wenn Text verwendet wird, der in Benutzeroberflächen der Produktsoftware fest codiert ist, auf RFP-Dokumentation basiert oder von einem genannten Drittanbieterprodukt verwendet wird. Hier erfahren Sie mehr darüber, wie Cisco inklusive Sprache verwendet.

Informationen zu dieser Übersetzung

Cisco hat dieses Dokument maschinell übersetzen und von einem menschlichen Übersetzer editieren und korrigieren lassen, um unseren Benutzern auf der ganzen Welt Support-Inhalte in ihrer eigenen Sprache zu bieten. Bitte beachten Sie, dass selbst die beste maschinelle Übersetzung nicht so genau ist wie eine von einem professionellen Übersetzer angefertigte. Cisco Systems, Inc. übernimmt keine Haftung für die Richtigkeit dieser Übersetzungen und empfiehlt, immer das englische Originaldokument (siehe bereitgestellter Link) heranzuziehen.

Inhalt

Einleitung

In diesem Dokument wird die Konfiguration der CVA-Funktion des Customer Voice Portal (CVP) beschrieben.

Voraussetzungen

Anforderungen

Cisco empfiehlt, dass Sie über Kenntnisse in folgenden Bereichen verfügen:

- Cisco Unified Contact Center Enterprise (UCCE) Version 12.5

- Cisco Package Contact Center Enterprise (PCCE) Version 12.5

- CVP-Version 12.5

- Cisco Virtualized Voice Browser (CVVB) 12,5

- Cisco Unified Border Element (CUBE) oder Voice Gateway (GW)

- Google-Dialogfluss

Verwendete Komponenten

Die Informationen in diesem Dokument basieren auf folgenden Software-Versionen:

- Cisco Package Contact Center Enterprise (PCCE) Version 12.5

- CVP-Version 12.5

- Cisco Virtualized Voice Browser (CVVB) 12,5

- Google-Dialogfluss

Die Informationen in diesem Dokument beziehen sich auf Geräte in einer speziell eingerichteten Testumgebung. Alle Geräte, die in diesem Dokument benutzt wurden, begannen mit einer gelöschten (Nichterfüllungs) Konfiguration. Wenn Ihr Netz Live ist, überprüfen Sie, ob Sie die mögliche Auswirkung jedes möglichen Befehls verstehen.

Hintergrund

CVP 12.5 führt die Customer Virtual Assistant (CVA)-Funktion ein, mit der Sie Text-to-Speech- (TTS), automatische Spracherkennung- (ASR) und Natural Language Processing- (NLP)-Services von Drittanbietern nutzen können.

Hinweis: In dieser Version wird nur Google NLP unterstützt.

Diese Funktion unterstützt menschenähnliche Interaktionen, die es Ihnen ermöglichen, Probleme schnell und effizient im Rahmen der interaktiven Sprachsteuerung (IVR) mit Natural Language Processing zu lösen.

Cisco CVA bietet folgende Interaktionsmodi:

- Lokale Interaktion: Die Eingabeaufforderungen werden lokal mithilfe von WAV-Dateien wiedergegeben, und die Benutzereingaben werden mithilfe der DTMF-Grammatik erfasst.

- MRCP-basierte Interaktionen: Die Aufforderungen werden vom externen standortbasierten Medienserver über den MRCP-Synthesebefehl (Media Resource Control Protocol) für die TTS-Funktionalität wiedergegeben. Die Aufforderungen werden vom externen Medienserver anhand der vordefinierten Grammatik des ASR erkannt.

- Natural Language Understanding (NLU): Diese Funktion ermöglicht die Aufnahme eines Dialogs über Cloud-basierte Natural Language Processing (NLP)-Engines, die für das Verständnis natürlicher Sprache geschult sind.

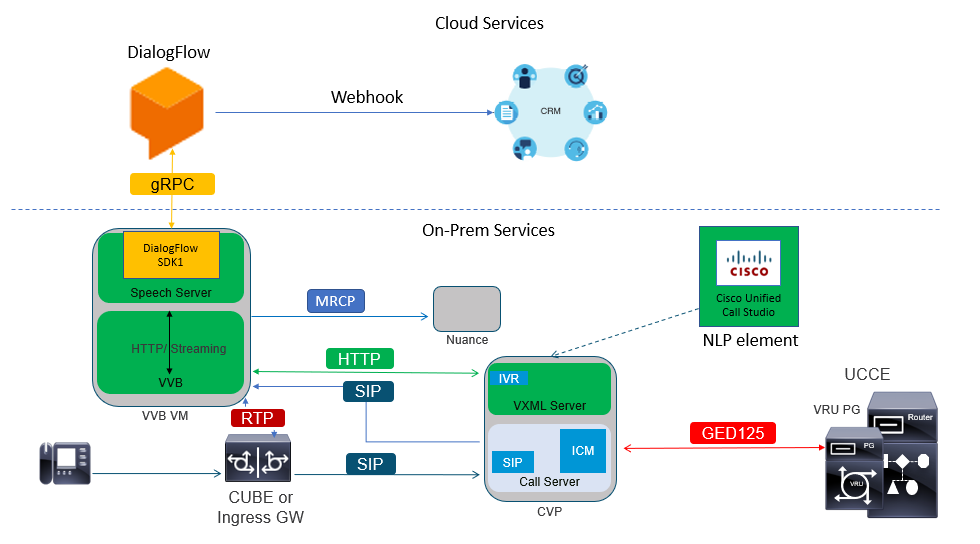

Architektur

Zusätzlich zu den Komponenten, die für einen umfassenden CVP-Anruffluss erforderlich sind, müssen für CVA Cloud-Services, Speech Services und spezifische CVP Call Studio-Elemente implementiert werden. Dies ist die Liste aller in CVA erforderlichen Komponenten:

- Eingangs-, Ausgangs-, CUBE-Gateways

- Unified Customer Voice Portal (Unified CVP)-Lösung, einschließlich Call Studio

- Unified Contact Center Enterprise (Unified CCE)

- Cisco Virtualized Voice Browser (VVB) - Sprachdienste

- Cloud-Services (Google Dialogflow)

Cisco CVA-Anrufflüsse

Es gibt drei CVA-Hauptanrufflüsse, die von Google Dialogflow unterstützt werden.

- Google-basierte IVR-Logik (Dialogflow)

- Standortbasierte Absicht (DialogflowIntent / DialogflowParam)

- Abschreiben

Google-basierte IVR-Logik (Dialogfluss)

Die gehostete IVR-Bereitstellung eignet sich am besten für Kunden, die eine Migration ihrer IVR-Infrastruktur in die Cloud planen. Bei gehosteter IVR-Bereitstellung befindet sich in der Cloud nur die IVR-Geschäftslogik, während die Agenten bei der standortbasierten Infrastruktur registriert sind.

Nach der Bereitstellung der gehosteten IVR-Lösung erfolgt das Kernsignal und der Medienprozess in der Cloud. CVP- und Cisco VVB-Lösungen befinden sich darüber hinaus im Bridge-Modus, über den die Medien in die Cloud gestreamt werden können. Sobald die IVR abgeschlossen ist und ein Agent erforderlich ist, wird die Anrufsteuerung für den weiteren Anrufprozess und die Warteschlangenbehandlung an das CVP zurückübertragen.

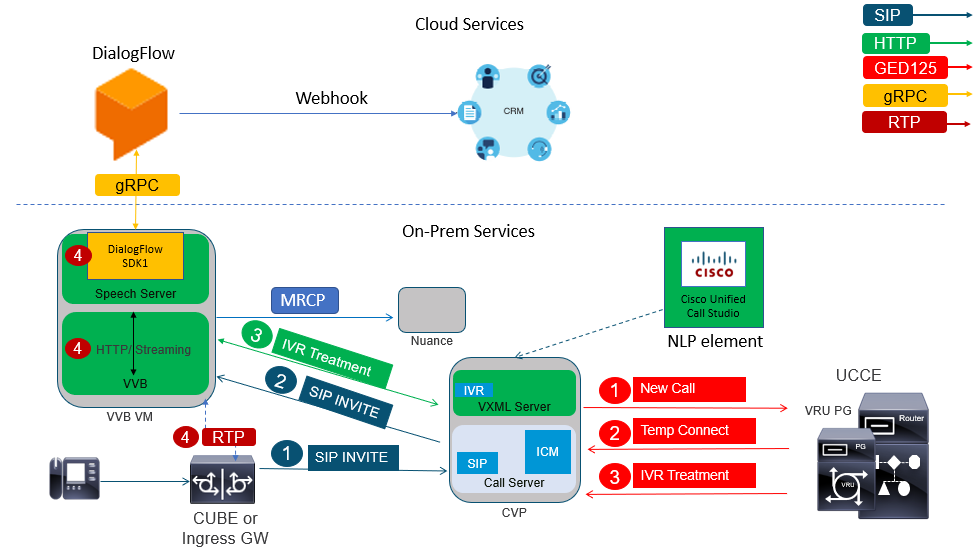

Nachfolgend finden Sie ein Beispiel für den Anruffluss:

- Der Anruf wird vom CUBE oder Eingangs-GW an den CVP-Anrufserver weitergeleitet. Der Anruf wird dann von CVP an Unified CCE/Paket CCE gesendet.

- CCE sendet eine temporäre Verbindung zu CVP zusammen mit der Anweisung, die VRU/IVR-Behandlung mit dem Cisco VVB einzustellen.

- CCE weist CVP an, eine Call Studio-Anwendung auszuführen, die auf dem VXML-Server bereitgestellt wird. Das CVP sendet den Anruf an die Cisco VVB, und die IVR-Behandlung wird gestartet. Das Audio (RTP) wird nun zwischen Cisco VVB und CUBE bzw. dem Eingangs-Gateway eingerichtet. Bis zu diesem Punkt entsprechen die Anrufflussschritte denen eines regulären umfassenden Anrufflusses. Die nächsten Schritte beziehen sich ausschließlich auf den CVA-Dialogflow-Anruffluss.

- Die Sprachdaten des Kunden werden mithilfe des Speech Servers auf der Cisco VVB an Google Dialogflow übertragen.

a. Sobald der Datenstrom bei Dialogflow empfangen wurde, erfolgt die Erkennung, und der NLU-Dienst wird aktiviert, um die Absicht zu identifizieren.

b. Der NLU-Dienst identifiziert die Ziele. Die Absichtsidentifizierung erfolgt auf Basis des in der Cloud erstellten virtuellen Agenten.

c. Dialogflow gibt die nachfolgenden Aufforderungen auf eine der folgenden Arten an Cisco VVB zurück (je nach Konfiguration der Call Studio-Anwendung):

Audio: Dialogflow gibt die Audio-Nutzlast in API-Antwort zurück.

Text: Dialogflow gibt als Antwort die Texteingabeaufforderung zurück, die von einem TTS-Dienst synthetisiert werden muss.

d. Cisco VVB spielt die Aufforderung an den Anrufer ab, um weitere Informationen zu erhalten.

e. Wenn der Anrufer antwortet, überträgt Cisco VVB diese Antwort an Dialogflow.

f. Dialogflow führt die Erfüllung durch und antwortet erneut mit den Aufforderungen auf eine der folgenden Arten:

Audio: Dialflow gibt die Audio-Nutzlast in API Antwort mit der Erfüllung Audio mit der Verwendung von webhook zurück.

Text: Dialogflow gibt die Texteingabeaufforderung mit dem Erfüllungstext als Antwort auf den Benutzerhaken zurück. Dieser wird von einem TTS-Dienst synthetisiert.

g. Dialogflow führt das Kontext- und Sitzungsmanagement für die gesamte Konversation durch.

Die Flow-Steuerung verbleibt bei Dialogflow, es sei denn, der Kunde fordert eine Agentenweiterleitung an oder der Anruf wird getrennt.

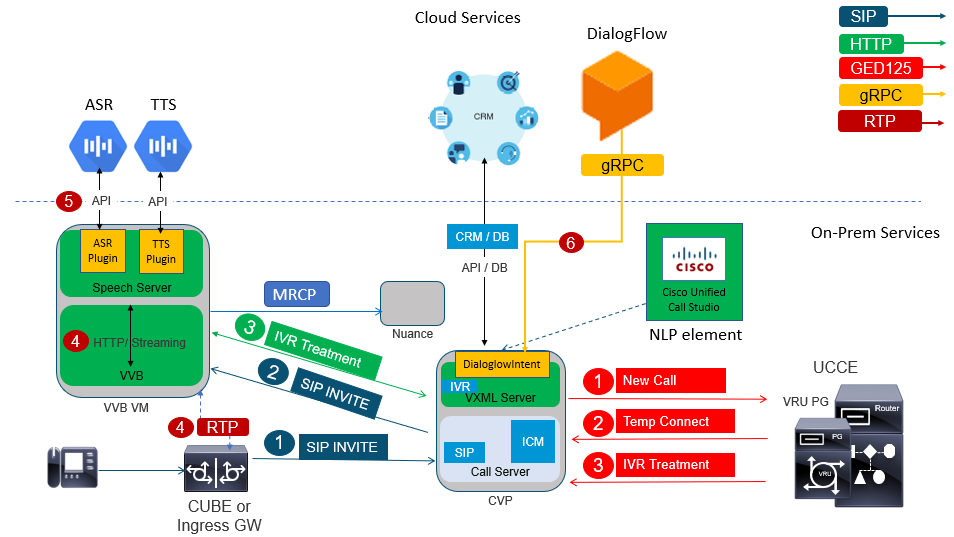

Zugelassene Absicht (DialogFlowIntent / DialogFlowParam)

Die standortbasierte Bereitstellung von Absichten eignet sich besser für Kunden, die persönliche Identitätsdaten (PII) oder andere vertrauliche Daten benötigen, die auf ihren lokalen Systemen verarbeitet werden sollen. In der Regel werden bei solchen Bereitstellungen personenbezogene Identitätsdaten (PII) nie zur Verarbeitung an die Cloud gesendet. Stattdessen werden sie so gesammelt, dass die Informationen stets vor Ort gespeichert und verarbeitet werden. Bei diesem Anruffluss erfolgt der Großteil der Prozesssteuerung auf dem VXML-Server. Dieser Anruffluss ermöglicht:

- Lokale Parameteraufforderung/-sequenz

- Lokale DTMF-Erkennung

- Aktuelle Anwendung erweitern

- Lokale Erfüllung

Dieser Anruffluss verwendet die Elemente DialogflowIntent und DialogflowParamt des Anrufstudios. Die Schritte 1 bis 3 entsprechen dem vorherigen Dialogflow-Anrufablauf. Hier die nachfolgenden Schritte

- Die Kundenstimme wird über den Speech Server auf der Cisco VVB zu Google Dialogflow gestreamt.

- In diesem Szenario leitet der Sprachserver die Sprache an den Cloud-ASR weiter.

- Sobald der Stream bei Google empfangen wurde, erfolgt die Erkennung, und der Text wird an den VXML-Server zurückgegeben. VXML-Server übergibt diesen Text an Dialogflow, und der NLU-Service wird aktiviert, um die Absicht zu identifizieren. NLU identifiziert die bereits konfigurierten Ziele. Die Absichtsidentifizierung erfolgt auf Basis des in der Cloud erstellten virtuellen Agenten.

a. Google Dialogflow gibt die beabsichtigte Anwendung an die im VXML-Server bereitgestellte Call Studio-Anwendung zurück.

b. Wenn für den angegebenen Zweck vertrauliche Informationen verarbeitet werden müssen, wie z. B. eine Kreditkartennummer oder eine PIN.

eingegeben hat, kann Cisco VVB die erforderliche Aufforderung abspielen und DTMFs (Dual Tone Multy Frequency) vom Endkunden sammeln.

c. Diese sensiblen Informationen werden von lokalen Geschäftsanwendungen gesammelt und an die Datenbank Customer Relationship Management (CRM) zur Authentifizierung und Weiterleitung gesendet.

Prozessen.

d. Nach der Authentifizierung des Kunden über seine PIN kann die Sprachsteuerung an den ASR-Service in der Cloud zurückgegeben werden.

e. Der VXML-Server führt über die Call Studio-Anwendung das Kontext- und Sitzungsmanagement für das gesamte Gespräch durch.

Im Wesentlichen bietet dieser Anruffluss eine wesentlich größere Flexibilität bei der Definition der Aktionen, die in jeder Phase basierend auf den Kundenbeiträgen ergriffen werden müssen, und wird vollständig von Vor-Ort-Anwendungen gesteuert. Cloud-Services werden hauptsächlich für die Erkennung von Sprache und Vorsätzen genutzt. Sobald die Absicht erkannt wurde, wird die Kontrolle an die CVP-Geschäftsanwendung zurückgegeben, um den nächsten Schritt zu verarbeiten und zu entscheiden.

Abschreiben

Dieser Anruffluss ermöglicht die Umwandlung von Sprachdaten in Textsätze, im Wesentlichen ASR.

Konfigurieren

Dialogflow-Projekt/virtueller Agent

Bevor Sie die CVA-Konfiguration starten, muss Google Dialogflow konfiguriert und mit dem Cisco Speech Server verbunden werden. Sie benötigen ein Google-Service-Konto, ein Google-Projekt und einen virtuellen DialogFlow-Agenten. Anschließend können Sie diesem virtuellen Mitarbeiter von Dialogflow die natürliche Sprache beibringen, sodass er auf die Kundeninteraktion mit der Verarbeitung der natürlichen Sprache reagieren kann.

Was ist ein Dialogflow?

Google Dialogflow ist eine Plattform für die Benutzererfahrung (User Experience, UX), die eine einzigartige, natürliche Sprachkommunikation für Geräte, Anwendungen und Services ermöglicht. Mit anderen Worten, Dialogflow ist ein Framework, das NLP/NLU-Services (Natural Language Understanding) bereitstellt.Cisco lässt sich in Google Dialogflow für CVA integrieren.

Was bedeutet das für Sie? Das bedeutet, dass Sie einen virtuellen Agenten in Dialogflow erstellen und diesen dann in Cisco Contact Center Enterprise integrieren können.

So erstellen Sie einen virtuellen Agenten oder ein Dialogflow-Projekt:

Schritt 1: Erstellen Sie ein Google-Konto/-Projekt, oder weisen Sie Ihnen ein Google-Projekt von Ihrem Cisco Partner zu.

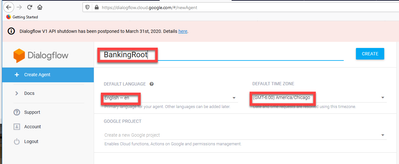

Schritt 2: Melden Sie sich bei Dialogflow an. Navigieren Sie zu https://dialogflow.com/.

Schritt 3: Erstellen Sie einen neuen Agenten. Wählen Sie einen Namen für den neuen Agenten und die Standard-Zeitzone aus. Behalten Sie die Einstellung für die Sprache Englisch bei. Klicken Sie auf CREATE AGENT.

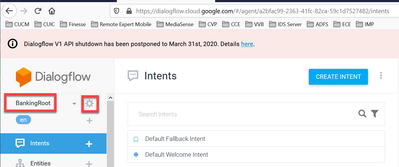

In diesem Beispiel verarbeitet der virtuelle Agent Banktransaktionen, daher lautet der Name des Agenten für diese Übung BankingRoot. Die Sprache ist Englisch, und die Zeitzone ist die Standard-Systemzeit.

Schritt 4: Klicken Sie auf die Registerkarte ERSTELLEN.

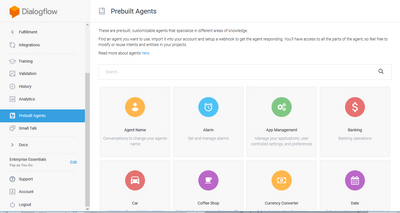

Schritt 5: Nachdem der virtuelle Agent erstellt wurde, können Sie die im Bild gezeigten virtuellen Google-Agenten importieren oder den Agenten lehren, wie er mit dem Anrufer kommunizieren soll.

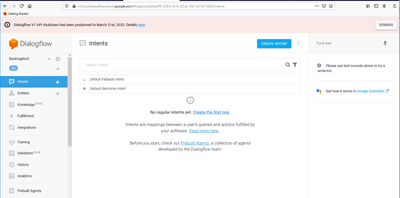

Schritt 6: An diesem Punkt weiß der Agent immer noch nicht, wie er auf Benutzereingaben reagieren soll. Der nächste Schritt ist, ihm beizubringen, wie man sich benimmt. Zuerst modellieren Sie die Persönlichkeit des Agenten und lassen es auf eine hello default Willkommensabsicht reagieren und präsentieren sich. Nachdem der Agent erstellt wurde, wird dieses Bild angezeigt.

Hinweis: hello kann im Dialogflow des Call Studio-Anwendungselements als standardmäßige Begrüßungsabsicht definiert werden.

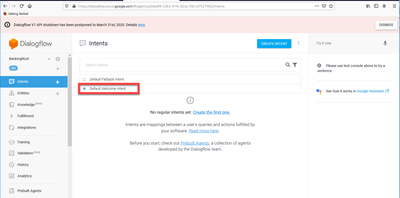

Schritt 7. Klicken Sie auf Standard-Willkommensabsicht.

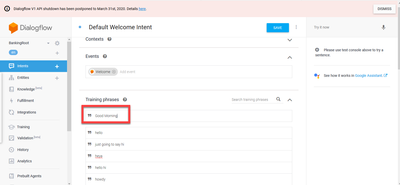

Schritt 8: Fügen Sie hallo, Guten Morgen und Guten Tag zu den Trainingssätzen. Geben Sie sie in das Textformular ein, und drücken Sie nach jedem Textfeld die Eingabetaste.

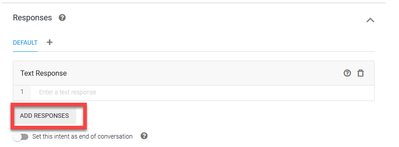

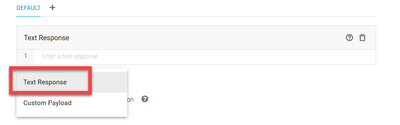

Schritt 9. Scrollen Sie jetzt nach unten zu Antworten, und klicken Sie auf ANTWORTEN HINZUFÜGEN.

Schritt 10. Wählen Sie Textantwort aus.

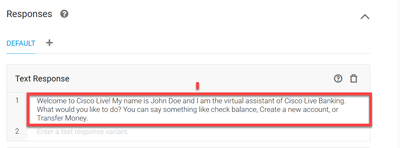

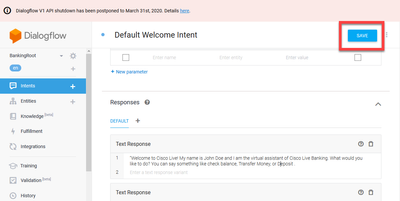

Fügen Sie eine angemessene Antwort hinzu, genau wie bei den Übungsphrasen. Dies ist die erste Nachricht, die der Benutzer vom Agent empfängt. Damit Ihr Agent natürlicher und gesprächiger klingt, denken Sie an ein normales Gespräch und stellen Sie sich vor, was ein Agent sagen würde. Dennoch ist es eine gute Praxis, den Benutzer darüber zu informieren, dass die Interaktion mit einem künstlich intelligenten (KI) Agenten stattfindet. In diesem Szenario wird eine Cisco Live Banking-Anwendung als Beispiel verwendet. Sie können also Folgendes hinzufügen:Willkommen bei der Cisco Live! Mein Name ist John Doe und ich bin der virtuelle Assistent von Cisco Live Banking. Was möchten Sie tun? Sie können etwas sagen wie Kontostand prüfen, ein neues Konto erstellen oder Geld überweisen.

Schritt 11. Klicken Sie auf Speichern.

Bevor Sie weitere Intents erstellen, erstellen Sie die Entitäten. Eine Entität ist eine Eigenschaft oder ein Parameter, der von Dialogflow verwendet werden kann, um die Anforderung des Benutzers zu beantworten. Die Entität ist in der Regel ein Schlüsselwort innerhalb der Absicht, wie z. B. ein Kontotyp, Datum, Ort usw. Fügen Sie also vor dem Hinzufügen weiterer Ziele die Entitäten hinzu: Kontotyp, Einzahlungstyp und Transfertyp.

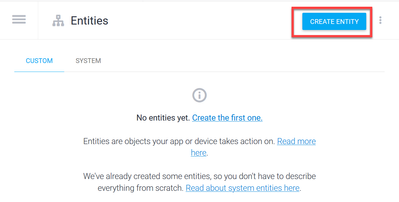

Schritt 12: Klicken Sie im Menü "Dialogfluss" auf Entities.

Schritt 13: Klicken Sie im Fenster Entitäten auf ENTITÄT ERSTELLEN.

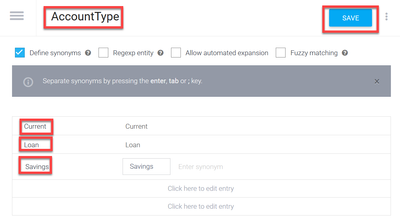

Schritt 14: Geben Sie für den Entitätsnamen AccountType ein. Geben Sie im Feld "Synonyme definieren" Folgendes ein: Aktuell, Darlehen und Ersparnisse, und klicken Sie auf SPEICHERN.

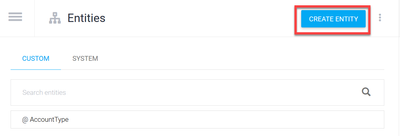

Schritt 15: Navigieren Sie zurück zum Menü "Dialogfluss", und klicken Sie erneut auf "Entities". Klicken Sie dann im Fenster "Entities" auf "ENTITY ERSTELLEN".

>

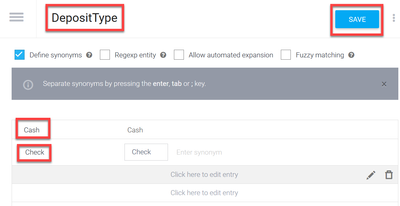

Schritt 16: Geben Sie für den Namen der Entität den Namen DepositType ein. Geben Sie im Feld "Synonyme definieren" Bargeld und Scheck ein, und klicken Sie auf SPEICHERN.

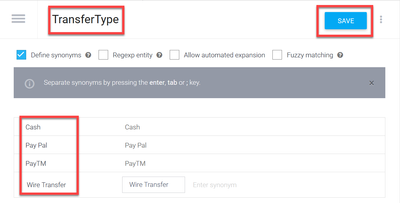

Schritt 17: Sie können weitere Einheiten erstellen, z. B.: TransferType und im Feld Synonyme definieren: Cash, Pay Pal, PayTM und Überweisung usw.

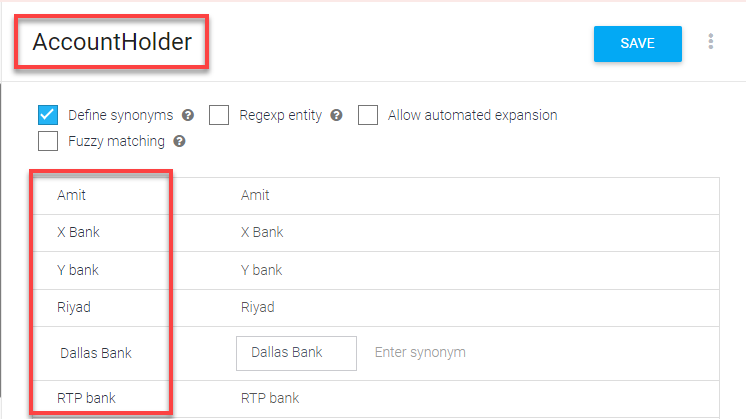

Schritt 18: Erstellen Sie die Kontoinhaberentität. Geben Sie im Feld Entitätsname den Namen AccountHolder und im Feld Synonyme definieren ein.

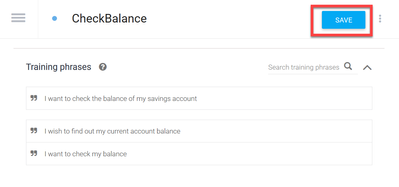

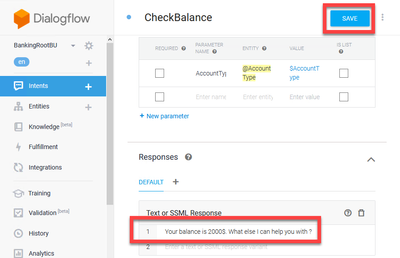

Schritt 19: Jetzt setzen Sie die Mitarbeiterschulung mit allen möglichen Fragen fort, die Sie im Bankensystem erhalten haben, und mit den typischen Antworten. Erstellen Sie die nächsten Pläne: CheckBalance, TransferMoney. Für die CheckBalance-Funktion können Sie die im Bild angezeigten Trainingssätze hinzufügen:

Sie können diese Antwort auch hinzufügen:

Schritt 20: Sie können die restlichen Intents (TransferMoney, CreateAccount und Exit), Schulungsphrasen, Parameter und Antworten hinzufügen.

Hinweis: Weitere Informationen zur Konfiguration von Google Dialogflow finden Sie unter: DialogFlow Virtual Agent

Konfiguration des CVVB-Sprachservers

Der Speech Server ist eine neue Komponente der Cisco VVB. Der Speech Server interagiert mit dem Google Dialog Flow über ein Open Source Remote Procedure Call (gRPC)-System, das ursprünglich von Google entwickelt wurde

Schritt 1: Tauschen Sie Zertifikate zwischen PCCE-Admin-Workstation (AW), CVP und CVVB aus, wenn dies nicht der Fall ist. Wenn sich Ihre Bereitstellung auf UCCE befindet, tauschen Sie die Zertifikate zwischen CVP New Operations Manager-Server (NOAMP), CVP und CVVB aus.

Hinweis: Weitere Informationen zum PCCE-Zertifikataustausch finden Sie in den folgenden Dokumenten: Selbstsignierte Zertifikate in einer PCCE-Lösung und Verwalten des PCCE-Komponentenzertifikats für SPOG . Informationen zu UCCE finden Sie unter Selbstsigniertes Zertifikat auf UCCE .

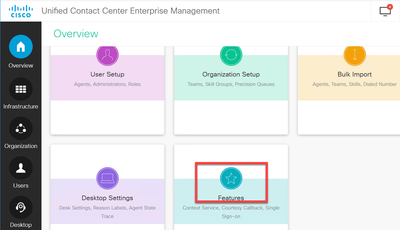

Schritt 2: Öffnen Sie auf PCCE die Schnittstelle CCE Admin / Single Plane of Glass (SPOG). Wenn sich Ihre Bereitstellung auf UCCE befindet, führen Sie diese Schritte auf dem NOAMP-Server aus.

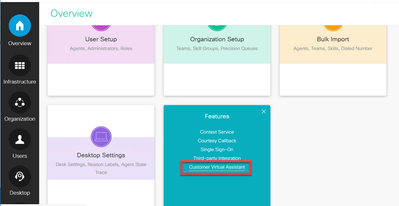

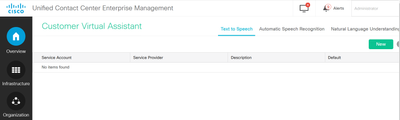

Schritt 3: Wählen Sie unter Features die Option Customer Virtual Assistant aus.

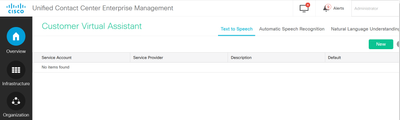

Schritt 4: Jetzt sollten Sie drei Registerkarten sehen: Text in Sprache, Automatische Spracherkennung und natürliches Sprachverständnis.

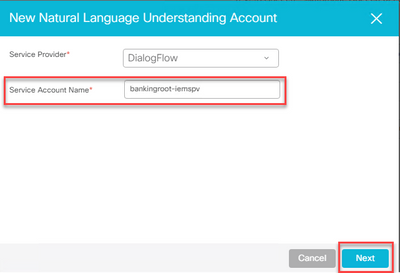

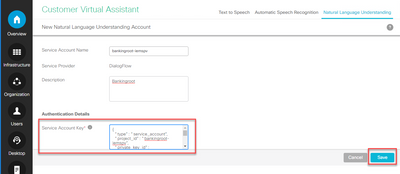

Schritt 5: Klicken Sie auf Natural Language Understanding und dann auf New.

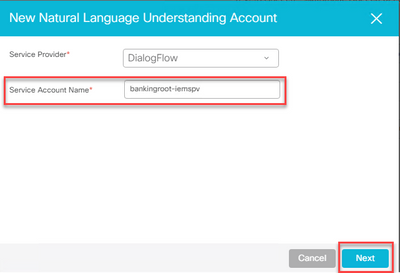

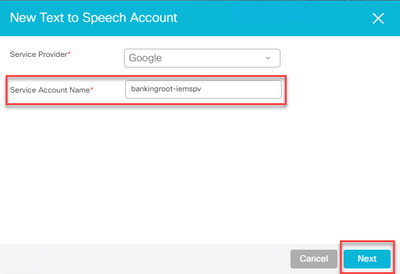

Schritt 6: Wählen Sie im Fenster New Natural Language Understanding Account (Neues Konto für natürliches Sprachverständnis) Dialogflow als Dienstanbieter aus.

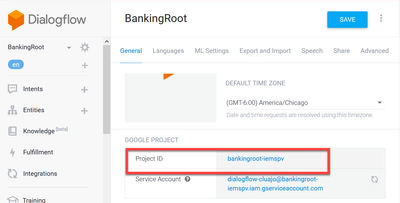

Schritt 7. Für den Service-Kontonamen müssen Sie das Google-Projekt angeben, das sich auf den von Ihnen in Google Dialogflow erstellten virtuellen Agenten bezieht.

Gehen Sie folgendermaßen vor, um das Projekt zu identifizieren, das sich auf den erstellten virtuellen Agenten bezieht:

a. Melden Sie sich bei Ihrem DialogFlow-Konto (dialogflow.com) an, wählen Sie den erstellten Agenten aus, und klicken Sie auf das Einstellungssymbol.

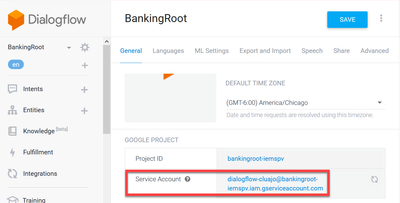

b. Blättern Sie im Einstellungsfenster auf der rechten Seite nach unten, und Sie sehen das Dienstkonto und die Projekt-ID. Kopieren Sie die Projekt-ID, d. h. den Service-Kontonamen, den Sie in der Speech Server-Konfiguration hinzufügen müssen.

Schritt 8: Um die Google Dialog Flow APIs zu verwenden, die zur Identifizierung und Reaktion auf Kundenabsichten erforderlich sind, müssen Sie einen privaten Schlüssel erhalten, der mit dem Dienstkonto eines virtuellen Agenten verknüpft ist.

Der private Schlüssel wird bei Erstellung des Dienstkontos als JSON-Datei heruntergeladen. Befolgen Sie dieses Verfahren, um den privaten Schlüssel des virtuellen Agenten zu erhalten.

Hinweis: Es ist zwingend erforderlich, ein neues Dienstkonto zu erstellen, anstatt eines der mit dem Projekt verknüpften Standarddienstkonten von Google zu verwenden.

a. Klicken Sie im Google Project-Bereich auf die URL des Dienstkontos.

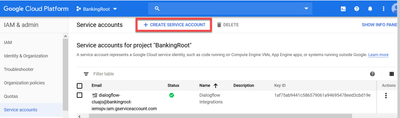

b. Dadurch gelangen Sie zur Seite Google Cloud Platform Service-Konten. Nun müssen Sie dem Dienstkonto zunächst Rollen hinzufügen. Klicken Sie auf die Schaltfläche Create Service Account (Dienstkonto erstellen) oben auf der Seite.

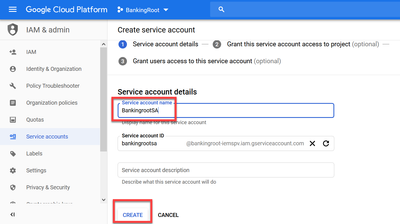

c. Geben Sie im Popup-Fenster einen Namen für das Dienstkonto ein. Geben Sie in diesem Fall BankingRootSA ein und klicken Sie auf ERSTELLEN.

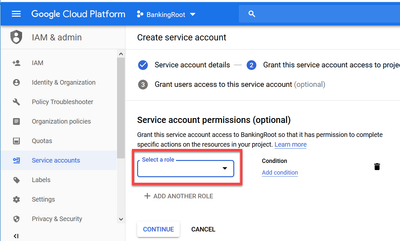

d. Klicken Sie auf Rolle auswählen.

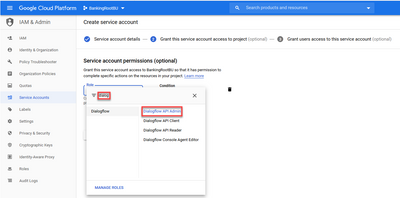

e. Wählen Sie unter der Kategorie Dialogfluss die gewünschte Rolle aus. Wählen Sie Dialogflow API Admin aus, und klicken Sie auf Weiter.

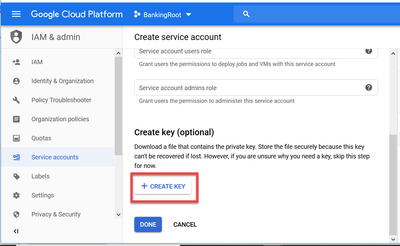

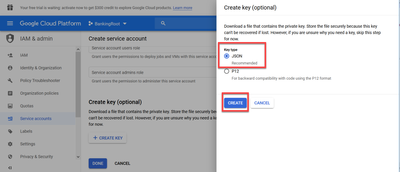

f. Blättern Sie nach unten, und wählen Sie SCHLÜSSEL ERSTELLEN aus.

g. Vergewissern Sie sich im Fenster für den privaten Schlüssel, dass JSON für den Schlüsseltyp ausgewählt ist, und klicken Sie auf ERSTELLEN.

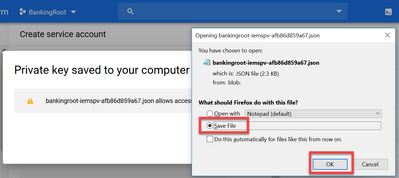

h. Der Download der JSON-Datei wird gestartet. Aktivieren Sie das Kontrollkästchen Datei speichern, wählen Sie einen Speicherort aus, an dem Sie die Datei speichern und bestätigen möchten.

Achtung: Sie können diese JSON-Datei nur einmal herunterladen, also stellen Sie sicher, dass Sie die Datei speichern und an einem sicheren Ort aufbewahren. Wenn Sie diesen Schlüssel verlieren oder wenn er kompromittiert wird, können Sie den gleichen Prozess verwenden, um einen neuen Schlüssel zu erstellen. Die JSON-Datei wird im Ordner C:\Download gespeichert.

i. Nach Abschluss dieses Vorgangs wird ein Popup mit einer Bestätigungsmeldung angezeigt. Klicken Sie auf Close (Schließen).

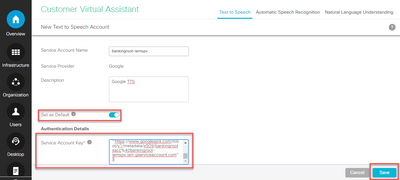

Schritt 9. Nachdem Sie im NLU-Kontofenster auf WEITER geklickt haben, müssen Sie den Authentifizierungsschlüssel angeben.

Schritt 10.Fügen Sie die Beschreibung hinzu. Navigieren Sie zu dem Ordner, in den Sie die JSON-Datei herunterladen. Bearbeiten Sie die Datei, wählen Sie alle Zeilen in der Datei aus, und kopieren Sie sie in das Feld für den Dienstkontenschlüssel. Klicken Sie auf Speichern.

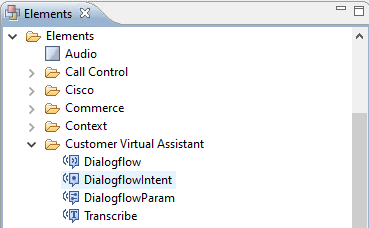

Elemente des CVP Call Studio

CVP Call Studio Release 12.5 wurde verbessert und diese vier Elemente (wie im Bild gezeigt) wurden hinzugefügt, um die Konfiguration der CVA-Funktion zu vereinfachen.

Im Folgenden finden Sie eine kurze Beschreibung der einzelnen Elemente:

Dialogfluss

Dialogflow wurde erstellt, um ASR-, NLU- und TTS-Services über die Cloud einzubinden und zu verwalten. Dialogflow simuliert eine gehostete IVR-Bereitstellung, bei der alle Sprachdienste von Google Dialogflow genutzt und die gesamte Geschäftslogik über die Cloud gesteuert und gesteuert wird.

DialogflussZweck

DialogflowIntent wurde für die Aktivierung von Cloud-Services für die Erkennung (ASR-Service) und die Intent-Identifikation (NLU-Service) erstellt. Sobald die Absicht identifiziert und an den CVP VXML-Server weitergeleitet wurde, können der Umgang mit der Absicht und alle weiteren Aktionen über das CVP Call Studio-Skript ausgeführt werden. Hier können Anwendungsentwickler TTS-Services flexibel von der Cloud oder vom Standort aus nutzen.

DialogflussParameter

DialogflowParam arbeitet mit dem DialogflowIntent-Element zusammen. Wenn bei einer typischen IVR-Bereitstellung vor Ort die Absicht des Kunden erkannt und an den VXML-Server übergeben wird, müssen die Parameter identifiziert werden. Dies sollte von der CVP-Anwendung gesteuert werden. In einer typischen Banking-Anwendung könnten beispielsweise ausgelassene Eingaben aus Kundengesprächen analysiert und noch erforderliche Eingaben angefordert werden, bevor die gesamte Transaktion verarbeitet wird. Im obigen Szenario arbeitet das DialogflowParam-Element mit dem DialogflowIntent-Element zusammen, um den identifizierten Zweck zu verarbeiten und die erforderlichen Parameter hinzuzufügen.

Abschreiben

Transcribe wurde erstellt, um Kundensprache zu verarbeiten und Text als Ausgabe zurückzugeben. Es führt im Wesentlichen die Erkennungsfunktion aus und gibt Text als Ausgabe aus. Dieses Element sollte verwendet werden, wenn nur eine ASR-Funktion erforderlich ist.

Weitere Informationen zur Parametereinstellung unter den einzelnen Elementen finden Sie im Leitfaden zu den Elementspezifikationen, Version 12.5.

CVP Call Studio-Anwendungen

Cloud-basierte Intent-Verarbeitung - Google-basierte IVR-Logik (Dialogflow)

Wenn ein Anruf eine VXML-Anwendung erreicht, übernimmt das Dialogflow-Element und beginnt mit der Verarbeitung der Spracheingabe.

Der Dialog mit dem Kunden wird fortgesetzt, und soweit der virtuelle Google-Agent Absichten erkennen und verarbeiten kann, werden die Medien über TTS-Dienste zurückgegeben. Bei jeder Kundenanfrage wird der Fluss in einer Schleife um das Dialogflow-Element herum fortgesetzt, und jede übereinstimmende Absicht wird gegen ein Entscheidungsfeld geleitet, um zu bestimmen, ob die IVR-Behandlung fortgesetzt werden soll oder ob der Kunde den Anruf an einen Agenten weiterleiten muss.

Nach der Auslösung der Agentenweiterleitungsentscheidung wird der Anruf an das CVP weitergeleitet, und die Steuerung wird übergeben, um den Anruf in die Warteschlange zu stellen und ihn dann an einen Agenten weiterzuleiten.

Nachfolgend sind die Konfigurationsschritte für eine Beispielanwendung für ein Call Studio aufgeführt:

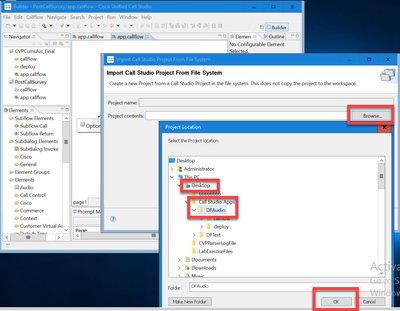

Schritt 1: Importieren Sie die Anwendung in Call Studio oder erstellen Sie eine neue. In diesem Beispiel wurde eine Anrufstudio-Anwendung mit dem Namen DFaudio aus Cisco DevNet Sample CVA Application-DFAudio importiert.

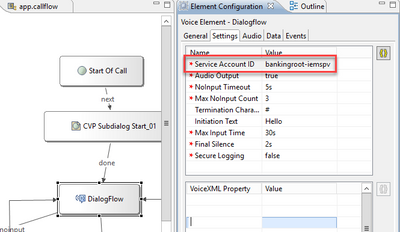

Schritt 2: Wählen Sie in der DFAudio-Anwendung das Element Dialogfluss und auf der rechten Seite die Registerkarte Einstellungen aus. Ändern Sie den Namen des Dienstkontos in die Projekt-ID, die zuvor zum Speech Server hinzugefügt wurde. In diesem Beispiel lautet der Name:bankingroot-iemspv

Schritt 3: Stellen Sie sicher, dass der Parameter Audio Output (Audioausgabe) an true gesendet wird, damit Audio an den virtuellen DialogFlow-Agenten anstatt an Text gesendet wird.

Schritt 4: Validierung, Speicherung und Bereitstellung der Anwendung auf dem VXML-Server.

Schritt 5: Stellen Sie die Anwendung jetzt im Arbeitsspeicher des VXML-Servers bereit. Öffnen Sie auf dem CVP VXML-Server den Windows Explorer, navigieren Sie zu C:\Cisco\CVP\VXMLServer, und klicken Sie auf deployAllNewApps.bat. Wenn die Anwendung zuvor auf dem VXML-Server bereitgestellt wurde, klicken Sie stattdessen auf UpdateAllApps.bat.

Standortbasierte Intent-Verarbeitung (DialogflowIntent / DialogflowParam)

In diesem Beispiel bezieht sich der Anruffluss auf eine Bankanwendung, bei der Kunden ihren Kontostand überprüfen und einen bestimmten Geldbetrag von einem Sparkonto auf ein anderes Konto überweisen können. Die ersten Transkriptionselemente erfassen die Identifikationsdaten vom Kunden per Sprache und validieren diese mit der ANI-Nummer. Nachdem die Endkundenerkennung validiert wurde, wird die Anrufsteuerung an das DialogFlowIntent-Element übergeben, um die Aufgabe des Kunden zu identifizieren. Basierend auf Kundeneingaben (z. B. zu übertragender Betrag) fordert die CVP Call Studio-Anwendung die verbleibenden Parameter vom Endkunden an, um die Absicht weiter zu verarbeiten. Nach Abschluss der Überweisung kann der Kunde den Anruf beenden oder eine Überweisung an einen Mitarbeiter anfordern.

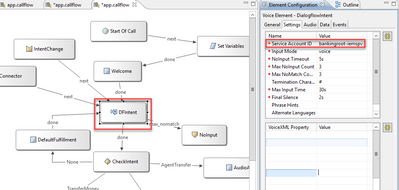

Schritt 1: Importieren Sie die Anwendung in Call Studio oder erstellen Sie eine neue. In diesem Beispiel wurde eine Anrufstudio-Anwendung mit dem Namen DFRemote aus Cisco Device Sample CVA Application-DFRemote importiert.

Schritt 2: Wählen Sie in der DFRemote-Anwendung das Element DialogflowIntent (DFIntent) und auf der rechten Seite die Registerkarte Einstellungen aus. Ändern Sie den Namen des Dienstkontos in die Projekt-ID, die zuvor zum Speech Server hinzugefügt wurde. In diesem Beispiel lautet der Name wie folgt: bankingroot-iemspv

Schritt 3: Stellen Sie sicher, dass der Parameter "Input Mode" (Eingabemodus) auf "voice" (Sprache) eingestellt ist. Sie können sowohl Voice als auch DTMF einstellen, aber für dieses Element muss Voice eingestellt sein, da keine Parameter erfasst werden. Wenn Sie den DialogFlowParam verwenden, können Sie beide festlegen. In diesem Element sammeln Sie den Eingabeparameter des Aufrufers.

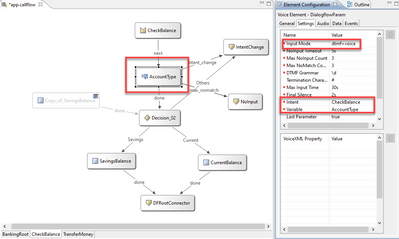

Schritt 4: In diesem Beispiel fordert die Anwendung den Kunden auf, den Kontotyp per DTMF oder Sprache anzugeben, wenn ein Kunde anruft, um den Kontostand zu überprüfen. Diese Informationen werden im DialogFlowParam-Element (AccountType wie im Bild dargestellt) gesammelt. Um die erforderlichen Parameter zu erfassen, ändern Sie die Einstellungen von DialogflowParam. Wählen Sie im Eingabemodus "dtmf+voice" aus, damit der Anrufer entweder den Kontotyp eingeben oder angeben kann. Geben Sie im Parameter Intent (Absicht) die entsprechende Absicht ein, in diesem Fall CheckBalance. In der Einstellung "Variable"

Wählen Sie den Parameter der Absicht aus, in diesem Fall AccountType. Wenn dies der letzte Parameter der Absicht ist, setzen Sie die Variable Last Parameter auf true. Weitere Informationen zu den DialogflowParam-Einstellungen finden Sie im Leitfaden zu Elementspezifikationen, Version 12.5.

Schritt 5: Validierung, Speicherung und Bereitstellung der Anwendung auf dem VXML-Server.

Schritt 6: Stellen Sie die Anwendung jetzt im Arbeitsspeicher des VXML-Servers bereit. Öffnen Sie auf dem CVP VXML-Server den Windows Explorer, navigieren Sie zu C:\Cisco\CVP\VXMLServer, und klicken Sie auf deployAllNewApps.bat. Wenn die Anwendung zuvor auf dem VXML-Server bereitgestellt wurde, klicken Sie stattdessen auf UpdateAllApps.bat.

Schritt 7. Kopieren Sie die zuvor heruntergeladene JSON-Datei in das Verzeichnis C:\Cisco\CVP\Conf. Der Name der Jason-Datei muss mit dem Projektnamen übereinstimmen, in diesem Fall bankingroot-iemspv.json.

Schritt 8: Fügen Sie die TTS- und ASR-Services von Google hinzu, falls diese Services erforderlich sind, wie in diesem Beispiel. Wenn Ihre Bereitstellung auf UCCE erfolgt, fügen Sie TTS und ASR über den NOAMP-Server hinzu. Öffnen Sie auf PCCE die Schnittstelle CCE Admin / Single Plane of Glass (SPOG).

Schritt 9. Wählen Sie unter der Funktionskarte Customer Virtual Assistant aus.

Schritt 10. Fügen Sie zunächst den TTS-Service hinzu, und befolgen Sie dann die gleichen Schritte, um den ASR-Service hinzuzufügen. Klicke auf "Text in Sprache" und dann auf "Neu".

Schritt 11. Wählen Sie als Service Provider Google aus, und fügen Sie den Service-Kontonamen hinzu (der in den vorherigen Schritten mit dem NLU-Konto identisch war). Klicken Sie auf Next (Weiter).

Schritt 12: Legen Sie diesen TTS-Dienst als Standard fest, und kopieren Sie den Inhalt der in den vorherigen Schritten generierten NLU-json-Datei als ASR- und TTS-json-Schlüssel. Klicken Sie auf Speichern.

Hinweis: TTS- und ASR-Dienstkonten erfordern keine Zuweisung einer Rolle. Wenn Sie jedoch dasselbe NLU-Dienstkonto für ASR und TTS verwenden, müssen Sie sicherstellen, dass dieses Dienstkonto Zugriff auf TTS- und ASR-APIs hat.

Im Allgemeinen ist dies der Prozessfluss, wenn Sie DialogflowIntent und DialogflowParam verwenden:

1. Call Studio / VXML-Anwendung liest die JSON-Datei von C:\Cisco\CVP\Conf\

2. DialogflowIntent-Audioaufforderung wird abgespielt, entweder die Audiodatei oder der TTS in der Audioeinstellung wird in Audio konvertiert.

3. Wenn der Kunde jetzt spricht, wird der Ton an die Erkennungs-Engine Google ASR übertragen.

4. Google ASR wandelt die Sprache in Text um.

5. Der Text wird vom VXML-Server an den Dialogflow gesendet.

6. Google Dialogflow gibt die Absicht in Form von Text an das DialogflowIntent-Element der VXML-Anwendung zurück.

Proxy-Serverkonfiguration

Das Google Software Development Kit (SDK) in Cisco VVB verwendet das gRPC-Protokoll, um mit Google Dialogflow zu interagieren. gRPC verwendet HTTP/2 für den Transport.

Da das zugrunde liegende Protokoll HTTP ist, müssen Sie HTTP Proxy für den End-to-End-Kommunikationsaufbau konfigurieren, wenn es keine direkte Kommunikation zwischen Cisco VB und Google Dialogflow gibt.

Der Proxyserver sollte die HTTP 2.0-Version unterstützen. Cisco VVB stellt CLI-Befehle zum Konfigurieren der Proxy-Host- und -Port-Konfiguration bereit.

Schritt 1: Konfigurieren Sie den httpsProxy-Host.

set speechserver httpsProxy host <hostname>

Schritt 2: Konfigurieren des httpsProxy-Ports

set speechserver httpsProxy port <portNumber>

Schritt 3: Validieren Sie die Konfiguration mit dem Befehl show httpsProxy.

show speechserver httpsProxy host

show speechserver httpsProxy port

Schritt 4: Starten Sie den Cisco Speech Server-Dienst nach der Proxy-Konfiguration neu.

utils service restart Cisco Speech Server

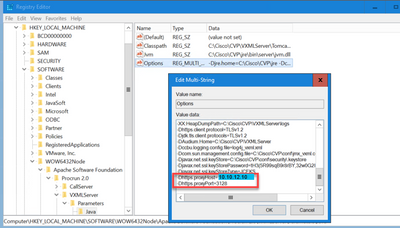

Wenn Sie das Bereitstellungsmodell für die standortbasierte Intent-Verarbeitung (DialogflowIntent / DialogflowParam) implementiert haben und keine direkte Internetverbindung zwischen dem CVP VXML-Server und Google Dialogflow besteht, müssen Sie den Proxyserver auf dem CVP VXML-Server konfigurieren.

Schritt 1: Melden Sie sich beim CVP VXML-Server an.

Schritt 2: Führen Sie den Befehl regedit aus.

Schritt 3: Navigieren Sie zu HKEY_LOCAL_MACHINE\SOFTWARE\WOW6432Node\Apache Software Foundation\Procrun 2.0\VXMLServer\Parameters\Java\Options.

Schritt 4: Hängen Sie diese Zeilen an die Datei an.

-Dhttps.proxyHost=<Ihr Proxy-IP/Host>

-Dhttps.proxyPort=<Ihre Proxy-Portnummer>

Schritt 5: Starten Sie den Dienst Cisco CVP VXML Server neu.

Fehlerbehebung

Wenn Sie CVA-Probleme beheben müssen, lesen Sie bitte die Informationen in diesem Dokument Fehlerbehebung für Cisco Customer Virtual Assistant .

Zugehörige Informationen

Cisco Dokumentation

- Beispielcode

- CVA-Design

- Konfigurieren von CVA-Services in UCCE mit OAMP

- Konfigurieren der CVA-Services in PCCE

- Dialogflow Call Studio-Element

- DialogFlowIntent Call Studio-Element

- DialogFlowParam Call Studio-Element

- Transcribe Call Studio-Element

Google-Dokumentation

- Dialogfluss-API aktivieren

- Cloud Speech-to-Text-API

- Cloud Text-to-Speech-API

- Dialogflow-Abrechnung

- Google Enterprise Edition

- Verbesserte Modelle

- Dialogflow-Authentifizierungsschlüssel

- Umwandlung von Sprachnachrichten in Text

- Text-in-Sprache-Taste

- Dialogflow - Grundlagen

- Einrichten des Dialflow Agents

- Erstellen eines Dialogfluss-Agenten

Revisionsverlauf

| Überarbeitung | Veröffentlichungsdatum | Kommentare |

|---|---|---|

2.0 |

18-Dec-2023 |

Version 2 |

1.0 |

14-May-2020 |

Erstveröffentlichung |

Beiträge von Cisco Ingenieuren

- Ramiro AmayaCisco TAC Engineer

- Anuj BhatiaCisco TAC Engineer

- Robert RogierCisco TAC Engineer

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback