Solucionar problemas do cluster Firepower Threat Defense (FTD)

Linguagem imparcial

O conjunto de documentação deste produto faz o possível para usar uma linguagem imparcial. Para os fins deste conjunto de documentação, a imparcialidade é definida como uma linguagem que não implica em discriminação baseada em idade, deficiência, gênero, identidade racial, identidade étnica, orientação sexual, status socioeconômico e interseccionalidade. Pode haver exceções na documentação devido à linguagem codificada nas interfaces de usuário do software do produto, linguagem usada com base na documentação de RFP ou linguagem usada por um produto de terceiros referenciado. Saiba mais sobre como a Cisco está usando a linguagem inclusiva.

Sobre esta tradução

A Cisco traduziu este documento com a ajuda de tecnologias de tradução automática e humana para oferecer conteúdo de suporte aos seus usuários no seu próprio idioma, independentemente da localização. Observe que mesmo a melhor tradução automática não será tão precisa quanto as realizadas por um tradutor profissional. A Cisco Systems, Inc. não se responsabiliza pela precisão destas traduções e recomenda que o documento original em inglês (link fornecido) seja sempre consultado.

Contents

Introdução

Este documento descreve a solução de problemas de uma configuração de cluster no firewall de próxima geração Firepower (NGFW).

Pré-requisitos

Requisitos

A Cisco recomenda que você tenha conhecimento destes tópicos (consulte a seção Informações Relacionadas para obter links):

- Arquitetura da plataforma Firepower

- Configuração e operação do cluster Firepower

- Familiaridade com a CLI FTD e Firepower eXtensible Operating System (FXOS)

- NGFW/registros de plano de dados

- NGFW/rastreador de pacotes de plano de dados

- Capturas de plano de dados/FXOS

Componentes Utilizados

- HW: Firepower 4125

- SW: 6.7.0 (Build 65) - plano de dados 9.15(1)

As informações neste documento foram criadas a partir de dispositivos em um ambiente de laboratório específico. Todos os dispositivos utilizados neste documento foram iniciados com uma configuração (padrão) inicial. Se a rede estiver ativa, certifique-se de que você entenda o impacto potencial de qualquer comando.

Informações de Apoio

A maioria dos itens abordados neste documento também se aplica totalmente à solução de problemas de cluster do Adaptive Security Appliance (ASA).

Configurar

A parte de configuração de uma implantação de cluster é abordada nos guias de configuração FMC e FXOS:

- Organização por clusters para o Firepower Threat Defense

- Implantação de um cluster do Firepower Threat Defense para escalabilidade e alta disponibilidade

Noções Básicas do Cluster

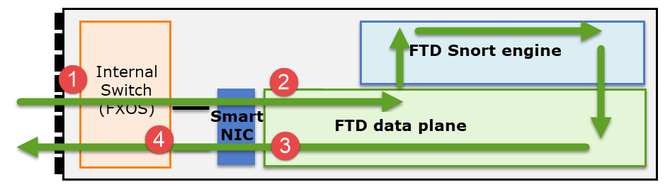

Arquitetura NGFW

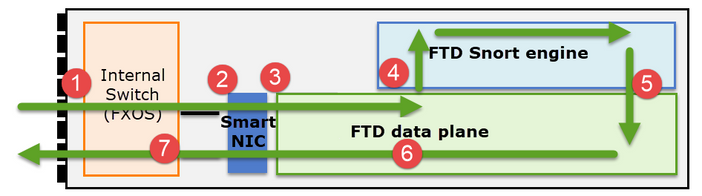

É importante entender como um Firepower 41xx ou 93xx Series lida com pacotes de trânsito:

- Um pacote entra na interface de entrada e é tratado pelo switch interno do chassi.

- O pacote passa pela placa de rede inteligente. Se o fluxo for descarregado (aceleração de HW), o pacote será tratado exclusivamente pela placa de rede inteligente e enviado de volta à rede.

- Se o pacote não for descarregado, ele entra no plano de dados do FTD que faz principalmente verificações de L3/L4.

- Se a política exigir, o pacote será inspecionado pelo mecanismo Snort (principalmente inspeção L7).

- O mecanismo Snort retorna um veredito (por exemplo, permitir ou bloquear) para o pacote.

- O plano de dados descarta ou encaminha o pacote com base no veredito do Snort.

- O pacote sai do chassi através do switch interno do chassi.

Capturas de cluster

Os dispositivos Firepower oferecem vários pontos de captura que oferecem visibilidade aos fluxos de trânsito. Ao solucionar problemas e ativar capturas de cluster, os principais desafios são:

- O número de capturas aumenta à medida que o número de unidades no cluster aumenta.

- Você precisa estar ciente de como o cluster trata um fluxo específico para poder rastrear o pacote pelo cluster.

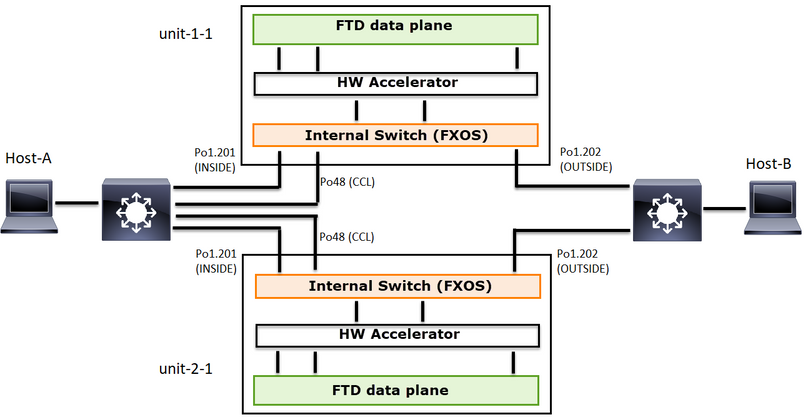

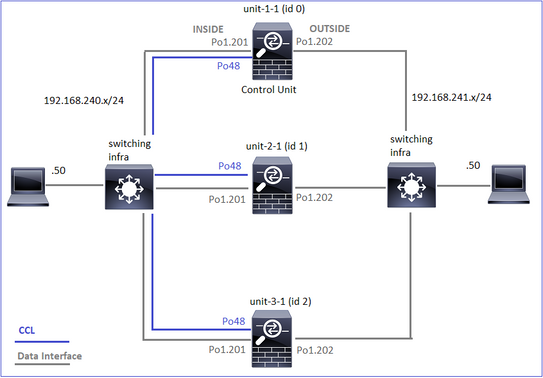

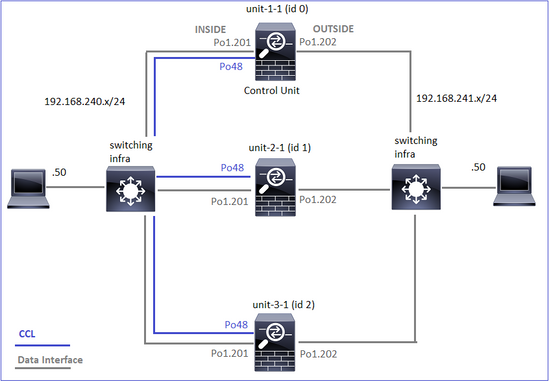

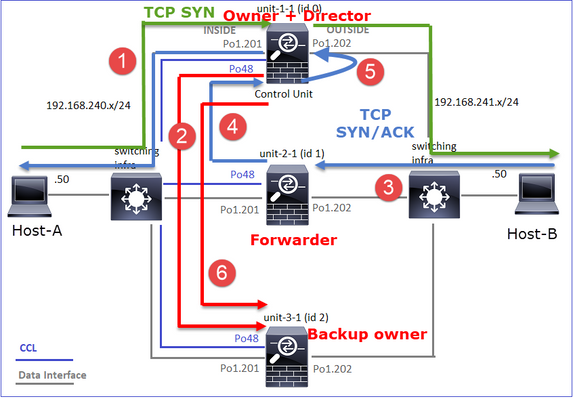

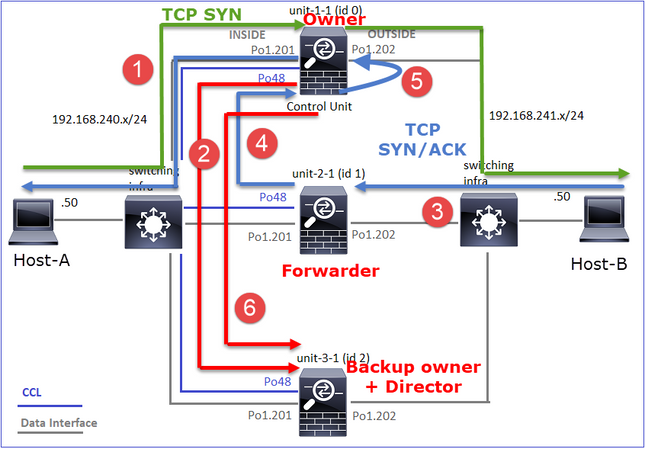

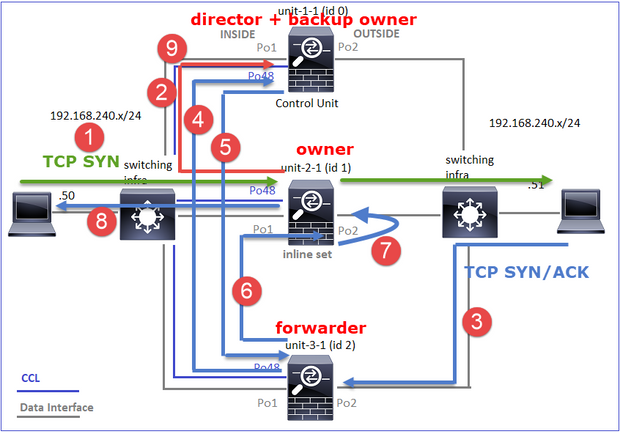

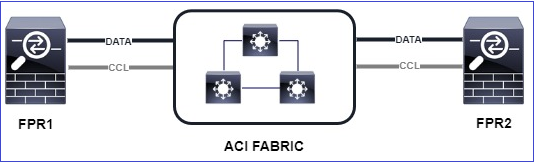

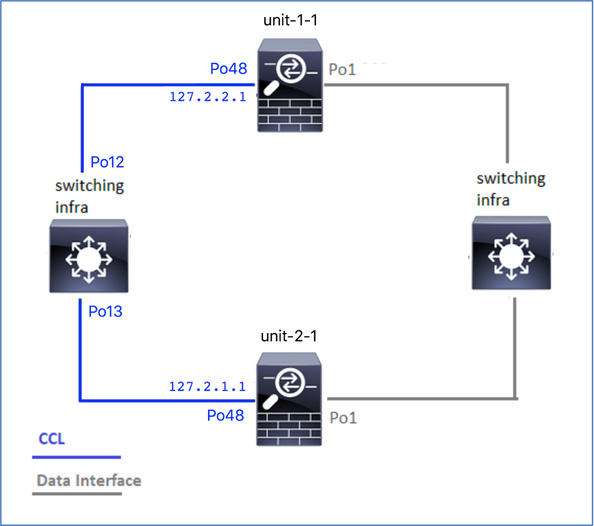

Este diagrama mostra um cluster de 2 unidades (por exemplo, FP941xx/FP9300):

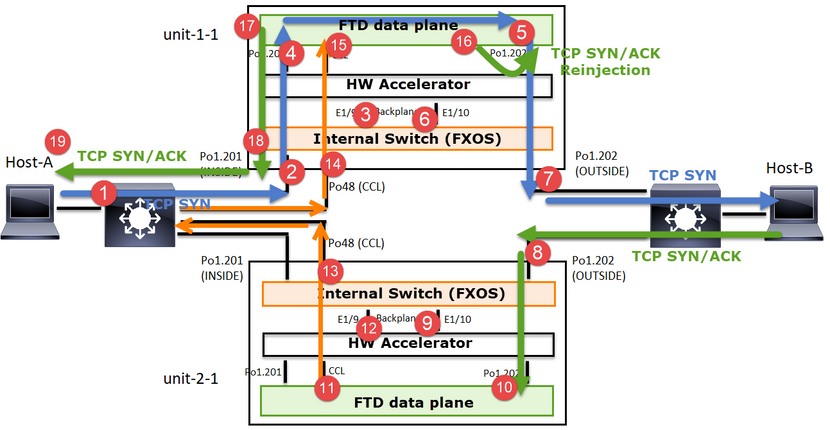

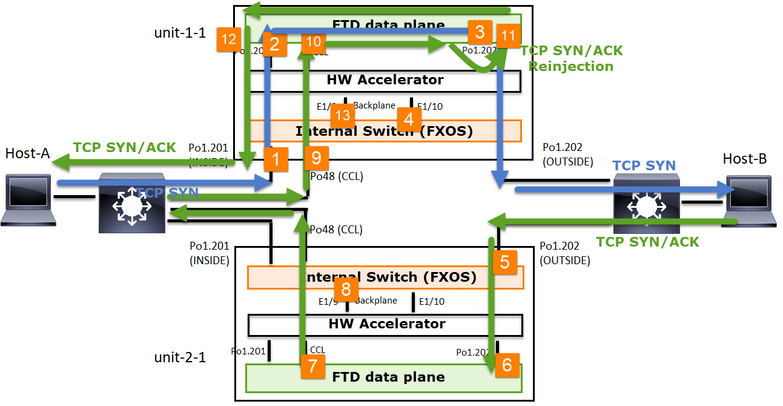

No caso do estabelecimento de uma conexão TCP assimétrica, uma troca TCP SYN, SYN/ACK é semelhante a esta:

Encaminhar tráfego

- O TCP SYN é enviado do Host-A para o Host-B.

- O TCP SYN chega ao chassi (um dos membros do Po1).

- O TCP SYN é enviado através de uma das interfaces de backplane do chassi (por exemplo, E1/9, E1/10, etc.) para o plano de dados.

- O TCP SYN chega à interface de ingresso do plano de dados (Po1.201/INSIDE). Neste exemplo, a unidade 1-1 assume a propriedade do fluxo, faz a seleção aleatória do Initial Sequence Number (ISN) e codifica as informações de propriedade (cookie) no número Seq.

- O TCP SYN é enviado de Po1.202/OUTSIDE (interface de saída do plano de dados).

- O TCP SYN chega a uma das interfaces de backplane do chassi (por exemplo, E1/9, E1/10, etc.).

- O TCP SYN é enviado para fora da interface física do chassi (um dos membros de Po1) em direção ao Host-B.

Tráfego de retorno

- O TCP SYN/ACK é enviado do Host-B e chega à unidade 2-1 (um dos membros da Po1).

- O TCP SYN/ACK é enviado através de uma das interfaces de backplane do chassi (por exemplo, E1/9, E1/10, etc.) para o plano de dados.

- O TCP SYN/ACK chega à interface de ingresso do plano de dados (Po1.202/OUTSIDE).

- O TCP SYN/ACK é enviado do Cluster Control Link (CCL) em direção à unidade 1-1. Por padrão, o ISN está habilitado. Assim, o encaminhador encontra as informações do proprietário para TCP SYN+ACKs sem o envolvimento do direcionador. Para outros pacotes ou quando o ISN é desativado, o direcionador é consultado.

- O TCP SYN/ACK chega a uma das interfaces de backplane do chassi (por exemplo, E1/9, E1/10 e assim por diante).

- O TCP SYN/ACK é enviado para fora da interface física do chassi (um dos membros do Po48) em direção à unidade 1-1.

- O TCP SYN/ACK chega à unidade 1-1 (um dos membros da Po48).

- O TCP SYN/ACK é encaminhado através de uma das interfaces de painel traseiro do chassi para a interface de canal de porta CCL do plano de dados (nome do cluster).

- O plano de dados injeta novamente o pacote TCP SYN/ACK na interface de plano de dados Po1.202/OUTSIDE.

- O TCP SYN/ACK é enviado de Po1.201/INSIDE (interface de saída do plano de dados) para o HOST-A.

- O TCP SYN/ACK atravessa uma das interfaces do painel traseiro do chassi (por exemplo, E1/9, E1/10, etc.) e sai de um dos membros de Po1.

- O TCP SYN/ACK chega ao Host-A.

Para obter mais detalhes sobre esse cenário, leia a seção relacionada nos Estudos de Caso de Estabelecimento de Conexão de Cluster.

Com base nessa troca de pacotes, todos os possíveis pontos de captura de cluster são:

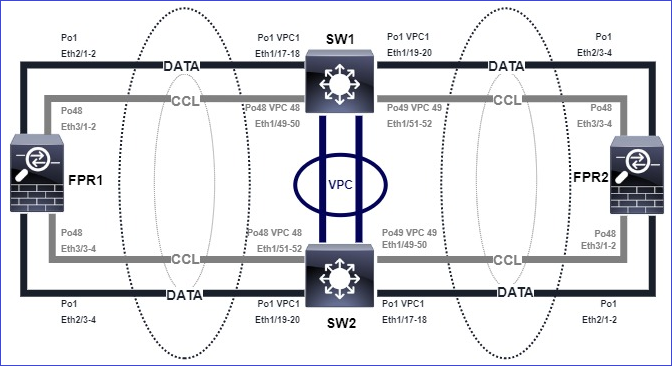

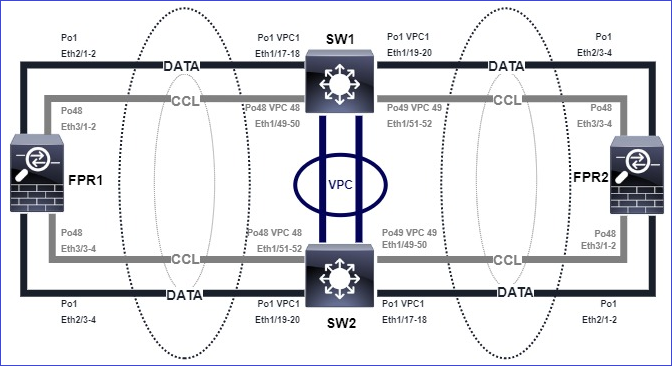

Para a captura de tráfego de encaminhamento (por exemplo, TCP SYN) em:

- A interface física do chassi (por exemplo, membros Po1). Essa captura é configurada na interface do usuário do Gerenciador de chassi (CM) ou na CLI do CM.

- Interface de ingresso do plano de dados (por exemplo, Po1.201 INSIDE).

- Interface de saída do plano de dados (por exemplo, Po1.202 OUTSIDE).

- Interfaces do chassi do backplane. No FP4100, há duas interfaces de backplane. No FP9300 há um total de 6 (2 por módulo). Como você não sabe em que interface o pacote chega, deve ativar a captura em todas as interfaces.

Para a captura de tráfego de retorno (por exemplo, TCP SYN/ACK) em:

- A interface física do chassi (por exemplo, membros Po1). Essa captura é configurada na interface do usuário do Gerenciador de chassi (CM) ou na CLI do CM.

- Interface de ingresso do plano de dados (por exemplo, Po1.202 OUTSIDE).

- Como o pacote é redirecionado, o próximo ponto de captura é o plano de dados CCL.

- Interfaces do chassi do backplane. Novamente, você deve habilitar a captura em ambas as interfaces.

- Interfaces de membro CCL de chassi de unidade 1-1.

- Interface CCL de plano de dados (nome do cluster).

- Interface de entrada (Po1.202 OUTSIDE). Este é o pacote injetado novamente da CCL para o plano de dados.

- Interface de saída do plano de dados (por exemplo, Po1.201 INSIDE).

- Interfaces do chassi do backplane.

Como ativar as capturas de cluster

Capturas FXOS

O processo é descrito no Guia de configuração de FXOS: Captura de pacotes

Observação: as capturas de FXOS só podem ser feitas na direção de entrada do ponto de vista do switch interno.

Capturas de plano de dados

A maneira recomendada de habilitar a captura em todos os membros do cluster é com o comando cluster exec.

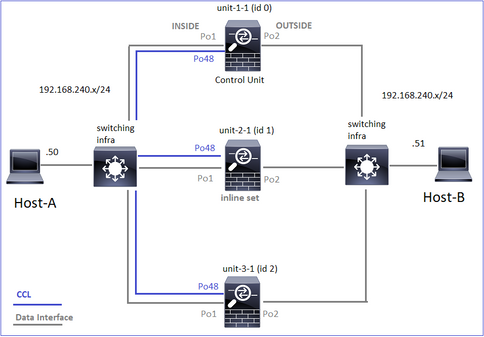

Considere um cluster de 3 unidades:

Para verificar se há capturas ativas em todas as unidades de cluster, use este comando:

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Para ativar uma captura de plano de dados em todas as unidades em Po1.201 (INTERIOR):

firepower# cluster exec capture CAPI interface INSIDE

É altamente recomendável especificar um filtro de captura e, caso você espere muito tráfego, aumentar o buffer de captura:

firepower# cluster exec capture CAPI buffer 33554432 interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Verificação

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 5140 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 260 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Para ver o conteúdo de todas as capturas (essa saída pode ser muito longa):

firepower# terminal pager 24

firepower# cluster exec show capture CAPI

unit-1-1(LOCAL):******************************************************

21 packets captured

1: 11:33:09.879226 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: S 2225395909:2225395909(0) win 29200 <mss 1460,sackOK,timestamp 1110209649 0,nop,wscale 7>

2: 11:33:09.880401 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45456: S 719653963:719653963(0) ack 2225395910 win 28960 <mss 1380,sackOK,timestamp 1120565119 1110209649,nop,wscale 7>

3: 11:33:09.880691 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: . ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

4: 11:33:09.880783 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: P 2225395910:2225396054(144) ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

unit-2-1:*************************************************************

0 packet captured

0 packet shown

unit-3-1:*************************************************************

0 packet captured

0 packet shown

Capturar Rastreamentos

Se quiser ver como os pacotes de entrada são tratados pelo plano de dados em cada unidade, use a palavra-chave trace. Isso rastreia os primeiros 50 pacotes de entrada. Você pode rastrear até 1000 pacotes de entrada.

Observação: caso você tenha várias capturas aplicadas em uma interface, poderá rastrear um único pacote apenas uma vez.

Para rastrear os primeiros 1000 pacotes de entrada na interface OUTSIDE em todas as unidades de cluster:

firepower# cluster exec cap CAPO int OUTSIDE buff 33554432 trace trace-count 1000 match tcp host 192.168.240.50 host 192.168.241.50 eq www

Depois de capturar o fluxo de interesse, é necessário garantir que você rastreie os pacotes de interesse em cada unidade. O importante a ser lembrado é que um pacote específico pode ser #1 na unidade 1-1, mas #2 em outra unidade e assim por diante.

Neste exemplo, você pode ver que SYN/ACK é o pacote #2 na unidade 2-1, mas o pacote #1 na unidade 3-1:

firepower# cluster exec show capture CAPO | include S.*ack

unit-1-1(LOCAL):******************************************************

1: 12:58:31.117700 802.1Q vlan#202 P0 192.168.240.50.45468 > 192.168.241.50.80: S 441626016:441626016(0) win 29200 <mss 1380,sackOK,timestamp 1115330849 0,nop,wscale 7>

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Para rastrear o #2 de pacotes (SYN/ACK) na unidade local:

firepower# cluster exec show cap CAPO packet-number 2 trace

unit-1-1(LOCAL):******************************************************

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Para rastrear o mesmo pacote (SYN/ACK) na unidade remota:

firepower# cluster exec unit unit-3-1 show cap CAPO packet-number 1 trace

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Captura CCL

Para ativar a captura no link CCL (em todas as unidades):

firepower# cluster exec capture CCL interface cluster

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Rejeitar Ocultar

Por padrão, uma captura habilitada em uma interface de dados de plano de dados mostra todos os pacotes:

- Aqueles que chegam da rede física

- Os que são reinjetados da CCL

Se você não quiser ver os pacotes injetados novamente, use a opção reinject-hide. Isso pode ser útil se você quiser verificar se um fluxo é assimétrico:

firepower# cluster exec capture CAPI_RH reinject-hide interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Essa captura mostra apenas o que a unidade local realmente recebe na interface específica diretamente da rede física, e não das outras unidades de cluster.

Quedas de ASP

Se quiser verificar se há descartes de software para um fluxo específico, você pode ativar a captura asp-drop. Se você não souber em qual motivo soltar focar, use a palavra-chave all. Além disso, se você não estiver interessado no payload do pacote, poderá especificar a palavra-chave headers-only. Isso permite capturar de 20 a 30 vezes mais pacotes:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Além disso, você pode especificar os IPs de interesse na captura ASP:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only match ip host 192.0.2.100 any

Limpar uma captura

Para limpar o buffer de qualquer captura executada em todas as unidades de cluster. Isso não interrompe as capturas, mas apenas limpa os buffers:

firepower# cluster exec clear capture /all

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Parar uma captura

Há duas maneiras de interromper uma captura ativa em todas as unidades de cluster. Mais tarde, você pode retomar.

Caminho 1

firepower# cluster exec cap CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Para retomar

firepower# cluster exec no capture CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Caminho 2

firepower# cluster exec no capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Para retomar

firepower# cluster exec capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Coletar uma Captura

Há várias maneiras de exportar uma captura.

Caminho 1 - Para um servidor remoto

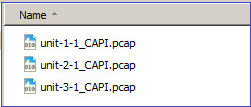

Isso permite que você carregue uma captura do plano de dados para um servidor remoto (por exemplo, TFTP). Os nomes de captura são alterados automaticamente para refletir a unidade de origem:

firepower# cluster exec copy /pcap capture:CAPI tftp://192.168.240.55/CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Address or name of remote host [192.168.240.55]?

Destination filename [CAPI.pcap]?

INFO: Destination filename is changed to unit-1-1_CAPI.pcap !!!!!!!

81 packets copied in 0.40 secs

unit-2-1:*************************************************************

INFO: Destination filename is changed to unit-2-1_CAPI.pcap !

unit-3-1:*************************************************************

INFO: Destination filename is changed to unit-3-1_CAPI.pcap !

Os arquivos pcap carregados:

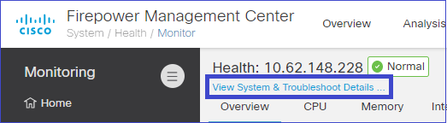

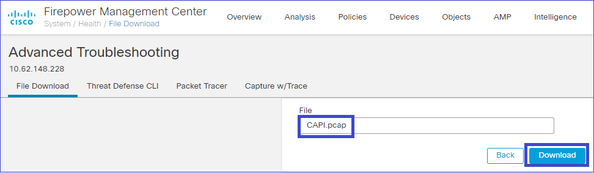

Caminho 2 - Buscar as capturas no FMC

Essa forma só é aplicável ao FTD. Primeiro, você copia a captura para o disco FTD:

firepower# cluster exec copy /pcap capture:CAPI disk0:CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Destination filename [CAPI.pcap]?

!!!!!

62 packets copied in 0.0 secs

No modo especialista, copie o arquivo do diretório /mnt/disk0/ para o diretório /ngfw/var/common/:

> expert

admin@firepower:~$ cd /mnt/disk0

admin@firepower:/mnt/disk0$ sudo cp CAPI.pcap /ngfw/var/common

Por fim, no FMC, navegue para a seção System > Health > Monitor. Escolha View System & Troubleshoot Details > Advanced Troubleshooting e busque o arquivo de captura:

Deletar uma Captura

Para remover uma captura de todas as unidades de cluster, use este comando:

firepower# cluster exec no capture CAPI

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Fluxo descarregado

Em FP41xx/FP9300, os fluxos podem ser descarregados no HW Accelerator estaticamente (por exemplo, regras Fastpath) ou dinamicamente. Para obter mais detalhes sobre o descarregamento de fluxo, consulte este documento:

Se um fluxo for descarregado, apenas alguns pacotes passarão pelo plano de dados do FTD. O restante é controlado pelo acelerador de hardware (Smart NIC).

Do ponto de vista da captura, isso significa que se você habilitar apenas as capturas de plano de dados FTD, não verá todos os pacotes que passam pelo dispositivo. Nesse caso, você também precisa ativar as capturas no nível do chassi FXOS.

Mensagens de Link de Controle de Cluster (CCL)

Se você fizer uma captura no CCL, perceberá que as unidades de cluster trocam diferentes tipos de mensagens. Os que interessam são:

| Protocolo |

Descrição |

| 49495 UDP |

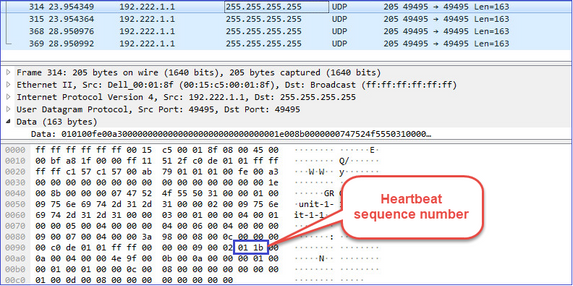

Pulsações de cluster (keepalives) · Difusão de L3 (255.255.255.255) · Esses pacotes são enviados por cada unidade de cluster a 1/3 do valor do tempo de espera da verificação de integridade. · Observe que nem todos os pacotes de 49495 UDP vistos na captura são pulsações · Os batimentos cardíacos contêm um número de sequência. |

| UDP 4193 |

Mensagens de Caminho de Dados do Protocolo de Controle de Cluster ·Unicast · Esses pacotes contêm informações (metadados) sobre o proprietário do fluxo, o diretor, o proprietário do backup, etc. Exemplos são: · Uma mensagem de ‘adição de cluster’ é enviada do proprietário para o direcionador quando um novo fluxo é criado · Uma mensagem de "exclusão de cluster" é enviada do proprietário para o direcionador quando um fluxo é encerrado |

| Pacotes de dados |

Pacotes de dados que pertencem aos vários fluxos de tráfego que atravessam o cluster |

Pulsação do Cluster

Mensagens do Ponto de Controle de Cluster (CCP)

Além das mensagens de pulsação, há várias mensagens de controle de cluster que são trocadas por meio do CCL em cenários específicos. Algumas delas são mensagens unicast, enquanto outras são broadcasts.

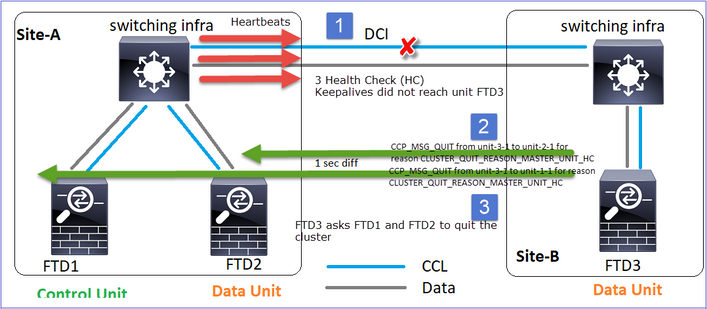

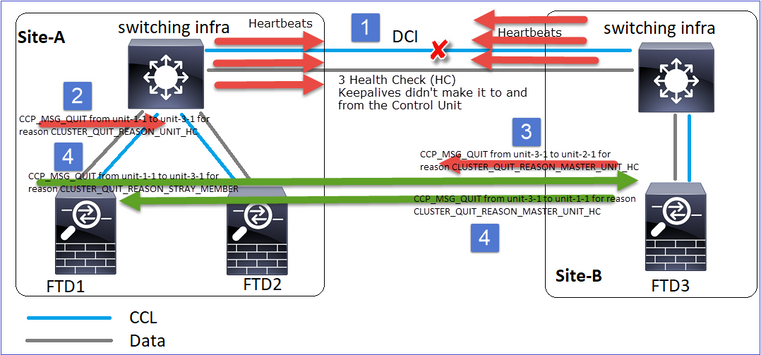

CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Sempre que uma unidade perde 3 mensagens de heartbeat consecutivas do nó de controle, ela gera uma mensagem CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC por meio do CCL. Esta mensagem:

- É um unicast.

- Ele é enviado para cada uma das unidades com um intervalo de 1 segundo.

- Quando uma unidade recebe esta mensagem, sai do cluster (DISABLED) e junta-se novamente.

P. Qual é a finalidade do CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC?

A. Do ponto de vista da unidade-3-1 (Site-B), ela perde a conexão com a unidade-1-1 e a unidade-2-1 do site A, portanto precisa removê-las de sua lista de membros o mais rápido possível; caso contrário, pode ter um pacote perdido se a unidade-2-1 ainda estiver em sua lista de membros e a unidade-2-1 for um direcionador de uma conexão, e a consulta de fluxo para a unidade-2-1 falhar.

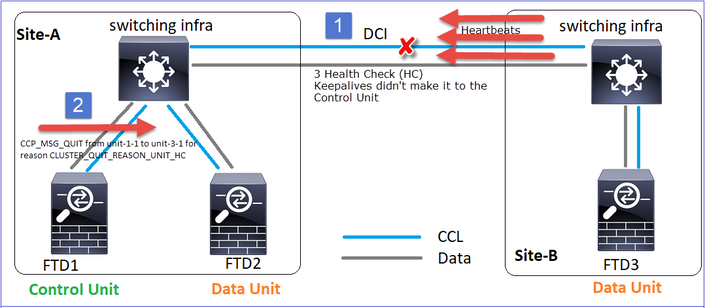

CLUSTER_QUIT_REASON_UNIT_HC

Sempre que o nó de controle perde 3 mensagens de pulsação consecutivas de um nó de dados, ele envia a mensagem CLUSTER_QUIT_REASON_UNIT_HC pelo CCL. Esta mensagem é unicast.

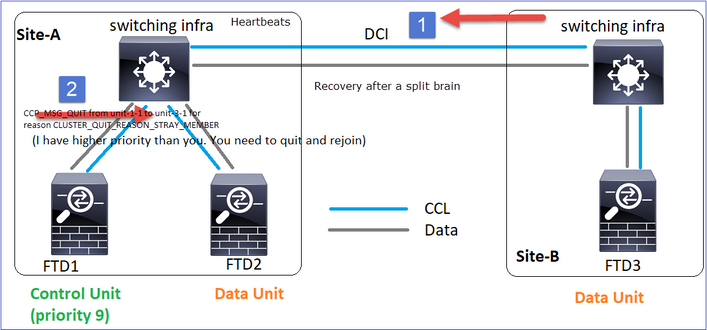

CLUSTER_QUIT_REASON_STRAY_MEMBER

Quando uma partição dividida se reconecta a uma partição de mesmo nível, o novo nó de dados é tratado como um membro perdido pela unidade de controle dominante e recebe uma mensagem de encerramento do CCP com a razão de CLUSTER_QUIT_REASON_STRAY_MEMBER.

CLUSTER_QUIT_MEMBER_DROPOUT

Uma mensagem de broadcast que é gerada por um nó de dados e é enviada como um broadcast. Quando uma unidade receber essa mensagem, passará para o status DISABLED. Além disso, a rejunção automática não inicia:

firepower# show cluster info trace | include DROPOUT

Nov 04 00:22:54.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:22:53.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

O histórico do cluster mostra:

PRIMARY DISABLED Received control message DISABLE (member dropout announcement)

Mecanismo de verificação de integridade (HC) do cluster

Pontos principais

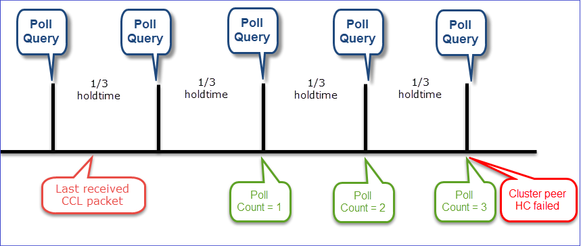

- Cada unidade de cluster envia um heartbeat a cada 1/3 do valor do tempo de espera de verificação de integridade para todas as outras unidades (broadcast 255.255.255.255) e usa o UDP port 49495 como transporte pelo CCL.

- Cada unidade de cluster rastreia de forma independente todas as outras unidades com um temporizador de Votação e um valor de Contagem de Votação.

- Se uma unidade de cluster não receber nenhum pacote (pulsação ou pacote de dados) de uma unidade de peer de cluster dentro de um intervalo de pulsação, ela aumentará o valor da Contagem de poll.

- Quando o valor da contagem de Poll para uma unidade de peer de cluster se torna 3, o peer é considerado inativo.

- Sempre que um heartbeat é recebido, seu número de sequência é verificado e, no caso de a diferença com o heartbeat recebido anteriormente ser diferente de 1, o contador de queda de heartbeat aumenta de acordo.

- Se o contador de Contagem de sondagem para um peer de cluster for diferente de 0 e um pacote for recebido pelo peer, o contador será redefinido para um valor 0.

Use este comando para verificar os contadores de integridade do cluster:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 650| 0| 4999| 1| 0|

| unit-3-1 ( 2)| 650| 0| 4999| 1| 0|

----------------------------------------------------------------------------------

Descrição das colunas principais

| Coluna |

Descrição |

| Unidade (ID) |

A ID do par de cluster remoto. |

| Contagem de pulsações |

O número de pulsações recebidas do par remoto por meio do CCL. |

| Quedas de pulsação |

O número de pulsações perdidas. Este contador é calculado com base no número de sequência de pulsação recebido. |

| Intervalo médio |

O intervalo de tempo médio das pulsações recebidas. |

| Contagem de sondagens |

Quando esse contador se torna 3, a unidade é removida do cluster. O intervalo de consulta de sondagem é o mesmo que o intervalo de pulsação, mas é executado independentemente. |

Para redefinir os contadores, use este comando:

firepower# clear cluster info health details

P. Como verificar a frequência dos batimentos cardíacos?

A. Verifique o valor médio do intervalo:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 3036| 0| 999| 1| 0|

----------------------------------------------------------------------------------

P. Como você pode alterar o tempo de espera do cluster no FTD?

A. Usar FlexConfig

P. Quem se torna o nó de controle após uma divisão cerebral?

A. A unidade com a prioridade mais alta (número mais baixo):

firepower# show run cluster | include priority

priority 9

Verifique o cenário de falha HC 1 para obter mais detalhes.

A visualização do mecanismo HC do cluster

Temporizadores indicativos: Os valores mínimo e máximo dependem da última chegada do pacote CCL recebido.

| Tempo de espera |

Verificação de consulta de sondagem (frequência) |

Tempo mínimo de detecção |

Tempo máximo de detecção |

| 3 seg (padrão) |

Aproximadamente 1 s |

~3,01 seg |

~3,99 seg |

| 4 s |

~1,33 seg |

~4,01 s |

~5,32 seg |

| 5 s |

~1,66 s |

~5,01 s |

~6,65 seg |

| 6 s |

Aprox. 2 s |

~6,01 seg |

~7,99 seg |

| 7 s |

~2,33 seg |

~7,01 seg |

~9,32 seg |

| 8 s |

~2,66 seg |

~8,01 seg |

~10,65 s |

Cenários de falha de HC de cluster

Os objetivos desta seção são demonstrar:

- Diferentes cenários de falha de HC de cluster.

- Como os diferentes logs e saídas de comando podem ser correlacionados.

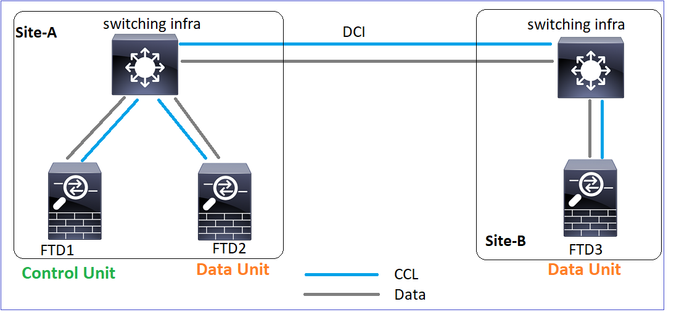

Topologia

Configuração de cluster

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

cluster group GROUP1 |

cluster group GROUP1 |

cluster group GROUP1 |

Status do cluster

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Cenário 1

Perda de comunicação CCL por aprox. 4+ seg em ambas as direções.

Antes da falha

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de controle |

Nó de dados |

Nó de dados |

Após a recuperação (sem alterações nas funções de unidade)

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de controle |

Nó de dados |

Nó de dados |

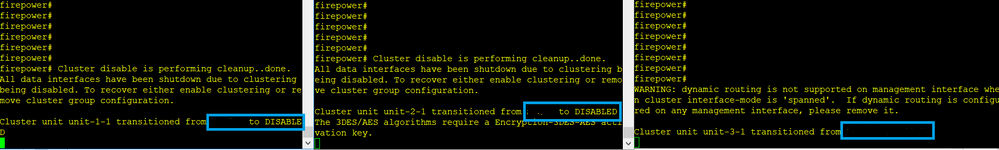

Análise

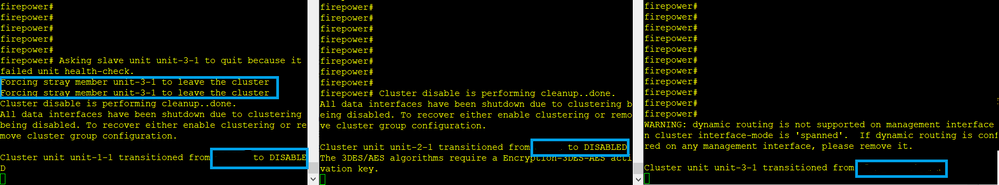

A falha (a comunicação da CCL foi perdida).

A mensagem do console do plano de dados na unidade 3-1:

firepower#

WARNING: dynamic routing is not supported on management interface when cluster interface-mode is 'spanned'.

If dynamic routing is configured on any management interface, please remove it.

Cluster unit unit-3-1 transitioned from SECONDARY to PRIMARY

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled.

To recover either enable clustering or remove cluster group configuration.

Logs de rastreamento de cluster de Unidade 1-1:

firepower# show cluster info trace | include unit-3-1

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8918307fb 0x000055a8917fc6e8 0x000055a8917f79b5

Nov 02 09:38:14.239 [INFO]FTD - CD proxy received state notification (DISABLED) from unit unit-3-1

Nov 02 09:38:14.239 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8917eb596 0x000055a8917f4838 0x000055a891abef9d

Nov 02 09:38:14.239 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Nov 02 09:38:14.239 [CRIT]Received heartbeat event 'SECONDARY heartbeat failure' for member unit-3-1 (ID: 1).

Split-brain

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Histórico do cluster

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

| Nenhum evento |

Nenhum evento |

09:38:16 UTC Nov 2 2020 |

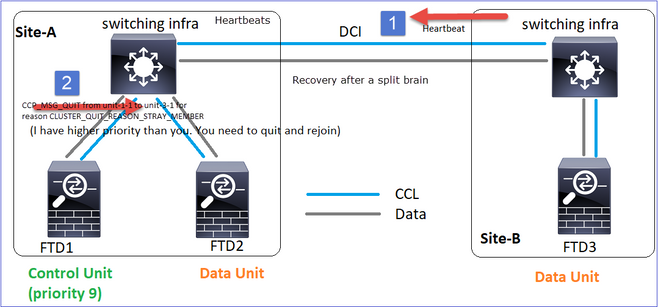

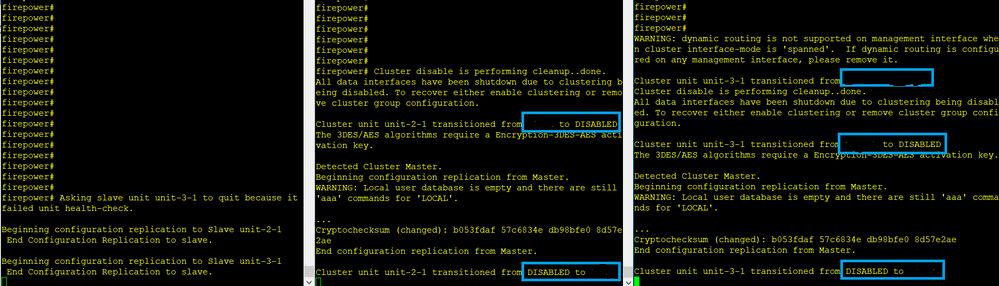

restauração de comunicação CCL

A Unidade-1-1 detecta o nó de controle atual e, como a unidade-1-1 tem prioridade mais alta, envia à unidade-3-1 uma mensagem CLUSTER_QUIT_REASON_STRAY_MEMBER para disparar um novo processo de eleição. No final, a unidade 3-1 se une novamente como um nó de dados.

Quando uma partição dividida se reconecta a uma partição de mesmo nível, o nó de dados é tratado como um membro perdido pelo nó de controle dominante e recebe uma mensagem de saída CCP com um motivo de CLUSTER_QUIT_REASON_STRAY_MEMBER.

Unit-3-1 console logs show:

Cluster unit unit-3-1 transitioned from PRIMARY to DISABLED

The 3DES/AES algorithms require a Encryption-3DES-AES activation key.

Detected Cluster Primart.

Beginning configuration replication from Primary.

WARNING: Local user database is empty and there are still 'aaa' commands for 'LOCAL'.

..

Cryptochecksum (changed): a9ed686f 8e2e689c 2553a104 7a2bd33a

End configuration replication from Primary.

Cluster unit unit-3-1 transitioned from DISABLED to SECONDARY

As duas unidades (unidade 1-1 e unidade 3-1) são mostradas em seus logs de cluster:

firepower# show cluster info trace | include retain

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Há também mensagens de syslog geradas para o split-brain:

firepower# show log | include 747016

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Histórico do cluster

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

| Nenhum evento |

Nenhum evento |

09:47:33 UTC Nov 2 2020 |

Cenário 2

Perda de comunicação CCL por aproximadamente 3 a 4 segundos em ambas as direções.

Antes da falha

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de controle |

Nó de dados |

Nó de dados |

Após a recuperação (sem alterações nas funções de unidade)

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de controle |

Nó de dados |

Nó de dados |

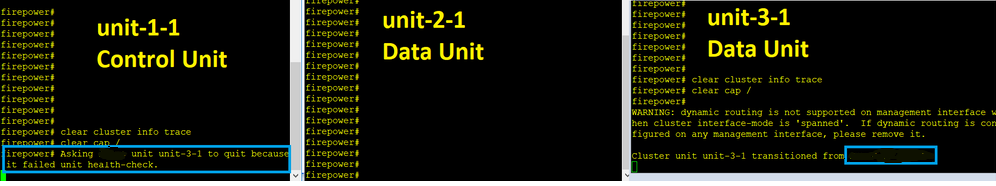

Análise

Evento 1: o nó de controle perde 3 CHs da unidade 3-1 e envia uma mensagem para a unidade 3-1 para sair do cluster.

Evento 2: a CCL se recuperou muito rapidamente e a mensagem CLUSTER_QUIT_REASON_STRAY_MEMBER do nó de controle chegou ao lado remoto. A unidade 3-1 vai diretamente para o modo DISABLED e não há split brain

Na unidade 1-1 (controle) você vê:

firepower#

Asking SECONDARY unit unit-3-1 to quit because it failed unit health-check.

Forcing stray member unit-3-1 to leave the cluster

Na unidade 3-1 (nó de dados) você vê:

firepower#

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled. To recover either enable clustering or remove cluster group configuration.

Cluster unit unit-3-1 transitioned from SECONDARY to DISABLED

A unidade de cluster 3-1 fez a transição para um estado DISABLED e, uma vez restaurada a comunicação CCL, ela ingressa novamente como um nó de dados:

firepower# show cluster history

20:58:40 UTC Nov 1 2020

SECONDARY DISABLED Received control message DISABLE (stray member)

20:58:45 UTC Nov 1 2020

DISABLED ELECTION Enabled from CLI

20:58:45 UTC Nov 1 2020

ELECTION SECONDARY_COLD Received cluster control message

20:58:45 UTC Nov 1 2020

SECONDARY_COLD SECONDARY_APP_SYNC Client progression done

20:59:33 UTC Nov 1 2020

SECONDARY_APP_SYNC SECONDARY_CONFIG SECONDARY application configuration sync done

20:59:44 UTC Nov 1 2020

SECONDARY_CONFIG SECONDARY_FILESYS Configuration replication finished

20:59:45 UTC Nov 1 2020

SECONDARY_FILESYS SECONDARY_BULK_SYNC Client progression done

21:00:09 UTC Nov 1 2020

SECONDARY_BULK_SYNC SECONDARY Client progression done

Cenário 3

Perda de comunicação CCL por aproximadamente 3 a 4 segundos em ambas as direções.

Antes da falha.

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de controle |

Nó de dados |

Nó de dados |

Após a recuperação (o nó de controle foi alterado).

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de dados |

Nó de controle |

Nó de dados |

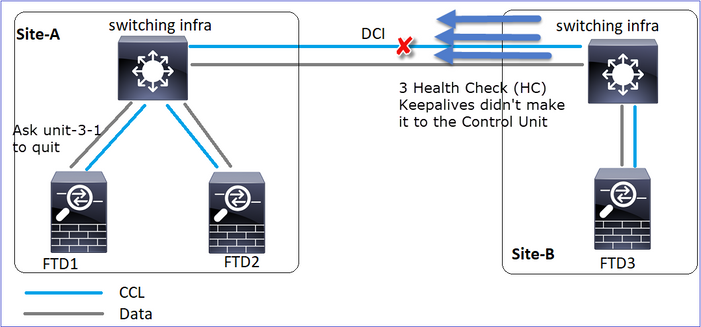

Análise

- A ACL fica inativa.

- A unidade 1-1 não recebe 3 mensagens HC da unidade 3-1 e envia uma mensagem QUIT para a unidade 3-1. Essa mensagem nunca chega à unidade 3-1.

- A Unidade 3-1 envia uma mensagem QUIT para a Unidade 2-1. Essa mensagem nunca alcança a unidade 2-1.

A CCL se recupera.

- A Unidade-1-1 vê que a unidade-3-1 se anunciou como um nó de controle e envia a mensagem QUIT_REASON_STRAY_MEMBER para a unidade-3-1. Uma vez que a unidade 3-1 recebe esta mensagem vai para um estado DISABLED. Ao mesmo tempo, a unidade 3-1 envia uma mensagem QUIT_REASON_PRIMARY_UNIT_HC à unidade 1-1 e solicita que ela seja encerrada. Quando a unidade 1-1 recebe essa mensagem, ela entra em um estado DISABLED.

Histórico do cluster

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

19:53:09 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

Cenário 4

Perda de comunicação CCL por aprox. 3-4 s

Antes da falha

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de controle |

Nó de dados |

Nó de dados |

Após a recuperação (o nó de controle alterou os sites)

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de dados |

Nó de dados |

Nó de controle |

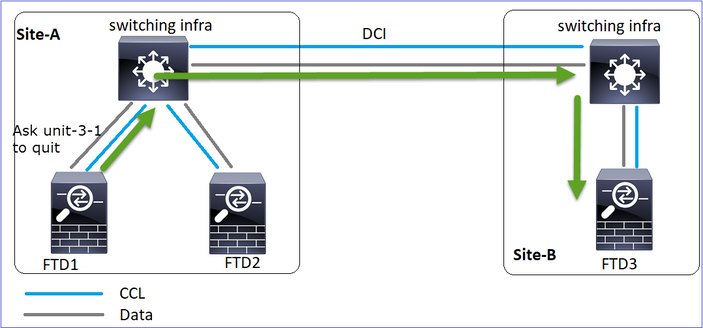

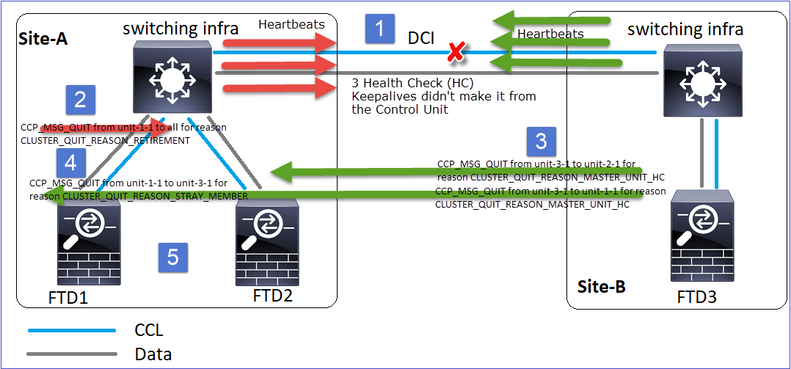

Análise

A falha

Um sabor diferente da mesma falha. Neste caso, a unidade-1-1 também não recebeu 3 mensagens HC da unidade-3-1, e uma vez que obteve um novo keepalive, tentou expulsar a unidade-3-1 com o uso de uma mensagem STRAY, mas a mensagem nunca chegou à unidade-3-1:

- A CCL se torna unidirecional por alguns segundos. A unidade 3-1 não recebe 3 mensagens HC da unidade 1-1 e torna-se um nó de controle.

- A Unidade 2-1 envia uma mensagem CLUSTER_QUIT_REASON_RETIREMENT (broadcast).

- Unit-3-1 envia uma mensagem QUIT_REASON_PRIMARY_UNIT_HC para unit-2-1. A Unidade 2-1 a recebe e sai do cluster.

- Unit-3-1 envia uma mensagem QUIT_REASON_PRIMARY_UNIT_HC para unit-1-1. A Unidade 1-1 a recebe e sai do cluster. A CCL se recupera.

- As Unidades 1-1 e 2-1 reingressam no cluster como nós de dados.

Observação: se na etapa 5 o CCL não se recuperar, no site-A o FTD1 se tornará o novo nó de controle e, após a recuperação do CCL, ele ganhará a nova eleição.

Mensagens de syslog na unidade 1-1:

firepower# show log | include 747

Nov 03 2020 23:13:08: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-3-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:09: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY to DISABLED

Nov 03 2020 23:13:12: %FTD-7-747006: Clustering: State machine is at state DISABLED

Nov 03 2020 23:13:12: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MY_STATE (state DISABLED,0x0000000000000000,0x0000000000000000)

Nov 03 2020 23:13:18: %FTD-6-747004: Clustering: State machine changed from state ELECTION to ONCALL

Logs de rastreamento de cluster na unidade 1-1:

firepower# show cluster info trace | include QUIT

Nov 03 23:13:10.789 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:10.769 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 03 23:13:10.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:09.789 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:09.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:08.559 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 03 23:13:08.559 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Mensagens de syslog na unidade 3-1:

firepower# show log | include 747

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-1-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state SECONDARY to PRIMARY

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_FAST to PRIMARY_DRAIN

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_DRAIN to PRIMARY_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_CONFIG to PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_POST_CONFIG to PRIMARY

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY

Histórico do cluster

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

23:13:13 UTC Nov 3 2020 |

23:13:12 UTC Nov 3 2020 |

23:13:10 UTC Nov 3 2020 |

Cenário 5

Antes da falha

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de controle |

Nó de dados |

Nó de dados |

Após a recuperação (sem alterações)

| FTD1 |

FTD2 |

FTD3 |

| Local-A |

Local-A |

Local-B |

| Nó de controle |

Nó de dados |

Nó de dados |

A falha

A Unidade 3-1 enviou mensagens QUIT para a unidade 1-1 e para a unidade 2-1, mas devido a problemas de conectividade, somente a unidade 2-1 recebeu a mensagem QUIT.

Logs de rastreamento de cluster de Unidade 1-1:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.429 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.059 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:45.429 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:51:45.429 [DBUG]Send CCP message to unit-3-1(1): CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Logs de rastreamento do cluster da Unidade 2-1:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.019 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:46.999 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 04 00:51:45.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Histórico do cluster

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

| Nenhum evento |

00:51:50 UTC Nov 4 2020 |

00:51:47 UTC Nov 4 2020 |

Estabelecimento de Conexão de Plano de Dados de Cluster

Pontos de captura do NGFW

O NGFW oferece recursos de captura nestes pontos:

- Switch interno do chassi (FXOS)

- Mecanismo de plano de dados FTD

- Mecanismo Snort de FTD

Quando você soluciona problemas de caminho de dados em um cluster, os pontos de captura usados na maioria dos casos são as capturas de mecanismo de plano de dados FXOS e FTD.

- Captura de ingresso FXOS na interface física

- Captura de ingresso de FTD em mecanismo de plano de dados

- Captura de saída FTD no mecanismo de plano de dados

- Captura de entrada FXOS na interface do painel traseiro

Para obter mais detalhes sobre as capturas de NGFW, consulte este documento:

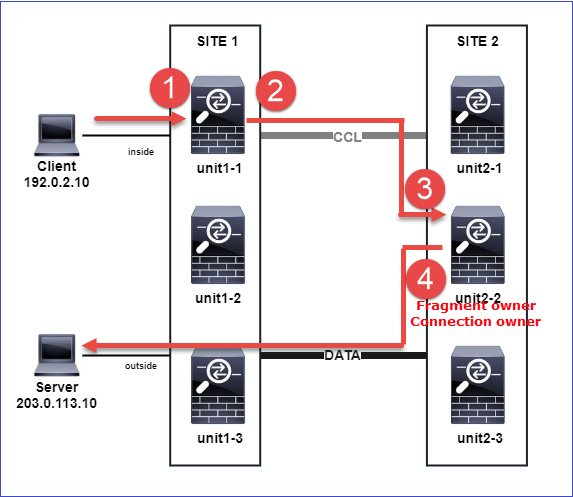

Conceitos Básicos das Funções de Fluxo de Unidade de Cluster

As conexões podem ser estabelecidas por meio de um cluster de várias maneiras, dependendo de fatores como:

- Tipo de tráfego (TCP, UDP, etc.)

- Algoritmo de balanceamento de carga configurado no switch adjacente

- Recursos configurados no firewall

- Condições de rede (por exemplo, fragmentação de IP, atrasos de rede e assim por diante)

| Função de fluxo |

Descrição |

Pavilhão(ões) |

| PROPRIETÁRIO |

Geralmente, a unidade que recebe inicialmente a conexão |

UIO |

| Director |

A unidade que trata solicitações de pesquisa de proprietário de encaminhadores. |

Y |

| Proprietário do backup |

Desde que o direcionador não seja a mesma unidade que o proprietário, o direcionador também será o proprietário do backup. Se o proprietário escolher a si mesmo como o direcionador, então um proprietário de backup separado será escolhido. |

S (se o direcionador também for o proprietário do backup) y (se o direcionador não for o proprietário do backup) |

| Encaminhador |

Uma unidade que encaminha pacotes ao proprietário |

z |

| Proprietário do fragmento |

A unidade que lida com o tráfego fragmentado |

- |

| Backup do chassi |

Em um cluster entre chassis, quando os fluxos de diretor/backup e proprietário são de propriedade das unidades do mesmo chassi, uma unidade em um dos outros chassis torna-se um backup/diretor secundário. Essa função é específica para clusters entre chassis do Firepower 9300 Series com mais de um blade. |

w |

- Para obter mais detalhes, verifique a seção relacionada no Guia de configuração (consulte os links em Informações relacionadas)

- Em cenários específicos (consulte a seção estudos de caso) algumas sinalizações nem sempre são mostradas.

Estudos de Caso de Estabelecimento de Conexão de Cluster

A próxima seção aborda vários estudos de caso que demonstram algumas das maneiras pelas quais uma conexão pode ser estabelecida através de um cluster. Os objetivos são:

- Familiarize-se com as diferentes funções de unidade.

- Demonstre como as várias saídas de comando podem ser correlacionadas.

Topologia

Unidades e IDs de cluster:

| Unit-1-1 |

Unit-2-1 |

Unit-3-1 |

Cluster GROUP1: On |

Unit "unit-2-1" in state SECONDARY |

Unit "unit-3-1" in state SECONDARY |

Capturas de cluster habilitadas:

cluster exec cap CAPI int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPI_RH reinject-hide int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO_RH reinject-hide int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CCL int cluster buffer 33554432

Observação: esses testes foram executados em um ambiente de laboratório com tráfego mínimo através do cluster. Na produção, tente usar os filtros de captura mais específicos possível (por exemplo, a porta de destino e, sempre que possível, a porta de origem) para minimizar o ‘ruído’ nas capturas.

Casos Práticos 1. Tráfego simétrico (o proprietário também é o diretor)

Observação 1. As capturas reject-hide mostram pacotes somente na unidade 1-1. Isso significa que o fluxo em ambas as direções passou pela unidade 1-1 (tráfego simétrico):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data interface cluster [Capturing - 33513 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-2-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 23245 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-3-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 24815 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Observação 2. Análise de sinalizador de conexão para fluxo com 45954 de porta de origem

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

22 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 2 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:00, bytes 487413076, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:443 NP Identity Ifc 192.168.240.50:39698, idle 0:00:23, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:06, bytes 0, flags y

| Unidade |

Sinalizador |

Nota |

| Unit-1-1 |

UIO |

· Proprietário do fluxo - A unidade controla o fluxo · Diretor - Como a unidade 3-1 tem "y" e não "Y", isso implica que a unidade 1-1 foi escolhida como o diretor para esse fluxo. Assim, como também é o proprietário, outra unidade (unidade 3-1 neste caso) foi eleita como o proprietário de backup |

| Unit-2-1 |

- |

- |

| Unit-3-1 |

y |

A unidade é um proprietário de Backup |

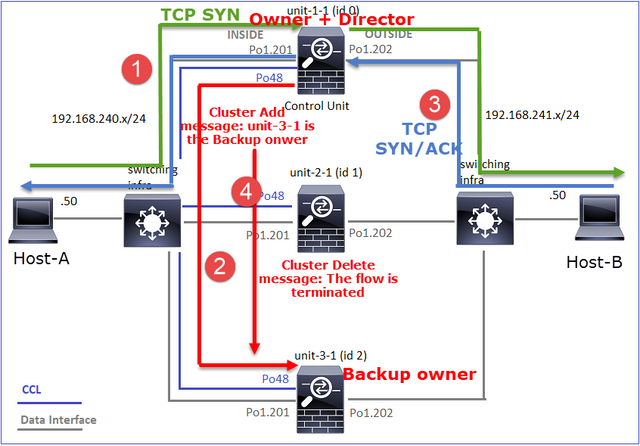

Isso pode ser visualizado da seguinte maneira:

- O pacote TCP SYN chega do Host-A para a unidade 1-1. A Unidade 1-1 torna-se o proprietário do fluxo.

- A Unidade-1-1 também é eleita diretora de fluxo. Assim, ele também escolhe a unidade 3-1 como o proprietário do backup (mensagem de adição de cluster).

- O pacote TCP SYN/ACK chega do Host-B para a unidade 3-1. O fluxo é simétrico.

- Quando a conexão é encerrada, o proprietário envia uma mensagem de exclusão de cluster para remover as informações de fluxo do proprietário do backup.

Observação 3. A captura com rastreamento mostra que ambas as direções vão apenas pela unidade 1-1.

Etapa 1. Identifique o fluxo e os pacotes de interesse em todas as unidades de cluster com base na porta de origem:

firepower# cluster exec show capture CAPI | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363521 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45954: S 4042762409:4042762409(0) ack 992089270 win 28960 <mss 1380,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363827 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 4042762410 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower# cluster exec show capture CAPO | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362987 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: S 2732339016:2732339016(0) win 29200 <mss 1380,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363903 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 3603655983 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Etapa 2. Como este é um rastreamento de fluxo TCP, os pacotes de handshake triplo. Como pode ser visto nesta saída, a unidade 1-1 é o proprietário. Por razões de simplicidade, são omitidas as fases de rastreio não relevantes:

firepower# show cap CAPI packet-number 1 trace

25985 packets captured

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

...

O tráfego de retorno (TCP SYN/ACK):

firepower# show capture CAPO packet-number 2 trace

25985 packets captured

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

...

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9364, using existing flow

Observação 4. Os syslogs de plano de dados FTD mostram a criação e o término da conexão em todas as unidades:

firepower# cluster exec show log | include 45954

unit-1-1(LOCAL):******************************************************

Dec 01 2020 08:42:09: %FTD-6-302013: Built inbound TCP connection 9364 for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302014: Teardown TCP connection 9364 for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 08:42:09: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

Casos Práticos 2. Tráfego simétrico (proprietário diferente do diretor)

- O mesmo que o estudo de caso #1, mas neste estudo de caso, um proprietário de fluxo é uma unidade diferente do diretor.

- Todos os resultados são semelhantes aos #1 do estudo de caso. A principal diferença em relação ao estudo de caso #1 é o indicador "Y", que substitui o indicador "y" do cenário 1.

Observação 1. O proprietário é diferente do diretor.

Análise de sinalizador de conexão para fluxo com 46278 de porta de origem.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:00, bytes 508848268, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46276, idle 0:00:03, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46276, idle 0:00:02, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:06, bytes 0, flags Y

| Unidade |

Sinalizador |

Nota |

| Unit-1-1 |

UIO |

· Proprietário do fluxo - A unidade controla o fluxo |

| Unit-2-1 |

- |

- |

| Unit-3-1 |

Y |

· Diretor e proprietário do backup - A unidade 3-1 tem a bandeira Y (Diretor). |

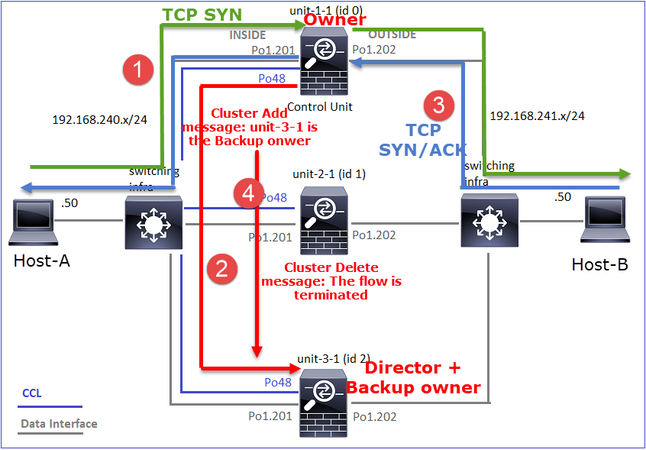

Isso pode ser visualizado da seguinte maneira:

- O pacote TCP SYN chega do Host-A para a unidade 1-1. A Unidade 1-1 torna-se o proprietário do fluxo.

- A Unidade 3-1 é eleita o diretor de fluxo. A Unidade-3-1 também é a proprietária do backup (mensagem "cluster add" no UDP 4193 sobre o CCL).

- O pacote TCP SYN/ACK chega do Host-B para a unidade 3-1. O fluxo é simétrico.

- Quando a conexão é encerrada, o proprietário envia pela CCL uma mensagem de 'exclusão de cluster' no UDP 4193 para remover as informações de fluxo do proprietário do backup.

Observação 2. A captura com rastreamento mostra que ambas as direções passam apenas pela unidade 1-1

Etapa 1. Use a mesma abordagem do estudo de caso 1 para identificar o fluxo e os pacotes de interesse em todas as unidades de cluster com base na porta de origem:

firepower# cluster exec show cap CAPI | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842317 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3524167695:3524167695(0) ack 1972783999 win 28960 <mss 1380,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842592 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3524167696 win 229 <nop,nop,timestamp 503529073 513884542>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Capturar na interface EXTERNA:

firepower# cluster exec show cap CAPO | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841921 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: S 2153055699:2153055699(0) win 29200 <mss 1380,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842638 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3382481338 win 229 <nop,nop,timestamp 503529073 513884542>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Etapa 2. Concentre-se nos pacotes de entrada (TCP SYN e TCP SYN/ACK):

firepower# cluster exec show cap CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

824 packets captured

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Rastreie o SYN/ACK na unidade 1-1:

firepower# cluster exec show cap CAPO packet-number 4 trace

unit-1-1(LOCAL):******************************************************

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9583, using existing flow

Observação 3. Os syslogs de plano de dados FTD mostram a criação e o término da conexão no proprietário e no proprietário do backup:

firepower# cluster exec show log | include 46278

unit-1-1(LOCAL):******************************************************

Dec 01 2020 11:01:44: %FTD-6-302013: Built inbound TCP connection 9583 for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302014: Teardown TCP connection 9583 for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024001808 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 11:01:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

Casos Práticos 3. Tráfego assimétrico (o diretor encaminha o tráfego).

Observação 1. As capturas de reinserção/ocultação mostram pacotes nas unidades 1-1 e 2-1 (fluxo assimétrico):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554320 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99932 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553268 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 53815 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Observação 2. Análise de sinalizador de conexão para fluxo com 46502 de porta de origem.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 448760236, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46500, idle 0:00:06, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 1 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 0, flags Y

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 0 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

| Unidade |

Sinalizador |

Nota |

| Unit-1-1 |

UIO |

· Proprietário do fluxo - A unidade controla o fluxo. |

| Unit-2-1 |

Y |

· Diretor - Como a unidade 2-1 tem a flag ‘Y’, isso implica que a unidade 2-1 foi escolhida como o diretor para esse fluxo. · Proprietário do backup · Finalmente, embora não seja óbvio a partir dessa saída, a partir das saídas show capture e show log é evidente que a unidade 2-1 encaminha esse fluxo para o proprietário (embora tecnicamente não seja considerado um encaminhador nesse cenário). Observação: uma unidade não pode ser diretor (fluxo Y) e encaminhador (fluxo z), essas duas funções são mutuamente exclusivas. Os diretors (fluxo Y) ainda podem encaminhar o tráfego. Consulte a saída do comando show log posteriormente neste estudo de caso. |

| Unit-3-1 |

- |

- |

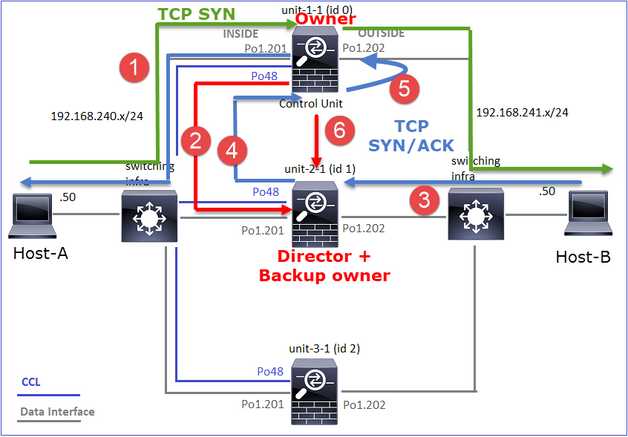

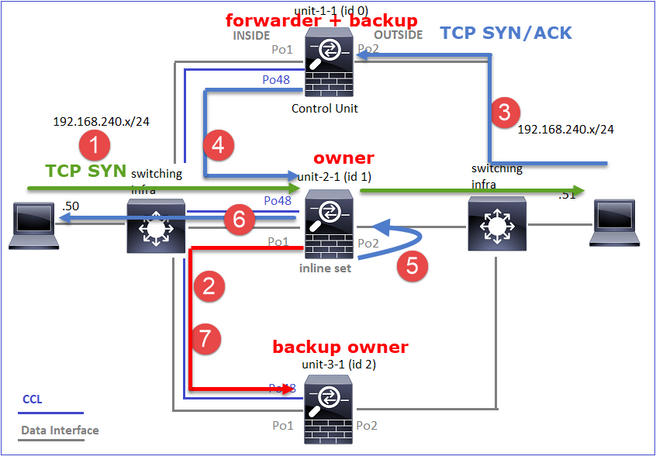

Isso pode ser visualizado da seguinte maneira:

- O pacote TCP SYN chega do Host-A para a unidade 1-1. A Unidade 1-1 torna-se o proprietário do fluxo.

- A unidade 2-1 é eleita o diretor de fluxo e o proprietário do backup. O proprietário do fluxo envia uma mensagem unicast 'cluster add' no UDP 4193 para informar o proprietário do backup sobre o fluxo.

- O pacote TCP SYN/ACK chega do Host-B para a unidade 2-1. O fluxo é assimétrico.

- A Unidade 2-1 encaminha o pacote por meio do CCL para o proprietário (devido ao Cookie TCP SYN).

- O proprietário injeta novamente o pacote na interface OUTSIDE e depois encaminha o pacote para o Host-A.

- Quando a conexão é encerrada, o proprietário envia uma mensagem de exclusão de cluster para remover as informações de fluxo do proprietário do backup.

Observação 3. Capture with trace mostra o tráfego assimétrico e o redirecionamento da unidade 2-1 para a unidade 1-1.

Etapa 1. Identifique os pacotes que pertencem ao fluxo de interesse (porta 46502):

firepower# cluster exec show capture CAPI | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.357037 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46502: S 883000451:883000451(0) ack 4124514681 win 28960 <mss 1380,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357357 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 883000452 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

A direção de retorno:

firepower# cluster exec show capture CAPO | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356426 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: S 1434968587:1434968587(0) win 29200 <mss 1380,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.356915 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357403 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 4257314723 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

2: 12:58:33.360302 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . ack 1434968736 win 235 <nop,nop,timestamp 520893005 510537536>

3: 12:58:33.361004 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . 4257314723:4257316091(1368) ack 1434968736 win 235 <nop,nop,timestamp 520893006 510537536>

…

unit-3-1:*************************************************************

Etapa 2. Rastreie os pacotes. Por padrão, somente os primeiros 50 pacotes de entrada são rastreados. Para simplificar, as fases de rastreamento não relevantes são omitidas.

Unidade-1-1 (proprietário):

firepower# cluster exec show capture CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Unidade 2-1 (encaminhador)

O tráfego de retorno (TCP SYN/ACK). A unidade de interesse é a unidade 2-1, que é o proprietário do direcionador/backup e encaminha o tráfego para o proprietário:

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

Observação 4. Os syslogs de plano de dados FTD mostram a criação e o término da conexão em todas as unidades:

firepower# cluster exec show log | i 46502

unit-1-1(LOCAL):******************************************************

Dec 01 2020 12:58:33: %FTD-6-302013: Built inbound TCP connection 9742 for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302014: Teardown TCP connection 9742 for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 bytes 2048000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 12:58:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46502 (192.168.240.50/46502)

Dec 01 2020 12:58:33: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46502 duration 0:00:00 forwarded bytes 0 Forwarding or redirect flow removed to create director or backup flow

Dec 01 2020 12:58:33: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 forwarded bytes 2048316300 Cluster flow with CLU closed on owner

unit-3-1:*************************************************************

firepower#

Casos Práticos 4. Tráfego assimétrico (o proprietário é o diretor)

Observação 1. As capturas de reinserção/ocultação mostram pacotes nas unidades 1-1 e 2-1 (fluxo assimétrico):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554229 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98974 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99924 bytes]