Inleiding

In dit document worden de stappen beschreven die u kunt gebruiken om problemen met Hyperflex Datastore-montage op te lossen.

Voorwaarden

Vereisten

Er zijn geen specifieke vereisten van toepassing op dit document.

Gebruikte componenten

Dit document is niet beperkt tot specifieke software- en hardware-versies.

De informatie in dit document is gebaseerd op de apparaten in een specifieke laboratoriumomgeving. Alle apparaten die in dit document worden beschreven, hadden een opgeschoonde (standaard)configuratie. Als uw netwerk levend is, zorg er dan voor dat u de mogelijke impact van om het even welke opdracht begrijpt.

Achtergrondinformatie:

Hyperflex datastores worden standaard gemonteerd in NFS v3.

NFS (Network File System) is een protocol voor het delen van bestanden dat door de hypersupervisor wordt gebruikt om te communiceren met een NAS-server (Network Attached Storage) via een standaard TCP/IP-netwerk.

Hier volgt een beschrijving van NFS-onderdelen die in een vSphere-omgeving worden gebruikt:

- NFS-server - een opslagapparaat of een server die het NFS-protocol gebruikt om bestanden beschikbaar te maken via het netwerk. In de Hyperflex-wereld runt elke controller VM een NFS-serverinstantie. De NFS server IP voor de datastores is de eth1:0 interface-IP.

- NFS-datastore - een gedeelde scheiding op de NFS-server die kan worden gebruikt om virtuele machine-bestanden vast te houden.

- NFS-client - ESXi omvat een ingebouwde NFS-client die wordt gebruikt voor toegang tot NFS-apparaten.

Naast de reguliere NFS-onderdelen is er een VIB geïnstalleerd op de ESXi, de IOVisor genaamd. Deze VIB biedt een NFS-montagepunt (Network File System), zodat de ESXi-hypersupervisor toegang heeft tot de virtuele diskregaten die aan afzonderlijke virtuele machines zijn gekoppeld. Vanuit het perspectief van de hypersupervisor wordt hij simpelweg aan een netwerkbestandssysteem gekoppeld.

Probleem

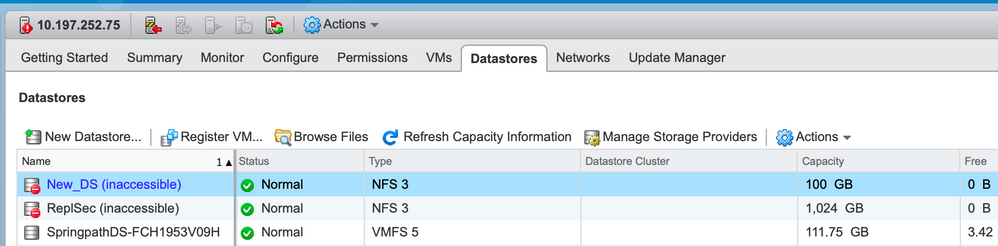

De symptomen van mount issues kunnen in de ESXi host verschijnen als datastore ontoegankelijk.

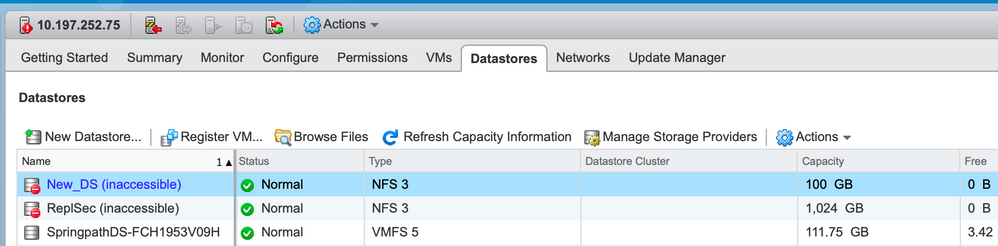

Datastores ontoegankelijk in vCenter

Opmerking: Wanneer uw Datastores in vCenter ontoegankelijk worden getoond, worden ze geacht niet beschikbaar te zijn in de ESX CLI. Dit betekent dat de datastores eerder op de host waren gemonteerd.

Controleer de Datastores via CLI:

- SSH naar de ESXi-host en voert de opdracht in:

[root@node1:~] esxcfg-nas -l

test1 is 10.197.252.106:test1 from 3203172317343203629-5043383143428344954 mounted unavailable

test2 is 10.197.252.106:test2 from 3203172317343203629-5043383143428344954 mounted unavailable

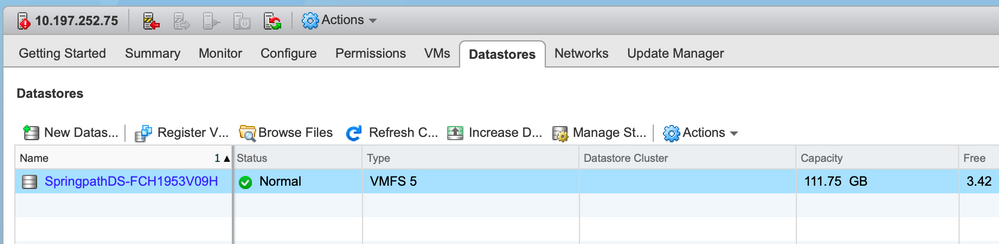

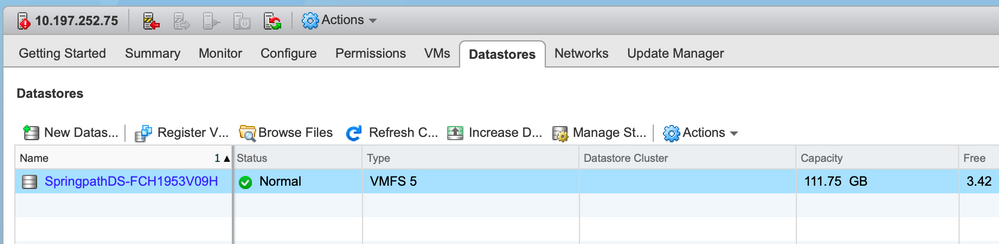

Datastores helemaal niet beschikbaar in vCenter/CLI

Opmerking: Wanneer uw Datastores niet aanwezig zijn in vCenter of CLI. Dit geeft aan dat de Datastore nooit eerder op de host is gemonteerd.

- Controleer de Datastores via CLI

SSH naar de ESXi-host en voert de opdracht in:

[root@node1:~] esxcfg-nas -l

[root@node1:~]

Oplossing

De redenen voor de afgifte van de bedragen kunnen verschillen, controleer de lijst met controles om deze te valideren en corrigeren als er een is.

Controleer netwerkbereikbaarheid

Het eerste wat te controleren in het geval van datastore-problemen is of de host in staat is de NFS server IP te bereiken.

De NFS server IP in het geval van Hyperflex is de IP die is toegewezen aan de virtuele interface eth1:0, die op een van de SCVM's aanwezig is.

Als de ESXi-hosts niet in staat zijn de NFS server IP te ping te brengen, veroorzaakt dit dat de datastores ontoegankelijk worden.

Vind de eth1:0 IP met de opdracht iffig op alle SCVM’s.

Opmerking: De Eth1:0 is een virtuele interface en is slechts op één van de SCVM's aanwezig.

root@SpringpathControllerGDAKPUCJLE:~# ifconfig eth1:0

eth1:0 Link encap:Ethernet HWaddr 00:50:56:8b:62:d5

inet addr:10.197.252.106 Bcast:10.197.252.127 Mask:255.255.255.224

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

Om de ESXi host te ontvangen met datastore montageemissies en te controleren of deze de NFS server IP kan bereiken.

[root@node1:~] ping 10.197.252.106

PING 10.197.252.106 (10.197.252.106): 56 data bytes

64 bytes from 10.197.252.106: icmp_seq=0 ttl=64 time=0.312 ms

64 bytes from 10.197.252.106: icmp_seq=1 ttl=64 time=0.166 m

Als u kunt pingelen, gaat u in de volgende sectie met de stappen naar probleemoplossing te werk.

Als u niet kunt pingelen, moet u uw omgeving controleren om de bereikbaarheid te repareren. er zijn een paar punten die nader kunnen worden bekeken :

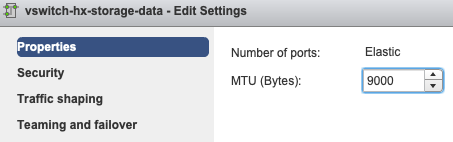

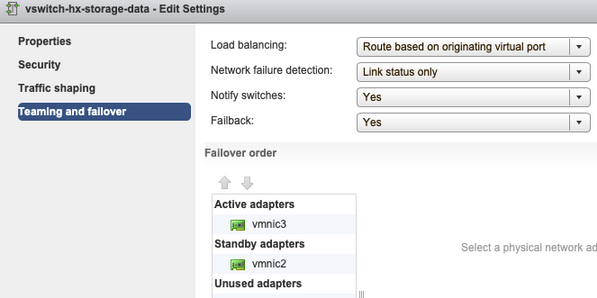

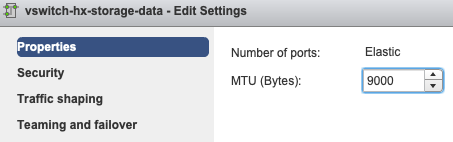

- HX-storage-data vSwitch-instellingen:

Opmerking: Standaard wordt alle configuratie uitgevoerd door de installateur tijdens de clustertoepassing. Als dit daarna handmatig is gewijzigd, controleert u de instellingen

MTU Instellingen - Als u Jumbo MTU's hebt ingeschakeld tijdens het gebruik van een cluster, moet de MTU op de vSwitch ook 9000 zijn. Voor het geval u geen baan gebruikt MTU moet dit 1500 zijn.

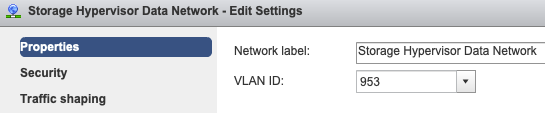

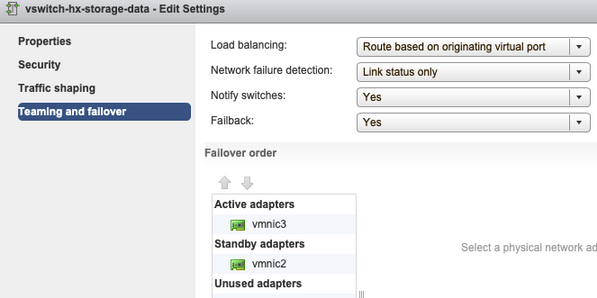

Teaming en failover - Het systeem probeert standaard te verzekeren dat het opslaggegevensverkeer lokaal is geschakeld door de FI. Daarom moeten de actieve en standby adapters tussen alle hosts hetzelfde zijn.

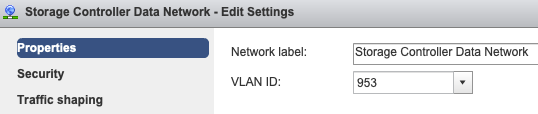

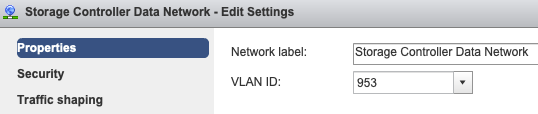

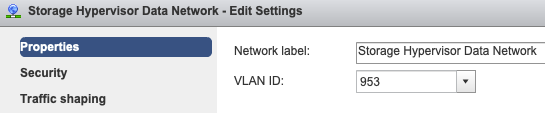

Instellingen poortgroep VLAN - Het opslaggegevens-VLAN moet worden gespecificeerd op zowel de poortgroepen van opslagcontrollers en het Hyperlink Data Network.

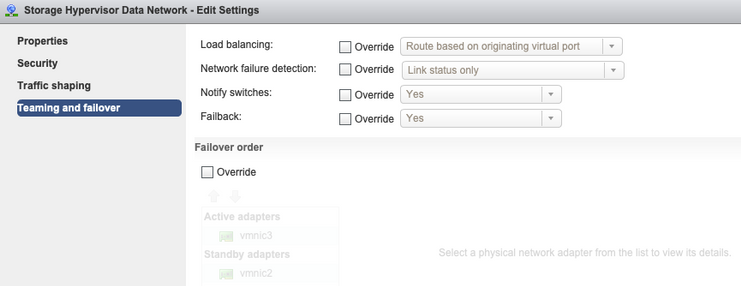

Geen overzichten op het niveau van de poortgroep - De instellingen Teaming & Failover die op het vSwitch-niveau zijn uitgevoerd worden standaard op de poortgroepen toegepast. Daarom is het aanbevolen de instellingen op het niveau van de poortgroep niet te omzeilen.

Opmerking: Standaard wordt alle configuratie uitgevoerd door de installateur tijdens de clustertoepassing. Als dit daarna handmatig is gewijzigd, controleert u de instellingen

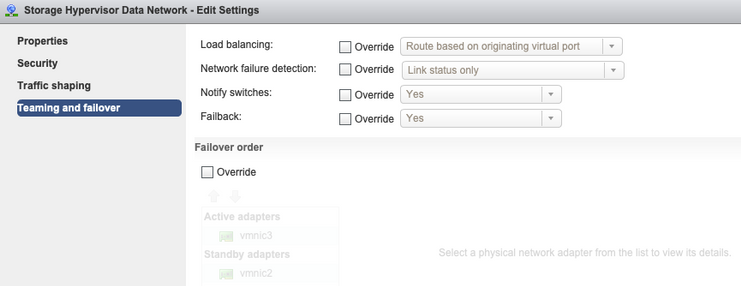

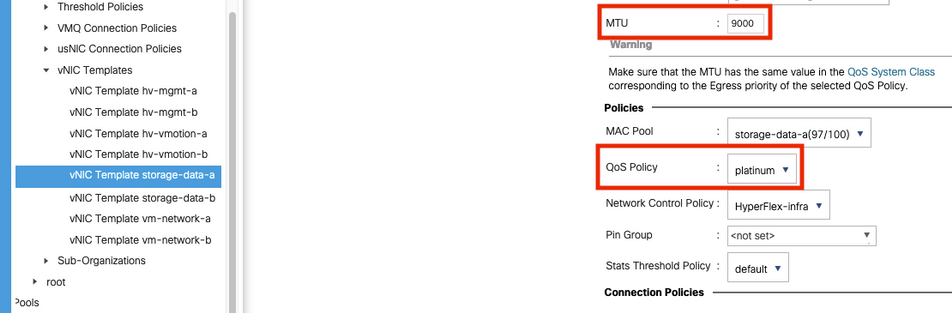

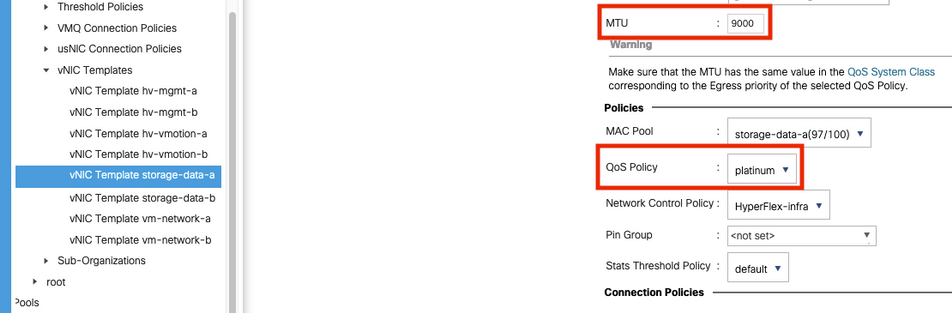

MTU Settings - verzekeren dat de omvang van de MTU en het QoS-beleid in de sjabloon voor opslaggegevens correct zijn geconfigureerd. De opslagdata-databases gebruiken Platinum QoS-beleid en de MTU moet worden geconfigureerd zoals in uw omgeving.

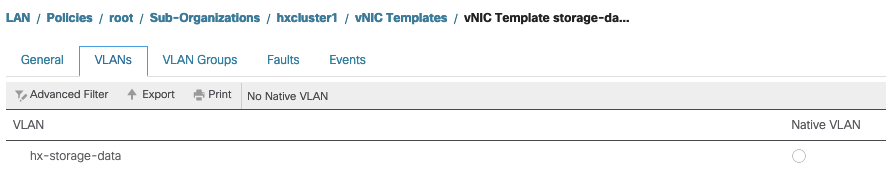

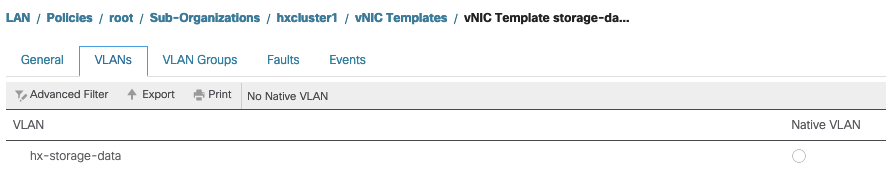

VLAN-instellingen - Het hx-storage-data VLAN dat tijdens de clusterimplementatie is gemaakt, moet in de sjabloon zijn toegestaan. ervoor te zorgen dat het niet als inheemse

Controle van IoDeler/SCVMclient/NFS Proxy-status

De SCVMclient vib in de ESXI werkt als de NFS Proxy. Het onderschept de virtuele machine IO, stuurt het naar de respectievelijke SCVM en geeft het terug met de benodigde informatie.

Zorg ervoor dat VIB op onze hosts is geïnstalleerd, voor deze SSH op een van de ESXI's en voer de opdrachten uit:

[root@node1:~] esxcli software vib list | grep -i spring

scvmclient 3.5.2b-31674 Springpath VMwareAccepted 2019-04-17

stHypervisorSvc 3.5.2b-31674 Springpath VMwareAccepted 2019-05-20

vmware-esx-STFSNasPlugin 1.0.1-21 Springpath VMwareAccepted 2018-11-23

Controleer nu de status van de scvmclient op het scherm en zorg ervoor dat de client actief is, en start de client als deze wordt gestopt met de opdracht /etc/init.d/scvmclient start

[root@node1:~] /etc/init.d/scvmclient status

+ LOGFILE=/var/run/springpath/scvmclient_status

+ mkdir -p /var/run/springpath

+ trap mv /var/run/springpath/scvmclient_status /var/run/springpath/scvmclient_status.old && cat /var/run/springpath/scvmclient_status.old |logger -s EXIT

+ exec

+ exec

Scvmclient is running

Cluster UID oplosbaar in ESXI Loopback IP

Hyperflex zet de UUID van het cluster in kaart aan de loopback interface van het ESXi, zodat het ESXI de NFS-verzoeken aan zijn eigen scvmclient doorgeeft. Als dit er niet is, kunt u problemen krijgen met de datastores die op de host worden geregistreerd. Om dit te verifiëren, moet ssh naar de host die datastores heeft gemonteerd, en ssh naar de host met problemen, en de bestand/etc/hosts katten

Als u ziet dat de niet-functionele host niet de entry in /etc/hosts heeft, kunt u deze van een functionele host kopiëren naar de /etc/hosts van de niet-functionele host.

Non-functionele host

[root@node1:~] cat /etc/hosts

# Do not remove these lines, or various programs

# that require network functionality will fail.

127.0.0.1 localhost.localdomain localhost

::1 localhost.localdomain localhost

10.197.252.75 node1

Functionele host

[root@node2:~] cat /etc/hosts

# Do not remove these lines, or various programs

# that require network functionality will fail.

127.0.0.1 localhost.localdomain localhost

::1 localhost.localdomain localhost

10.197.252.76 node2

127.0.0.1 3203172317343203629-5043383143428344954.springpath 3203172317343203629-5043383143428344954

Stale Datastore-indelingen in /etc/vmware/esx.conf

Als het HX-cluster niet opnieuw is geïnstalleerd van ESXI, kunt u oude datastore-items in het esx.conf-bestand hebben.

Dit maakt het niet mogelijk om de nieuwe datastores met dezelfde naam te koppelen. U kunt alle HX datastores in esx.conf uit het bestand controleren:

[root@node1:~] cat /etc/vmware/esx.conf | grep -I nas

/nas/RepSec/share = "10.197.252.106:RepSec"

/nas/RepSec/enabled = "true"

/nas/RepSec/host = "5983172317343203629-5043383143428344954"

/nas/RepSec/readOnly = "false"

/nas/DS/share = "10.197.252.106:DS"

/nas/DS/enabled = "true"

/nas/DS/host = "3203172317343203629-5043383143428344954"

/nas/DS/readOnly = "false"

als je in de output ziet dat de oude datastore die in kaart is gebracht en de oude cluster UUID gebruikt, dan staat ESXi je dus niet toe om de genoemde datastore met de nieuwe UID te koppelen.

Om dit op te lossen, is het nodig om de oude datastore ingang met de opdracht - esxcfg-nas-d RepSec te verwijderen

Nadat het is verwijderd, probeert u het aantal datastore opnieuw uit de HX-Connect

Controleer firewallregels in ESXi

Schakel deze optie in voor instellingen voor firewalls

Het is ingesteld op Vals, het veroorzaakt problemen.

[root@node1:~] esxcli network firewall get

Default Action: DROP

Enabled: false

Loaded: true

Schakel deze functie in met de opdrachten:

[root@node1:~] esxcli network firewall set –e true

[root@node1:~] esxcli network firewall get

Default Action: DROP

Enabled: true

Loaded: true

Instellingen voor verbindingsregels controleren

Het is ingesteld op Vals, het veroorzaakt problemen.

[root@node1:~] esxcli network firewall ruleset list | grep -i scvm

ScvmClientConnectionRule false

Schakel deze functie in met de opdrachten:

[root@node1:~] esxcli network firewall ruleset set –e true –r ScvmClientConnectionRule

[root@node1:~] esxcli network firewall ruleset list | grep -i scvm

ScvmClientConnectionRule true

Controleer iptable-regels op SCVM

Controleer en stem het aantal regels op alle SCVM's af. Als ze niet overeenkomen, opent u een TAC-case om deze te corrigeren.

root@SpringpathControllerI51U7U6QZX:~# iptables -L | wc -l

48

Gerelateerde informatie

Feedback

Feedback