はじめに

このドキュメントでは、Cisco IOS® XEデバイスの基本設定とトラブルシューティングについて説明します。

前提条件

要件

次の項目に関する知識があることが推奨されます。

- DCIオーバーレイおよびマルチキャストに関する基本的な知識

使用するコンポーネント

このドキュメントの情報は、次のソフトウェアとハードウェアのバージョンに基づいています。

- ソフトウェア03.16.00.Sが稼働するASR1004

- ソフトウェア3.16.03.Sを実行するCSR100v(VXE)

このドキュメントの情報は、特定のラボ環境にあるデバイスに基づいて作成されました。このドキュメントで使用するすべてのデバイスは、クリアな(デフォルト)設定で作業を開始しています。本稼働中のネットワークでは、各コマンドによって起こる可能性がある影響を十分確認してください。

背景説明

仮想拡張LAN(VXLAN)は、データセンター相互接続(DCI)ソリューションとしてますます普及しています。VXLAN機能は、レイヤ3/パブリックルーティングドメイン上でレイヤ2拡張を提供するために使用されます。このドキュメントでは、Cisco IOS XEデバイスの基本設定とトラブルシューティングについて説明します。

このドキュメントの「設定と確認」セクションでは、次の2つのシナリオについて説明しています。

- シナリオAでは、マルチキャストモードの3つのデータセンター間のVXLAN設定について説明します。

- シナリオBでは、ユニキャストモードの2つのデータセンター間のVXLAN設定について説明します。

設定

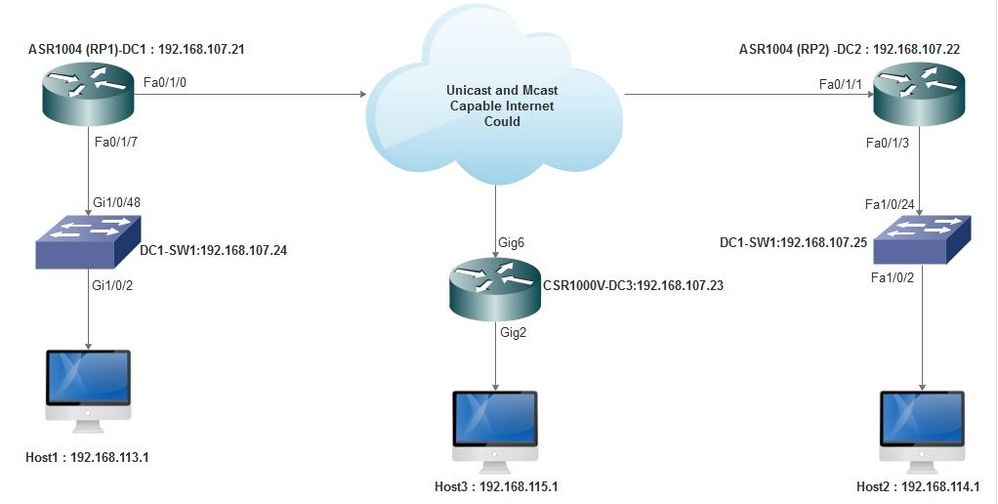

シナリオA:マルチキャストモードでの3つのデータセンター間のVXLANの設定

基本設定

マルチキャストモードでは、サイト間のユニキャスト接続とマルチキャスト接続の両方が必要です。この設定ガイドでは、Open Shortest Path First(OSPF)を使用してユニキャスト接続を提供し、Bidirectional Protocol Independent Multicast(PIM)を使用してマルチキャスト接続を提供します。

次に、3つすべてのデータセンターにおけるマルチキャストモードの動作の基本設定を示します。

!

DC1#show run | sec ospf

router ospf 1

network 10.1.1.1 0.0.0.0 area 0

network 10.10.10.4 0.0.0.3 area 0

!

PIM双方向コンフィギュレーション:

!

DC1#show run | sec pim

ip pim bidir-enable

ip pim send-rp-discovery scope 10

ip pim bsr-candidate Loopback1 0

ip pim rp-candidate Loopback1 group-list 10 bidir

!

access-list 10 permit 239.0.0.0 0.0.0.255

!

DC1#

!

さらに、ループバックを含むすべてのL3インターフェイスでPIMスパースモードが有効になっています。

!

DC1#show run interface lo1

Building configuration...

Current configuration : 83 bytes

!

interface Loopback1

ip address 10.1.1.1 255.255.255.255

ip pim sparse-mode

end

また、マルチキャストルーティングがデバイスで有効になっていること、およびマルチキャストmrouteテーブルにデータが入力されていることを確認します。

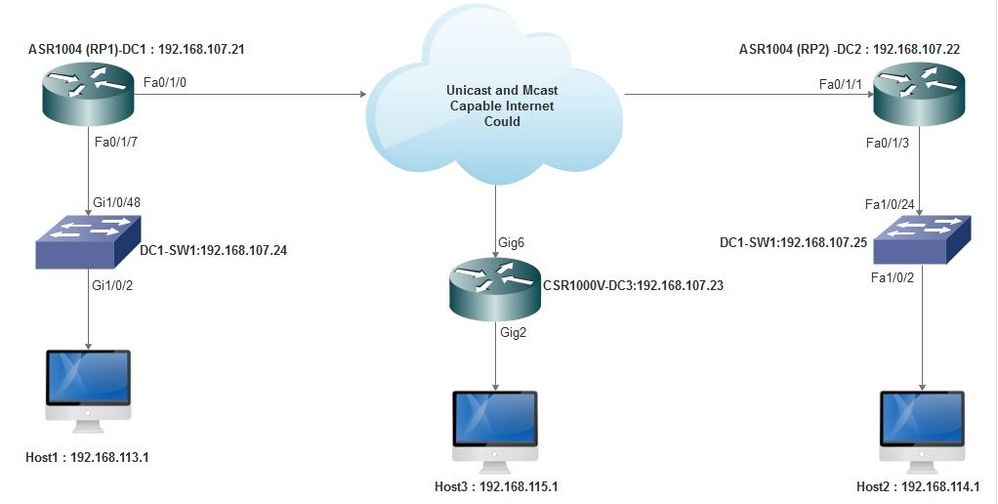

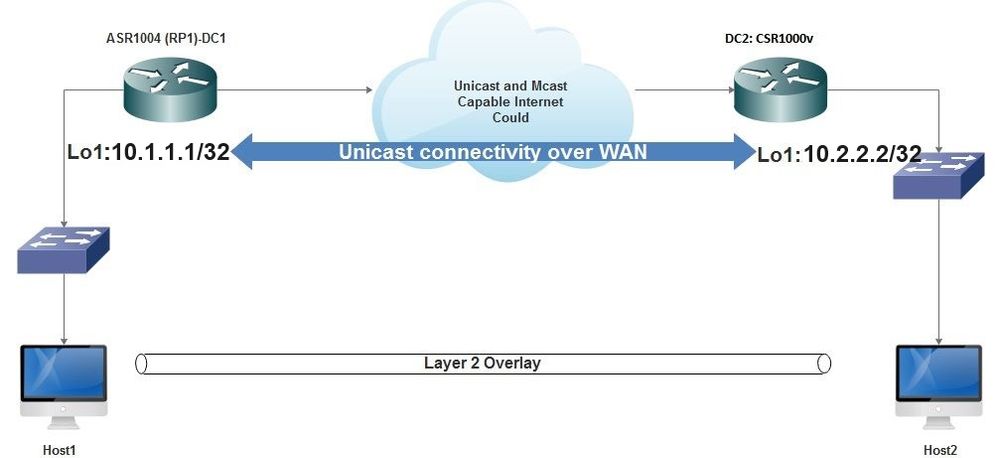

ネットワーク図

ユニキャストおよびマルチキャスト対応インターネット

ユニキャストおよびマルチキャスト対応インターネット

DC1(VTEP1)の設定

!

!

Vxlan udp port 1024

!

Interface Loopback1

ip address 10.1.1.1 255.255.255.255

ip pim sparse-mode

!

ブリッジドメイン設定でVNIメンバーとメンバーインターフェイスを定義します。

!

bridge-domain 1

member vni 6001

member FastEthernet0/1/7 service-instance 1

!

ネットワーク仮想インターフェイス(NVE)を作成し、WANを介して他のデータセンターに拡張する必要があるVNIメンバーを定義します。

!

interface nve1

no ip address

shut

member vni 6001 mcast-group 10.0.0.10

!

source-interface Loopback1

!

LANインターフェイス(つまり、LANネットワークに接続するインターフェイス)を介してサービスインスタンスを作成し、特定のVLAN(802.1qタグ付きトラフィック)(この場合はVLAN 1)をオーバーレイします。

!

interface FastEthernet0/1/7

no ip address

negotiation auto

cdp enable

no shut

!

トラフィックをオーバーレイ経由で送信する前にVLANタグを削除し、リターントラフィックがVLANに送信された後にそれをプッシュします。

!

service instance 1 ethernet

encapsulation unagged

!

DC2(VTEP2)の設定

!

!

Vxlan udp port 1024

!

interface Loopback1

ip address 10.2.2.2 255.255.255.255

ip pim sparse-mode

!

!

bridge-domain 1

member vni 6001

member FastEthernet0/1/3 service-instance 1

!

!

interface nve1

no ip address

member vni 6001 mcast-group 10.0.0.10

!

source-interface Loopback1

shut

!

!

interface FastEthernet0/1/3

no ip address

negotiation auto

cdp enable

no shut

!

service instance 1 ethernet

encapsulation untagged

!

DC3(VTEP3)の設定

!

!

Vxlan udp port 1024

!

interface Loopback1

ip address 10.3.3.3 255.255.255.255

ip pim sparse-mode

!

!

bridge-domain 1

member vni 6001

member GigabitEthernet2 service-instance 1

!

interface nve1

no ip address

shut

member vni 6001 mcast-group 10.0.0.10

!

source-interface Loopback1

!

interface gig2

no ip address

negotiation auto

cdp enable

no shut

!

service instance 1 ethernet

encapsulation untagged

!

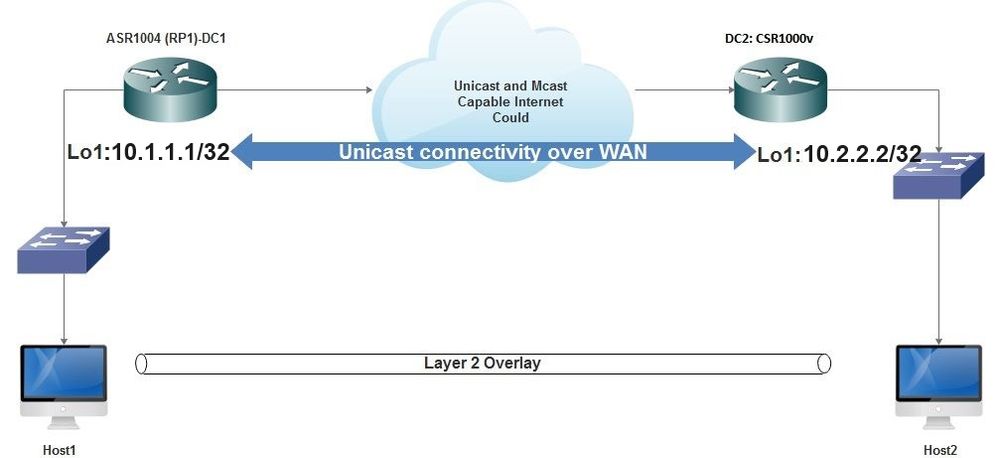

シナリオB:ユニキャストモードでの2つのデータセンター間のVXLANの設定

ネットワーク図

WAN経由のユニキャスト接続

WAN経由のユニキャスト接続

DC1の設定

!

interface nve1

no ip address

member vni 6001

! ingress replication shold be configured as peer data centers loopback IP address.

!

ingress-replication 10.2.2.2

!

source-interface Loopback1

!

!

interface gig0/2/1

no ip address

negotiation auto

cdp enable

!

service instance 1 ethernet

encapsulation untagged

!

!

!

bridge-domain 1

member vni 6001

member gig0/2/1 service-instance 1

DC2の設定

!

interface nve1

no ip address

member vni 6001

ingress-replication 10.1.1.1

!

source-interface Loopback1

!

!

interface gig5

no ip address

negotiation auto

cdp enable

!

service instance 1 ethernet

encapsulation untagged

!

!

bridge-domain 1

member vni 6001

member gig5 service-instance 1

確認

シナリオA:マルチキャストモードでの3つのデータセンター間のVXLANの設定

シナリオAの設定が完了したら、各データセンター内の接続されたホストは、同じブロードキャストドメイン内で相互に到達できる必要があります。

次のコマンドを使用して、設定を確認します。シナリオBに例が示されています。

Router#show nve vni

Router#show nve vni interface nve1

Router#show nve interface nve1

Router#show nve interface nve1 detail

Router#show nve peers

シナリオB:ユニキャストモードでの2つのデータセンター間のVXLANの設定

DC1上:

DC1#show nve vni

Interface VNI Multicast-group VNI state

nve1 6001 N/A Up

DC1#show nve interface nve1 detail

Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan

source-interface: Loopback1 (primary:10.1.1.1 vrf:0)

Pkts In Bytes In Pkts Out Bytes Out

60129 6593586 55067 5303698

DC1#show nve peers

Interface Peer-IP VNI Peer state

nve1 10.2.2.2 6000 -

DC2:

DC2#show nve vni

Interface VNI Multicast-group VNI state

nve1 6000 N/A Up

DC2#show nve interface nve1 detail

Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan

source-interface: Loopback1 (primary:10.2.2.2 vrf:0)

Pkts In Bytes In Pkts Out Bytes Out

70408 7921636 44840 3950835

DC2#show nve peers

Interface Peer-IP VNI Peer state

nve 10.1.1.1 6000 Up

DC2#show bridge-domain 1

Bridge-domain 1 (3 ports in all)

State: UP Mac learning: Enabled

Aging-Timer: 300 second(s)

BDI1 (up)

GigabitEthernet0/2/1 service instance 1

vni 6001

AED MAC address Policy Tag Age Pseudoport

0 7CAD.74FF.2F66 forward dynamic 281 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 B838.6130.DA80 forward dynamic 288 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 0050.56AD.1AD8 forward dynamic 157 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

トラブルシュート

「確認」セクションで説明するコマンドは、基本的なトラブルシューティング手順を提供します。これらの追加診断は、システムが動作していない場合に役立ちます。

注:これらの診断の一部は、メモリおよびCPU使用率の増加を引き起こす可能性があります。

デバッグ診断

#debug nve error

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes eer nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

#show nve log error

[01/01/70 00:04:34.130 UTC 1 3] NVE-MGR-STATE ERROR: vni 6001: error in create notification to Tunnel

[01/01/70 00:04:34.314 UTC 2 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 00:04:34.326 UTC 3 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:50:59.650 UTC 4 3] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:50:59.654 UTC 5 3] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:50:59.701 UTC 6 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:50:59.705 UTC 7 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:54:55.166 UTC 8 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:54:55.168 UTC 9 61] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:55:04.432 UTC A 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:55:04.434 UTC B 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:55:37.670 UTC C 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

#show nve log event

[01/04/70 19:48:51.883 UTC 1DD16 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD17 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD18 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD19 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD1A 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1B 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1C 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1D 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1E 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD1F 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD20 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:21.884 UTC 1DD21 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

Embedded Packet Capture

Cisco IOS XEソフトウェアで使用可能な組み込みパケットキャプチャ(EPC)機能は、トラブルシューティングに役立つ追加情報を提供します。

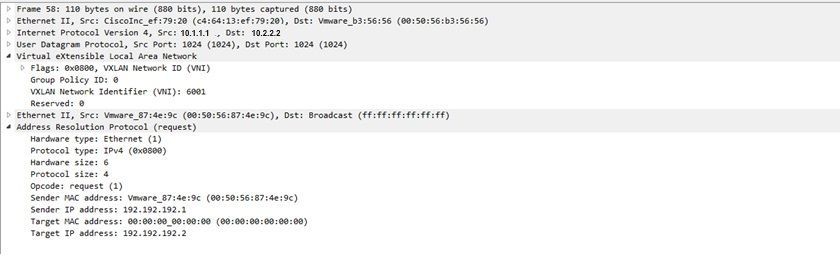

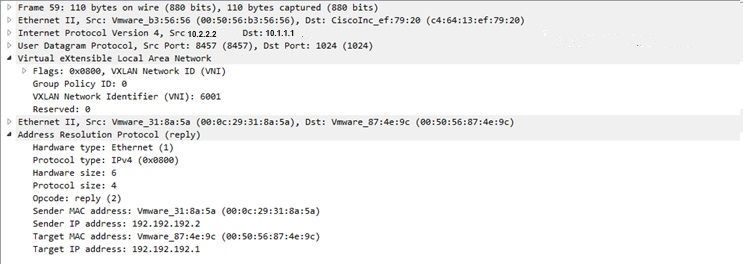

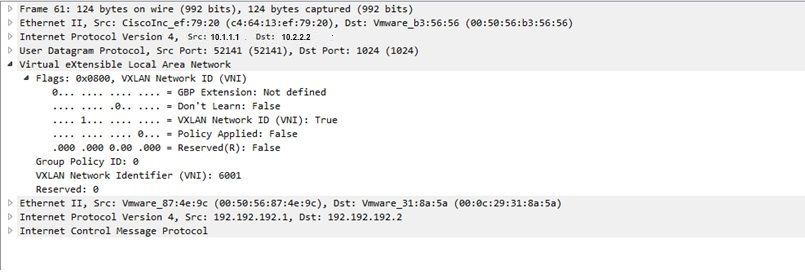

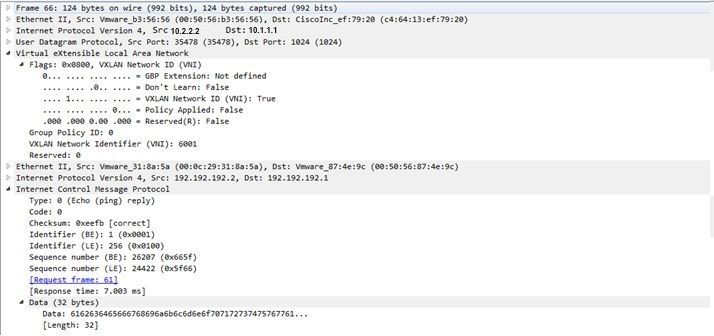

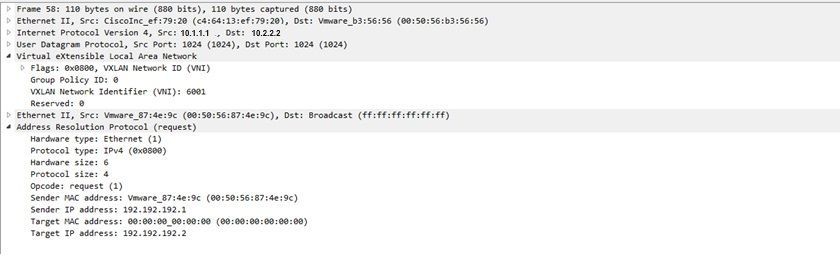

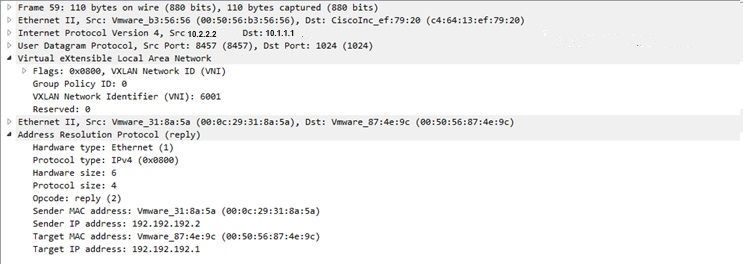

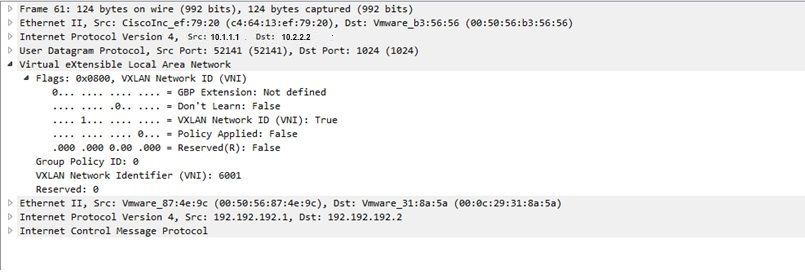

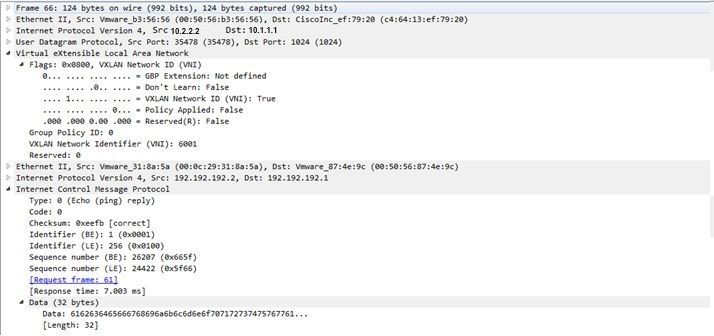

たとえば、次のキャプチャは、VXLANによってカプセル化されるパケットを説明しています。

EPC設定(TEST_ACLは、キャプチャデータのフィルタリングに使用されるアクセスリストです):

#monitor capture TEST access-list TEST_ACL interface gigabitEthernet0/2/0 both #monitor capture TEST buffer size 10 #monitor capture TEST start

次に、パケットダンプの結果を示します。

# show monitor capture TEST buffer dump # monitor capture TEST export bootflash:TEST.pcap // with this command you can export the capture in pcap format to the bootflash, which can be downloaded and opened in wireshark.

次の例では、簡易インターネット制御メッセージプロトコル(ICMP)がVXLAN上でどのように動作するかを説明します。

VXLANオーバーレイ経由で送信されるアドレス解決プロトコル(ARP):

ARP応答:

ICMP要求:

ICMP応答:

その他のdebugコマンドとtroubleshootingコマンド

このセクションでは、さらにdebugコマンドとtroubleshootingコマンドについて説明します。

この例では、デバッグの強調表示されている部分から、NVEインターフェイスがマルチキャストグループに参加できなかったことがわかります。そのため、VNI 6002ではVXLANカプセル化が有効になっていません。これらのデバッグ結果は、ネットワーク上のマルチキャストの問題を示しています。

#debug nve all

*Jan 5 06:13:55.844: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:13:55.846: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was failure

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:13:55.851: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:13:55.857: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:13:55.857: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Down

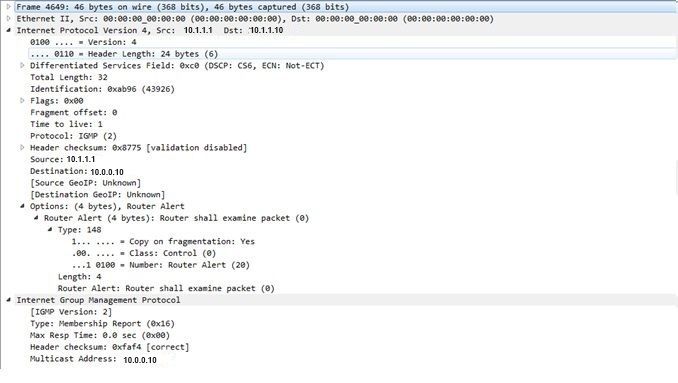

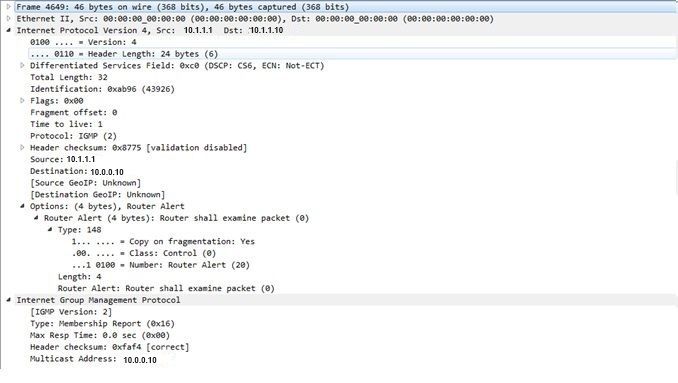

VNIがmcastグループに参加した後に送信できるInternet Group Management Protocol(IGMP)メンバーシップレポートを次に示します。

次の例は、マルチキャストが期待どおりに動作している場合に、NVE下でVNIをマルチキャストモードに設定した後に予想されるデバッグの結果を示しています。

*Jan 5 06:19:20.335: NVE-MGR-DB: [IF 0x14]VNI node creation

*Jan 5 06:19:20.335: NVE-MGR-DB: VNI Node created [437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 create notification to PD

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 Create notif successful, map [pd 0x1020017] to [pi 0x437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:19:20.342: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was successful

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:19:20.347: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:19:20.347: NVE-MGR-DB: Return pd_hdl[0x1020017] for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.347: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.351: NVE-MGR-EI: L2FIB query for info 0x437C9B28

*Jan 5 06:19:20.351: NVE-MGR-EI: PP up notification for bd_id 3

*Jan 5 06:19:20.351: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.352: NVE-MGR-STATE: vni 6002: Notify clients of state change Create to Up

*Jan 5 06:19:20.352: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.353: NVE-MGR-PD: VNI 6002 Create to Up State update to PD successful

*Jan 5 06:19:20.353: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: No state change Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: New State as a result of create Up

関連情報

フィードバック

フィードバック