Introduzione

In questo documento viene descritto come configurare le MTU (Maximum Transition Unit) jumbo in modo completo sui dispositivi del data center Cisco.

Prerequisiti

Requisiti

Cisco raccomanda la conoscenza dei seguenti argomenti:

- VMWare ESXi

- Cisco UCS

- Cisco N5k

- Cisco iSCSI (Internet Small Computer Systems Interface)

Componenti usati

In questo documento viene descritto come configurare una MTU (Maximum Transition Unit) jumbo end-to-end tra dispositivi Cisco Data Center in una rete composta da un host VMware ESXi installato sugli switch Cisco Unified Computing System (UCS), Cisco Nexus serie 1000V (N1kV), Cisco Nexus serie 5000 (N5k) e il controller Cisco NetApp.

Le informazioni fornite in questo documento si basano sulle seguenti versioni software e hardware:

- Cisco Nexus serie 5020 Switch versione 5.0(3)N2(2a)

- Cisco UCS versione 2.1(1d)

- Server blade Cisco UCS B200 M3 con scheda di interfaccia virtuale Cisco (VIC) 1240

- vSphere 5.0 (ESXi e vCenter)

- Cisco N1kV versione 4.2(1)SV2(2.1a)

- NetApp FAS 3240

Le informazioni discusse in questo documento fanno riferimento a dispositivi usati in uno specifico ambiente di emulazione. Su tutti i dispositivi menzionati nel documento la configurazione è stata ripristinata ai valori predefiniti. Se la rete è operativa, valutare attentamente eventuali conseguenze derivanti dall'uso dei comandi.

Configurazione

Esempio di rete

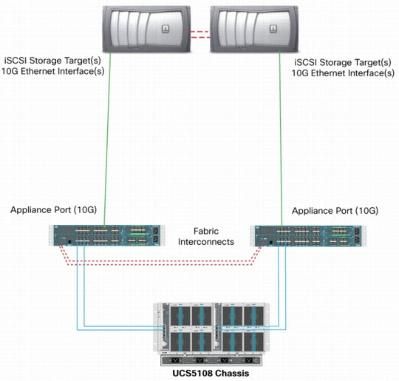

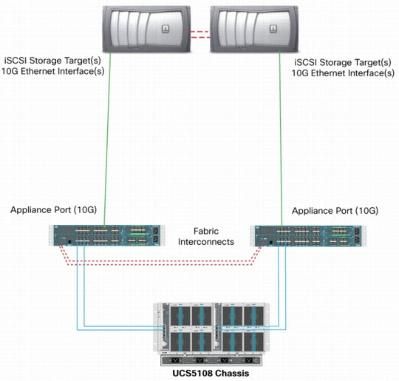

La tipica implementazione di una SAN (Storage Area Network) iSCSI utilizza Cisco UCS con un'interconnessione fabric in modalità Ethernet End Host e la destinazione di archiviazione connessa tramite uno switch a monte o una rete commutata.

Tramite le porte dell'accessorio sull'UCS, lo storage può essere collegato direttamente alle interconnessioni fabric.

Che la rete upstream sia 1 GbE o 10 GbE, l'uso di frame jumbo (ad esempio una MTU di 9000) migliora le prestazioni in quanto riduce il numero di frame singoli da inviare per una determinata quantità di dati e riduce la necessità di separare i blocchi di dati iSCSI in più frame Ethernet. Inoltre, riducono l'utilizzo della CPU di host e storage.

Se si utilizzano frame jumbo, verificare che l'UCS e la destinazione di archiviazione, così come tutte le apparecchiature di rete tra di essi, siano in grado e configurati in modo da supportare frame di dimensioni maggiori.

Ciò significa che l'MTU jumbo deve essere configurata end-to-end (da iniziatore a destinazione) in modo che sia efficace in tutto il dominio.

Di seguito è riportata una panoramica della procedura utilizzata per configurare l'MTU jumbo end-to-end:

- Creare una classe di sistema UCS Quality of Service (QoS) con una MTU di 9000, quindi configurare la scheda NIC virtuale (vNIC) con una MTU jumbo.

- Abilitare i frame jumbo (MTU 9000) su tutti gli switch tra l'iniziatore (UCS) e la destinazione iSCSI.

- Abilitare i frame jumbo sull'adattatore del sistema operativo (porta VMkernel di ESXi).

- Abilitare i frame jumbo sulle interfacce NetApp.

Nota: per ulteriori informazioni, fare riferimento all'articolo Opzioni di connettività dello storage e best practice di Cisco Unified Computing System (UCS) con lo storage NetApp Cisco.

Cisco UCS Configuration

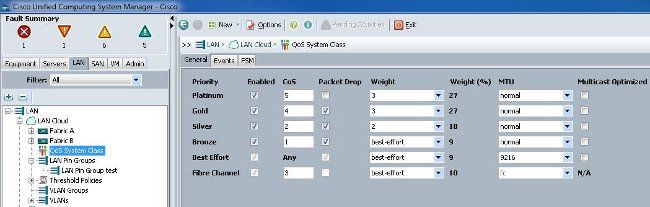

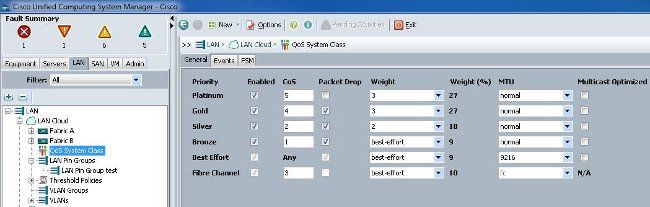

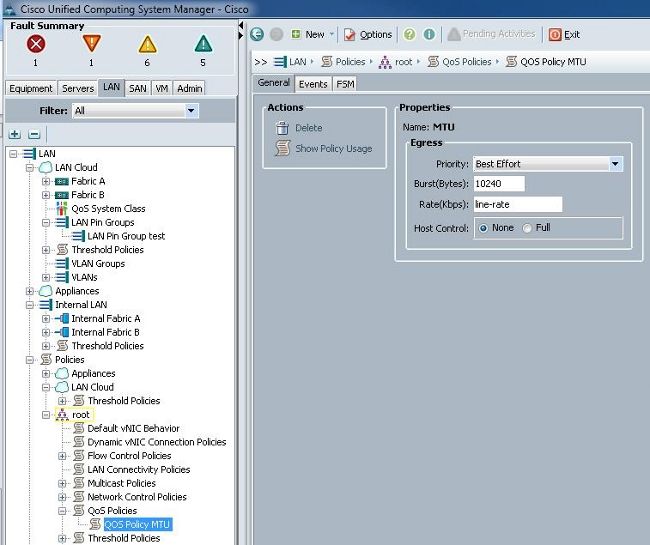

L'MTU viene impostata sulla base del valore CoS (per Class of Service) all'interno dell'UCS. Se non sono stati definiti criteri QoS per la vNIC indirizzata verso lo vSwitch, il traffico viene spostato alla classe di massimo sforzo.

Per abilitare i frame jumbo, completare i seguenti passaggi:

- Dall'interfaccia utente di UCS, fare clic sulla scheda LAN.

- Selezionare LAN > LAN Cloud > Classe sistema QoS.

- Fare clic sulla classe di sistema QoS e modificare l'MTU della classe di traffico (che trasmette il traffico iSCSI) in 9216.

Nota: in questo esempio viene usata la classe di traffico Best Effort per illustrare questo aggiornamento dell'MTU.

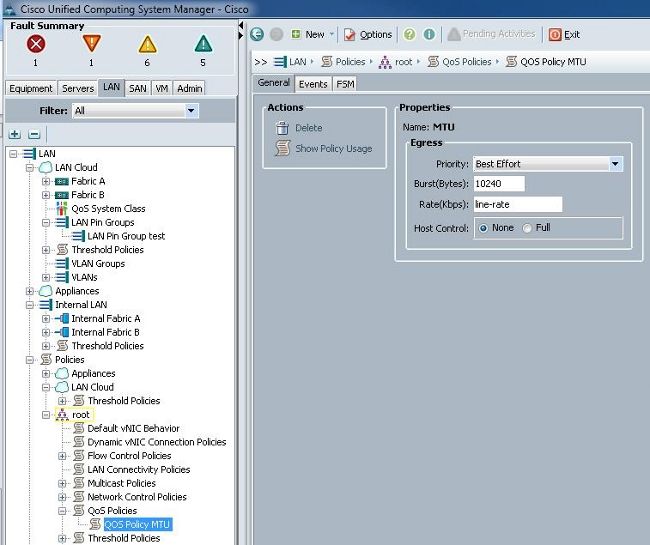

- Creare un criterio QoS nella scheda LAN e applicarlo alla vNIC che trasmette il traffico di storage.

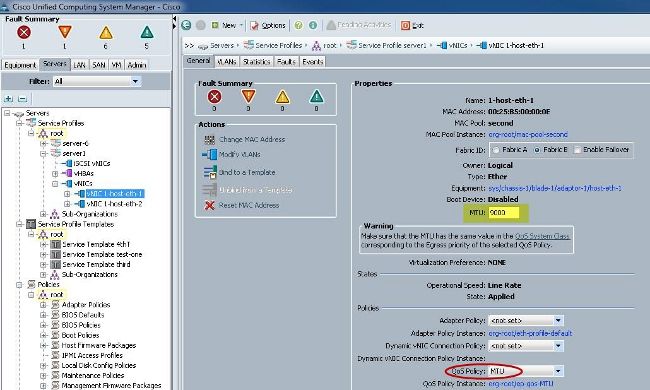

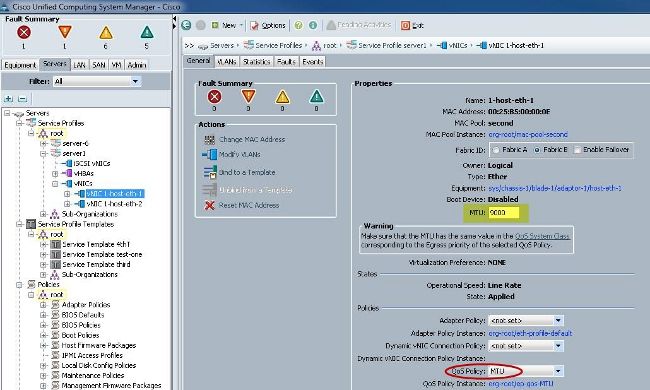

- Passare al modello vNIC o alla vNIC effettiva nei profili di servizio e impostare il valore MTU su 9000.

Verifica

Verificare che l'MTU della vNIC sia configurata come descritto in precedenza.

Verificare che le porte uplink abbiano la MTU jumbo abilitata.

Configurazione N5k

Con la N5k, l'MTU jumbo è abilitata a livello di sistema.

Aprire un prompt dei comandi e immettere questi comandi per configurare il sistema per l'MTU jumbo:

switch(config)#policy-map type network-qos jumbo

switch(config-pmap-nq)#class type network-qos class-default

switch(config-pmap-c-nq)#mtu 9216

switch(config-pmap-c-nq)#exit

switch(config-pmap-nq)#exit

switch(config)#system qos

switch(config-sys-qos)#service-policy type network-qos jumbo

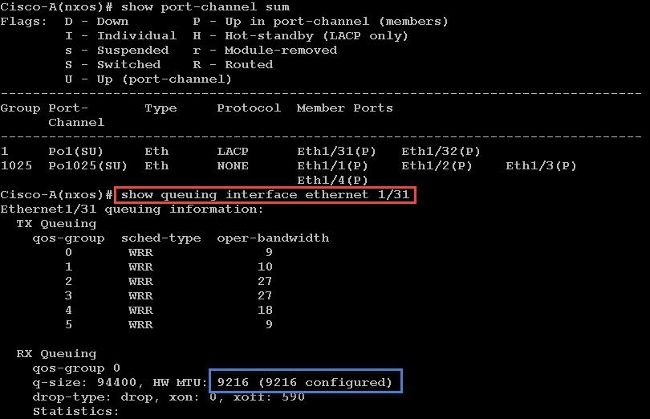

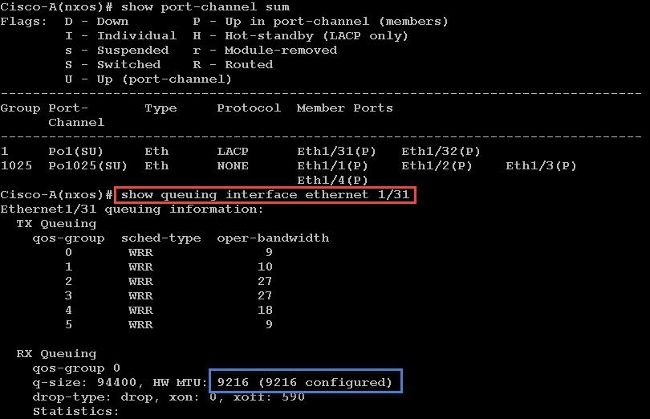

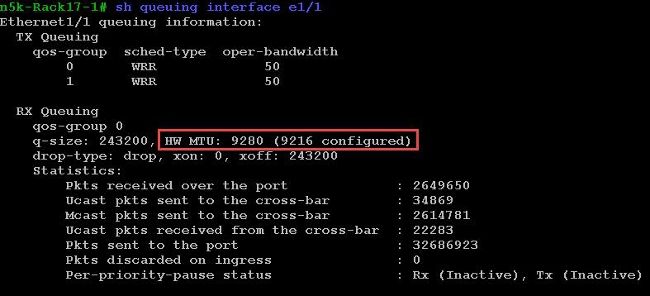

Verifica

Immettere il comando show queuing interface Ethernet x/y per verificare che l'MTU jumbo sia abilitata:

Nota: il comando show interface Ethernet x/y restituisce un MTU di 1500, ma questa condizione non è corretta.

Configurazione di VMware ESXi

È possibile configurare il valore MTU di uno switch vSwitch in modo che tutti i gruppi di porte e le porte utilizzino frame jumbo.

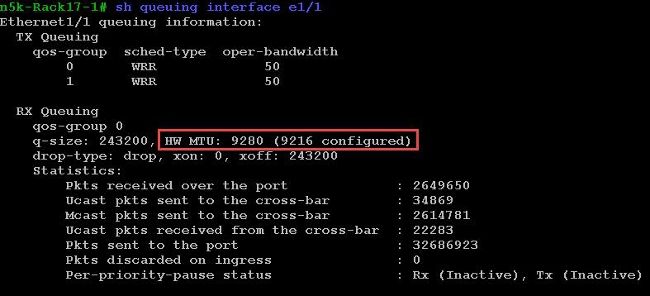

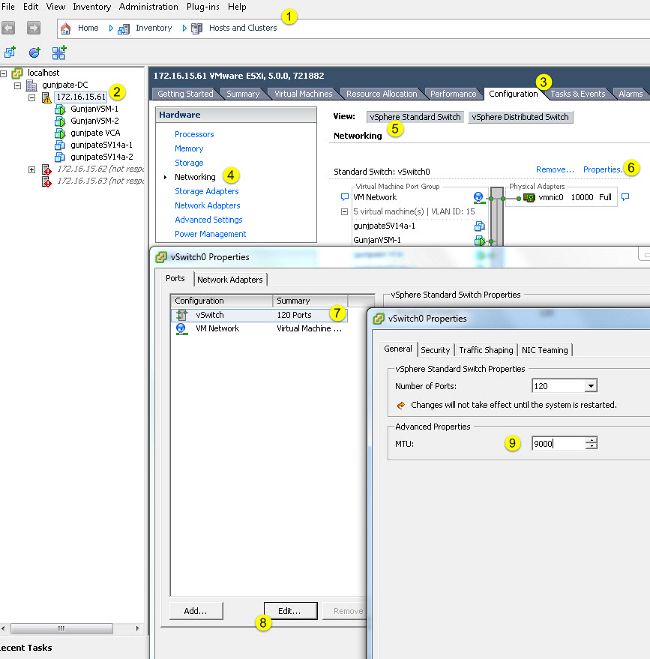

Per abilitare i frame jumbo su uno switch host v, completare i seguenti passaggi:

- Passare a Home > Inventario > Host e cluster dal client vSphere.

- Selezionare l'host.

- Fare clic sulla scheda Configuration.

- Selezionare Networking (Rete) nel menu Hardware.

- Scegliere vSphere Standard Switch nel campo View (Visualizza).

- Fare clic su Proprietà.

- Selezionare vSwitch nella scheda Porte della finestra a comparsa Proprietà.

- Fare clic su Edit (Modifica).

- Nella scheda General (Generale) della finestra a comparsa, modificare l'MTU (in Advanced Properties) dal valore predefinito (1500) a 9000. In questo modo si abilitano i frame jumbo su tutti i gruppi di porte e su tutte le porte dello switch vSwitch.

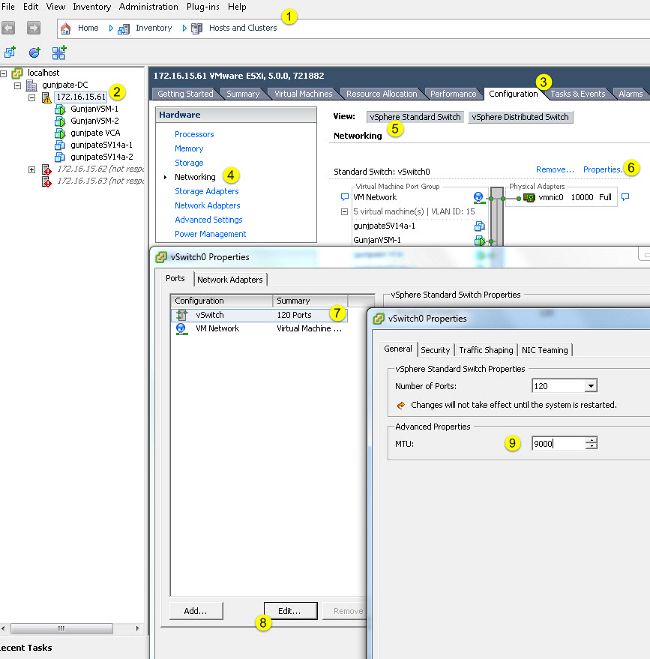

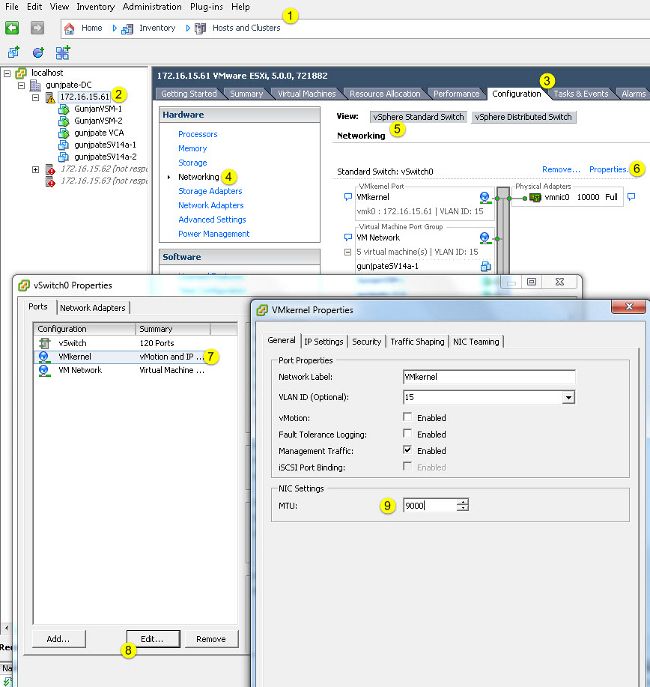

Completare questi passaggi per abilitare i frame jumbo solo su una porta VMkernel dal server vCenter:

- Dal client vSphere, passare a Home > Inventario > Host e cluster.

- Selezionare l'host.

- Fare clic sulla scheda Configuration.

- Selezionare Networking (Rete) nel menu Hardware.

- Scegliere vSphere Standard Switch nel campo View (Visualizza).

- Fare clic su Proprietà.

- Selezionare VMkernel nella scheda Porte della finestra popup Proprietà.

- Fare clic su Edit (Modifica).

- Nella scheda General (Generale) della finestra popup, modificare l'MTU (in NIC Settings) dal valore predefinito (1500) a 9000. In questo modo i frame jumbo vengono abilitati solo su una porta VMkernel dello switch v40.

Verifica

Immettere il comando vmkping -d -s 8972 <indirizzo ip accessorio di storage> per verificare la connettività di rete e verificare che la porta VMkernel sia in grado di eseguire il ping con MTU jumbo.

Suggerimento: per ulteriori informazioni su questo comando, fare riferimento all'articolo Test della connettività di rete VMkernel con il comando vmkping.

Nota: le dimensioni massime del pacchetto sono 8972, che invia un pacchetto da 9000 byte quando si aggiungono i byte dell'intestazione IP e ICMP.

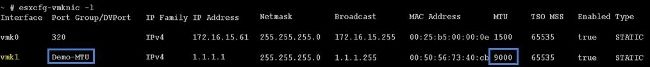

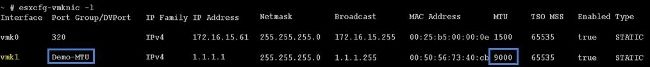

A livello di host ESXi, verificare che le impostazioni MTU siano configurate correttamente:

Configurazione di Cisco IOS

Sugli switch Cisco IOS®, non esiste il concetto di MTU globale a livello di switch. Al contrario, l'MTU è configurata a livello di interfaccia/canale etere.

Immettere questi comandi per configurare l'MTU jumbo:

7609(config)#int gigabitEthernet 1/1

7609(config-if)#mtu ?

<1500-9216> MTU size in bytes

7609(config-if)#mtu 9216

Verifica

Immettere il comando show interfaces gigabit Ethernet 1/1 per verificare che la configurazione sia corretta:

7609#show interfaces gigabitEthernet 1/1

GigabitEthernet1/1 is up, line protocol is up (connected)

Hardware is C6k 1000Mb 802.3, address is 0007.0d0e.640a (bia 0007.0d0e.640a)

MTU 9216 bytes, BW 1000000 Kbit, DLY 10 usec,

reliability 255/255, txload 1/255, rxload 1/255

Configurazione N1kV

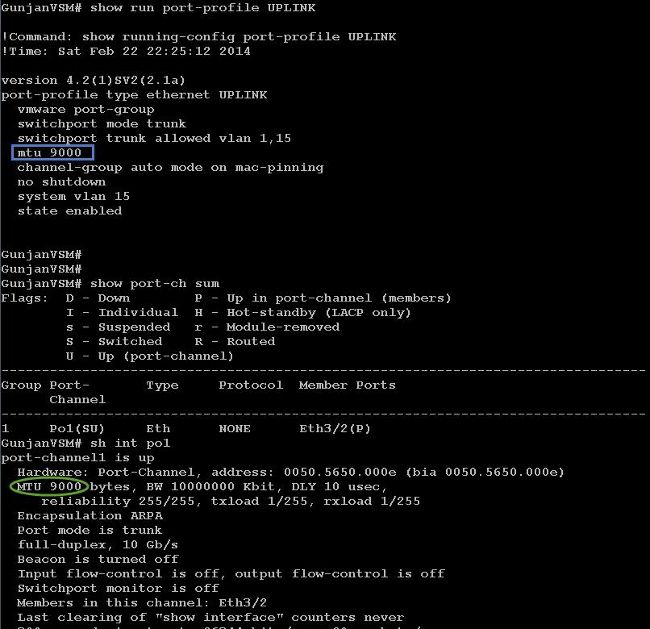

Con il modello N1kV, l'MTU jumbo può essere configurata solo sui profili delle porte Ethernet per l'uplink; l'MTU non può essere configurata sull'interfaccia vEthernet.

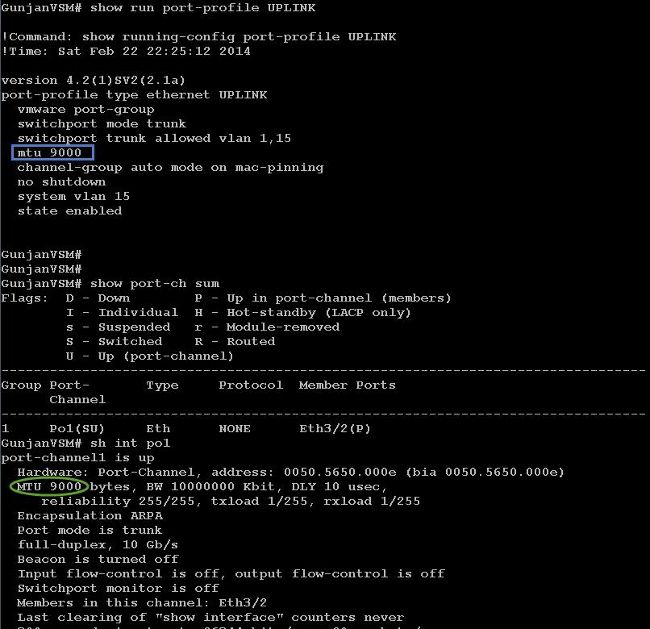

Verifica

Immettere il comando show run port-profile UPLINK per verificare che la configurazione sia corretta:

Configurazione NetApp FAS 3240

Sul controller di storage, l'MTU jumbo deve essere configurata per le porte di rete connesse all'interconnessione fabric o allo switch di layer 2 (L2). Di seguito è riportato un esempio di configurazione:

FAS3240-A> vlan create e1a 100

Ethernet e1a: Link being reconfigured.

vlan: e1a-100 has been created

Ethernet e1a: Link up.

FAS3240-A> vlan create e1b 100

Ethernet e1b: Link being reconfigured.

vlan: e1b-100 has been created

Ethernet e1b: Link up.

FAS3240-A> ifconfig e1a-100 192.168.101.105 netmask 255.255.255.0 mtusize 9000

partner e1a-100

FAS3240-A> ifconfig e1b-100 192.168.102.105 netmask 255.255.255.0 mtusize 9000

partner e1b-100

Verifica

Per verificare che la configurazione sia corretta, consultare questa sezione.

FAS3240-A> ifconfig –a

e1a: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2c (auto-10g_twinax-fd-up) flowcontrol full

e1b: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2e (auto-10g_twinax-fd-up) flowcontrol full

Feedback

Feedback