Risoluzione dei problemi relativi al cluster Firepower Threat Defense (FTD)

Opzioni per il download

Linguaggio senza pregiudizi

La documentazione per questo prodotto è stata redatta cercando di utilizzare un linguaggio senza pregiudizi. Ai fini di questa documentazione, per linguaggio senza di pregiudizi si intende un linguaggio che non implica discriminazioni basate su età, disabilità, genere, identità razziale, identità etnica, orientamento sessuale, status socioeconomico e intersezionalità. Le eventuali eccezioni possono dipendere dal linguaggio codificato nelle interfacce utente del software del prodotto, dal linguaggio utilizzato nella documentazione RFP o dal linguaggio utilizzato in prodotti di terze parti a cui si fa riferimento. Scopri di più sul modo in cui Cisco utilizza il linguaggio inclusivo.

Informazioni su questa traduzione

Cisco ha tradotto questo documento utilizzando una combinazione di tecnologie automatiche e umane per offrire ai nostri utenti in tutto il mondo contenuti di supporto nella propria lingua. Si noti che anche la migliore traduzione automatica non sarà mai accurata come quella fornita da un traduttore professionista. Cisco Systems, Inc. non si assume alcuna responsabilità per l’accuratezza di queste traduzioni e consiglia di consultare sempre il documento originale in inglese (disponibile al link fornito).

Sommario

Introduzione

In questo documento viene descritta la risoluzione dei problemi di installazione di un cluster in Firepower Next-Generation Firewall (NGFW).

Prerequisiti

Requisiti

Cisco raccomanda la conoscenza dei seguenti argomenti (per i collegamenti, vedere la sezione Informazioni correlate):

- Architettura della piattaforma Firepower

- Configurazione e funzionamento del cluster Firepower

- Familiarità con la CLI di FTD e Firepower eXtensible Operating System (FXOS)

- Registri NGFW/data plane

- NGFW/data plane packet-tracer

- Acquisizioni FXOS/data plane

Componenti usati

- HARDWARE: Firepower 4125

- Software: 6.7.0 (Build 65) - piano dati 9.15(1)

Le informazioni discusse in questo documento fanno riferimento a dispositivi usati in uno specifico ambiente di emulazione. Su tutti i dispositivi menzionati nel documento la configurazione è stata ripristinata ai valori predefiniti. Se la rete è operativa, valutare attentamente eventuali conseguenze derivanti dall'uso dei comandi.

Premesse

La maggior parte degli argomenti trattati in questo documento è applicabile anche alla risoluzione dei problemi dei cluster ASA (Adaptive Security Appliance).

Configurazione

La parte relativa alla configurazione di una distribuzione cluster è illustrata nelle guide alla configurazione di FMC e FXOS:

- Clustering per Firepower Threat Defense

- Implementazione di un cluster per Firepower Threat Defense per la scalabilità e l'alta disponibilità

Nozioni di base sui cluster

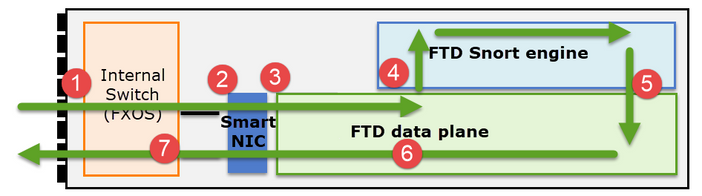

Architettura NGFW

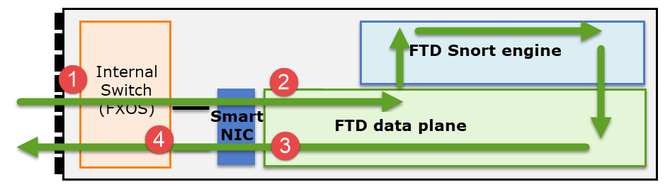

È importante comprendere in che modo Firepower serie 41xx o 93xx gestisce i pacchetti in transito:

- Un pacchetto entra nell'interfaccia in entrata e viene gestito dallo switch interno dello chassis.

- Il pacchetto passa attraverso la Smart NIC. Se il flusso è scaricato (accelerazione hardware), il pacchetto viene gestito esclusivamente dalla Smart NIC e quindi inviato nuovamente alla rete.

- Se il pacchetto non è scaricato, entra nel piano dati FTD che esegue principalmente i controlli L3/L4.

- Se la politica lo richiede, il pacchetto viene ispezionato dal motore Snort (principalmente l'ispezione L7).

- Il motore Snort restituisce un verdetto (ad esempio, allow o block) per il pacchetto.

- Il data plane scarta o inoltra il pacchetto in base al verdetto di Snort.

- Il pacchetto attraversa lo chassis attraverso lo switch interno dello chassis.

Acquisizioni cluster

Le appliance Firepower forniscono più punti di acquisizione che forniscono visibilità sui flussi di transito. Quando si esegue la risoluzione dei problemi e si attivano le acquisizioni cluster, le principali problematiche sono:

- Il numero di acquisizioni aumenta con l'aumentare del numero di unità nel cluster.

- È necessario essere consapevoli del modo in cui il cluster gestisce un flusso specifico per poter tenere traccia del pacchetto attraverso il cluster.

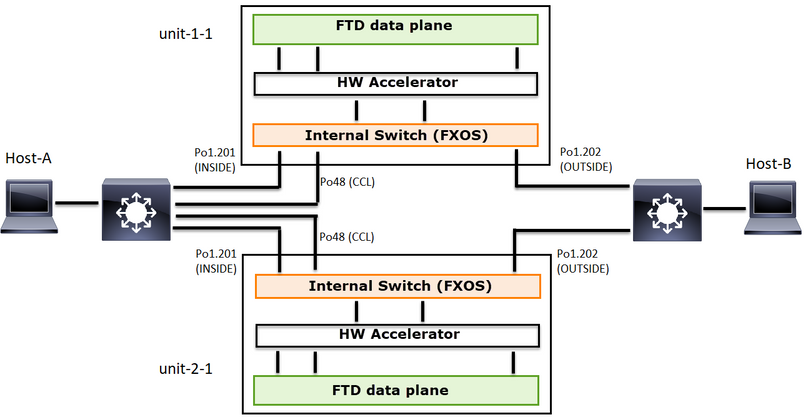

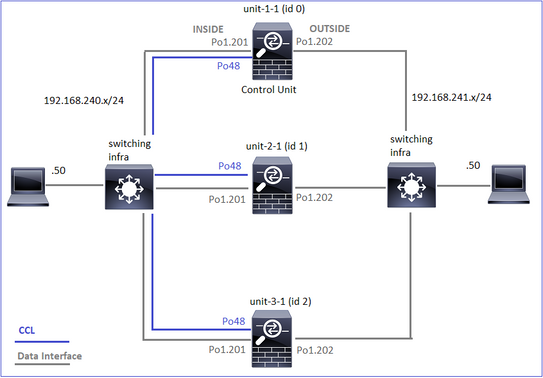

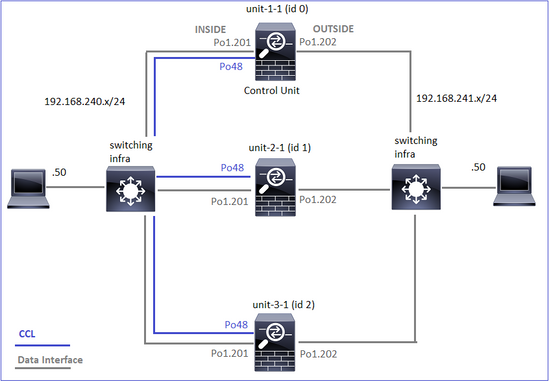

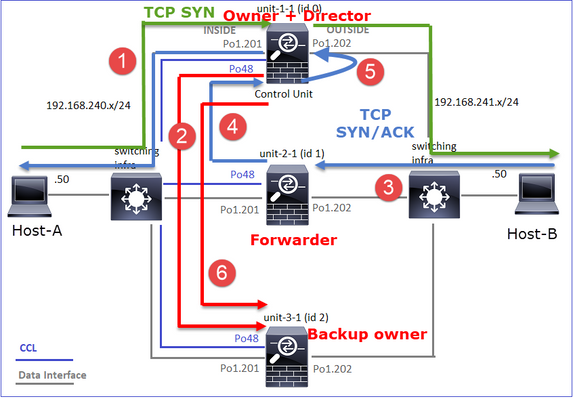

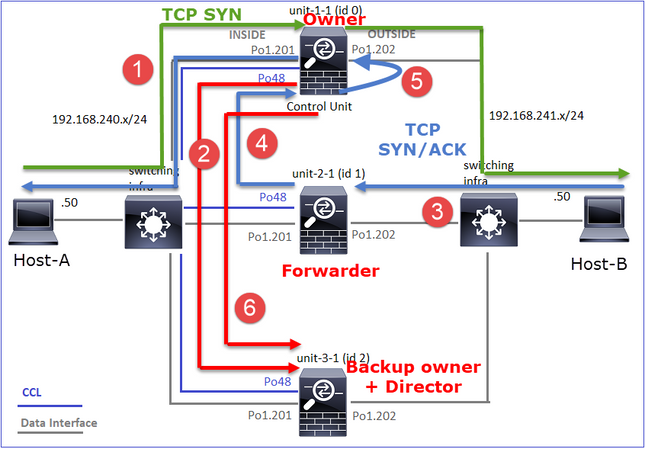

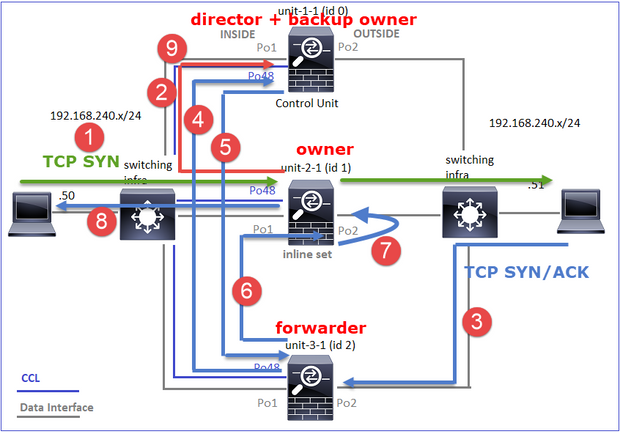

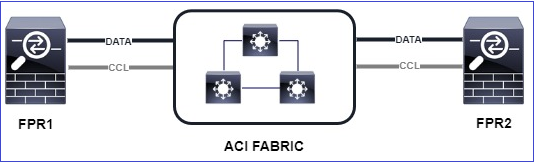

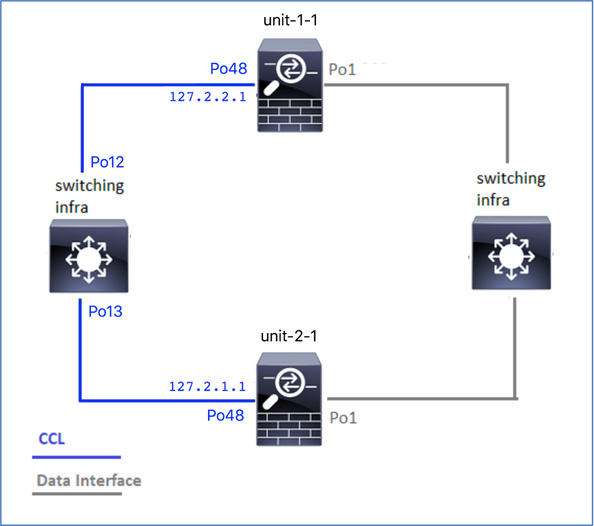

Il diagramma mostra un cluster a 2 unità (ad esempio, FP941xx/FP9300):

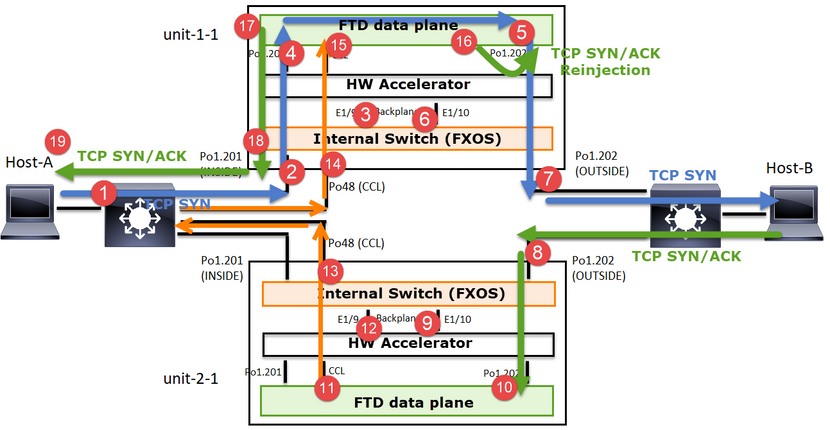

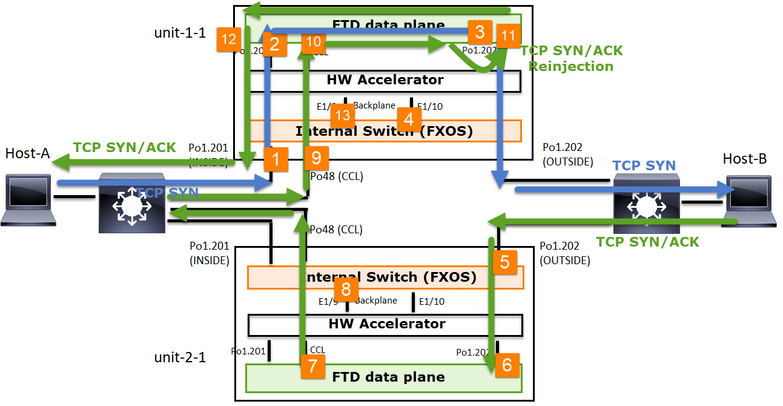

In caso di connessione TCP asimmetrica stabilita, uno scambio SYN, SYN/ACK TCP ha il seguente aspetto:

Inoltra traffico

- TCP SYN viene inviato dall'host A all'host B.

- TCP SYN arriva sullo chassis (uno dei membri di Po1).

- Il TCP SYN viene inviato al piano dati attraverso una delle interfacce backplane dello chassis (ad esempio, E1/9, E1/10, ecc.).

- TCP SYN arriva sull'interfaccia in entrata del piano dati (Po1.201/INSIDE). In questo esempio, l'unità 1-1 assume la proprietà del flusso, esegue la randomizzazione ISN (Initial Sequence Number) e codifica le informazioni sulla proprietà (cookie) nel numero Seq.

- TCP SYN viene inviato fuori da Po1.202/OUTSIDE (interfaccia di uscita del piano dati).

- TCP SYN arriva su una delle interfacce backplane dello chassis (ad esempio, E1/9, E1/10, ecc.).

- TCP SYN viene inviato dall'interfaccia fisica dello chassis (uno dei membri di Po1) verso l'host B.

Traffico di ritorno

- TCP SYN/ACK viene inviato dall'host-B e arriva all'unità-2-1 (uno dei membri di Po1).

- TCP SYN/ACK viene inviato al piano dati attraverso una delle interfacce backplane dello chassis (ad esempio, E1/9, E1/10, ecc.).

- TCP SYN/ACK arriva sull'interfaccia in entrata del data plane (Po1.202/OUTSIDE).

- TCP SYN/ACK viene inviato da Cluster Control Link (CCL) verso l'unità 1-1. Per impostazione predefinita, ISDN è abilitato. Pertanto, il server d'inoltro trova le informazioni sul proprietario per i TCP SYN+ACK senza il coinvolgimento del director. Per altri pacchetti o quando ISDN è disattivato, viene interrogato il director.

- TCP SYN/ACK arriva su una delle interfacce backplane dello chassis (ad esempio, E1/9, E1/10 e così via).

- TCP SYN/ACK viene inviato dall'interfaccia fisica dello chassis (uno dei membri di Po48) all'unità 1-1.

- TCP SYN/ACK arriva sull'unità 1-1 (uno dei membri di Po48).

- TCP SYN/ACK viene inoltrato attraverso una delle interfacce backplane dello chassis all'interfaccia del canale della porta CCL del piano dati (nameif cluster).

- Il piano dati reindirizza il pacchetto TCP SYN/ACK all'interfaccia del piano dati Po1.202/OUTSIDE.

- TCP SYN/ACK viene inviato fuori da Po1.201/INSIDE (data plane exit interface) verso HOST-A.

- Il TCP SYN/ACK attraversa una delle interfacce backplane dello chassis (ad esempio, E1/9, E1/10 e così via) ed egredisce uno dei membri di Po1.

- TCP SYN/ACK arriva sull'host-A.

Per ulteriori informazioni su questo scenario, vedere la sezione correlata in Casi di studio sull'istituzione di connessioni cluster.

In base a questo scambio di pacchetti, tutti i possibili punti di acquisizione del cluster sono:

Per il traffico di inoltro (ad esempio, TCP SYN), acquisire su:

- L'interfaccia fisica dello chassis (ad esempio, membri Po1). Questa acquisizione viene configurata dall'interfaccia utente di Gestione chassis (CM) o dalla CLI di Gestione chassis.

- Interfaccia in entrata del piano dati (ad esempio, Po1.201 INSIDE).

- Interfaccia di uscita del piano dati (ad esempio, Po1.202 OUTSIDE).

- Interfacce backplane chassis. Su FP4100 ci sono 2 interfacce backplane. Su FP9300 sono disponibili 6 (2 per modulo). Poiché non si conosce l'interfaccia a cui il pacchetto arriva, è necessario abilitare l'acquisizione su tutte le interfacce.

Per il traffico di ritorno (ad esempio, TCP SYN/ACK) acquisire su:

- L'interfaccia fisica dello chassis (ad esempio, membri Po1). Questa acquisizione viene configurata dall'interfaccia utente di Gestione chassis (CM) o dalla CLI di Gestione chassis.

- Interfaccia in entrata del piano dati (ad esempio, Po1.202 OUTSIDE).

- Poiché il pacchetto viene reindirizzato, il punto di acquisizione successivo è il CCL del piano dati.

- Interfacce backplane chassis. Anche in questo caso, abilitare l'acquisizione su entrambe le interfacce.

- Interfacce membro CCL dello chassis dell'unità 1-1.

- Interfaccia CCL del piano dati (nome del cluster).

- Interfaccia in ingresso (Po1.202 OUTSIDE). Questo è il pacchetto reiniettato da CCL al piano dati.

- Interfaccia di uscita del piano dati (ad esempio, Po1.201 INSIDE).

- Interfacce backplane chassis.

Come abilitare le acquisizioni del cluster

Acquisizioni FXOS

Il processo è descritto nella guida alla configurazione di FXOS: Acquisizione pacchetti

Nota: Le acquisizioni FXOS possono essere effettuate solo in entrata dal punto di vista dello switch interno.

Acquisizioni di Data Plane

Per abilitare l'acquisizione in tutti i membri del cluster, si consiglia di utilizzare il comando cluster exec.

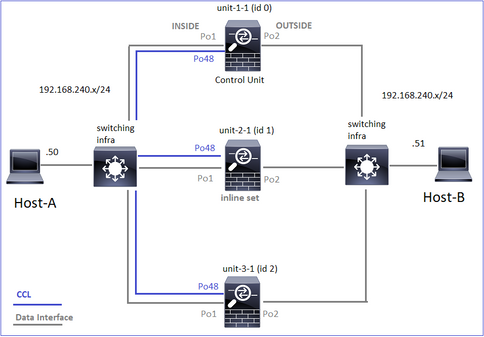

Si consideri un cluster a 3 unità:

Per verificare se sono presenti acquisizioni attive in tutte le unità cluster, utilizzare questo comando:

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Per abilitare l'acquisizione di un piano dati su tutte le unità in Po1.201 (INSIDE):

firepower# cluster exec capture CAPI interface INSIDE

Per aumentare il buffer di acquisizione, si consiglia di specificare un filtro di acquisizione e, nel caso si preveda un traffico elevato:

firepower# cluster exec capture CAPI buffer 33554432 interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Verifica

firepower# cluster exec show capture

unit-1-1(LOCAL):******************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 5140 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 260 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CAPI type raw-data buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Per visualizzare il contenuto di tutte le clip (questo output può essere molto lungo):

firepower# terminal pager 24

firepower# cluster exec show capture CAPI

unit-1-1(LOCAL):******************************************************

21 packets captured

1: 11:33:09.879226 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: S 2225395909:2225395909(0) win 29200 <mss 1460,sackOK,timestamp 1110209649 0,nop,wscale 7>

2: 11:33:09.880401 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45456: S 719653963:719653963(0) ack 2225395910 win 28960 <mss 1380,sackOK,timestamp 1120565119 1110209649,nop,wscale 7>

3: 11:33:09.880691 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: . ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

4: 11:33:09.880783 802.1Q vlan#201 P0 192.168.240.50.45456 > 192.168.241.50.80: P 2225395910:2225396054(144) ack 719653964 win 229 <nop,nop,timestamp 1110209650 1120565119>

unit-2-1:*************************************************************

0 packet captured

0 packet shown

unit-3-1:*************************************************************

0 packet captured

0 packet shown

Acquisisci tracce

Per vedere come vengono gestiti i pacchetti in entrata dal piano dati su ciascuna unità, usare la parola chiave trace. In questo modo si tracciano i primi 50 pacchetti in entrata. È possibile tracciare fino a 1000 pacchetti in entrata.

Nota: Se all'interfaccia sono state applicate più acquisizioni, è possibile tracciare un singolo pacchetto una sola volta.

Per tracciare i primi 1000 pacchetti in entrata sull'interfaccia OUTSIDE su tutte le unità cluster:

firepower# cluster exec cap CAPO int OUTSIDE buff 33554432 trace trace-count 1000 match tcp host 192.168.240.50 host 192.168.241.50 eq www

Una volta acquisito il flusso di interesse, è necessario accertarsi di tracciare i pacchetti di interesse su ciascuna unità. L'importante da ricordare è che un pacchetto specifico può essere #1 sull'unità-1-1, ma #2 su un'altra unità, e così via.

Nell'esempio, si può vedere che il SYN/ACK è il pacchetto n. 2 sull'unità 2-1, ma il pacchetto n. 1 sull'unità 3-1:

firepower# cluster exec show capture CAPO | include S.*ack

unit-1-1(LOCAL):******************************************************

1: 12:58:31.117700 802.1Q vlan#202 P0 192.168.240.50.45468 > 192.168.241.50.80: S 441626016:441626016(0) win 29200 <mss 1380,sackOK,timestamp 1115330849 0,nop,wscale 7>

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Per tracciare il pacchetto 2 (SYN/ACK) sull'unità locale:

firepower# cluster exec show cap CAPO packet-number 2 trace

unit-1-1(LOCAL):******************************************************

2: 12:58:31.118341 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Per tracciare lo stesso pacchetto (SYN/ACK) sull'unità remota:

firepower# cluster exec unit unit-3-1 show cap CAPO packet-number 1 trace

1: 12:58:31.111429 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45468: S 301658077:301658077(0) ack 441626017 win 28960 <mss 1460,sackOK,timestamp 1125686319 1115330849,nop,wscale 7>

Phase: 1

Type: CAPTURE

Subtype:

Result: ALLOW

Config:

Additional Information:

MAC Access list

...

Acquisizione CCL

Per abilitare l'acquisizione sul collegamento CCL (su tutte le unità):

firepower# cluster exec capture CCL interface cluster

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Rifiuta Nascondi

Per impostazione predefinita, un'acquisizione abilitata su un'interfaccia dati del piano dati mostra tutti i pacchetti:

- Quelli che arrivano dalla rete fisica

- Quelli che vengono reiniettati dalla CCL

Se non si desidera visualizzare i pacchetti reiniettati, usare l'opzione reinject-hide. Ciò può essere utile se si desidera verificare se un flusso è asimmetrico:

firepower# cluster exec capture CAPI_RH reinject-hide interface INSIDE match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Questa acquisizione mostra solo ciò che l'unità locale riceve effettivamente sull'interfaccia specifica direttamente dalla rete fisica e non dalle altre unità del cluster.

Cadute ASP

Se si desidera verificare la presenza di perdite software per un flusso specifico, è possibile abilitare l'acquisizione asp-drop. Se non si conosce il motivo della perdita su cui concentrarsi, utilizzare la parola chiave all. Inoltre, se non si è interessati al payload del pacchetto, è possibile specificare la parola chiave headers-only. In questo modo è possibile acquisire un numero di pacchetti da 20 a 30 volte superiore:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

È inoltre possibile specificare gli IP di interesse nell'acquisizione ASP:

firepower# cluster exec cap ASP type asp-drop all buffer 33554432 headers-only match ip host 192.0.2.100 any

Cancella un'acquisizione

Cancellare il buffer di qualsiasi acquisizione eseguita in tutte le unità cluster. In questo modo le acquisizioni non vengono interrotte, ma vengono cancellati solo i buffer:

firepower# cluster exec clear capture /all

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Interrompere un'acquisizione

Esistono due modi per arrestare un'acquisizione attiva su tutte le unità cluster. In seguito sarà possibile riprendere l'attività.

Modo 1

firepower# cluster exec cap CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Per riprendere

firepower# cluster exec no capture CAPI stop

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Modo 2

firepower# cluster exec no capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Per riprendere

firepower# cluster exec capture CAPI interface INSIDE

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Raccogli un'acquisizione

Esistono diversi modi per esportare un'acquisizione.

Modo 1 - A un server remoto

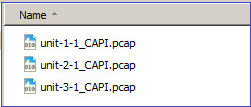

Ciò consente di caricare un'acquisizione dal piano dati su un server remoto (ad esempio, TFTP). I nomi di acquisizione vengono modificati automaticamente per riflettere l'unità di origine:

firepower# cluster exec copy /pcap capture:CAPI tftp://192.168.240.55/CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Address or name of remote host [192.168.240.55]?

Destination filename [CAPI.pcap]?

INFO: Destination filename is changed to unit-1-1_CAPI.pcap !!!!!!!

81 packets copied in 0.40 secs

unit-2-1:*************************************************************

INFO: Destination filename is changed to unit-2-1_CAPI.pcap !

unit-3-1:*************************************************************

INFO: Destination filename is changed to unit-3-1_CAPI.pcap !

I file pcap caricati:

Modo 2 - Recupera le clip dal CCP

Questo metodo è applicabile solo all'FTD. Innanzitutto, copiare l'acquisizione sul disco FTD:

firepower# cluster exec copy /pcap capture:CAPI disk0:CAPI.pcap

unit-1-1(LOCAL):******************************************************

Source capture name [CAPI]?

Destination filename [CAPI.pcap]?

!!!!!

62 packets copied in 0.0 secs

In modalità Expert, copiare il file dalla directory /mnt/disk0/ alla directory /ngfw/var/common/:

> expert

admin@firepower:~$ cd /mnt/disk0

admin@firepower:/mnt/disk0$ sudo cp CAPI.pcap /ngfw/var/common

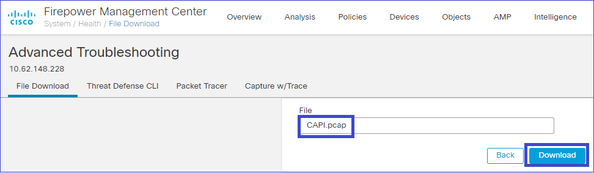

Infine, su FMC passare alla sezione Sistema > Integrità > Monitor. Scegliere Visualizza dettagli di sistema e risoluzione dei problemi > Risoluzione dei problemi avanzata e recuperare il file di acquisizione:

Eliminare un'acquisizione

Per rimuovere un'acquisizione da tutte le unità cluster, utilizzare questo comando:

firepower# cluster exec no capture CAPI

unit-1-1(LOCAL):******************************************************

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Flussi scaricati

Su FP41xx/FP9300 i flussi possono essere scaricati su HW Accelerator in modo statico (ad esempio, le regole Fastpath) o dinamico. Per ulteriori informazioni sull'offload del flusso, consultare questo documento:

Se un flusso viene scaricato, solo pochi pacchetti passano attraverso il piano dati FTD. Il resto viene gestito dall'acceleratore hardware (Smart NIC).

Dal punto di vista dell'acquisizione, ciò significa che se si abilitano solo le acquisizioni a livello di piano dati FTD, non si vedranno tutti i pacchetti che passano attraverso il dispositivo. In questo caso, è necessario abilitare anche le acquisizioni a livello di chassis FXOS.

Messaggi CCL (Cluster Control Link)

Se si esegue un'acquisizione nella CCL, si noterà che le unità del cluster scambiano diversi tipi di messaggi. Le aree di interesse sono:

| Protocollo |

Descrizione |

| UDP 49495 |

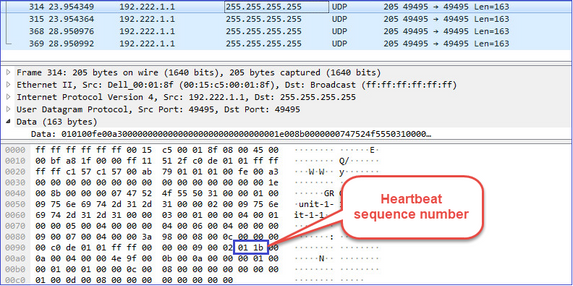

Heartbeat del cluster (keepalive) · Trasmissione L3 (255.255.255.255) · Questi pacchetti vengono inviati da ogni unità cluster a 1/3 del valore del tempo di attesa per il controllo dello stato. · Notare che non tutti i pacchetti UDP 49495 rilevati nell'acquisizione sono heartbeat · Gli heartbeat contengono un numero di sequenza. |

| UDP 4193 |

Messaggi sul percorso dati del protocollo di controllo del cluster · Unicast · Questi pacchetti contengono informazioni (metadati) sul proprietario del flusso, sul director, sul proprietario del backup e così via. Alcuni esempi: · Quando viene creato un nuovo flusso, il proprietario invia un messaggio di aggiunta cluster al director · Quando un flusso viene terminato, il proprietario invia un messaggio di "eliminazione del cluster" al director |

| Pacchetti di dati |

Pacchetti di dati appartenenti ai vari flussi di traffico che attraversano il cluster |

Heartbeat del cluster

Messaggi CCP (Cluster Control Point)

Oltre ai messaggi di heartbeat, sono disponibili numerosi messaggi di controllo del cluster scambiati tramite la CCL in scenari specifici. Alcuni di essi sono messaggi unicast mentre altri sono trasmissioni.

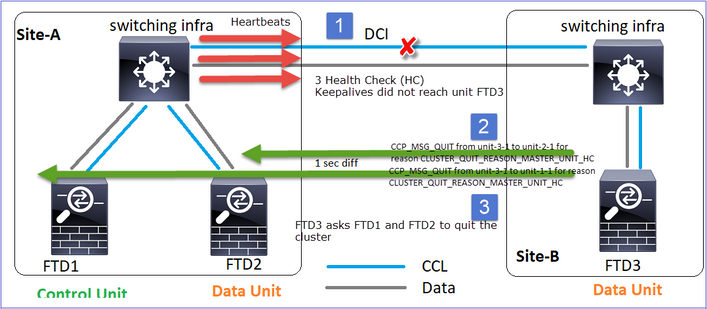

CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Ogni volta che un'unità perde 3 messaggi heartbeat consecutivi dal nodo di controllo, genera un messaggio CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC sul CCL. Questo messaggio:

- È un unicast.

- e viene inviato a ciascuna delle unità con un intervallo di 1 sec.

- Quando un'unità riceve questo messaggio, esce dal cluster (DISABLED) e si unisce nuovamente.

D. Qual è lo scopo di CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC?

A. Dal punto di vista dell'unità-3-1 (Sito-B), perde la connessione sia all'unità-1-1 che all'unità-2-1 dal sito A, quindi deve rimuoverli dal suo elenco dei membri il prima possibile, altrimenti può perdere il pacchetto se l'unità-2-1 è ancora nel suo elenco dei membri e l'unità-2-1 si presenta come il direttore di una connessione, e la query del flusso all'unità-2-1 non riesce.

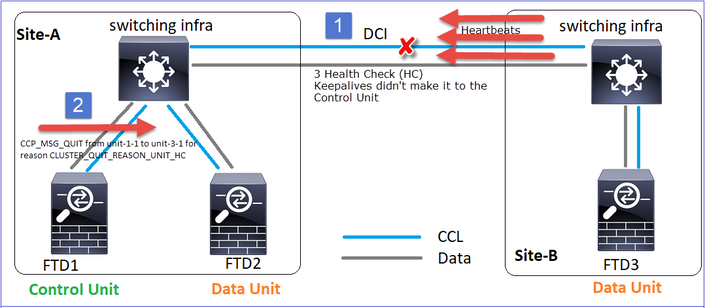

CLUSTER_QUIT_REASON_UNIT_HC

Ogni volta che il nodo di controllo perde 3 messaggi heartbeat consecutivi da un nodo di dati, invia il messaggio CLUSTER_QUIT_REASON_UNIT_HC sulla CCL. Questo messaggio è unicast.

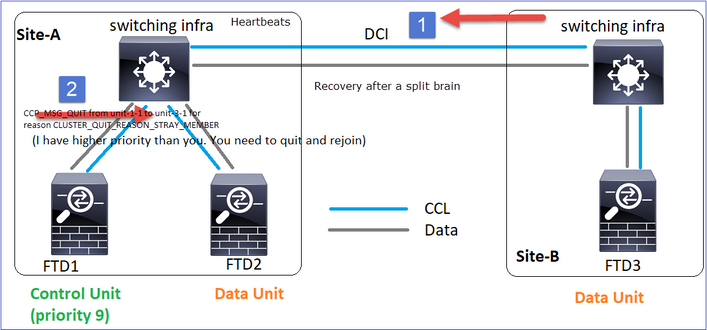

CLUSTER_QUIT_REASON_STRAY_MEMBER

Quando una partizione divisa si riconnette con una partizione peer, il nuovo nodo di dati viene trattato come membro isolato dall'unità di controllo dominante e riceve un messaggio di uscita CCP con il motivo CLUSTER_QUIT_REASON_STRAY_MEMBER.

CLUSTER_QUIT_MEMBER_DROP

Messaggio broadcast generato da un nodo dati e inviato come broadcast. Quando un apparecchio riceve questo messaggio, passa allo stato DISABLED. Inoltre, l'auto-rejoin non decolla:

firepower# show cluster info trace | include DROPOUT

Nov 04 00:22:54.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:22:53.699 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

La cronologia del cluster mostra quanto segue:

PRIMARY DISABLED Received control message DISABLE (member dropout announcement)

Meccanismo di verifica dello stato del cluster (HC)

Considerazioni principali

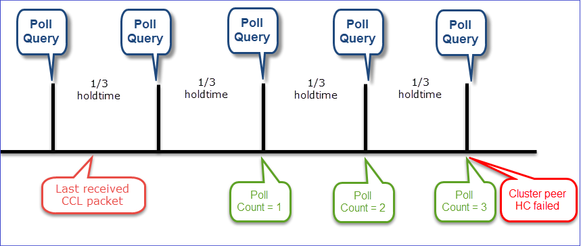

- Ogni unità cluster invia un heartbeat ogni 1/3 del valore del tempo di attesa per il controllo dello stato a tutte le altre unità (broadcast 255.255.255.255) e utilizza la porta UDP 49495 come trasporto sul CCL.

- Ogni unità cluster tiene traccia in modo indipendente di ogni altra unità con un timer di polling e un valore di conteggio polling.

- Se un'unità cluster non riceve alcun pacchetto (heartbeat o pacchetto dati) da un'unità peer del cluster entro un intervallo di heartbeat, aumenta il valore del conteggio polling.

- Quando il valore del conteggio di polling per un'unità peer del cluster diventa 3, il peer viene considerato inattivo.

- Ogni volta che si riceve un heartbeat, viene controllato il relativo numero di sequenza e nel caso in cui la differenza con l'heartbeat ricevuto in precedenza sia diversa da 1, il contatore di rilascio dell'heartbeat aumenta di conseguenza.

- Se il contatore Conteggio polling per un peer del cluster è diverso da 0 e il peer riceve un pacchetto, il contatore viene reimpostato su 0.

Utilizzare questo comando per controllare i contatori di integrità del cluster:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 650| 0| 4999| 1| 0|

| unit-3-1 ( 2)| 650| 0| 4999| 1| 0|

----------------------------------------------------------------------------------

Descrizione delle colonne principali

| Colonna |

Descrizione |

| Unità (ID) |

ID del peer del cluster remoto. |

| Conteggio heartbeat |

Numero di heartbeat ricevuti dal peer remoto tramite CCL. |

| Cadute di heartbeat |

Numero di heartbeat mancati. Questo contatore viene calcolato in base al numero di sequenza di heartbeat ricevuto. |

| Distanza media |

Intervallo di tempo medio degli heartbeat ricevuti. |

| Conteggio sondaggi |

Quando questo contatore diventa 3, l'unità viene rimossa dal cluster. L'intervallo di query di polling è uguale all'intervallo di heartbeat, ma viene eseguito in modo indipendente. |

Per reimpostare i contatori, utilizzare questo comando:

firepower# clear cluster info health details

D. Come verificare la frequenza del battito cardiaco?

A. Controllare il valore medio dell'intervallo:

firepower# show cluster info health details

----------------------------------------------------------------------------------

| Unit (ID)| Heartbeat| Heartbeat| Average| Maximum| Poll|

| | count| drops| gap (ms)| slip (ms)| count|

----------------------------------------------------------------------------------

| unit-2-1 ( 1)| 3036| 0| 999| 1| 0|

----------------------------------------------------------------------------------

D. Come è possibile modificare il tempo di attesa del cluster su FTD?

A. Uso di FlexConfig

D. Chi diventa il nodo di controllo dopo uno split-brain?

A. L'unità con la priorità più alta (numero più basso):

firepower# show run cluster | include priority

priority 9

Per ulteriori informazioni, vedere lo scenario di errore 1 relativo alla conversione del tipo di dati.

Visualizzazione del meccanismo HC del cluster

Timer indicativi: Il valore minimo e il valore massimo dipendono dall'ultimo arrivo del pacchetto CCL ricevuto.

| Tempo di attesa |

Verifica query di polling (frequenza) |

Tempo di rilevamento minimo |

Tempo di rilevamento massimo |

| 3 sec (impostazione predefinita) |

Circa 1 sec |

~3,01 sec |

~3,99 sec |

| 4 sec. |

~1,33 sec |

~4,01 sec |

Circa 5,32 sec |

| 5 sec. |

~1,66 sec |

Circa 5,01 sec |

~6,65 sec |

| 6 sec. |

Circa 2 sec |

~6,01 sec |

~7,99 sec |

| 7 sec. |

~2,33 sec |

Circa 7,01 sec |

~9,32 sec |

| 8 sec |

~2,66 sec |

Circa 8,01 sec |

Circa 10,65 sec |

Scenari di errore HC del cluster

Gli obiettivi di questa sezione sono illustrare:

- Diversi scenari di errore HC del cluster.

- Correlazione tra i diversi log e output di comando.

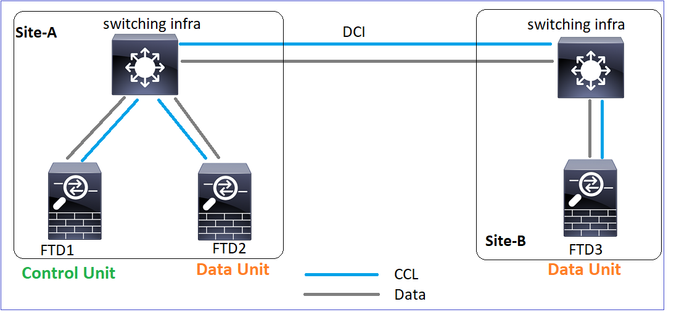

Topologia

Configurazione cluster

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

cluster group GROUP1 |

cluster group GROUP1 |

cluster group GROUP1 |

Stato cluster

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

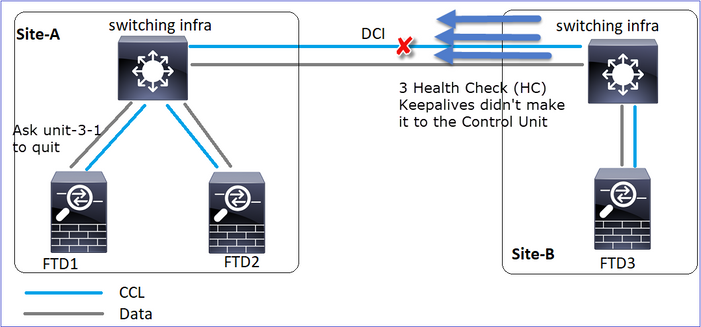

Scenario 1

Perdita di comunicazione CCL per circa 4+ sec in entrambe le direzioni.

Prima dell'errore

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo di controllo |

Nodo dati |

Nodo dati |

Dopo il ripristino (nessuna modifica nei ruoli delle unità)

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo di controllo |

Nodo dati |

Nodo dati |

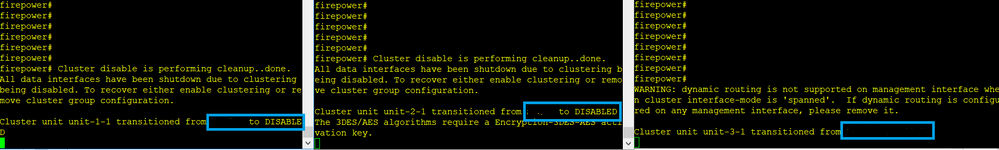

Analisi

Errore (comunicazione CCL persa).

Messaggio della console del piano dati sull'unità 3-1:

firepower#

WARNING: dynamic routing is not supported on management interface when cluster interface-mode is 'spanned'.

If dynamic routing is configured on any management interface, please remove it.

Cluster unit unit-3-1 transitioned from SECONDARY to PRIMARY

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled.

To recover either enable clustering or remove cluster group configuration.

Registri di traccia cluster unità 1-1:

firepower# show cluster info trace | include unit-3-1

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8918307fb 0x000055a8917fc6e8 0x000055a8917f79b5

Nov 02 09:38:14.239 [INFO]FTD - CD proxy received state notification (DISABLED) from unit unit-3-1

Nov 02 09:38:14.239 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 02 09:38:14.239 [INFO]Notify chassis de-bundle port for blade unit-3-1, stack 0x000055a8917eb596 0x000055a8917f4838 0x000055a891abef9d

Nov 02 09:38:14.239 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Nov 02 09:38:14.239 [CRIT]Received heartbeat event 'SECONDARY heartbeat failure' for member unit-3-1 (ID: 1).

Spaccato

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

firepower# show cluster info |

firepower# show cluster info |

firepower# show cluster info |

Cronologia cluster

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

| Nessun evento |

Nessun evento |

09:38:16 UTC Nov 2 2020 |

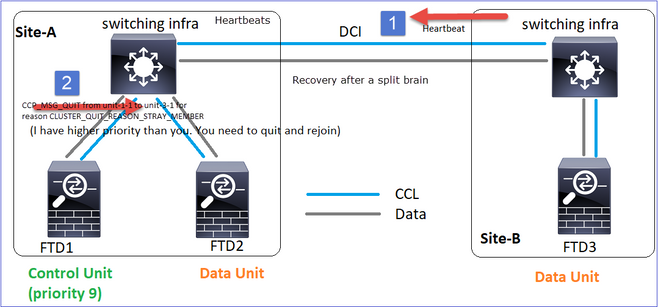

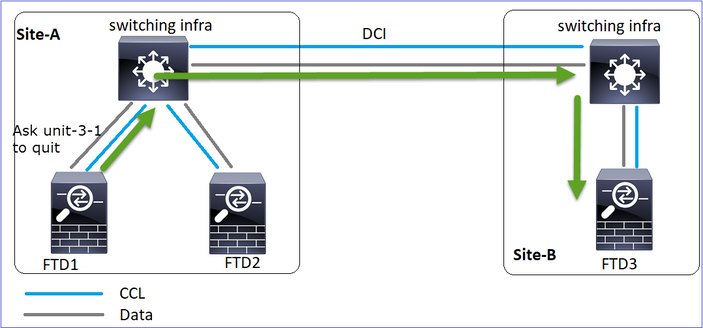

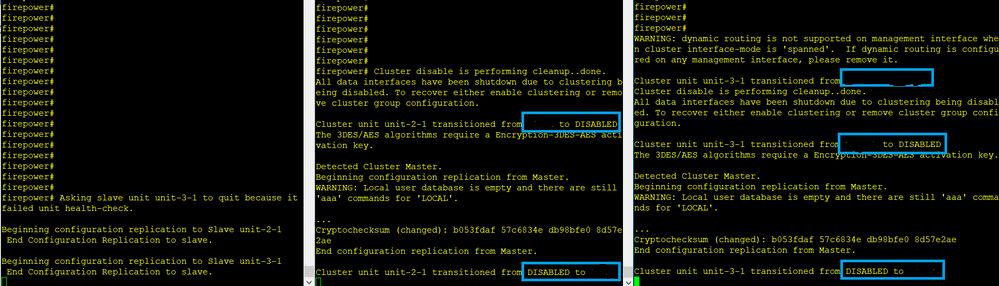

Ripristino comunicazioni CCL

L'unità 1-1 rileva il nodo di controllo corrente e, poiché l'unità 1-1 ha priorità più alta, invia all'unità 3-1 un messaggio CLUSTER_QUIT_REASON_STRAY_MEMBER per attivare un nuovo processo di selezione. Alla fine, unit-3-1 si ricongiunge come nodo dati.

Quando una partizione divisa si riconnette con una partizione peer, il nodo di dati viene trattato come membro isolato dal nodo di controllo dominante e riceve un messaggio di uscita CCP con un motivo di CLUSTER_QUIT_REASON_STRAY_MEMBER.

Unit-3-1 console logs show:

Cluster unit unit-3-1 transitioned from PRIMARY to DISABLED

The 3DES/AES algorithms require a Encryption-3DES-AES activation key.

Detected Cluster Primart.

Beginning configuration replication from Primary.

WARNING: Local user database is empty and there are still 'aaa' commands for 'LOCAL'.

..

Cryptochecksum (changed): a9ed686f 8e2e689c 2553a104 7a2bd33a

End configuration replication from Primary.

Cluster unit unit-3-1 transitioned from DISABLED to SECONDARY

Entrambe le unità (unità-1-1 e unità-3-1) vengono visualizzate nei relativi registri cluster:

firepower# show cluster info trace | include retain

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 21:20:23.019 [CRIT]Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Esistono anche messaggi syslog generati per lo split-brain:

firepower# show log | include 747016

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Nov 03 2020 21:20:23: %FTD-4-747016: Clustering: Found a split cluster with both unit-1-1 and unit-3-1 as primary units. Primary role retained by unit-1-1, unit-3-1 will leave then join as a secondary

Cronologia cluster

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

| Nessun evento |

Nessun evento |

09:47:33 UTC Nov 2 2020 |

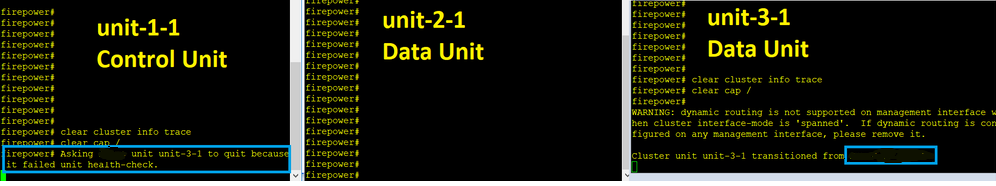

Scenario 2

Perdita di comunicazione CCL per circa 3-4 sec in entrambe le direzioni.

Prima dell'errore

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo di controllo |

Nodo dati |

Nodo dati |

Dopo il ripristino (nessuna modifica nei ruoli delle unità)

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo di controllo |

Nodo dati |

Nodo dati |

Analisi

Evento 1 Il nodo di controllo perde 3 HC dall'unità 3-1 e invia un messaggio all'unità 3-1 per lasciare il cluster.

Evento 2 La CCL si è ripresa molto velocemente e il messaggio CLUSTER_QUIT_REASON_STRAY_MEMBER dal nodo di controllo è arrivato sul lato remoto. L'unità 3-1 passa direttamente alla modalità DISABLED e non è presente la funzione split-brain

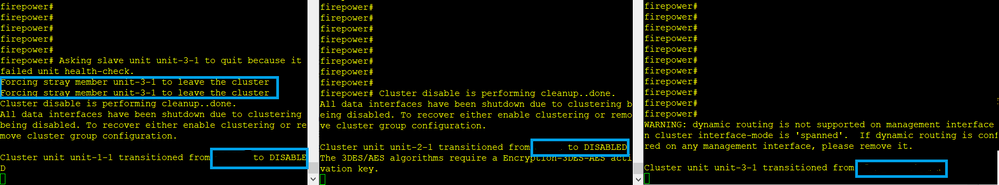

Nell'unità 1-1 (controllo) è possibile vedere:

firepower#

Asking SECONDARY unit unit-3-1 to quit because it failed unit health-check.

Forcing stray member unit-3-1 to leave the cluster

Nell'unità 3-1 (nodo dati) vengono visualizzati:

firepower#

Cluster disable is performing cleanup..done.

All data interfaces have been shutdown due to clustering being disabled. To recover either enable clustering or remove cluster group configuration.

Cluster unit unit-3-1 transitioned from SECONDARY to DISABLED

L'unità cluster 3-1 è passata a uno stato DISABLED e, una volta ripristinata la comunicazione CCL, viene nuovamente aggiunta come nodo dati:

firepower# show cluster history

20:58:40 UTC Nov 1 2020

SECONDARY DISABLED Received control message DISABLE (stray member)

20:58:45 UTC Nov 1 2020

DISABLED ELECTION Enabled from CLI

20:58:45 UTC Nov 1 2020

ELECTION SECONDARY_COLD Received cluster control message

20:58:45 UTC Nov 1 2020

SECONDARY_COLD SECONDARY_APP_SYNC Client progression done

20:59:33 UTC Nov 1 2020

SECONDARY_APP_SYNC SECONDARY_CONFIG SECONDARY application configuration sync done

20:59:44 UTC Nov 1 2020

SECONDARY_CONFIG SECONDARY_FILESYS Configuration replication finished

20:59:45 UTC Nov 1 2020

SECONDARY_FILESYS SECONDARY_BULK_SYNC Client progression done

21:00:09 UTC Nov 1 2020

SECONDARY_BULK_SYNC SECONDARY Client progression done

Scenario 3

Perdita di comunicazione CCL per circa 3-4 sec in entrambe le direzioni.

Prima del fallimento.

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo di controllo |

Nodo dati |

Nodo dati |

Dopo il ripristino (il nodo di controllo è stato modificato).

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo dati |

Nodo di controllo |

Nodo dati |

Analisi

- CCL si abbassa.

- L'unità 1-1 non riceve messaggi 3 HC dall'unità 3-1 e invia un messaggio QUIT all'unità 3-1. Questo messaggio non raggiunge mai l'unità 3-1.

- L'unità 3-1 invia un messaggio QUIT all'unità 2-1. Questo messaggio non raggiunge mai l'unità 2-1.

Recupero CCL.

- L'unità-1-1 vede che l'unità-3-1 si è annunciata come nodo di controllo e invia il messaggio QUIT_REASON_STRAY_MEMBER all'unità-3-1. Quando l'unità-3-1 ottiene questo messaggio passa allo stato DISABLED. Allo stesso tempo, l'unità 3-1 invia un messaggio QUIT_REASON_PRIMARY_UNIT_HC all'unità 1-1 e gli chiede di uscire. Una volta che l'unità 1-1 riceve questo messaggio, passa allo stato DISABLED.

Cronologia cluster

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

19:53:09 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

19:53:06 UTC Nov 2 2020 |

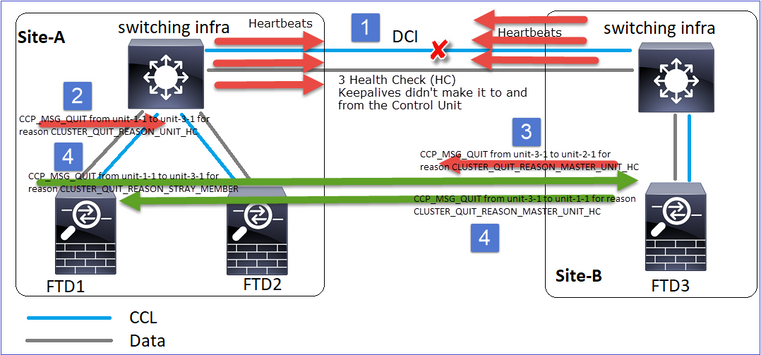

Scenario 4

Perdita di comunicazione CCL per circa 3-4 sec

Prima dell'errore

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo di controllo |

Nodo dati |

Nodo dati |

Dopo il ripristino (il nodo di controllo ha modificato i siti)

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo dati |

Nodo dati |

Nodo di controllo |

Analisi

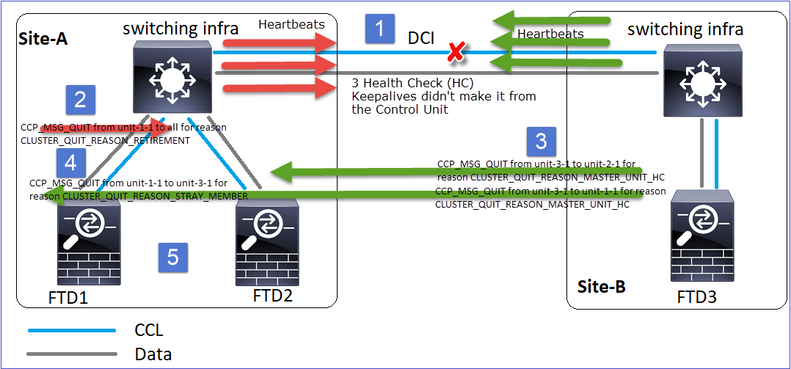

Il fallimento

Un gusto diverso dello stesso errore. In questo caso, l'unità-1-1 non ha ricevuto messaggi 3 HC dall'unità-3-1, e una volta che ha ricevuto un nuovo keepalive, ha cercato di buttare fuori l'unità-3-1 con l'uso di un messaggio STRAY, ma il messaggio non è mai arrivato all'unità-3-1:

- CCL diventa unidirezionale per alcuni secondi. L'unità 3-1 non riceve messaggi 3 HC dall'unità 1-1 e diventa un nodo di controllo.

- L'unità 2-1 invia un messaggio CLUSTER_QUIT_REASON_RETIREMENT (broadcast).

- L'unità 3-1 invia un messaggio QUIT_REASON_PRIMARY_UNIT_HC all'unità 2-1. L'unità 2-1 lo riceve e chiude il cluster.

- L'unità 3-1 invia un messaggio QUIT_REASON_PRIMARY_UNIT_HC all'unità 1-1. L'unità 1-1 lo riceve e chiude il cluster. Recupero CCL.

- Le unità 1-1 e 2-1 si uniscono nuovamente al cluster come nodi di dati.

Nota: Se nel passo 5 la CCL non si riprende, nel sito A l'FTD1 diventa il nuovo nodo di controllo e, dopo il recupero della CCL, vince la nuova scelta.

Messaggi syslog sull'unità 1-1:

firepower# show log | include 747

Nov 03 2020 23:13:08: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-3-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:09: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-4-747015: Clustering: Forcing stray member unit-3-1 to leave the cluster

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY to DISABLED

Nov 03 2020 23:13:12: %FTD-7-747006: Clustering: State machine is at state DISABLED

Nov 03 2020 23:13:12: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MY_STATE (state DISABLED,0x0000000000000000,0x0000000000000000)

Nov 03 2020 23:13:18: %FTD-6-747004: Clustering: State machine changed from state ELECTION to ONCALL

Log di traccia del cluster sull'unità 1-1:

firepower# show cluster info trace | include QUIT

Nov 03 23:13:10.789 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:10.769 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-1-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 03 23:13:10.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:09.789 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 03 23:13:09.769 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_STRAY_MEMBER

Nov 03 23:13:08.559 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 03 23:13:08.559 [DBUG]Send CCP message to id 1: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Messaggi syslog sull'unità 3-1:

firepower# show log | include 747

Nov 03 2020 23:13:09: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-2-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-7-747005: Clustering: State machine notify event CLUSTER_EVENT_MEMBER_STATE (unit-1-1,DISABLED,0x0000000000000000)

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state SECONDARY to PRIMARY

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_FAST to PRIMARY_DRAIN

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_DRAIN to PRIMARY_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_CONFIG to PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY_POST_CONFIG

Nov 03 2020 23:13:10: %FTD-6-747004: Clustering: State machine changed from state PRIMARY_POST_CONFIG to PRIMARY

Nov 03 2020 23:13:10: %FTD-7-747006: Clustering: State machine is at state PRIMARY

Cronologia cluster

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

23:13:13 UTC Nov 3 2020 |

23:13:12 UTC Nov 3 2020 |

23:13:10 UTC Nov 3 2020 |

Scenario 5

Prima dell'errore

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo di controllo |

Nodo dati |

Nodo dati |

Dopo il ripristino (nessuna modifica)

| FTD1 |

FTD2 |

FTD3 |

| Sito-A |

Sito-A |

Sito-B |

| Nodo di controllo |

Nodo dati |

Nodo dati |

Il fallimento

L'unità 3-1 ha inviato messaggi QUIT sia all'unità 1-1 che all'unità 2-1, ma, a causa di problemi di connettività, solo l'unità 2-1 ha ricevuto il messaggio QUIT.

Registri di traccia cluster unità 1-1:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.429 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.059 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:45.429 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Nov 04 00:51:45.429 [DBUG]Send CCP message to unit-3-1(1): CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_REASON_UNIT_HC

Registri di traccia cluster unità 2-1:

firepower# show cluster info trace | include QUIT

Nov 04 00:52:10.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:47.019 [DBUG]Send CCP message to all: CCP_MSG_QUIT from unit-2-1 for reason CLUSTER_QUIT_REASON_RETIREMENT

Nov 04 00:51:46.999 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-3-1 to unit-2-1 for reason CLUSTER_QUIT_REASON_PRIMARY_UNIT_HC

Nov 04 00:51:45.389 [DBUG]Receive CCP message: CCP_MSG_QUIT from unit-1-1 to unit-3-1 for reason CLUSTER_QUIT_MEMBER_DROPOUT

Cronologia cluster

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

| Nessun evento |

00:51:50 UTC Nov 4 2020 |

00:51:47 UTC Nov 4 2020 |

Installazione connessione Data Plane cluster

Punti di acquisizione NGFW

NGFW fornisce funzionalità di acquisizione su questi punti:

- Switch interno per chassis (FXOS)

- motore del piano dati FTD

- FTD Motore Snort

Quando si risolvono i problemi relativi ai percorsi dati in un cluster, nella maggior parte dei casi vengono utilizzati i punti di acquisizione acquisiti dal motore del piano dati FXOS e FTD.

- Acquisizione FXOS in entrata sull'interfaccia fisica

- Acquisizione in ingresso FTD nel motore del piano dati

- Acquisizione in uscita FTD nel motore del piano dati

- Acquisizione in entrata FXOS sull'interfaccia del backplane

Per ulteriori informazioni sulle acquisizioni NGFW, consultare questo documento:

Nozioni di base sui ruoli del flusso di unità del cluster

Le connessioni possono essere stabilite tramite un cluster in diversi modi, a seconda di fattori quali:

- Tipo di traffico (TCP, UDP, ecc.)

- Algoritmo di bilanciamento del carico configurato sullo switch adiacente

- Funzionalità configurate sul firewall

- Condizioni di rete (ad esempio, frammentazione IP, ritardi della rete e così via)

| Ruolo Flusso |

Descrizione |

Contrassegno/i |

| Proprietario |

In genere, l'unità che riceve inizialmente la connessione |

UIO |

| Direttore |

Unità che gestisce le richieste di ricerca del proprietario dai server d'inoltro. |

Y |

| Proprietario backup |

Finché il director non è la stessa unità del proprietario, il director è anche il proprietario del backup. Se il proprietario sceglie se stesso come director, viene scelto un proprietario di backup separato. |

Y (se la directory è anche il proprietario del backup) y (se la directory non è il proprietario del backup) |

| Inoltro |

Unità che inoltra i pacchetti al proprietario |

z |

| Proprietario frammento |

Unità che gestisce il traffico frammentato |

- |

| Backup dello chassis |

In un cluster tra chassis, quando i flussi di director/backup e proprietari sono di proprietà delle unità dello stesso chassis, un'unità in uno degli altri chassis diventa un backup/director secondario. Questo ruolo è specifico per i cluster tra chassis di Firepower serie 9300 con più di un blade. |

s |

- Per ulteriori informazioni, consultare la sezione correlata nella Guida alla configurazione (vedere i collegamenti nelle Informazioni correlate)

- In scenari specifici (vedere la sezione studi di casi) alcuni flag non sono sempre visualizzati.

Casi aziendali relativi all'istituzione di connessioni cluster

Nella sezione successiva vengono illustrati vari casi aziendali che dimostrano alcuni dei modi in cui è possibile stabilire una connessione tramite un cluster. Gli obiettivi sono i seguenti:

- Acquisire familiarità con i diversi ruoli delle unità.

- Dimostrare come è possibile correlare i vari output del comando.

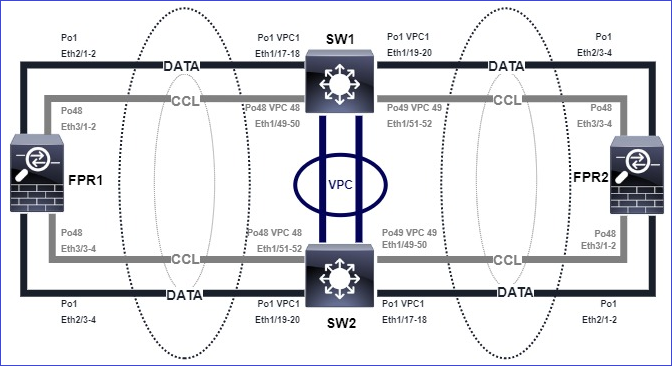

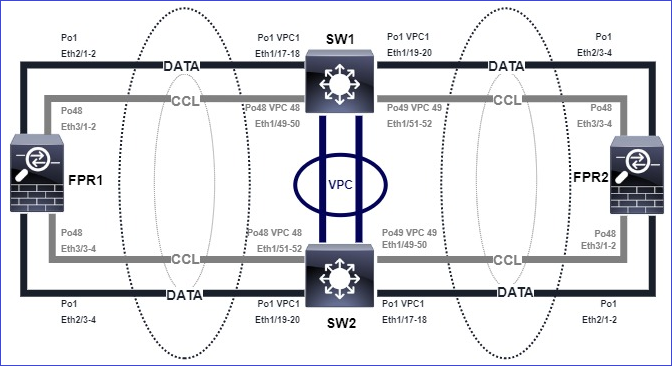

Topologia

ID e unità cluster:

| Unità-1-1 |

Unità-2-1 |

Unità-3-1 |

Cluster GROUP1: On |

Unit "unit-2-1" in state SECONDARY |

Unit "unit-3-1" in state SECONDARY |

Acquisizioni cluster abilitate:

cluster exec cap CAPI int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPI_RH reinject-hide int INSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CAPO_RH reinject-hide int OUTSIDE buffer 33554432 match tcp host 192.168.240.50 host 192.168.241.50 eq 80

cluster exec cap CCL int cluster buffer 33554432

Nota: Questi test sono stati eseguiti in un ambiente lab con traffico minimo attraverso il cluster. Nella produzione, cercare di usare filtri di acquisizione il più possibile specifici (ad esempio, la porta di destinazione e, quando possibile, la porta di origine) per ridurre al minimo il "rumore" nelle riprese.

Caso di studio 1. Traffico simmetrico (il proprietario è anche il direttore)

Osservazione 1. Le clip reject-hide mostrano i pacchetti solo sull'unità 1-1. Ciò significa che il flusso in entrambe le direzioni ha attraversato l'unità 1-1 (traffico simmetrico):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data interface cluster [Capturing - 33513 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Buffer Full - 33553914 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-2-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 23245 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

unit-3-1:*************************************************************

capture CCL type raw-data interface cluster [Capturing - 24815 bytes]

capture CAPI type raw-data buffer 33554432 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO type raw-data buffer 33554432 trace interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPI_RH type raw-data reinject-hide buffer 33554432 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

capture CAPO_RH type raw-data reinject-hide buffer 33554432 interface OUTSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq 80

Osservazione 2. Analisi del flag di connessione per il flusso con porta di origine 45954

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

22 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 2 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:00, bytes 487413076, flags UIO N1

unit-2-1:*************************************************************

22 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 1 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 2 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:443 NP Identity Ifc 192.168.240.50:39698, idle 0:00:23, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:45954, idle 0:00:06, bytes 0, flags y

| Unità |

Contrassegna |

Nota |

| Unità-1-1 |

UIO |

· Proprietario flusso: l'unità gestisce il flusso · Direttore - Poiché l'unità 3-1 ha "y" e non "Y", ciò implica che l'unità 1-1 è stata scelta come direttore per questo flusso. Pertanto, poiché è anche il proprietario, un'altra unità (in questo caso l'unità 3-1) è stata scelta come proprietario del backup |

| Unità-2-1 |

- |

- |

| Unità-3-1 |

y |

L'unità è proprietaria di un backup |

Ciò può essere visualizzato come:

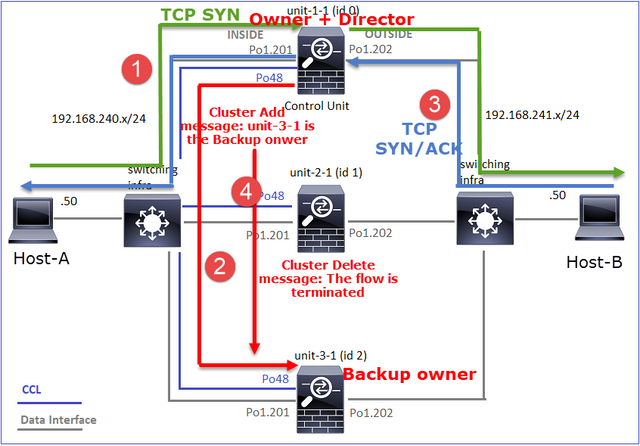

- Il pacchetto TCP SYN arriva dall'host A all'unità 1 1. L'unità 1 1 diventa il proprietario del flusso.

- Anche l'unità 1-1 viene selezionata come director di flusso. Pertanto, seleziona anche l'unità 3-1 come proprietario del backup (messaggio di aggiunta cluster).

- Il pacchetto TCP SYN/ACK arriva dall'host-B all'unità-3-1. Il flusso è simmetrico.

- Una volta terminata la connessione, il proprietario invia un messaggio di eliminazione del cluster per rimuovere le informazioni sul flusso dal proprietario del backup.

Osservazione 3. La cattura con traccia indica che entrambe le direzioni attraversano solo l'unità 1-1.

Passaggio 1. Identificare il flusso e i pacchetti di interesse in tutte le unità cluster in base alla porta di origine:

firepower# cluster exec show capture CAPI | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363521 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.45954: S 4042762409:4042762409(0) ack 992089270 win 28960 <mss 1380,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363827 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 4042762410 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower# cluster exec show capture CAPO | i 45954

unit-1-1(LOCAL):******************************************************

1: 08:42:09.362987 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: S 2732339016:2732339016(0) win 29200 <mss 1380,sackOK,timestamp 495153655 0,nop,wscale 7>

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

3: 08:42:09.363903 802.1Q vlan#202 P0 192.168.240.50.45954 > 192.168.241.50.80: . ack 3603655983 win 229 <nop,nop,timestamp 495153657 505509125>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Passaggio 2. Poiché si tratta di una traccia di flusso TCP, i pacchetti di handshake a 3 vie. Come si può vedere in questo output, l'unità-1-1 è il proprietario. Per semplicità, le fasi di analisi non pertinenti sono omesse:

firepower# show cap CAPI packet-number 1 trace

25985 packets captured

1: 08:42:09.362697 802.1Q vlan#201 P0 192.168.240.50.45954 > 192.168.241.50.80: S 992089269:992089269(0) win 29200 <mss 1460,sackOK,timestamp 495153655 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

...

Traffico di ritorno (TCP SYN/ACK):

firepower# show capture CAPO packet-number 2 trace

25985 packets captured

2: 08:42:09.363415 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.45954: S 3603655982:3603655982(0) ack 2732339017 win 28960 <mss 1460,sackOK,timestamp 505509125 495153655,nop,wscale 7>

...

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9364, using existing flow

Osservazione 4. I syslog del piano dati FTD mostrano la creazione e la terminazione della connessione su tutte le unità:

firepower# cluster exec show log | include 45954

unit-1-1(LOCAL):******************************************************

Dec 01 2020 08:42:09: %FTD-6-302013: Built inbound TCP connection 9364 for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302014: Teardown TCP connection 9364 for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 08:42:09: %FTD-6-302022: Built backup stub TCP connection for INSIDE:192.168.240.50/45954 (192.168.240.50/45954) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 08:42:18: %FTD-6-302023: Teardown backup TCP connection for INSIDE:192.168.240.50/45954 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

Caso di studio 2. Traffico simmetrico (proprietario diverso dal director)

- Come il caso di studio n. 1, ma in questo caso di studio il proprietario di un flusso è un'unità diversa da quella del direttore.

- Tutti i risultati sono simili al caso di studio n. 1. La differenza principale rispetto al caso di studio n. 1 è il flag "Y" che sostituisce il flag "y" dello scenario 1.

Osservazione 1. Il proprietario è diverso dal direttore.

Analisi del flag di connessione per il flusso con la porta di origine 46278.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:00, bytes 508848268, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46276, idle 0:00:03, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 0 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 1 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 NP Identity Ifc 192.168.240.50:46276, idle 0:00:02, bytes 0, flags z

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46278, idle 0:00:06, bytes 0, flags Y

| Unità |

Contrassegna |

Nota |

| Unità-1-1 |

UIO |

· Proprietario flusso: l'unità gestisce il flusso |

| Unità-2-1 |

- |

- |

| Unità-3-1 |

Y |

· Direttore e proprietario del backup - Unità 3-1 ha il flag Y (Direttore). |

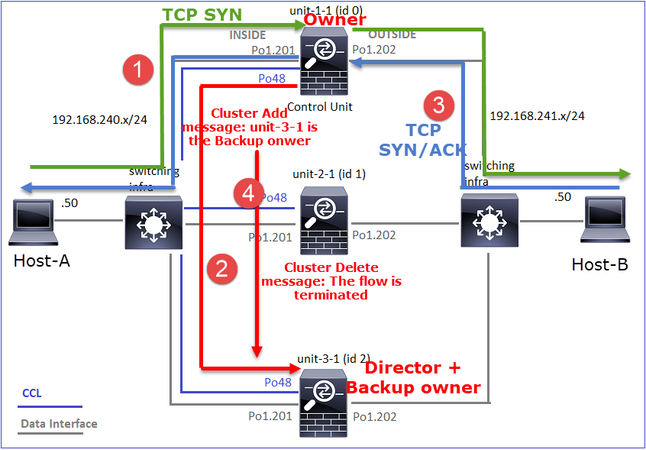

Ciò può essere visualizzato come:

- Il pacchetto TCP SYN arriva dall'host A all'unità 1 1. L'unità 1 1 diventa il proprietario del flusso.

- L'unità 3-1 viene selezionata come director di flusso. L'unità 3-1 è anche il proprietario del backup (messaggio "cluster add" su UDP 4193 su CCL).

- Il pacchetto TCP SYN/ACK arriva dall'host-B all'unità-3-1. Il flusso è simmetrico.

- Una volta terminata la connessione, il proprietario invia al CCL un messaggio di eliminazione del cluster su UDP 4193 per rimuovere le informazioni sul flusso dal proprietario del backup.

Osservazione 2. La cattura con traccia indica che entrambe le direzioni attraversano solo l'unità 1-1

Passaggio 1. Utilizzare lo stesso approccio utilizzato nello studio di applicazione 1 per identificare il flusso e i pacchetti di interesse in tutte le unità cluster in base alla porta di origine:

firepower# cluster exec show cap CAPI | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842317 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3524167695:3524167695(0) ack 1972783999 win 28960 <mss 1380,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842592 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3524167696 win 229 <nop,nop,timestamp 503529073 513884542>

…

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Acquisizione sull'interfaccia ESTERNA:

firepower# cluster exec show cap CAPO | include 46278

unit-1-1(LOCAL):******************************************************

3: 11:01:44.841921 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: S 2153055699:2153055699(0) win 29200 <mss 1380,sackOK,timestamp 503529072 0,nop,wscale 7>

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

5: 11:01:44.842638 802.1Q vlan#202 P0 192.168.240.50.46278 > 192.168.241.50.80: . ack 3382481338 win 229 <nop,nop,timestamp 503529073 513884542>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

firepower#

Passaggio 2. Concentrazione sui pacchetti in entrata (TCP SYN e TCP SYN/ACK):

firepower# cluster exec show cap CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

824 packets captured

3: 11:01:44.841631 802.1Q vlan#201 P0 192.168.240.50.46278 > 192.168.241.50.80: S 1972783998:1972783998(0) win 29200 <mss 1460,sackOK,timestamp 503529072 0,nop,wscale 7>

…

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Tracciare il SYN/ACK sull'unità 1-1:

firepower# cluster exec show cap CAPO packet-number 4 trace

unit-1-1(LOCAL):******************************************************

4: 11:01:44.842226 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46278: S 3382481337:3382481337(0) ack 2153055700 win 28960 <mss 1460,sackOK,timestamp 513884542 503529072,nop,wscale 7>

Phase: 3

Type: FLOW-LOOKUP

Subtype:

Result: ALLOW

Config:

Additional Information:

Found flow with id 9583, using existing flow

Osservazione 3. I syslog del piano dati FTD mostrano la creazione e la terminazione della connessione sul proprietario e sul proprietario del backup:

firepower# cluster exec show log | include 46278

unit-1-1(LOCAL):******************************************************

Dec 01 2020 11:01:44: %FTD-6-302013: Built inbound TCP connection 9583 for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302014: Teardown TCP connection 9583 for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 bytes 1024001808 TCP FINs from INSIDE

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Dec 01 2020 11:01:44: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46278 (192.168.240.50/46278) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 11:01:53: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46278 to OUTSIDE:192.168.241.50/80 duration 0:00:08 forwarded bytes 0 Cluster flow with CLU closed on owner

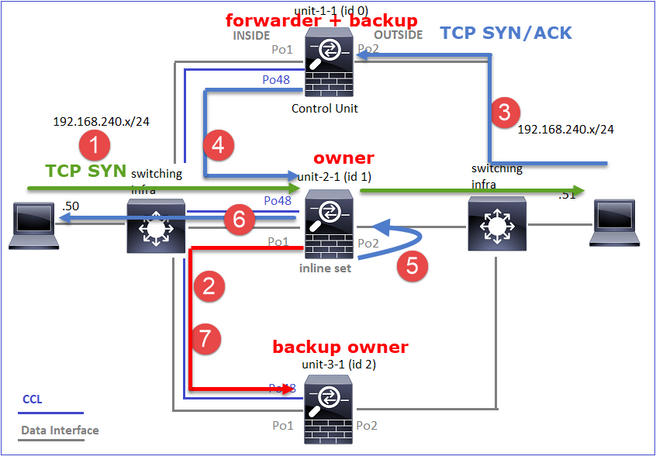

Caso di studio 3. Traffico asimmetrico (il director inoltra il traffico).

Osservazione 1. Le catture di reject-hide mostrano pacchetti sulle unità 1-1 e 2-1 (flusso asimmetrico):

firepower# cluster exec show cap

unit-1-1(LOCAL):******************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33554320 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Buffer Full - 98552 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99932 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-2-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Buffer Full - 33553268 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Buffer Full - 99052 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

unit-3-1:*************************************************************

capture CCL type raw-data buffer 33554432 interface cluster [Capturing - 53815 bytes]

capture CAPI type raw-data buffer 100000 trace interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO type raw-data buffer 100000 trace interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPI_RH type raw-data reinject-hide buffer 100000 interface INSIDE [Capturing - 0 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

capture CAPO_RH type raw-data reinject-hide buffer 100000 interface OUTSIDE [Capturing - 658 bytes]

match tcp host 192.168.240.50 host 192.168.241.50 eq www

Osservazione 2. Analisi del flag di connessione per il flusso con porta di origine 46502.

firepower# cluster exec show conn

unit-1-1(LOCAL):******************************************************

23 in use, 25 most used

Cluster:

fwd connections: 0 in use, 1 most used

dir connections: 0 in use, 122 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 2 enabled, 0 in effect, 4 most enabled, 1 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 448760236, flags UIO N1

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46500, idle 0:00:06, bytes 0, flags aA N1

unit-2-1:*************************************************************

21 in use, 271 most used

Cluster:

fwd connections: 0 in use, 2 most used

dir connections: 1 in use, 2 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 249 most enabled, 0 most in effect

TCP OUTSIDE 192.168.241.50:80 INSIDE 192.168.240.50:46502, idle 0:00:00, bytes 0, flags Y

unit-3-1:*************************************************************

17 in use, 20 most used

Cluster:

fwd connections: 1 in use, 5 most used

dir connections: 0 in use, 127 most used

centralized connections: 0 in use, 0 most used

VPN redirect connections: 0 in use, 0 most used

Inspect Snort:

preserve-connection: 0 enabled, 0 in effect, 1 most enabled, 0 most in effect

| Unità |

Contrassegna |

Nota |

| Unità-1-1 |

UIO |

· Proprietario flusso: l'unità gestisce il flusso. |

| Unità-2-1 |

Y |

· Director - Poiché l'unità 2-1 ha il flag 'Y', ciò implica che l'unità 2-1 è stata scelta come director per questo flusso. · Proprietario del backup · Infine, sebbene non sia ovvio da questo output, dai risultati show capture e show log è evidente che l'unità 2-1 inoltra questo flusso al proprietario (anche se tecnicamente non è considerato un server d'inoltro in questo scenario). Nota: Un'unità non può essere sia director (flusso Y) che forwarder (flusso z). Questi due ruoli si escludono a vicenda. I director (flusso Y) possono comunque inoltrare il traffico. Vedere l'output del comando show log più avanti in questo caso di studio. |

| Unità-3-1 |

- |

- |

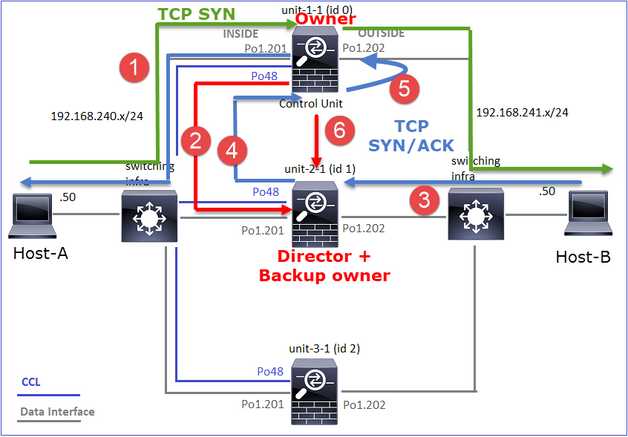

Ciò può essere visualizzato come:

- Il pacchetto TCP SYN arriva dall'host A all'unità 1 1. L'unità 1 1 diventa il proprietario del flusso.

- L'unità 2-1 viene selezionata come director di flusso e proprietario del backup. Il proprietario del flusso invia un messaggio unicast 'cluster add' su UDP 4193 per informare il proprietario del backup del flusso.

- Il pacchetto TCP SYN/ACK arriva dall'host-B all'unità-2-1. Il flusso è asimmetrico.

- L'unità 2-1 inoltra il pacchetto attraverso la CCL al proprietario (a causa del cookie SYN di TCP).

- Il proprietario reinserisce il pacchetto sull'interfaccia OUTSIDE e quindi lo inoltra all'host-A.

- Una volta terminata la connessione, il proprietario invia un messaggio di eliminazione del cluster per rimuovere le informazioni sul flusso dal proprietario del backup.

Osservazione 3. La cattura con traccia mostra il traffico asimmetrico e il reindirizzamento dall'unità 2-1 all'unità 1-1.

Passaggio 1. Identificare i pacchetti che appartengono al flusso di interesse (porta 46502):

firepower# cluster exec show capture CAPI | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.357037 802.1Q vlan#201 P0 192.168.241.50.80 > 192.168.240.50.46502: S 883000451:883000451(0) ack 4124514681 win 28960 <mss 1380,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357357 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 883000452 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

unit-3-1:*************************************************************

Direzione di ritorno:

firepower# cluster exec show capture CAPO | include 46502

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356426 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: S 1434968587:1434968587(0) win 29200 <mss 1380,sackOK,timestamp 510537534 0,nop,wscale 7>

4: 12:58:33.356915 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

5: 12:58:33.357403 802.1Q vlan#202 P0 192.168.240.50.46502 > 192.168.241.50.80: . ack 4257314723 win 229 <nop,nop,timestamp 510537536 520893004>

unit-2-1:*************************************************************

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

2: 12:58:33.360302 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . ack 1434968736 win 235 <nop,nop,timestamp 520893005 510537536>

3: 12:58:33.361004 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: . 4257314723:4257316091(1368) ack 1434968736 win 235 <nop,nop,timestamp 520893006 510537536>

…

unit-3-1:*************************************************************

Passaggio 2. Tracciare i pacchetti. Per impostazione predefinita, vengono tracciati solo i primi 50 pacchetti in entrata. Per semplicità, le fasi di analisi non rilevanti vengono omesse.

Unità-1-1 (proprietario):

firepower# cluster exec show capture CAPI packet-number 3 trace

unit-1-1(LOCAL):******************************************************

3: 12:58:33.356121 802.1Q vlan#201 P0 192.168.240.50.46502 > 192.168.241.50.80: S 4124514680:4124514680(0) win 29200 <mss 1460,sackOK,timestamp 510537534 0,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'INSIDE'

Flow type: NO FLOW

I (0) am becoming owner

Unità-2-1 (server d'inoltro)

Il traffico di ritorno (TCP SYN/ACK). L'unità di interesse è l'unità 2-1 che è il director/proprietario del backup e inoltra il traffico al proprietario:

firepower# cluster exec unit unit-2-1 show capture CAPO packet-number 1 trace

1: 12:58:33.359249 802.1Q vlan#202 P0 192.168.241.50.80 > 192.168.240.50.46502: S 4257314722:4257314722(0) ack 1434968588 win 28960 <mss 1460,sackOK,timestamp 520893004 510537534,nop,wscale 7>

...

Phase: 4

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) got initial, attempting ownership.

Phase: 5

Type: CLUSTER-EVENT

Subtype:

Result: ALLOW

Config:

Additional Information:

Input interface: 'OUTSIDE'

Flow type: NO FLOW

I (1) am early redirecting to (0) due to matching action (-1).

Osservazione 4. I syslog del piano dati FTD mostrano la creazione e la terminazione della connessione su tutte le unità:

firepower# cluster exec show log | i 46502

unit-1-1(LOCAL):******************************************************

Dec 01 2020 12:58:33: %FTD-6-302013: Built inbound TCP connection 9742 for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302014: Teardown TCP connection 9742 for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 bytes 2048000440 TCP FINs from INSIDE

unit-2-1:*************************************************************

Dec 01 2020 12:58:33: %FTD-6-302022: Built forwarder stub TCP connection for OUTSIDE:192.168.241.50/80 (192.168.241.50/80) to unknown:192.168.240.50/46502 (192.168.240.50/46502)

Dec 01 2020 12:58:33: %FTD-6-302023: Teardown forwarder TCP connection for OUTSIDE:192.168.241.50/80 to unknown:192.168.240.50/46502 duration 0:00:00 forwarded bytes 0 Forwarding or redirect flow removed to create director or backup flow

Dec 01 2020 12:58:33: %FTD-6-302022: Built director stub TCP connection for INSIDE:192.168.240.50/46502 (192.168.240.50/46502) to OUTSIDE:192.168.241.50/80 (192.168.241.50/80)

Dec 01 2020 12:59:02: %FTD-6-302023: Teardown director TCP connection for INSIDE:192.168.240.50/46502 to OUTSIDE:192.168.241.50/80 duration 0:00:28 forwarded bytes 2048316300 Cluster flow with CLU closed on owner