Exemple de configuration de Nexus 5500 VM-FEX

Contenu

Introduction

Ce document décrit comment configurer, utiliser et dépanner la fonctionnalité Virtual Machine Fabric Extender (VM-FEX) sur les commutateurs Cisco Nexus 5500.

Conditions préalables

Conditions requises

Cisco vous recommande de prendre connaissance des rubriques suivantes .

- VPC (Virtual Port Channel) Nexus

- VMware vSphere

Components Used

Les informations contenues dans ce document sont basées sur les versions de matériel et de logiciel suivantes :

- Nexus 5548UP qui exécute la version 5.2(1)N1(4)

- Serveur rack UCS C210 M2 avec carte d'interface virtuelle UCS P81E qui exécute le microprogramme version 1.4(2)

- vSphere version 5.0 (ESXi et vCenter)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si votre réseau est actif, assurez-vous de bien comprendre l'impact potentiel de toute commande ou configuration de capture de paquets.

Présentation de VM-FEX

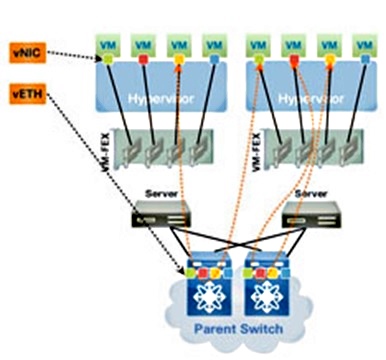

VM-FEX regroupe les réseaux virtuels et physiques dans une infrastructure unique. Il vous permet de provisionner, configurer et gérer le trafic réseau des machines virtuelles et le trafic réseau sans système d'exploitation au sein d'une infrastructure unifiée.

Le logiciel VM-FEX étend la technologie d'extension de fabric Cisco à la machine virtuelle avec les fonctionnalités suivantes :

- Chaque machine virtuelle inclut une interface dédiée sur le commutateur parent.

- Tout le trafic des machines virtuelles est envoyé directement à l'interface dédiée du commutateur.

- Le vSwitch standard de l'hyperviseur est éliminé.

VM-FEX est un type de commutateur virtuel distribué (DVS ou VDS). Le DVS présente l'abstraction d'un seul commutateur sur plusieurs serveurs ESX qui font partie du même conteneur de data center dans vCenter. La configuration VNIC (Virtual Machine) est conservée à partir d'un emplacement centralisé (Nexus 5000 ou UCS dans VM-FEX, ce document illustre la VM-FEX basée sur Nexus 5000).

VM-FEX peut fonctionner en deux modes :

- Passthrough : Il s'agit du mode par défaut, dans lequel le VEM est impliqué dans le chemin de données du trafic de VM.

- Hautes performances : Le trafic des machines virtuelles n'est pas géré par le VEM, mais il est transmis directement à la carte NIV (Network IO Virtualization).

Afin d'utiliser le mode hautes performances, il doit être demandé par la configuration du profil de port et doit être pris en charge par le système d'exploitation de la machine virtuelle et par sa carte virtuelle. Plus d'informations à ce sujet sont fournies plus loin dans ce document.

Définitions

- Module Ethernet virtuel (VEM). Module logiciel Cisco qui s'exécute à l'intérieur de l'hyperviseur ESX et qui assure la mise en oeuvre de VNLink dans un seul package

- La virtualisation des E/S réseau (NIV) utilise le marquage VN afin de déployer plusieurs liaisons de réseau virtuel (VN-Link) sur le même canal Ethernet physique

- DCBX (Datacenter Bridging Capability Exchange)

- VNIC Interface Control (VIC)

- Carte réseau virtuelle (VNIC), qui indique un point de terminaison hôte. Il peut être associé à un VIF actif ou à un VIF de secours

- Port virtuel distribué (DVPort). La carte VNIC est connectée au DVPort dans le VEM

- Interface virtuelle NIV (VIF), qui est indiquée sur un point d'extrémité réseau

- L’interface Virtual Ethernet (vEth) représente le VIF au niveau du commutateur.

- Commutateur PTS (Pass-Through Switch). Module VEM installé dans l'hyperviseur

Configuration

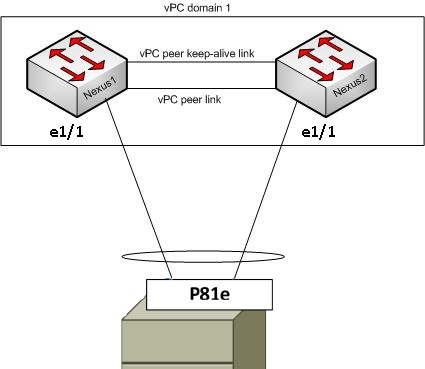

La topologie est un serveur UCS-C avec une carte VIC P81E à double résidence sur deux commutateurs VPC Nexus 5548.

Diagramme du réseau

Ces composants requis doivent déjà être en place :

- Le VPC est configuré et initialisé correctement entre les deux commutateurs Nexus 5000.

- VMWare vCenter est installé et connecté à via un client vSphere.

- ESXi est installé sur le serveur UCS-C et ajouté à vCenter.

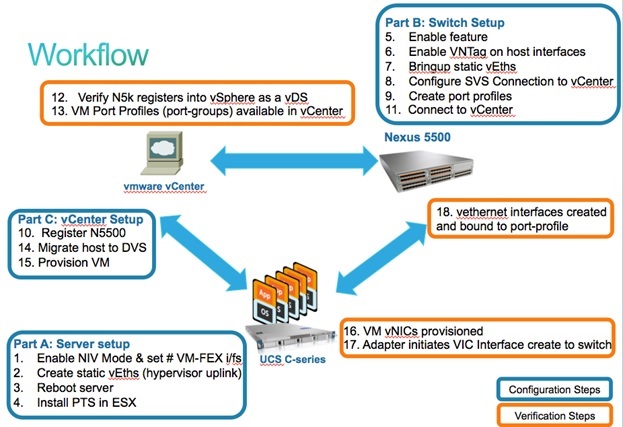

Les étapes de configuration sont résumées ici :

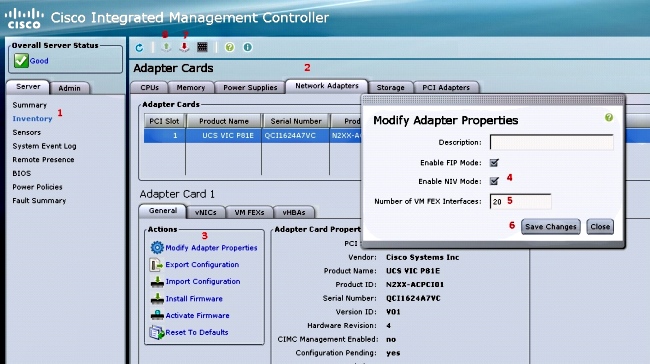

- Activer le mode NIV sur l'adaptateur serveur :

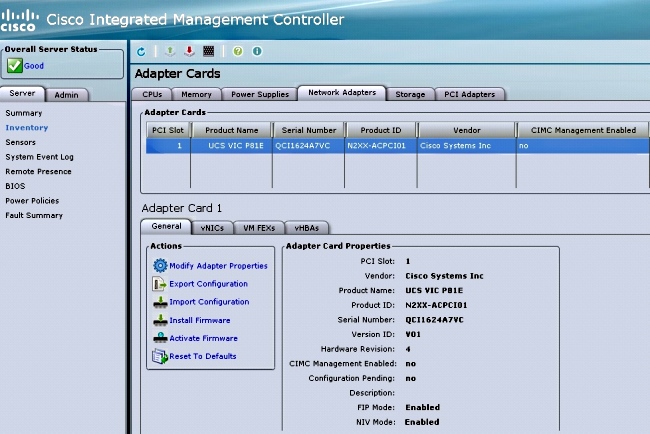

- Connectez-vous à l'interface CIMC (Cisco Integrated Management Controller) via HTTP et connectez-vous avec les informations d'identification d'administrateur.

- Choisissez Inventory > Network Adapters > Modify Adapter Properties.

- Activez le mode NIV, définissez le nombre d'interfaces FEX de VM et enregistrez les modifications.

- Mettez le serveur hors tension, puis sous tension.

Une fois que le serveur est de nouveau en ligne, vérifiez que NIV est activé :

- Connectez-vous à l'interface CIMC (Cisco Integrated Management Controller) via HTTP et connectez-vous avec les informations d'identification d'administrateur.

- Créez deux valeurs virtuelles statiques sur le serveur.

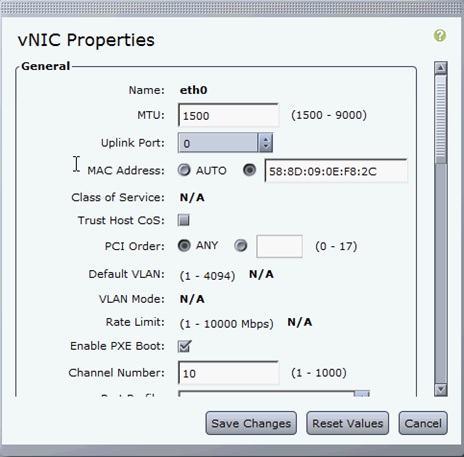

Afin de créer deux VNIC, choisissez Inventory > Network Adapters > VNICs > Add.

Voici les champs les plus importants à définir :

- Port de liaison ascendante VIC à utiliser (P81E a deux ports de liaison ascendante référencés par 0 et 1).

- Numéro de canal: Il s'agit d'un ID de canal unique de la carte VNIC sur la carte. Il est référencé dans la commande bind sous l'interface vEth du Nexus 5000. La portée du numéro de canal est limitée à la liaison physique VNTag. Le canal peut être considéré comme une « liaison virtuelle » sur la liaison physique entre le commutateur et la carte serveur.

- Profil de port : La liste des profils de port définis sur le Nexus 5000 en amont peut être sélectionnée. Une interface vEthernet est automatiquement créée sur le Nexus 5000 si le Nexus 5000 est configuré avec la commande vEthernet auto-create. Notez que seuls les noms de profil de port vEthernet sont transmis au serveur (la configuration de profil de port ne l'est pas). Cela se produit après l'établissement de la connectivité de la liaison VNTag et l'exécution des étapes initiales de connexion et de négociation entre le commutateur et la carte serveur.

- Activer le basculement de liaison ascendante : Les cartes réseau virtuelles basculent vers l'autre port de liaison ascendante P81E si le port de liaison ascendante configuré est hors connexion.

- Port de liaison ascendante VIC à utiliser (P81E a deux ports de liaison ascendante référencés par 0 et 1).

- Redémarrez le serveur.

- Installez le VEM sur l'hôte ESXi.

Pour un exemple d'installation du VEM sur l'hôte ESXi, reportez-vous à Installation ou mise à niveau du bundle logiciel Cisco VEM sur un hôte ESX ou ESXi dans le Guide de configuration de l'interface utilisateur graphique VM-FEX pour VMware de Cisco UCS Manager, version 2.1. - Activez le jeu de fonctions de virtualisation et les fonctions VM-FEX et HTTP :

(config)# install feature-set virtualization

(config)# feature-set virtualization

(config)# feature vmfex

(config)# feature http-server

(Optional) Allow the Nexus 5000 to auto-create its Vethernet interfaces when the

corresponding vNICs are defined on the server:

(config)# vethernet auto-create - Activez VNTag sur les interfaces hôtes.

Configure the N5k interface that connects to the servers in VNTAG mode:

(config)# interface Eth 1/1

(config-if)# switchport mode vntag

(config-if)# no shutdown - Montrez les ondes statiques.

Sur les deux commutateurs Nexus 5500, activez les interfaces virtuelles vEth statiques qui doivent se connecter aux deux cartes réseau virtuelles statiques activées sur la carte d'interface virtuelle du serveur.

Sur le Nexus 5548-A, saisissez :interface vethernet 1

bind interface eth 1/1 channel 10

no shutdown

Sur le Nexus 5548-B, saisissez :interface vethernet 2

bind interface eth 1/1 channel 11

no shutdown

Vous pouvez également créer automatiquement ces interfaces vEth à l'aide de la commande vethernet auto-create.

Voici un exemple.

Sur chacun des deux Nexus 5000, configurez :interface Vethernet1

description server_uplink1

bind interface Ethernet101/1/1 channel 11

bind interface Ethernet102/1/1 channel 11

interface Vethernet2

description server_uplink2

bind interface Ethernet101/1/1 channel 12

bind interface Ethernet102/1/1 channel 12 - Configurez la connexion SVS à vCenter et connectez-vous.

Sur les deux commutateurs Nexus 5500, configurez :svs connection <name>

protocol vmware-vim

remote ip address <vCenter-IP> vrf <vrf>

dvs-name <custom>

vmware dvs datacenter-name <VC_DC_name>

Sur le commutateur principal VPC uniquement, connectez-vous à vCenter :svs connection <name>

connect

Sample configuration on VPC primary:

svs connection MyCon

protocol vmware-vim

remote ip address 10.2.8.131 port 80 vrf management

dvs-name MyVMFEX

vmware dvs datacenter-name MyVC

connect

Voici un exemple de configuration sur VPC secondaire :svs connection MyCon

protocol vmware-vim

remote ip address 10.2.8.131 port 80 vrf management

dvs-name MyVMFEX

vmware dvs datacenter-name MyVC - Créez des profils de port sur le Nexus 5000.

Sur les deux commutateurs Nexus 5500, configurez les profils de port pour les cartes réseau virtuelles VM-FEX. Ces profils de port apparaissent comme des groupes de ports du commutateur DVS dans vCenter.

Voici un exemple :vlan 10,20

port-profile type vethernet VM1

dvs-name all

switchport mode access

switchport access vlan 10

no shutdown

state enabled

port-profile type vethernet VM2

dvs-name all

switchport mode access

switchport access vlan 20

no shutdown

state enabled

Mode hautes performances VM

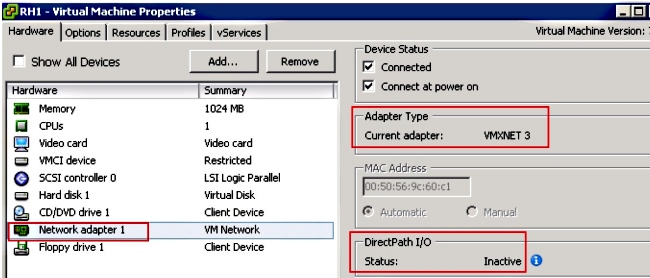

Afin d'implémenter le mode haute performance (E/S DirectPath) et de contourner l'hyperviseur pour le trafic de VM, configurez le profil de port vEthernet à l'aide de la commande hautes performances host-netio. Dans le cas des topologies VPC, le profil de port doit toujours être modifié sur les deux commutateurs homologues VPC. Exemple :port-profile type vethernet VM2

high-performance host-netio

Pour que le mode hautes performances fonctionne, votre machine virtuelle doit disposer des conditions requises supplémentaires suivantes :

- La carte virtuelle de la machine virtuelle doit être de type vmxnet3 (archiver vCenter : Cliquez avec le bouton droit de la souris sur VM > Edit settings > Network Adapter > Adapter type dans le menu de droite).

- La machine virtuelle doit avoir une réservation de mémoire complète (dans vCenter : Cliquez avec le bouton droit de la souris sur VM > Modifier les paramètres > onglet Ressources > Mémoire > Faites glisser le curseur de réservation vers la droite).

- Le système d'exploitation qui s'exécute sur la machine virtuelle doit prendre en charge cette fonctionnalité.

Voici comment vérifier le mode hautes performances (E/S DirectPath) lorsqu'il est utilisé.

Sous les paramètres matériels de la machine virtuelle, le champ E/S DirectPath du menu de droite affiche comme actif lorsque le mode hautes performances de la machine virtuelle est en cours d'utilisation et comme inactif lorsque le mode de transfert de la machine virtuelle par défaut est en cours d'utilisation.

- La carte virtuelle de la machine virtuelle doit être de type vmxnet3 (archiver vCenter : Cliquez avec le bouton droit de la souris sur VM > Edit settings > Network Adapter > Adapter type dans le menu de droite).

- Enregistrez le VPC Nexus 5548 principal dans vCenter :

Connectez-vous via HTTP au Nexus 5548 principal VPC et téléchargez le fichier XML d'extension :

Ensuite, enregistrez ce plug-in d'extension dans vCenter : choisissez Plug-ins > Manage Plug-ins > Right click > New Plug-in. - Se connecter à vCenter. (Reportez-vous à l'étape 8.)

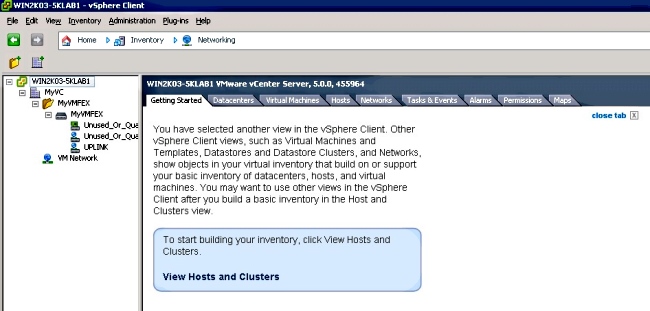

- Vérifiez que le Nexus 5000 s'enregistre dans vSphere en tant que vDS :

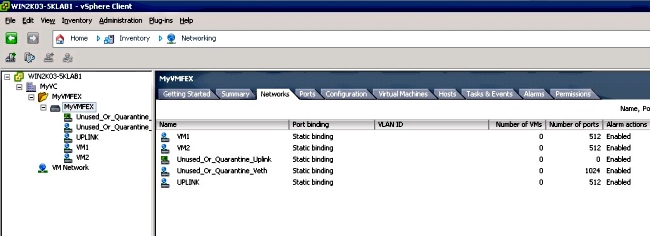

Vérifiez la création d'un nouveau DVS sous vCenter avec le nom défini dans dvs-name sous connexion svs sur le Nexus 5000 : choisissez Accueil > Inventaire > Mise en réseau.

Sur le commutateur principal VPC Nexus 5000, vérifiez que la connexion SVS est en ligne avec cette commande :n5k1# show svs connections

Local Info:

-----------

connection MyCon:

ip address: 10.2.8.131

remote port: 80

vrf: management

protocol: vmware-vim https

certificate: default

datacenter name: MyVC

extension key: Cisco_Nexus_1000V_126705946

dvs name: MyVMFEX

DVS uuid: 89 dd 2c 50 b4 81 57 e4-d1 24 f5 28 df e3 d2 70

config status: Enabled

operational status: Connected

sync status: in progress

version: VMware vCenter Server 5.0.0 build-455964

Peer Info:

----------

connection MyCon:

ip address: 10.2.8.131

remote port: 80

vrf: management

protocol: vmware-vim https

extension key: Cisco_Nexus_1000V_126705946

certificate: default

certificate match: TRUE

datacenter name: MyVC

dvs name: MyVMFEX

DVS uuid: -

config status: Disabled

operational status: Disconnected

n5k1# - Assurez-vous que les groupes de ports de VM sont disponibles dans vCenter.

Les profils de port vEthernet définis sur le Nexus 5000 doivent apparaître dans vCenter en tant que groupes de ports sous le DVS dans la vue réseau :

- Migrer les hôtes ESXi vers le DVS.

Dans VSphere, choisissez Home > Inventory > Networking, cliquez avec le bouton droit sur le nom DVS, puis Add Host afin d'ajouter les hôtes ESXi au DVS.

Les interfaces virtuelles Adapter-FEX sont les liaisons ascendantes des hôtes ESXi. Choisissez le groupe de ports de liaison ascendante par défaut (non utilisé_ou_quarantaine_liaison ascendante) pour ces ports de liaison ascendante. - Provisionner la VM.

Choisissez un groupe de ports VM-FEX pour la carte réseau d'une machine virtuelle (cliquez avec le bouton droit sur VM > Modifier les paramètres > Carte réseau > Étiquette réseau dans le menu de droite). - VNIC de VM provisionnées.

- L'adaptateur lance la création d'interface VIC sur le commutateur.

Lorsqu'une carte réseau de VM est mappée à un groupe de ports VM-FEX, une interface vEthernet est créée dynamiquement sur le Nexus 5000. La plage des interfaces vEth créées dynamiquement commence à 32769.

Ces interfaces peuvent être vérifiées via ces commandes :# show interface virtual status

# show interface virtual summary

Vérifiez et dépannez

Utilisez cette section afin de vérifier que votre configuration fonctionne correctement et de résoudre les problèmes que vous rencontrez.

- Afin de vérifier que les deux cartes réseau virtuelles statiques du serveur UCS-C sont connectées au VN-Link aux interfaces vEthernet fixes statiques du Nexus 5500, entrez cette commande :

n5k1# show system internal dcbx info interface e1/1

Interface info for if_index: 0x1a001000(Eth1/1)

tx_enabled: TRUE

rx_enabled: TRUE

dcbx_enabled: TRUE

DCX Protocol: CEE

DCX CEE NIV extension: enabled

<output omitted> - Dans le cas de topologies actives/en veille sur deux FEX à double hébergement, assurez-vous que l'interface vEth s'affiche comme mode actif ou en veille sur les deux commutateurs VPC Nexus 5000.

Ici, le mode est inconnu :

n5k1# show int virtual status

Interface VIF-index Bound If Chan Vlan Status Mode Vntag

-------------------------------------------------------------------------

Veth1 VIF-16 Eth101/1/1 11 1 Up Active 2

Veth1 None Eth102/1/1 11 0 Init Unknown 0

Veth2 None Eth101/1/1 12 0 Init Unknown 0

Veth2 None Eth102/1/1 12 0 Init Unknown 0

Veth3 VIF-18 Eth101/1/2 11 1 Up Active 2

Veth3 None Eth102/1/2 11 0 Init Unknown 0

Veth4 None Eth101/1/2 12 0 Init Unknown 0

Veth4 VIF-19 Eth102/1/2 12 1 Up Active 3

Si vous rencontrez un mode inconnu, assurez-vous d'activer le mode de basculement de liaison ascendante sur la carte VNIC. Vérifiez également que le numéro de canal que vous avez spécifié dans le CIMC correspond au numéro de canal spécifié dans la configuration vEthernet.

Le résultat correct doit ressembler à ceci :n5k1# show int virtual status

Interface VIF-index Bound If Chan Vlan Status Mode Vntag

-------------------------------------------------------------------------

Veth1 VIF-27 Eth101/1/1 11 1 Up Active 2

Veth1 VIF-35 Eth102/1/1 11 1 Up Standby 2

Veth2 VIF-36 Eth101/1/1 12 1 Up Standby 3

Veth2 VIF-33 Eth102/1/1 12 1 Up Active 3

Veth3 VIF-30 Eth101/1/2 11 1 Up Active 2

Veth3 VIF-21 Eth102/1/2 11 1 Up Standby 2

Veth4 VIF-24 Eth101/1/2 12 1 Up Standby 3

Veth4 VIF-31 Eth102/1/2 12 1 Up Active 3 - Les interfaces Ethernet n’apparaissent pas sur le commutateur.

Dans le menu HTTP CIMC du serveur UCS-C, vérifiez que :

- NIV est activé sur la carte.

- Un nombre non nul d'interfaces VM-FEX est configuré sur la carte.

- Le basculement de la carte est activé sur la carte réseau virtuel.

- Le serveur UCS-C a été redémarré après la configuration ci-dessus.

- NIV est activé sur la carte.

- Les interfaces Ethernet ne sont pas mises en ligne.

Vérifiez si VIF_CREATE apparaît dans cette commande :# show system internal vim info logs interface veth 1

03/28/2014 16:31:47.770137: RCVD VIF CREATE request on If Eth1/32 <<<<<<<

03/28/2014 16:31:53.405004: On Eth1/32 - VIC CREATE sending rsp for msg_id 23889

to completion code SUCCESS

03/28/2014 16:32:35.739252: On Eth1/32 - RCVD VIF ENABLE. VIF-index 698 msg id 23953

VIF_ID: 0, state_valid: n, active

03/28/2014 16:32:35.802019: On Eth1/32 - VIC ENABLE sending rsp for msg_id 23953 to

completion code SUCCESS

03/28/2014 16:32:36.375495: On Eth1/32 - Sent VIC SET, INDEX: 698, msg_id 23051, up,

enabled, active, cos 0VIF_ID: 50 vlan:

1 rate 0xf4240, burst_size 0xf

03/28/2014 16:32:36.379441: On Eth1/32 - RCVD VIC SET resp, INDEX: 698, msg_id 23051,

up, enabled,active, cos 0, completion

code: 100

Si VIF_CREATE n'apparaît pas ou si le commutateur ne répond pas correctement, procédez comme suit :

- Dans vCenter, vérifiez que le commutateur DVS a été correctement configuré avec deux liaisons ascendantes physiques pour l'hôte ESX (cliquez avec le bouton droit sur commutateur DVS > Gérer les hôtes > Sélectionner des adaptateurs physiques).

- Dans vCenter, vérifiez que VMNIC a sélectionné l'étiquette réseau / profil de port correct (cliquez avec le bouton droit sur VM > Modifier les paramètres > cliquez sur Carte réseau > cochez l'étiquette Réseau).

- Dans vCenter, vérifiez que le commutateur DVS a été correctement configuré avec deux liaisons ascendantes physiques pour l'hôte ESX (cliquez avec le bouton droit sur commutateur DVS > Gérer les hôtes > Sélectionner des adaptateurs physiques).

- La connexion SVS à vCenter ne se met pas en ligne.

Comme indiqué à l'étape 12 de la section précédente, utilisez ce processus afin de vérifier que le Nexus 5000 était connecté à vCenter :

- Sur vCenter, vérifiez que le DVS apparaît sous la vue réseau.

- Sur le Nexus 5000 VPC principal, vérifiez que le SVS est connecté (utilisez la commande show svs connection).

Si la connexion n'est pas établie, vérifiez que :

- La configuration SVS est identique sur les deux homologues VPC.

- Le VPC est initialisé et les rôles sont établis correctement.

- Le certificat XML du commutateur principal VPC est installé dans vCenter.

- Le commutateur principal VPC a la connexion configurée sous le mode de configuration « connexion svs ».

- Le nom du centre de données correspond au nom utilisé sur vCenter.

- Le VRF (Virtual Routing and Forwarding) correct est configuré dans la commande distante SVS et que le commutateur dispose d'une connectivité IP à l'adresse IP vCenter.

Si toutes ces conditions sont remplies mais que la connexion SVS n'est toujours pas établie, collectez ce résultat et contactez le centre d'assistance technique Cisco (TAC) :show msp port-profile vc sync-status

show msp internal errors

show msp internal event-history msgs

show vms internal errors

show vms internal event-history msgs - Sur vCenter, vérifiez que le DVS apparaît sous la vue réseau.

- Le commutateur Nexus 5500 n'est pas accessible via HTTP.

Vérifiez que la fonctionnalité http-server est activée :n5k1# show feature | i http

http-server 1 disabled

n5k1# conf t

Enter configuration commands, one per line. End with CNTL/Z.

n5k1(config)# feature http-server

n5k1(config)#

Historique de révision

| Révision | Date de publication | Commentaires |

|---|---|---|

1.0 |

15-May-2014 |

Première publication |

Contacter Cisco

- Ouvrir un dossier d’assistance

- (Un contrat de service de Cisco est requis)

Commentaires

Commentaires