Définition des commandes de bande passante et de priorité d'une politique de service QoS

Options de téléchargement

-

ePub (108.6 KB)

Consulter à l’aide de différentes applications sur iPhone, iPad, Android ou Windows Phone -

Mobi (Kindle) (105.1 KB)

Consulter sur un appareil Kindle ou à l’aide d’une application Kindle sur plusieurs appareils

Langage exempt de préjugés

Dans le cadre de la documentation associée à ce produit, nous nous efforçons d’utiliser un langage exempt de préjugés. Dans cet ensemble de documents, le langage exempt de discrimination renvoie à une langue qui exclut la discrimination en fonction de l’âge, des handicaps, du genre, de l’appartenance raciale de l’identité ethnique, de l’orientation sexuelle, de la situation socio-économique et de l’intersectionnalité. Des exceptions peuvent s’appliquer dans les documents si le langage est codé en dur dans les interfaces utilisateurs du produit logiciel, si le langage utilisé est basé sur la documentation RFP ou si le langage utilisé provient d’un produit tiers référencé. Découvrez comment Cisco utilise le langage inclusif.

À propos de cette traduction

Cisco a traduit ce document en traduction automatisée vérifiée par une personne dans le cadre d’un service mondial permettant à nos utilisateurs d’obtenir le contenu d’assistance dans leur propre langue. Il convient cependant de noter que même la meilleure traduction automatisée ne sera pas aussi précise que celle fournie par un traducteur professionnel.

Table des matières

Introduction

Ce document décrit comment les commandes bandwidth et priority sont appliquées dans une carte-politique d'interface de ligne de commande de qualité de service modulaire.

Conditions préalables

Conditions préalablesExigences

ExigencesAucune exigence spécifique n'est associée à ce document.

Composants utilisés

Composants utilisésCe document n'est pas limité à des versions de matériel et de logiciel spécifiques.

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si votre réseau est en ligne, assurez-vous de bien comprendre l’incidence possible des commandes.

Conventions

ConventionsPour plus d'informations sur les conventions utilisées dans ce document, reportez-vous à Conventions relatives aux conseils techniques Cisco.

Informations générales

Informations généralesLes commandes bandwidth et priority définissent toutes deux des actions qui peuvent être appliquées dans une carte-politique d'interface de ligne de commande (MQC) de qualité de service modulaire, que vous appliquez ensuite à une interface, une sous-interface ou un circuit virtuel (VC) via cette service-policy commande. Spécifiquement, ces commandes fournissent une garantie de bande passante aux paquets qui correspondent aux critères d'une classe de trafic. Cependant, les deux commandes présentent d'importantes différences fonctionnelles dans ces garanties. Cette note technique explique lesdites différences et la façon dont la bande passante inutilisée d'une classe est distribuée à des flux qui correspondent à d'autres classes.

Résumé des différences

Résumé des différencesCe tableau répertorie les différences fonctionnelles entre les commandes bandwidth et priority :

| Fonction | bandwidthCommand | priorityCommand |

|---|---|---|

| Garantie de bande passante minimale | Oui | Oui |

| Garantie de bande passante maximale | Non | Oui |

| Contrôle intégré | Non | Oui |

| Fournit une faible latence | Non | Oui |

En outre, les commandes bandwidth et priority sont conçues pour répondre à différents objectifs de politique de qualité de service (QoS). Ce tableau répertorie les différents objectifs suivants :

| Application | bandwidthCommand | priorityCommand |

|---|---|---|

| Gestion de la bande passante pour des liaisons WAN | Oui | Un peu |

| Gérez le retard et les variations du retard (gigue) | Non | Oui |

| Améliorez le temps de réponse des applications | Non | Oui |

Même avec des interfaces rapides, la plupart des réseaux ont toujours besoin d'un modèle solide de gestion QoS pour traiter efficacement des points d'encombrement et des étranglements qui se produisent inévitablement en raison d'incohérences de vitesse ou de structures de trafic diverses. Les réseaux réels présentent des ressources limitées et des goulots d’étranglement et ont besoin de politiques de qualité de service pour garantir une allocation correcte des ressources.

Configuration de la commande Bandwidth

Configuration de la commande BandwidthLes guides de configuration de Cisco IOS ® décrivent la bandwidth commande comme la « quantité de bande passante, en kbits/s, à attribuer à la classe. ... .pour spécifier ou modifier la bande passante allouée pour une classe qui appartient à une carte de stratégie."

Voyons ce que signifient ces définitions.

La bandwidth commande fournit une garantie de bande passante minimale pendant l'encombrement. La syntaxe de la commande peut revêtir trois formes, tel qu'illustré dans ce tableau :

| Syntaxe de commande | Description |

|---|---|

bandwidth {kbps}

|

Spécifie l'allocation de bande passante en tant que débit binaire. |

bandwidth percent {value}

|

Spécifie l'allocation de bande passante sous la forme d'un pourcentage du débit de liaison principal. |

bandwidth remaining percent {value}

|

Spécifie l'allocation de bande passante en tant que pourcentage de la bande passante qui n'a pas été allouée à d'autres classes. |

Remarque : la commande bandwidth définit un comportement, qui est une garantie de bande passante minimale. Toutes les plates-formes de routeurs Cisco n'utilisent pas weighted-fair queueing (WFQ) comme algorithme principal pour mettre en oeuvre ce comportement. Pour plus d'informations, référez-vous à Pourquoi utiliser CBWFQ ?

Configuration de la commande Priority

Configuration de la commande PriorityLes guides de configuration de Cisco IOS décrivent la commande priority comme une réserve pour « une file d'attente prioritaire avec une quantité spécifiée de bande passante disponible pour le trafic CBWFQ... pour donner la priorité à une classe de trafic en fonction de la quantité de bande passante disponible dans une stratégie de trafic. » L'exemple suivant explique ce que signifient ces définitions.

Vous créez une file d'attente prioritaire avec les ensembles de commandes suivants :

Router(config)#policy-map policy-name

Router(config-pmap)#class class-name

Router(config-pmap-c)#priority kpbs [bytes]

Dans les situations d'encombrement, la classe de trafic est une bande passante garantie égale au débit spécifié. (Souvenez-vous que les garanties de bande passante sont seulement un problème quand une interface est congestionnée.) En d'autres termes, la priority commande fournit une garantie de bande passante minimale.

En outre, la priority commande implémente une garantie de bande passante maximale. À un niveau interne, la file d'attente prioritaire utilise un comptage de jeton qui mesure la charge offerte et s'assure que le flux de trafic est conforme au débit configuré. Seul le trafic qui est conforme au comptage de jeton est garanti de faible latence. Tout excès de trafic est envoyé si la liaison n'est pas congestionnée ou alors est abandonné si la liaison est congestionnée. Pour plus d'informations, consultezQu'est-ce qu'un groupement de jetons ?

Le but du contrôle intégré est de s'assurer que les autres files d'attente sont traitées par le programmateur de files d'attente. Dans la fonctionnalité de mise en file d'attente prioritaire Cisco d'origine, qui utilise les priority-group priority-list commandes et , le planificateur a toujours traité en premier la file d'attente de priorité la plus élevée. Dans des cas extrêmes, les files d'attente de faible priorité étaient rarement traitées et étaient effectivement privées de bande passante.

Le véritable avantage de la priority commande, et sa principale différence par rapport à la bandwidth commande, est de fournir une priorité stricte de suppression de la file d'attente pour fournir une limite de latence. Voici comment le Guide de configuration de Cisco IOS décrit cet avantage : « Une file d'attente à priorité stricte (PQ) permet de retirer de la file d'attente des données sensibles au délai, telles que la voix, et de les envoyer avant que les paquets d'autres files d'attente ne soient retirés de la file d'attente. » Regarde ce que ça veut dire.

Chaque interface du routeur met à jour ces deux ensembles de files d'attente :

| File d’attente | Emplacement | Méthodes de mise en file d'attente | Les routages spécifiques de service s'appliquent | Commande pour ajuster |

|---|---|---|---|---|

| File d'attente matérielle ou boucle de transmission | Adaptateur de port ou module réseau | FIFO uniquement. | Non | tx-ring-limit |

| File d'attente de la couche 3 | Système de traitement de la couche 3 ou tampons d'interface | WFQ, CBWFQ, LLQ basés sur le flux | Oui | Varie avec la méthode de mise en file d'attente. Utilisez la commande queue-limit avec une classe de bande passante. |

D'après le tableau précédent, nous pouvons voir qu'une politique de service s'applique uniquement aux paquets dans la file d'attente de couche 3.

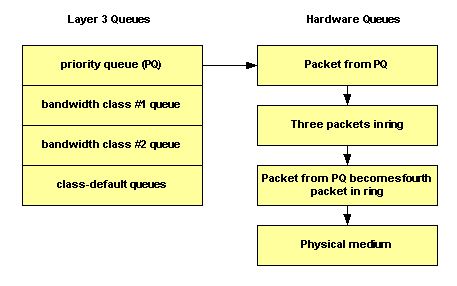

La suppression stricte de la file d'attente fait référence au planificateur de mise en file d'attente qui gère la file d'attente prioritaire et transfère d'abord ses paquets à l'anneau de transmission. La boucle de transmission est le dernier arrêt avant les médias physiques.

Dans l'illustration suivante, l'anneau de transmission a été configuré pour contenir quatre paquets. Si trois paquets sont déjà sur la boucle, alors au mieux nous pouvons mettre en file d'attente à la quatrième position, puis attendre que les trois autres se vident. Ainsi, le mécanisme Low Latency Queueing (LLQ) retire simplement de la file d'attente les paquets à la fin de la liste d'attente du niveau du pilote first-in, first-out (FIFO) sur la boucle de transmission.

Utilisez la tx-ring-limit commande pour régler la taille de l'anneau de transmission sur une valeur non définie par défaut. Cisco vous recommande de régler la sonnerie de transmission lorsque vous transmettez du trafic vocal.

La hiérarchisation du trafic est particulièrement importante pour des applications basées sur des transactions interactives et sensibles au retard. Pour réduire le retard et la gigue, les périphériques réseau doivent être capables de traiter de paquets de voix dès qu'ils arrivent, ou en d'autres termes, de façon strictement prioritaire. Seule une priorité stricte fonctionne bien pour la voix. À moins que les paquets vocaux ne soient immédiatement retirés de la file d’attente, chaque saut peut entraîner un délai supplémentaire.

L'Union internationale des télécommunications (ITU) recommande un maximum de retard de bout en bout unidirectionnel de 150 millisecondes. Sans retrait immédiat de la file d'attente sur l'interface du routeur, un seul saut de routeur peut peser le plus dans ce budget de retard. Pour plus d'informations, reportez-vous au support de qualité vocale.

Remarque : avec les deux commandes, la valeur en kbits/s doit prendre en compte la surcharge de couche 2. En d'autres termes, si une garantie est faite pour une classe, cette garantie est, en ce qui concerne la couche 2, le débit.

Quelles classes de trafic peuvent utiliser la bande passante excessive ?

Quelles classes de trafic peuvent utiliser la bande passante excessive ?Bien que les garanties de bande passante fournies par les commandes bandwidth et priority aient été décrites avec des mots comme « réservé » et « bande passante à mettre de côté », aucune commande n'implémente une vraie réservation. En d'autres termes, si une classe de trafic n'utilise pas sa bande passante configurée, toute bande passante inutilisée est partagée entre les autres classes.

Le système de mise en file d'attente impose une importante exception à la règle avec une classe prioritaire. Comme indiqué précédemment, la charge offerte d'une classe de priorité est mesurée par un régulateur de trafic. Pendant les états d'encombrement, une classe prioritaire ne peut utiliser aucune bande passante excessive.

Ce tableau décrit quand une classe de bande passante et une classe prioritaire peuvent utiliser la bande passante excessive :

| Commande | Congestion | Non encombrement |

|---|---|---|

| bandwidthCommand | Autorisé à dépasser le débit alloué. | Autorisé à dépasser le débit alloué. |

| priorityCommand | Cisco IOS dose les paquets et applique un système de mesure du trafic par l'intermédiaire d'un comptage de jeton. Les paquets qui correspondent sont régulés selon le débit en bits/s configuré, et tout paquet en excès est rejeté. | La classe peut dépasser sa bande passante configurée. |

Remarque : Frame Relay sur le routeur Cisco 7200 et les autres plates-formes non RSP (Route/Switch Processor) constitue une exception à ces directives pour LLQ. L'implémentation originale de LLQ au-dessus de Frame Relay sur ces plates-formes n'a pas permis aux classes prioritaires de dépasser le débit configuré au cours des périodes de non encombrement. La version 12.2 du logiciel Cisco IOS ne contient plus cette exception et s'assure que des paquets non conformes sont seulement déposés s'il y a un encombrement. En outre, les paquets dont la taille est inférieure à une taille de fragmentation FRF.12 ne sont plus envoyés par le processus de fragmentation, ce qui réduit l’utilisation du CPU.

D'après la discussion précédente, il est important de comprendre que puisque les classes de priorité sont contrôlées dans des conditions d'encombrement, aucune bande passante restante ne leur est allouée à partir des classes de bande passante. Ainsi, la bande passante restante est partagée par toutes les classes de bande passante et classes par défaut.

Allocation de bande passante inutilisée

Allocation de bande passante inutiliséeCette section explique comment le système de mise en file d'attente distribue toute bande passante restante. Voici comment l'Aperçu de la fonctionnalité de mise en file d'attente pondérée basée sur les classes décrit le mécanisme d'allocation : « Si une bande passante excessive est disponible, la bande passante excédentaire est divisée entre les classes de trafic proportionnellement à leurs bandes passantes configurées. Si toute la bande passante n'est pas allouée, la bande passante restante est proportionnellement allouée parmi les classes, basées sur leur bande passante configurée. » Regardez deux exemples.

Dans le premier exemple, policy-map foo garantit 30 % de la bande passante à la barre de classe et 60 % de la bande passante à la barre de classe.

policy-map foo

class bar

bandwidth percent 30

class baz

bandwidth percent 60

Si vous appliquez cette stratégie à une liaison à Mbits/s, cela signifie que 300 kBps sont garantis à la classe « bar », et 600 kBps sont garantis à la classe « baz ». Il est important de mentionner que 100 kBps restent pour la classe par défaut. Si la classe par défaut n'en a pas besoin, les 100 kPps inutilisés sont disponibles à l'usage de la classe « bar » et de la classe « baz ». Si les deux classes ont besoin de bande passante, elles la partagent proportionnellement aux débits configurés. Dans cette configuration, le rapport est partagé 30:60 ou 1:2.

Le prochain exemple de configuration contient trois cartes de stratégie - barre, baz et poli. Dans la carte de stratégie appelée barre et la carte de stratégie appelée baz, la bande passante est spécifiée par pourcentage. Cependant, dans la carte de stratégie appelée poli, la bande passante est spécifiée en kBps.

N'oubliez pas que les mappages de classe doivent déjà être créés avant de créer les mappages de stratégie.

policy-map bar

class voice

priority percent 10

class data

bandwidth percent 30

class video

bandwidth percent 20

policy-map baz

class voice

priority percent 10

class data

bandwidth remaining percent 30

class video

bandwidth remaining percent 20

policy-map poli

class voice

class data

bandwidth 30

class video

bandwidth 20

Remarque : la commande bandwidth still percent a été introduite dans la version 12.2(T) de Cisco IOS.

Utiliser la commande Police pour définir un maximum

Utiliser la commande Police pour définir un maximumSi une bande passante ou une classe de priorité ne doit pas dépasser sa bande passante allouée pendant les périodes sans encombrement, vous pouvez combiner la priority commande avec la police commande. Cette configuration impose un débit maximal qui est toujours en activité sur la classe. Le choix de configurer une police instruction dans cette configuration dépend de l'objectif de la stratégie.

Comprendre la valeur de la bande passante disponible

Comprendre la valeur de la bande passante disponibleCette section explique comment le système de mise en file d'attente obtient la valeur de bande passante disponible, telle qu'affichée dans le résultat des commandes show interface ou show queueing .

Nous avons créé cette carte stratégique nommée Leslie :

7200-16#show policy-map leslie

Policy Map leslie

Class voice

Weighted Fair Queueing

Strict Priority

Bandwidth 1000 (kbps) Burst 25000 (Bytes)

Class data

Weighted Fair Queueing

Bandwidth 2000 (kbps) Max Threshold 64 (packets)

Nous avons alors créé un circuit virtuel permanent ATM (PVC), l'avons attribué à la catégorie de service ATM en temps non réel à débit variable, et avons configuré un taux de cellules soutenu de 6 Mbits/s. Nous avons ensuite appliqué le policy-map au circuit virtuel permanent à l’aide de la service-policy output leslie commande.

7200-16(config)#interface atm 4/0.10 point

7200-16(config-subif)#pvc 0/101

7200-16(config-if-atm-vc)#vbr-nrt 6000 6000

7200-16(config-if-atm-vc)#service-policy output leslie

show queueing interface atm La commande affiche Bande passante disponible 1 500 kilobits/s.

7200-16#show queue interface atm 4/0.10

Interface ATM4/0.10 VC 0/101

queue strategy: weighted fair

Output queue: 0/512/64/0 (size/max total/threshold/drops)

Conversations 0/0/128 (active/max active/max total)

Reserved Conversations 1/1 (allocated/max allocated)

Available Bandwidth 1500 kilobits/sec

Voyons comment cette valeur est dérivée :

-

6 Mbits/s est le taux de cellules soutenu (SCR). Par défaut, 75 pour cent de cette somme peut être réservée :

0.75 * 6000000 = 4500000

-

3000 Kbps sont déjà utilisés par la voix et les classes de données :

4500000 - 3000000 = 1500000 bps

-

La bande passante disponible est de 1500000 bps.

Le maximum par défaut de valeur de bande passante réservable de 75 % est conçu pour laisser la bande passante suffisante pour le trafic supplémentaire, tel que des mises à jour de protocoles de routage et des keepalives de la couche 2. Il couvre également la surcharge de couche 2 pour les paquets qui correspondent et sont des classes de trafic définies ou la classe par défaut de la classe. Vous pouvez désormais augmenter la valeur maximale de bande passante réservable sur les circuits virtuels permanents ATM à l’aide de la commande max-reserved-bandwidth . Pour connaître les versions de Cisco IOS prises en charge et obtenir des informations supplémentaires, reportez-vous à Comprendre la commande max-reserved-bandwidth sur ATM PVC.

Sur les circuits virtuels permanents Frame Relay, les commandes bandwidth et priority calculent la quantité totale de bande passante disponible de l'une des manières suivantes :

-

Si un débit minimum de données garanti acceptable (minCIR) n'est pas configuré, le CIR est divisé par deux.

-

Si un minCIR est configuré, le paramétrage de minCIR est utilisé dans le calcul. La bande passante totale du débit précédent peut être affectée à des classes de bande passante et de priorité.

Par conséquent, la max-reserved-bandwidth commande n’est pas prise en charge sur les circuits virtuels permanents Frame Relay, bien que vous deviez vous assurer que la quantité de bande passante configurée est suffisamment importante pour prendre en charge la surcharge de couche 2. Pour plus d'informations, référez-vous à Configurer CBWFQ sur des circuits virtuels permanents Frame Relay.

Informations connexes

Informations connexes Historique de révision

| Révision | Date de publication | Commentaires |

|---|---|---|

3.0 |

30-Aug-2023 |

Correction des fautes. Recertification. |

2.0 |

04-Apr-2023 |

Format mis à jour, CCW corrigé. Recertification. |

1.0 |

27-Nov-2001 |

Première publication |

Contribution d’experts de Cisco

- Ingénieurs TAC

Contacter Cisco

- Ouvrir un dossier d’assistance

- (Un contrat de service de Cisco est requis)

Commentaires

Commentaires