Déployez EVPN VXLAN, multisite par l'intermédiaire de DCNM 11.2(1)

Options de téléchargement

-

ePub (8.0 MB)

Consulter à l’aide de différentes applications sur iPhone, iPad, Android ou Windows Phone -

Mobi (Kindle) (6.1 MB)

Consulter sur un appareil Kindle ou à l’aide d’une application Kindle sur plusieurs appareils

Langage exempt de préjugés

Dans le cadre de la documentation associée à ce produit, nous nous efforçons d’utiliser un langage exempt de préjugés. Dans cet ensemble de documents, le langage exempt de discrimination renvoie à une langue qui exclut la discrimination en fonction de l’âge, des handicaps, du genre, de l’appartenance raciale de l’identité ethnique, de l’orientation sexuelle, de la situation socio-économique et de l’intersectionnalité. Des exceptions peuvent s’appliquer dans les documents si le langage est codé en dur dans les interfaces utilisateurs du produit logiciel, si le langage utilisé est basé sur la documentation RFP ou si le langage utilisé provient d’un produit tiers référencé. Découvrez comment Cisco utilise le langage inclusif.

À propos de cette traduction

Cisco a traduit ce document en traduction automatisée vérifiée par une personne dans le cadre d’un service mondial permettant à nos utilisateurs d’obtenir le contenu d’assistance dans leur propre langue. Il convient cependant de noter que même la meilleure traduction automatisée ne sera pas aussi précise que celle fournie par un traducteur professionnel.

Contenu

Introduction

Ce document décrit comment déployer deux différentes matrices EVPN VXLAN aussi bien que comment fusionner ces deux matrices dans un déploiement multisite de matrice EVPN utilisant le responsable du centre de données Cisco (DCNM) 11.2(1).

Le domaine multisite (MSD), introduit dans la release DCNM 11.0(1), est un conteneur multifabric qui est créé pour gérer de plusieurs matrices de membre. C'est un seul point de contrôle pour une définition des réseaux de substitution et du Virtual Routing and Forwarding (VRF) qui sont partagés à travers des matrices de membre.

Remarque: Ce document ne décrit pas les détails en ce qui concerne les fonctions/propriétés de chaque onglet dans DCNM. Veuillez voir les références à l'extrémité qui couvre des explications détaillées.

Conditions préalables

Exigences

Cisco vous recommande de prendre connaissance des rubriques suivantes :

-

vCenter/UCS pour déployer le virtual machine DCNM

-

Connaissance de NX-OS et de Nexus 9000s

-

Les massifs de roche du Nexus 9000s, EoRs se sont connectés d'une mode de feuille/épine

Composants utilisés

Les informations dans ce document sont basées sur le logiciel et le matériel suivants :

- DCNM 11.2(1)

- NX-OS 7.0(3)I7(7) et NX-OS 9.2(3)

- Épines : N9K-C9508/N9K-X97160YC-EX ET N9K-C9508/N9K-X9636PQ

- Feuilles : N9K-C9372TX, N9K-C93180YC-EX, N9K-C9372TX-E, N9K-C92160YC-X

- Passerelles de cadre : N9K-C93240YC-FX2 ET N9K-C93180YC-FX

- 7K « héberge » : N77-C7709

Les informations contenues dans ce document ont été créées à partir des périphériques d'un environnement de laboratoire spécifique. Tous les périphériques utilisés dans ce document ont démarré avec une configuration effacée (par défaut). Si votre réseau est en ligne, assurez-vous de bien comprendre l’incidence possible des commandes.

Topologie physique établie

Déployez l'OVA/OVF dans le vCenter

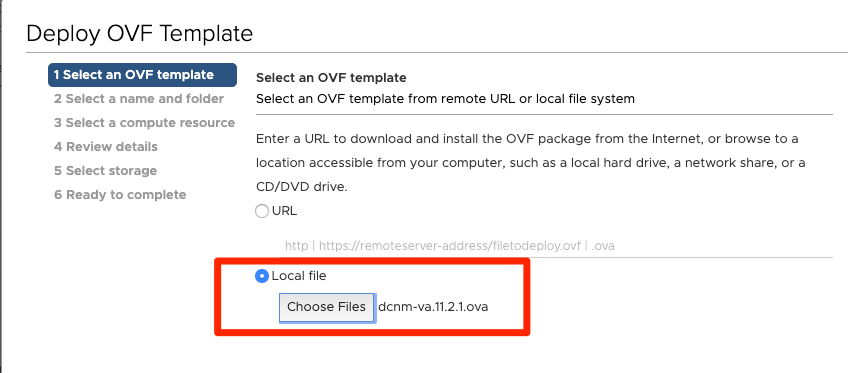

Étape 1. Sous le vCenter, déployez le modèle ouvert du format de virtualisation (OVF) dans le serveur/hôte de votre choix, suivant les indications de l'image.

- Ayez le fichier OVA/OVF, etc. localement et le sélectionnez par l'intermédiaire de choisissent des fichiers, suivant les indications de l'image :

- Suivez le reste de demandes (nom VM, qui hébergent, des paramètres réseau, suivant les indications de l'image) et cliquez sur en fonction la finition.

Étape 2. Une fois que terminé, commencez votre VM DCNM, comme affiché ici.

Étape 3. Lancez la console Web, une fois dans la console, vous devrait voir ces la demande (l'IP diffère car c'est spécifique à votre environnement et à votre configuration) :

Étape 4. Dirigez à https:// le <your IP>:2443 (c'est l'IP que vous avez configuré plus tôt pendant le déploiement d'OVULES) et cliquez sur en fonction Get a commencé. Dans cet exemple, une installation fraîche est couverte.

Étape 5. Une fois que vous avez configuré le mot de passe administrateur, vous devez sélectionner le type de matrice que vous voudriez installer. Sélectionnez entre le RÉSEAU LOCAL ou OUVRIER car chaque type a un but différent ainsi soyez sûr de comprendre et choisir correctement. Pour cet exemple, la matrice de RÉSEAU LOCAL est utilisée, il est pour la plupart des déploiements VXLAN-EVPN.

Étape 6. Suivez les demandes de l'installateur avec les DN de votre réseau, le serveur de Protocole NTP (Network Time Protocol), l'adresse Internet DCNM, etc.

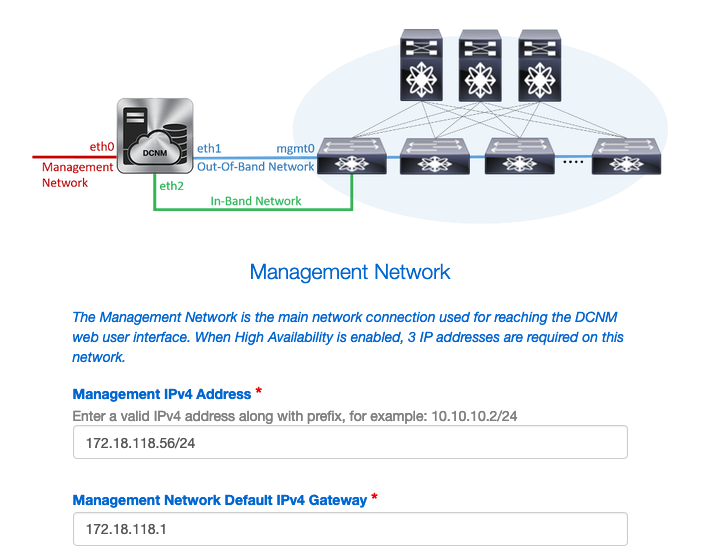

Étape 7. Configurez l'IP de Gestion et la passerelle de Gestion. Le réseau de gestion fournit la Connectivité (SSH, SCP, HTTP, HTTPS) au serveur DCNM. C'est également l'IP que vous utilisez pour atteindre le GUI. L'adresse IP devrait être préconfigurée de vous de l'installation d'OVULES faite précédemment.

Étape 8. Configurez le réseau d'intrabande. Le réseau d'intrabande est utilisé pour des applications telles que le localisateur de point final qui exige de la connectivité de port de panneau avant au 9Ks dans la matrice de fonctionner pendant qu'une session de Protocole BGP (Border Gateway Protocol) obtient établi entre DCNM et le 9K.

Étape 9. Configurez le réseau d'Application Services interne --

Pour commencer par la release DCNM 11.0, DCNM prend en charge le cadre d'applications (AFW) avec l'installation du RÉSEAU LOCAL OVA/ISO DCNM. Ce cadre utilise le docker pour orchestrer des applications comme microservices dans les environnements groupés et unclustered pour réaliser une architecture d'échelle-.

D'autres applications qui se transportent par défaut avec le DCNM sont le localisateur de point final, le tower de montre, le module d'extension de gestionnaire de virtual machine, la conformité etc. AFW de config prend soin de la Gestion de cycle de vie de ces applications comprenant fournir le réseau, mémoire, authentification, Sécurité, etc. AFW gère également le déploiement et le cycle de vie des applications ce sous-réseau à savoir NIR de vues de réseau et NIA est pour des services de docker quand vous faites activer NIA/NIR.

Comment installer NIA/NIR est couvert sous la section d'exécutions du jour 2.

Remarque: Ce sous-réseau ne devrait pas superposer avec les réseaux assignés aux interfaces eth0/eth1/eth2 assignées au DCNM et aux Noeuds de calcul. En outre, ce sous-réseau ne devrait pas superposer avec les IPS qui sont alloués aux Commutateurs ou à d'autres périphériques qui sont gérés par DCNM. Le sous-réseau choisi devrait demeurer cohérent en installant les Noeuds primaires et secondaires DCNM (en cas de déploiement indigène ha).

Étape 10. Passez en revue et confirmez tous les détails de configuration et mettez sur pied l'installation.

Étape 11. Une fois que DCNM est entièrement installé, ouvrez une session au GUI (adresse IP ou adresse Internet que vous avez précédemment configurée).

Déployez la première matrice -- Matrice de RTP

Étape 1. Une fois dans le GUI DCNM, naviguez vers le builder de matrice. Contrôle > matrices > builder de matrice afin de créer votre première matrice.

Étape 2. Cliquez sur en fonction la matrice Create et complétez les formes comme nécessaire pour votre réseau — la matrice facile est le modèle correct pour le déploiement des gens du pays EVPN VXLAN :

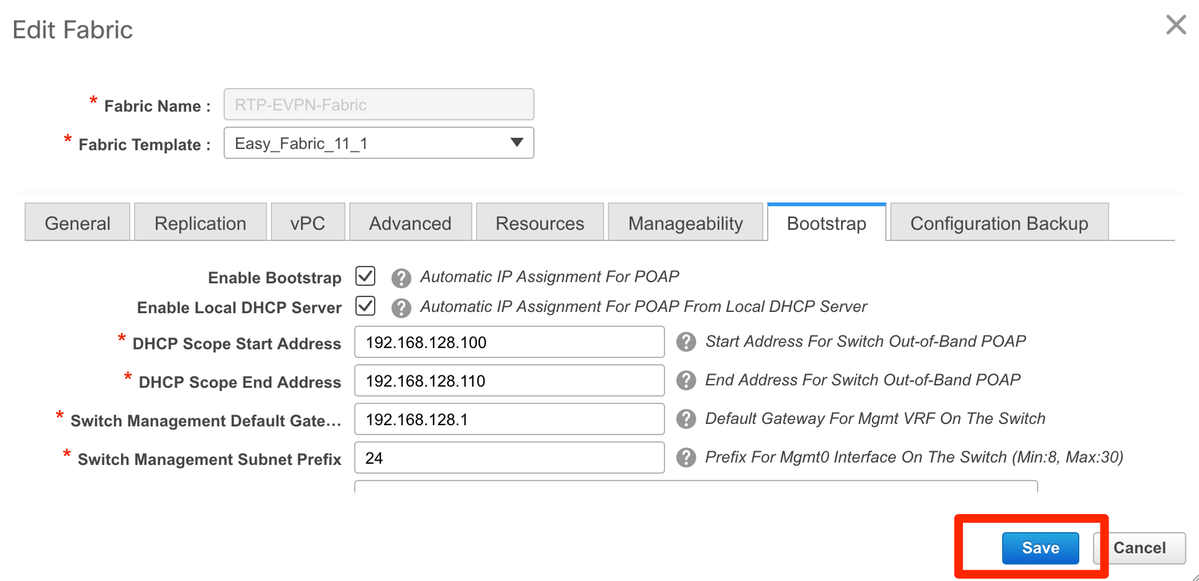

Étape 3. Complétez l'assise de la matrice, le recouvrement, le vpc, la réplication, les ressources, les conditions requises etc.

Cette section couvre tous les assise, recouvrement, vpc, réplication, configurations etc. exigés par l'intermédiaire de DCNM. Ceci dépend du système d'adressage du réseau, des conditions requises, etc. Pour cet exemple, la plupart des champs sont partis comme par défaut. Les L2VNI et les L3VNI ont été changés tels que début L2VNIs avec 2 et début L3VNIs avec 3 pour que la facilité dépanne plus tard. La détection bidirectionnelle d'expédition (BFD) est également activée avec d'autres caractéristiques.

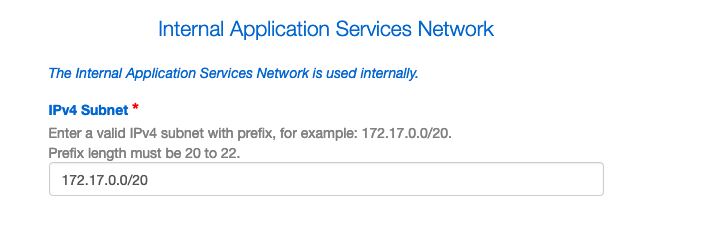

Étape 4. Sous la configuration de bootstrap, configurez la plage du DHCP s'adresse à vous veulent que DCNM distribue aux Commutateurs dans la matrice pendant le processus POAP. Configurez une passerelle par défaut (existante) appropriée aussi bien. Cliquez sur en fonction la sauvegarde une fois que vous êtes fait et maintenant vous pouvez entrer en fonction à ajouter des Commutateurs dans la matrice.

Ajoutez les Commutateurs dans la matrice

Étape 1. Naviguez pour contrôler > les matrices > le builder de matrice puis sélectionnez votre matrice. Sur du côté gauche le panneau, cliquez sur en fonction les Commutateurs Add, suivant les indications de l'image.

Vous pouvez découvrir des Commutateurs ou en utilisant un IP de graine (signifiant l'IP mgmt0 de chaque commutateur devez être configuré manuellement) ou vous pouvez découvrir les Commutateurs par l'intermédiaire de POAP et faire configurer DCNM tous les adresses IP mgmt0, Gestion de VRF, etc. pour vous. Pour cet exemple, nous utiliserons POAP.

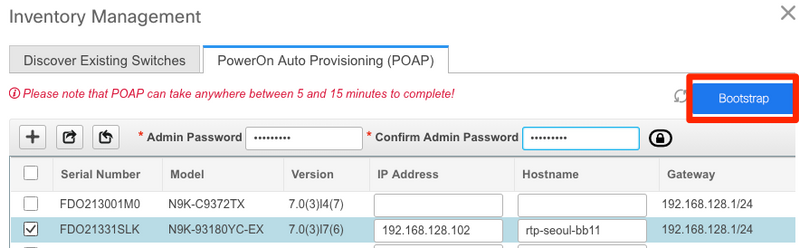

Étape 2. Une fois que vous voyez les commutateurs de votre intérêt, entrez l'adresse IP et l'adresse Internet désirées que vous voulez que DCNM l'utilise, entrer dans l'admin picowatt, puis pour cliquer sur en fonction le bootstrap, suivant les indications de l'image.

Un log réussi d'initialisation devrait regarder suivant les indications de l'image ici de la console du commutateur.

Étape 3. Avant que vous déployiez la configuration pour la matrice entière, assurez-vous que vous avez précédemment configuré DCNM avec les qualifications de périphérique. Un instantané devrait être apparu dans le GUI pendant que vous ouvrez une session. En cas il ne fait pas, vous peut toujours accéder à ceci par l'intermédiaire de la gestion > de la Gestion de qualifications > des qualifications de RÉSEAU LOCAL.

Remarque: Si les qualifications de périphérique manquent, DCNM ne pousse pas la configuration aux Commutateurs.

Déployez la configuration de la matrice

Étape 1. Une fois que vous avez découvert tous les Commutateurs pour la matrice donnée utilisant les mêmes étapes, naviguez pour contrôler > les matrices > le builder de matrice > le Fabric> sélectionné par <your. Vous devriez voir vos Commutateurs avec tous leurs liens ici. Cliquez sur la sauvegarde et déployez-vous.

Étape 2. Dans la fenêtre de déploiement de config, vous voyez combien de lignes de configuration pour chaque commutateur DCNM pousse. Vous pouvez visionner la configuration préalablement aussi bien si désiré et comparez avant et après :

Assurez tout l'état de Commutateurs NON TERMINÉ et 100% sans aucune erreur — s'il y a des erreurs, soyez sûr de les adresser un par un (voir les problèmes produits pendant cette section de déploiement pour des exemples)

Étape 3. que vous (facultatif) pouvez ouvrir une session aux périphériques en ce moment et émettre n'importe quel passage CLIs d'exposition pour vérifier que la configuration a été avec succès poussée par DCNM.

Exemple :

Déployez la deuxième matrice -- SJ

Exécutez les mêmes étapes qu'avant avec la matrice de RTP utilisant différentes valeurs pour le BGP COMME, etc.

Étape 1. Naviguez pour contrôler > les matrices > le builder de matrice > créent la matrice > le nom il !

Cette section couvre tous les assise, recouvrement, vpc, réplication, configurations etc. exigés. Ceci dépend du système d'adressage du réseau, des conditions requises, etc.

Remarque: Le MAC de passerelle de cantonade ici devrait apparier l'autre matrice si multisite est utilisé, plus tard, différents MACs de passerelle de cantonade ne sont pas pris en charge. Ceci a été corrigé plus tard pendant la section multisite de déploiement (non affichée dans l'article par souci de concision).

Étape 2. Configurez la section de bootstrap comme fait avant. Naviguez ajoutent des Commutateurs de nouveau. Une fois que tous découverts, cliquent sur en fonction la sauvegarde et se déploient pour déployer la configuration. Ceci a été tout couvert dans la section de déploiement de matrice de RTP (omettant ici par souci de concision).

Topologie du point de vue du builder de matrice à l'extrémité.

Dans le meilleur des cas, tous les Commutateurs devraient apparaître en vert avec leurs liens. Cette image affiche les différentes couleurs d'état dans le moyen DCNM.

Étape 3. Une fois que les deux matrices sont configurées et déployées, assurez à la save config et la recharge pour TCAM change pour la prendre effet. Allez aux contrôles > aux matrices > au builder de matrice > au <your Fabric>, naviguez vers la vue tabulaire, suivant les indications de l'image.

Étape 4. Cliquez sur alors le bouton d'alimentation (ceci recharge tous vos Commutateurs simultanément) :

Créez un réseau (VLAN/L2VNI) et les vrf (L3VNIs)

Étape 1. Naviguez pour contrôler > des matrices > des réseaux, suivant les indications de l'image.

Étape 2. Suivant les indications de l'image, sélectionnez la place pour la modification. c.-à-d. que la matrice fait cette configuration doivent être appliqués à ?

Étape 3. Cliquez sur en fonction + signe, suivant les indications de l'image.

Étape 4. DCNM marche vous par le processus pour créer Switch Virtual Interface (SVI) (ou L2 pur VLAN). Si aucun vrf n'est créé à ce stade, cliquez sur + bouton de nouveau et ceci vous prend temporairement à la revue du projet de vrf avant d'avancer avec les configurations SVI.

Ces caractéristiques peuvent être configurées sous l'onglet Avancé :

- Suppression d'ARP

- Réplication d'entrée

- Groupe de multidiffusion

- DCHP

- Balises d'artère

- TRM

- Route-target L2 VNI

- Passerelle de l'enable L3 au cadre

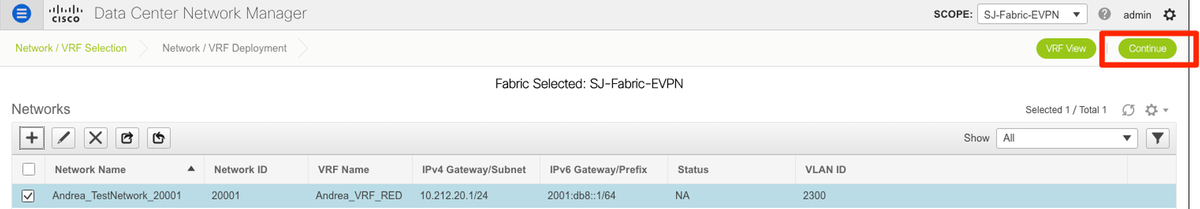

Étape 5. Cliquez sur en fonction Continue de déployer la configuration Network/VRF.

Étape 6. Double-cliquer sur un périphérique (ou des périphériques) dans la vue topologique (DCNM vous prend automatiquement ici), pour les sélectionner pour la configuration applicable. Cliquez sur en fonction la sauvegarde, suivant les indications de l'image.

Étape 7. Une fois que sélectionnés, les Commutateurs devraient sembler bleus (préparez pour se déployer), suivant les indications de cette image.

Remarque: Si vous voulez vérifier la configuration pour le CLI avant de déployer, vous pouvez cliquer sur la vue en fonction détaillée au lieu de déployez et cliquez sur l'aperçu sur l'écran suivant.

Les Commutateurs tournent jaune tandis que la configuration est appliquée et retournera pour le verdir une fois est terminée.

Étape 8. vous (facultatif) pouvez ouvrir une session le CLI pour vérifier la configuration si vous avez besoin ainsi (souvenez-vous pour utiliser l'option de développer-port-profil) :

Configuration multisite

Pour ce déploiement de Greenfield, la matrice MSD est déployée par l'intermédiaire de scruter direct entre les passerelles de cadre (BGWs). Une alternative utilise un serveur de route centralisé, non couvert dans ce document.

Étape 1. Naviguez pour contrôler > builder de matrice > créent la matrice, suivant les indications de l'image.

Étape 2. Donnez à votre matrice multisite un nom et choisissez MSD_Fabric_11_1 dans la baisse vers le bas pour le modèle de matrice.

Étape 3. Sous le général, assurez vos correspondances de chaîne L2 et L3 VNI ce que vos différentes matrices utilisent. Supplémentaire, le MAC de passerelle de cantonade doit s'assortir sur les deux matrices (RTP/SJ dans cet exemple). DCNM te donne une erreur si les MACs de passerelle sont mal adaptés et elle doit être corrigée avant d'avancer avec le déploiement MSD.

Étape 4. La sauvegarde de clic, alors naviguent vers la matrice MSD et cliquent sur en fonction la sauvegarde et se déploient. Votre topologie devrait sembler semblable à ces derniers (tous les Commutateurs + joignent le vert) une fois avec succès terminés :

Déployez les stratégies d'accès au hôte/joncteur réseau

Pour cet exemple, des joncteurs réseau de vpc outre de deux paires différentes VTEP sont configurés et testent la Connectivité dans la matrice locale de RTP. Topologie appropriée suivant les indications de l'image :

Étape 1. Naviguez pour contrôler > des matrices > des interfaces, suivant les indications de l'image.

Étape 2. Cliquez sur + signe d'écrire l'ajouter un assistant d'interface, suivant les indications de l'image.

Dans cet exemple, un joncteur réseau de vpc est en aval créé au N7K qui est utilisé aux tests de ping dans cette revue du projet.

Étape 3. Sélectionnez les paires appropriées de vpc, les interfaces physiques, le LACP "Marche/Arrêt", le BPDUGuard, etc.

Étape 4. Cliquez sur en fonction la sauvegarde une fois terminé. Alternativement, vous pouvez directement se déployer, suivant les indications de l'image.

Examen (facultatif) d'étape 5. la configuration à appliquer.

Configuration manuelle (facultative) d'étape 6. sur 7K :

Étape 7.(Optional) Création d'un test SVI sur N7K pour cingler le VTEPs dans le RTP (VTEPs ont la passerelle de cantonade de 10.212.20.1 dans le VRF andrea_red) :

Étape 8. (facultative) vérifient que l'autre VTEPs dans le RTP voient cet hôte par l'intermédiaire d'EVPN/HMM :

Étape 9.(Optional) Répétez le même processus pour seoul-bb11/12 (créez le Port canalisé de vpc, créez SVI 2300). Cinglement de Rtp-laissé Rtp-droit de confirmer la Connectivité L2 au-dessus d'EVPN dans la matrice de RTP :

Des étapes semblables peuvent être suivies pour créer des Ports canalisés de non-vpc, des interfaces d'accès, etc. sous le contexte d'interfaces d'ajouter.

Exécutions du jour 2

Logiciel de la mise à jour NX-OS par l'intermédiaire de DCNM

Étape 1. Téléchargez une image (ou l'ensemble d'images au serveur de DCNM), et puis naviguez pour contrôler > Gestion d'image > téléchargement d'image, suivant les indications de l'image.

Étape 2. Suivez les demandes pour un téléchargement local, puis les fichiers devraient apparaître suivant les indications de cette image :

Étape 3. Une fois que les fichiers sont téléchargés, vous pouvez passer pour installer et améliorer si les Commutateurs exigent une mise à jour. Naviguez pour contrôler > Gestion d'image > installent et mise à jour, suivant les indications de l'image.

Étape 4. Mettez en position les Commutateurs que vous voudriez mis à jour. Pour cet exemple, la matrice entière de RTP est mise à jour.

Étape 5. Sélectionnez au lequel la version NX-OS vous veulent les Commutateurs mis à jour (comme pratique recommandée, Commutateurs upgrade all à la même version NX-OS) :

Étape 6. Cliquez sur Next et DCNM exécute les Commutateurs par des contrôles de préinstallation. Cette fenêtre peut prendre un tout à fait certain temps, ainsi vous pouvez alternativement sélectionner l'installation de finition plus tard et programmer la mise à jour tandis que vous êtes parti.

Ceci aligne la tâche et ressemble à suivant les indications de l'image ici, une fois que terminé.

Remarque: L'exception sur le cas ci-dessus était l'un des Commutateurs de RTP n'a pas eu assez de pièce pour l'image NX-OS.

Étape 7. Une fois que la compatibilité est faite, cliquez sur en fonction l'installation de finition dans la même fenêtre, suivant les indications de l'image.

Étape 8. Vous pouvez sélectionner les mises à jour pour être simultané (tous en même temps) ou séquentiel fait (un par un). Puisque c'est un environnement de travaux pratiques, sélectionné est simultané.

La tâche est créée et elle semble EN COURS, suivant les indications de l'image.

Une manière alternative de sélectionner l'image est affichée ici.

Installez le localisateur de point final

Pour que les app DCNM fonctionnent correctement, vous devez avoir la Connectivité intrabande entre le serveur DCNM et un port de panneau avant à un du Nexus 9000s dans la matrice. Pour cet exemple, le serveur DCNM est connecté à Ethernet1/5 d'une des épines dans la matrice de RTP.

Étape 1. Ce CLI est ajouté manuellement au Nexus 9000 :

Étape 2. Assurez-vous que vous pouvez cingler le serveur DCNM et vice-versa sur cette connexion point-à-point.

Étape 3. Naviguez vers le DCNM GUI > localisateur de contrôle > de point final > configurent, suivant les indications de l'image.

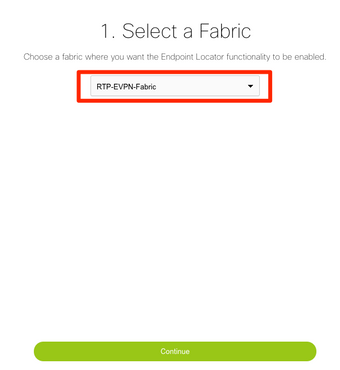

Étape 4. Sélectionnez que la matrice vous veulent que le localisateur de point final soit activé, suivant les indications de l'image.

Étape 5. Suivant les indications de l'image, sélectionnez une épine.

Étape 6. (facultative). Avant d'avancer à l'étape suivante, l'IP eth2 a été changé du déploiement d'origine par l'intermédiaire de ce CLI sur le serveur DCNM (cette étape n'est pas nécessaire si l'IP d'original configuré pendant l'installation fraîche de serveur DCNM reste correct) :

Étape 7. Vérifiez la configuration d'interface d'intrabande. Ceci devrait apparier ce qui a été configuré dans l'étape précédente.

Étape 8. Une fois que vous passez en revue la configuration, cliquez sur en fonction Configure. Cette étape peut prendre quelques minutes :

Une fois que terminée, la notification, suivant les indications de l'image apparaît.

L'avis DCNM a configuré un voisin BGP sur l'épine sélectionnée dans la famille du L2VPN EVPN.

Étape 9. Vous pouvez maintenant utiliser le localisateur de point final. Naviguez pour surveiller > localisateur de point final > les explorent.

Dans cet exemple, vous pouvez voir les deux hôtes qui ont été configurés pour les tests de ping locaux dans la matrice de RTP :

Problèmes produits pendant ce déploiement

Mauvais câblage

Une paire de Commutateurs a eu le mauvais câblage qui a entraîné une erreur de empaquetement pour le vpc peer-link port-channel500. Exemple :

Étape 1. Naviguez de nouveau au contrôle > au builder de matrice et passez en revue les erreurs :

Étape 2. Pour la première erreur concernant la commande port-channel500 manquant — vérifié par l'intermédiaire du show cdp neighbors que la connexion au pair de vpc était sur un 10G et un port 40G (non compatibles). A enlevé le port 10G physiquement et a supprimé le lien de DCNM aussi bien :

Pour configurer une caractéristique

Pour la deuxième erreur concernant le « ngoam de caractéristique » ne pas configurer — le commutateur a été mis à jour à une version plus récente NX-OS où le « ngoam de caractéristique » est pris en charge et à la sauvegarde de clic et se déployer de nouveau. Les deux questions ont été résolues.

Superposez les sous-réseaux de gestion pour différentes matrices

Tandis que la deuxième matrice est déployée, SJ, le même sous-réseau a été utilisé (si physiquement distinct, ceci devrait être CORRECT) ; cependant, DCNM se connecte un conflit et POAP échoue. Ceci est résolu pendant que la matrice SJ est mise un VLAN de gestion différent et en changeant la plage des adresses DHCP.

Interfaces de rubrique

Étape 1. Pour la rubrique relie dans certains des Commutateurs (référez-vous à la topologie), ce CLI a été ajouté manuellement pour les épines de T2 :

Étape 2. Naviguez pour contrôler > des interfaces, et supprimez les interfaces de parent :

Les interfaces réellement utilisées sont Eth1/6/1-4 et Eth1/7/1-4. Si vous ne corrigez pas ceci, la sauvegarde et Deploy échoueront plus tard. Il y a une manière de faire la rubrique par DCNM elle-même (bouton à côté de + signe ; cependant, non couvert en cet article)

Erreur de matrice une fois déployé vers la capacité non vérifiée

Une partie du châssis (T2s) dans la matrice SJ ne prend en charge pas TRM ainsi quand DCNM essayé pour pousser cette configuration, il ne pouvait pas avancer. Support TRM ici : https://www.cisco.com/c/en/us/td/docs/switches/datacenter/nexus9000/sw/92x/vxlan-92x/configuration/guide/b-cisco-nexus-9000-series-nx-os-vxlan-configuration-guide-92x/b_Cisco_Nexus_9000_Series_NX-OS_VXLAN_Configuration_Guide_9x_chapter_01001.html#concept_vw1_syb_zfb

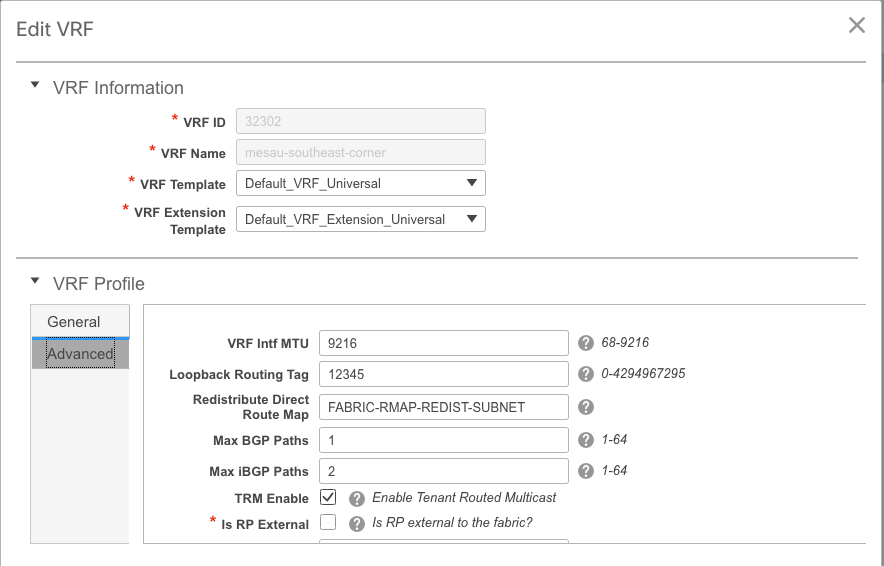

A décoché la case d'enable TRM sous le réseau et le VRF éditent des fenêtres est affiché dans l'image.

Répétez le même processus sous le contrôle > le builder > le VRF de matrice.

Cliquez sur continuent et se déploient alors respectivement comme fait précédemment.

Qu'est qu'il y a de neuf dans DCNM 11.2 ?

-

scruter de matrice de vpc

-

matrices conduites basées par eBGP

-

Enable EVPN sur le dessus

-

-

Améliorations faciles de Brownfield de matrice

-

Épine gw d'épine de cadre/cadre

-

PIM Bidir

-

Multidiffusion conduite par locataire

-

-

Day-0/Bootstrap avec le serveur DHCP externe

Exécutions du jour 2 :

-

Ressources en vues de réseau

-

Conseiller de vues de réseau

-

Soutien d'IPv6 de l'accès externe (eth0)

-

VMM visibilité de calcul avec UCS-FI

-

Améliorations de vue topologique

-

Mise à jour intégrée de 11.0/11.1

Changer du vpc traditionnel au vpc sans MCT utilisant DCNM :

Avantages de vpc sans MCT :

-

Solution améliorée d'attachement secouru "dual homing" sans gaspiller des ports physiques

-

Préserve des caractéristiques traditionnelles de vpc

-

Routage optimisé pour des points finaux autoguidés choisis avec le PIP

Informations connexes

- Guide de configuration de matrice de RÉSEAU LOCAL de Cisco DCNM, version 11.2(1)

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/control.html - Chapitre : Cas d'utilisation de ravitaillement de cadre dans des matrices BGP EVPN VXLAN - multisites

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/border-provisioning-multisite.html - NextGen DCI avec VXLAN EVPN multisite utilisant Livre Blanc de passerelles de cadre de vpc

https://www.cisco.com/c/en/us/products/collateral/switches/nexus-9000-series-switches/whitepaper-c11-742114.html#_Toc5275096 - Chapitre : Applications DCNM

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/applications.html

Contribution d’experts de Cisco

- Andrea TestinoConstruction de Cisco

Contacter Cisco

- Ouvrir un dossier d’assistance

- (Un contrat de service de Cisco est requis)

Commentaires

Commentaires