Introducción

Este documento describe cómo configurar la unidad de transición máxima jumbo (MTU) de extremo a extremo en los dispositivos de Cisco Data Center.

Prerequisites

Requirements

Cisco recomienda que tenga conocimiento sobre estos temas:

- VMware ESXi

- Cisco UCS

- Cisco N5k

- Interfaz Cisco Internet Small Computer Systems Interface (iSCSI)

Componentes Utilizados

Este documento describe cómo configurar una unidad de transición máxima (MTU) gigantesca de extremo a extremo en los dispositivos de Data Center de Cisco en una red que consta de un host VMware ESXi instalado en Cisco Unified Computing System (UCS), switches Nexus de Cisco serie 1000V (N1kV), switches Nexus de Cisco serie 5000 (N5k) y el controlador NetApp de Cisco.

La información que contiene este documento se basa en las siguientes versiones de software y hardware.

- Switches Nexus de Cisco serie 5020 versión 5.0(3)N2(2a)

- Cisco UCS versión 2.1(1d)

- Servidor blade Cisco UCS B200 M3 con tarjeta de interfaz virtual (VIC) Cisco 1240

- vSphere 5.0 (ESXi y vCenter)

- Cisco N1kV versión 4.2(1)SV2(2.1a)

- NetApp FAS 3240

La información que contiene este documento se creó a partir de los dispositivos en un ambiente de laboratorio específico. Todos los dispositivos que se utilizan en este documento se pusieron en funcionamiento con una configuración verificada (predeterminada). Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

Configurar

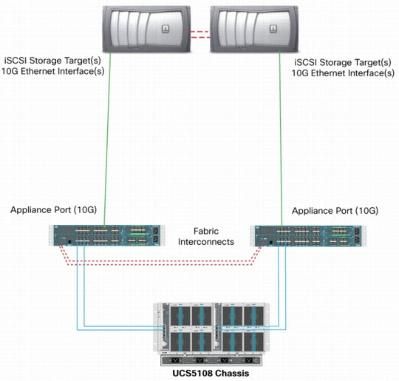

Diagrama de la red

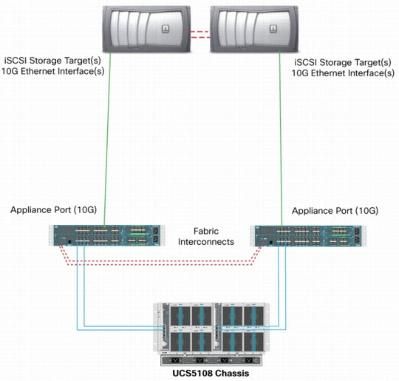

La implementación típica de la red de área de almacenamiento (SAN) iSCSI utiliza Cisco UCS con Fabric Interconnect en modo de host final Ethernet y el destino de almacenamiento conectado a través de un switch ascendente o una red conmutada.

Mediante el uso de los puertos del equipo en el UCS, el almacenamiento se puede conectar directamente a las Fabric Interconnects.

Tanto si la red ascendente es de 1 GbE como de 10 GbE, el uso de tramas gigantes (un tamaño de MTU de 9000, por ejemplo) mejora el rendimiento porque reduce el número de tramas individuales que se deben enviar para una cantidad determinada de datos y reduce la necesidad de separar bloques de datos iSCSI en varias tramas Ethernet. También disminuyen la utilización de la CPU del host y del almacenamiento.

Si se utilizan tramas gigantes, asegúrese de que UCS y el destino de almacenamiento, así como todo el equipo de red que haya entre ellos, sean capaces y estén configurados para admitir el tamaño de trama más grande.

Esto significa que la MTU jumbo se debe configurar de extremo a extremo (de iniciador a destino) para que sea efectiva en todo el dominio.

A continuación se presenta una descripción general del procedimiento que se utiliza para configurar la MTU jumbo de extremo a extremo:

- Cree una clase de sistema de calidad de servicio (QoS) de UCS con una MTU de 9000 y, a continuación, configure la NIC virtual (vNIC) con una MTU gigante.

- Habilite las tramas jumbo (MTU 9000) en todos los switches entre el iniciador (UCS) y el destino iSCSI.

- Habilite las tramas jumbo en el adaptador del sistema operativo (SO) (puerto VMkernel de ESXi).

- Habilite las tramas jumbo en las interfaces de NetApp.

Nota: Consulte el artículo Opciones y prácticas recomendadas de conectividad de almacenamiento de Cisco Unified Computing System (UCS) con almacenamiento NetApp de Cisco para obtener más información.

Configuración de Cisco UCS

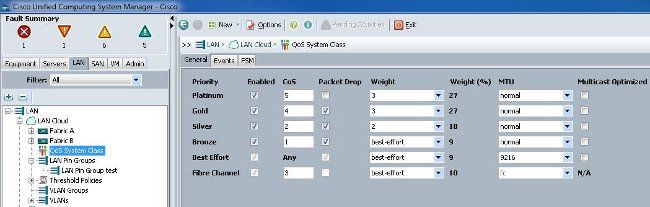

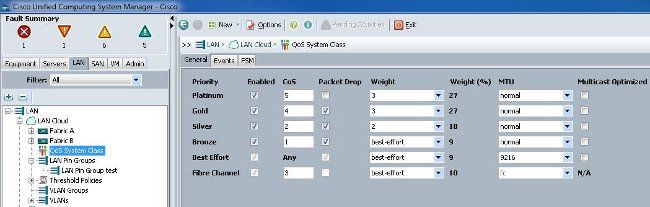

La MTU se establece en función de la clase de servicio (CoS) dentro de UCS. Si no tiene una política de QoS definida para la vNIC que se dirige hacia el vSwitch, el tráfico se traslada a la clase de mejor esfuerzo.

Complete estos pasos para habilitar las tramas jumbo:

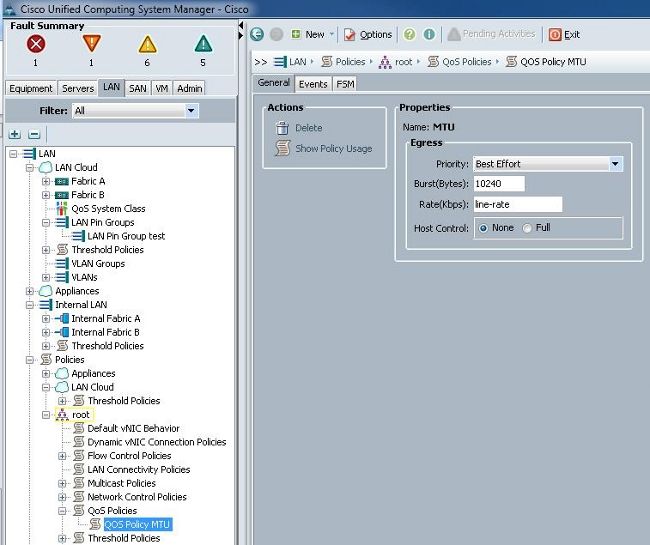

- En la GUI de UCS, haga clic en la pestaña LAN.

- Vaya a LAN > LAN Cloud > QoS System Class.

- Haga clic en QoS System Class y cambie la clase de tráfico (que transporta el tráfico iSCSI) MTU a 9216.

Nota: Este ejemplo utiliza la clase de tráfico Best Effort para ilustrar esta actualización de MTU.

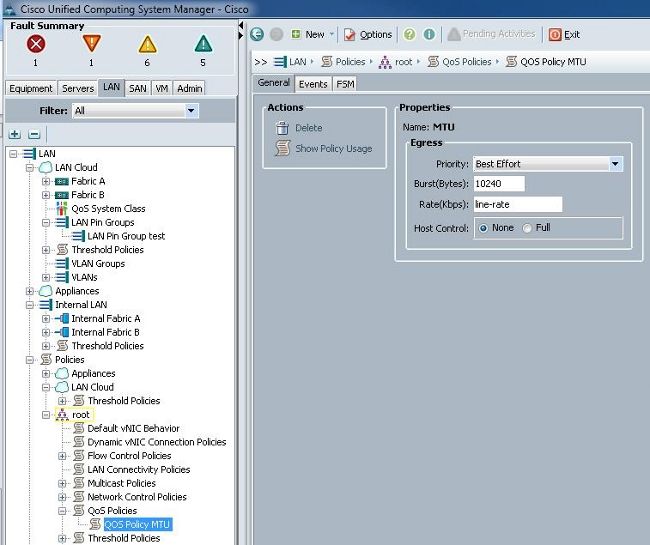

- Cree una política de QoS en la ficha LAN y aplíquela a la vNIC que transporta el tráfico de almacenamiento.

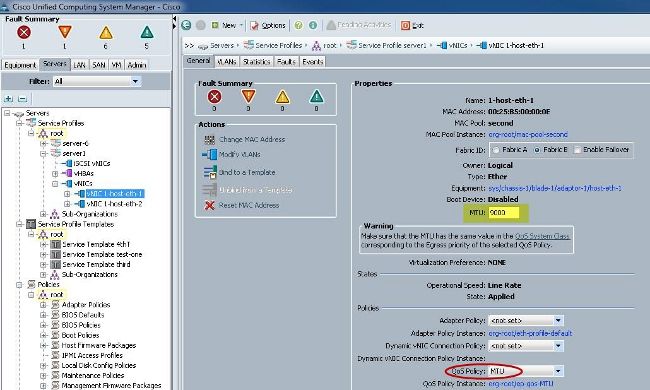

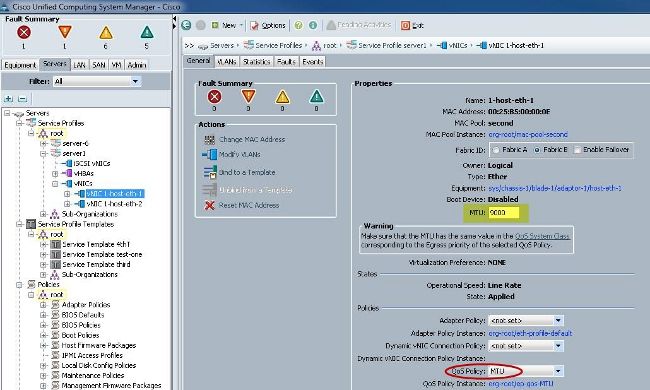

- Navegue hasta la plantilla vNIC o la vNIC real en Perfiles de servicio y establezca el valor de MTU en 9000.

Verificación

Verifique que la vNIC tenga la MTU configurada como se describió anteriormente.

Verifique que los puertos de link ascendente tengan habilitada la MTU jumbo.

Configuración de N5k

Con N5k, la MTU jumbo se habilita en el nivel del sistema.

Abra un símbolo del sistema e ingrese estos comandos para configurar el sistema para la MTU jumbo:

switch(config)#policy-map type network-qos jumbo

switch(config-pmap-nq)#class type network-qos class-default

switch(config-pmap-c-nq)#mtu 9216

switch(config-pmap-c-nq)#exit

switch(config-pmap-nq)#exit

switch(config)#system qos

switch(config-sys-qos)#service-policy type network-qos jumbo

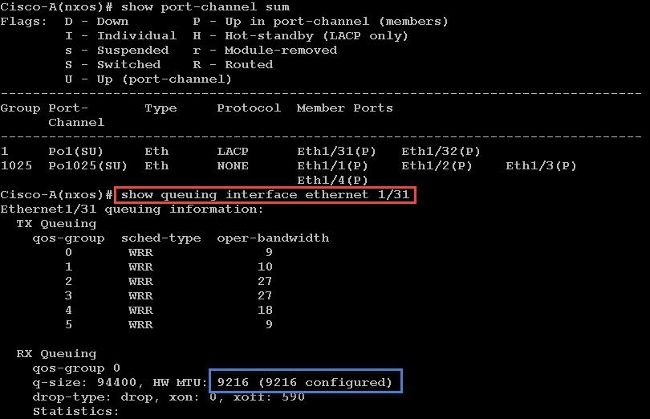

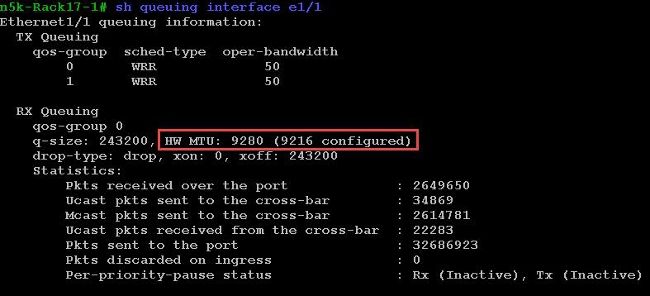

Verificación

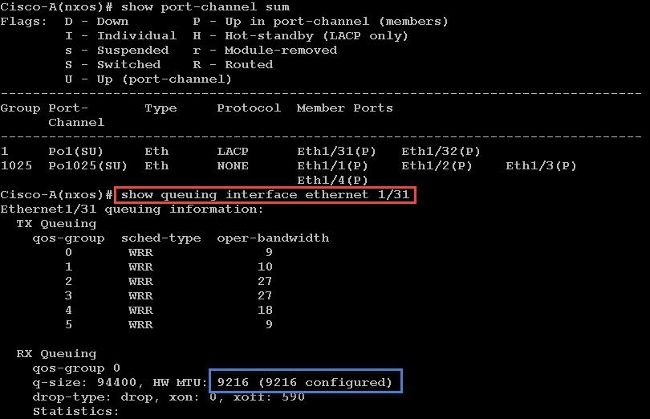

Ingrese el comando show queuing interface Ethernet x/y para verificar que la MTU jumbo está habilitada:

Nota: El comando show interface Ethernet x/y muestra una MTU de 1500, pero eso es incorrecto.

Configuración de VMware ESXi

Puede configurar el valor de MTU de un vSwitch para que todos los grupos de puertos y puertos utilicen tramas jumbo.

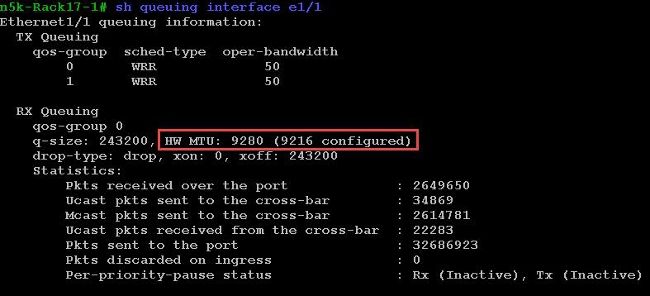

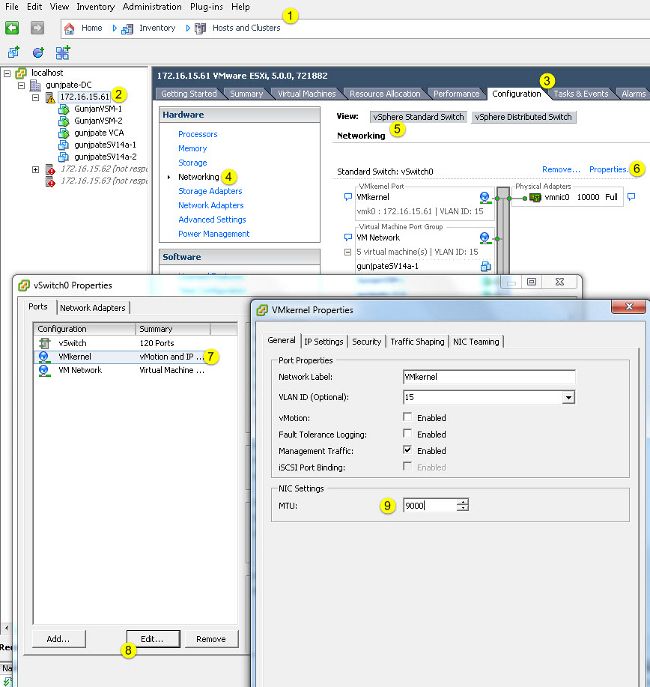

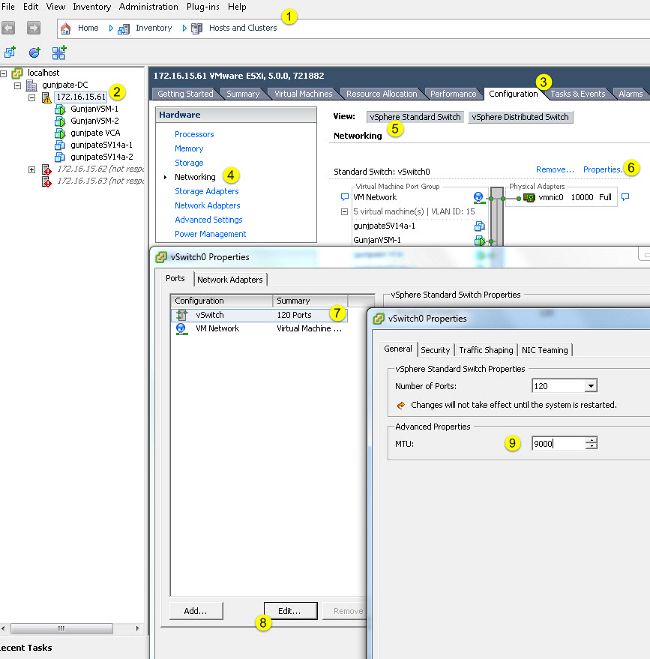

Complete estos pasos para habilitar las tramas jumbo en un vSwitch host:

- Vaya a Inicio > Inventario > Hosts y clústeres desde el cliente vSphere.

- Seleccione el host.

- Haga clic en la pestaña Configuration.

- Seleccione Networking en el menú Hardware.

- Elija vSphere Standard Switch en el campo View.

- Haga clic en Properties (Propiedades).

- Seleccione vSwitch en la ficha Puertos de la ventana emergente Propiedades.

- Haga clic en Editar.

- En la ficha General de la ventana emergente, cambie la MTU (en Propiedades avanzadas) del valor predeterminado (1500) a 9000. Esto habilita tramas jumbo en todos los grupos de puertos y puertos del vSwitch.

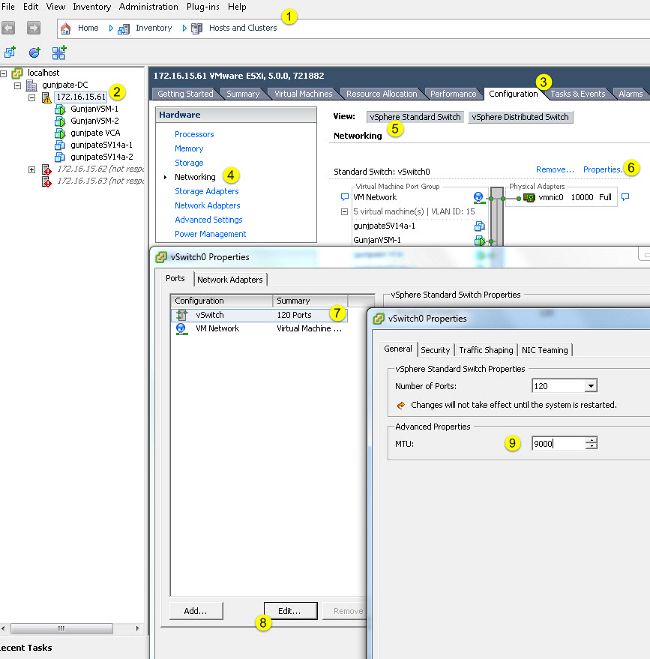

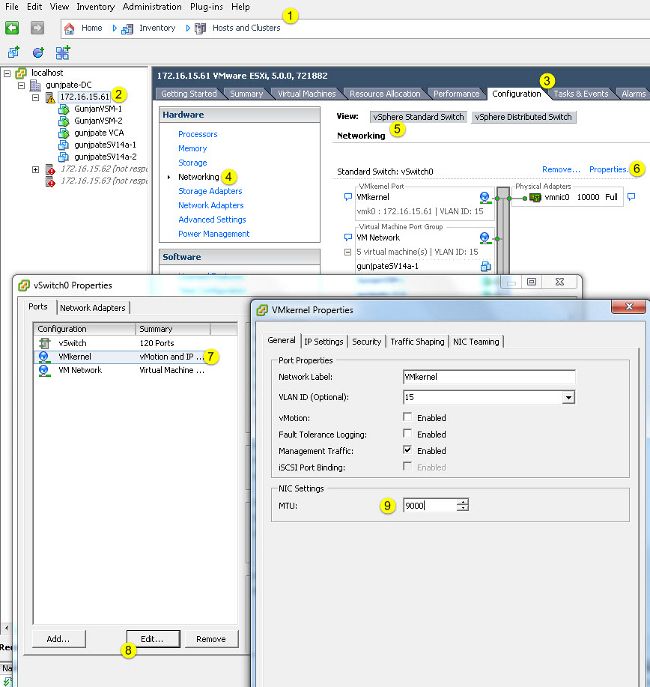

Complete estos pasos para habilitar las tramas jumbo solamente en un puerto VMkernel desde el servidor vCenter:

- Desde el cliente vSphere, navegue hasta Inicio > Inventario > Hosts y clústeres.

- Seleccione el host.

- Haga clic en la pestaña Configuration.

- Seleccione Networking en el menú Hardware.

- Elija vSphere Standard Switch en el campo View.

- Haga clic en Properties (Propiedades).

- Seleccione VMkernel en la ficha Puertos de la ventana emergente Propiedades.

- Haga clic en Editar.

- En la ficha General de la ventana emergente, cambie la MTU (en Configuración NIC) del valor predeterminado (1500) a 9000. Esto habilita las tramas jumbo sólo en un puerto VMkernel del vSwitch.

Verificación

Ingrese el comando vmkping -d -s 8972 <dirección ip del dispositivo de almacenamiento> para probar la conectividad de red y verificar que el puerto VMkernel pueda hacer ping con la MTU jumbo.

Sugerencia: Consulte el artículo Prueba de conectividad de red VMkernel con el comando vmkping VMware para obtener más información sobre este comando.

Nota: El tamaño de paquete real más grande es 8972, que envía un paquete de 9000 bytes cuando agrega los bytes de encabezado ICMP e IP.

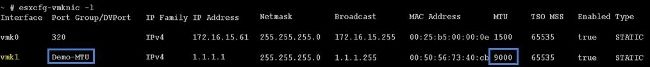

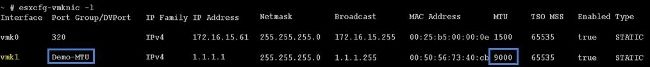

En el nivel de host de ESXi, compruebe que los parámetros de MTU se han configurado correctamente:

Configuración de Cisco IOS

Con los switches Cisco IOS®, no existe el concepto de MTU global en el nivel del switch. En su lugar, la MTU se configura en el nivel de interfaz/canal Ethernet.

Ingrese estos comandos para configurar la MTU jumbo:

7609(config)#int gigabitEthernet 1/1

7609(config-if)#mtu ?

<1500-9216> MTU size in bytes

7609(config-if)#mtu 9216

Verificación

Ingrese el comando show interfaces gigabitEthernet 1/1 para verificar que la configuración sea correcta:

7609#show interfaces gigabitEthernet 1/1

GigabitEthernet1/1 is up, line protocol is up (connected)

Hardware is C6k 1000Mb 802.3, address is 0007.0d0e.640a (bia 0007.0d0e.640a)

MTU 9216 bytes, BW 1000000 Kbit, DLY 10 usec,

reliability 255/255, txload 1/255, rxload 1/255

Configuración de N1kV

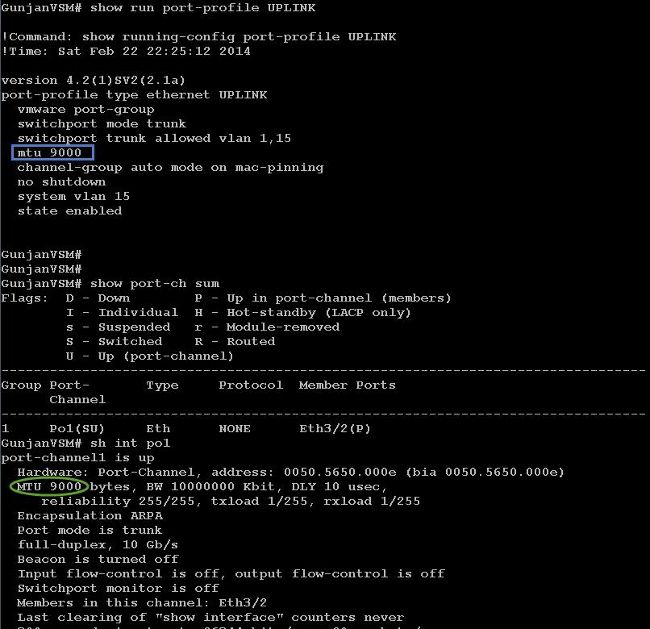

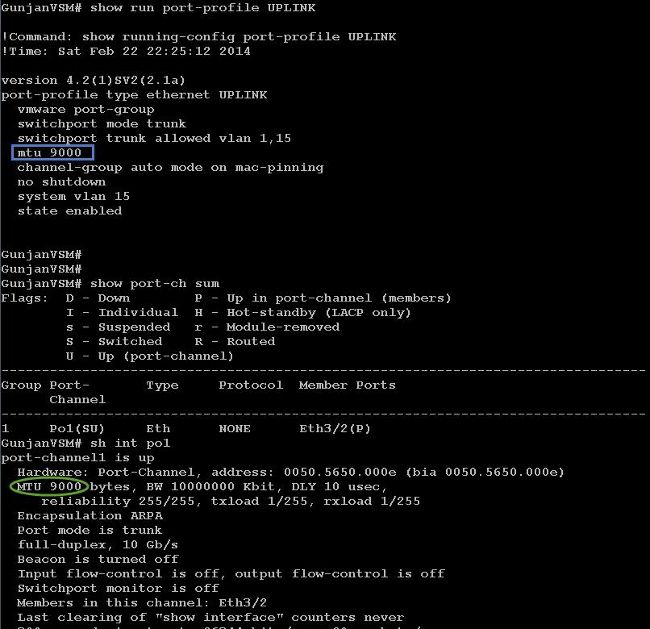

Con el N1kV, la MTU jumbo sólo se puede configurar en los perfiles de puerto Ethernet para el enlace ascendente; la MTU no se puede configurar en la interfaz vEthernet.

Verificación

Ingrese el comando show run port-profile UPLINK para verificar que la configuración sea correcta:

Configuración de NetApp FAS 3240

En el controlador de almacenamiento, los puertos de red conectados a Fabric Interconnect o al switch de capa 2 (L2) deben tener configurada la MTU jumbo. Aquí hay un ejemplo de configuración:

FAS3240-A> vlan create e1a 100

Ethernet e1a: Link being reconfigured.

vlan: e1a-100 has been created

Ethernet e1a: Link up.

FAS3240-A> vlan create e1b 100

Ethernet e1b: Link being reconfigured.

vlan: e1b-100 has been created

Ethernet e1b: Link up.

FAS3240-A> ifconfig e1a-100 192.168.101.105 netmask 255.255.255.0 mtusize 9000

partner e1a-100

FAS3240-A> ifconfig e1b-100 192.168.102.105 netmask 255.255.255.0 mtusize 9000

partner e1b-100

Verificación

Utilice esta sección para verificar que la configuración es correcta.

FAS3240-A> ifconfig –a

e1a: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2c (auto-10g_twinax-fd-up) flowcontrol full

e1b: flags=0x80f0c867<BROADCAST,RUNNING,MULTICAST,TCPCKSUM,VLAN> mtu 9000

ether 00:c0:dd:11:40:2e (auto-10g_twinax-fd-up) flowcontrol full

Comentarios

Comentarios