Configuración de la función VXLAN en dispositivos Cisco IOS XE

Opciones de descarga

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Contenido

Introducción

Este documento describe la configuración básica y la resolución de problemas en los dispositivos Cisco IOS® XE.

Prerequisites

Requirements

Cisco recomienda que tenga conocimiento sobre estos temas:

- Comprensión básica de DCI overlays y multicast

Componentes Utilizados

La información que contiene este documento se basa en las siguientes versiones de software y hardware.

- ASR1004 con software 03.16.00.S

- CSR100v(VXE) que ejecuta el software 3.16.03.S

La información que contiene este documento se creó a partir de los dispositivos en un ambiente de laboratorio específico. Todos los dispositivos que se utilizan en este documento se pusieron en funcionamiento con una configuración verificada (predeterminada). Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

Antecedentes

La LAN extensible virtual (VXLAN) es cada vez más popular como solución de interconexión del Data Center (DCI). La función VXLAN se utiliza para proporcionar extensión de capa 2 sobre el dominio de routing público/de capa 3. Este documento describe la configuración básica y la resolución de problemas en los dispositivos Cisco IOS XE.

Las secciones Configurar y Verificar de este documento cubren dos escenarios:

- El escenario A describe una configuración VXLAN entre tres Data Centers en modo multidifusión.

- El escenario B describe una configuración VXLAN entre dos Data Centers en modo unidifusión.

Configurar

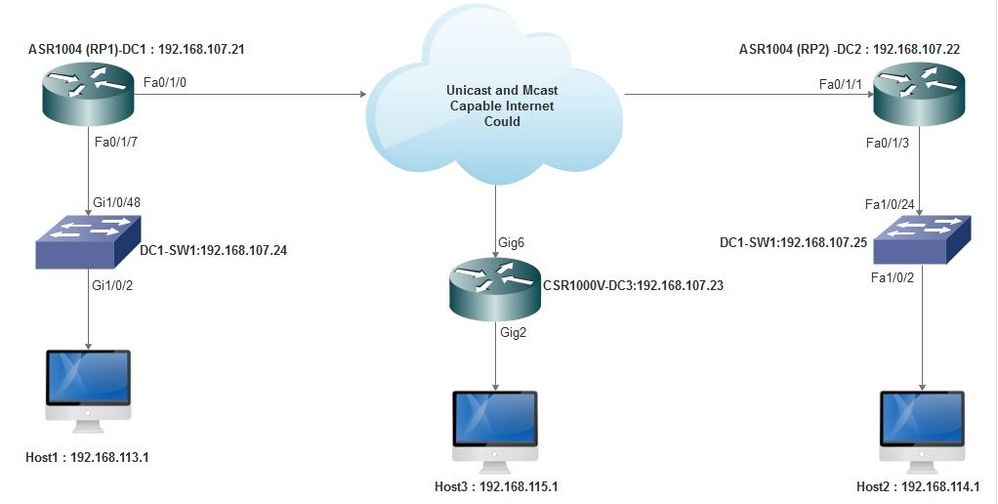

Situación A: Configuración de VXLAN entre tres Data Centers en modo multidifusión

Configuración base

El modo multidifusión requiere conectividad de unidifusión y multidifusión entre sitios. Esta guía de configuración utiliza OSPF (Open Shortest Path First) para proporcionar conectividad de unidifusión y PIM (Protocol Independent Multicast) bidireccional para proporcionar conectividad de multidifusión.

Esta es la configuración básica de los tres Data Centers para el modo de funcionamiento multidifusión:

! DC1#show run | sec ospf router ospf 1 network 10.1.1.1 0.0.0.0 area 0 network 10.10.10.4 0.0.0.3 area 0

!

Configuración bidireccional de PIM:

!

DC1#show run | sec pim ip pim bidir-enable ip pim send-rp-discovery scope 10 ip pim bsr-candidate Loopback1 0 ip pim rp-candidate Loopback1 group-list 10 bidir ! access-list 10 permit 239.0.0.0 0.0.0.255

!

DC1#

!

Además, el modo disperso de PIM se habilita en todas las interfaces L3, incluido el loopback:

!

DC1#show run interface lo1 Building configuration... Current configuration : 83 bytes ! interface Loopback1 ip address 10.1.1.1 255.255.255.255 ip pim sparse-mode end

Asegúrese también de que el ruteo multicast esté habilitado en su dispositivo y de que vea la tabla de multicast mroute que se está llenando.

Diagrama de la red

Internet compatible con unidifusión y multidifusión

Internet compatible con unidifusión y multidifusión

Configuración de DC1 (VTEP1)

! ! Vxlan udp port 1024 ! Interface Loopback1 ip address 10.1.1.1 255.255.255.255 ip pim sparse-mode !

Defina los miembros VNI y la interfaz miembro en configuración de dominio de puente:

! bridge-domain 1 member vni 6001 member FastEthernet0/1/7 service-instance 1 !

Cree la interfaz virtual de red (NVE) y defina los miembros de VNI que deben ampliarse a otros Data Centers a través de la WAN:

! interface nve1 no ip address shut member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 !

Cree instancias de servicio a través de la interfaz LAN (es decir, la interfaz que conecta la red LAN) para superponer la VLAN concreta (tráfico etiquetado 802.1q); en este caso, VLAN 1:

! interface FastEthernet0/1/7 no ip address negotiation auto cdp enable no shut !

Quite la etiqueta VLAN antes de enviar el tráfico a través de la superposición y empújela después de que el tráfico de retorno se envíe a la VLAN:

! service instance 1 ethernet encapsulation unagged !

Configuración de DC2 (VTEP2)

! ! Vxlan udp port 1024 ! interface Loopback1 ip address 10.2.2.2 255.255.255.255 ip pim sparse-mode ! ! bridge-domain 1 member vni 6001 member FastEthernet0/1/3 service-instance 1 ! ! interface nve1 no ip address member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 shut ! ! interface FastEthernet0/1/3 no ip address negotiation auto cdp enable no shut ! service instance 1 ethernet encapsulation untagged !

Configuración de DC3 (VTEP3)

! ! Vxlan udp port 1024 ! interface Loopback1 ip address 10.3.3.3 255.255.255.255 ip pim sparse-mode ! ! bridge-domain 1 member vni 6001 member GigabitEthernet2 service-instance 1 ! interface nve1 no ip address shut member vni 6001 mcast-group 10.0.0.10 ! source-interface Loopback1 ! interface gig2 no ip address negotiation auto cdp enable no shut ! service instance 1 ethernet encapsulation untagged !

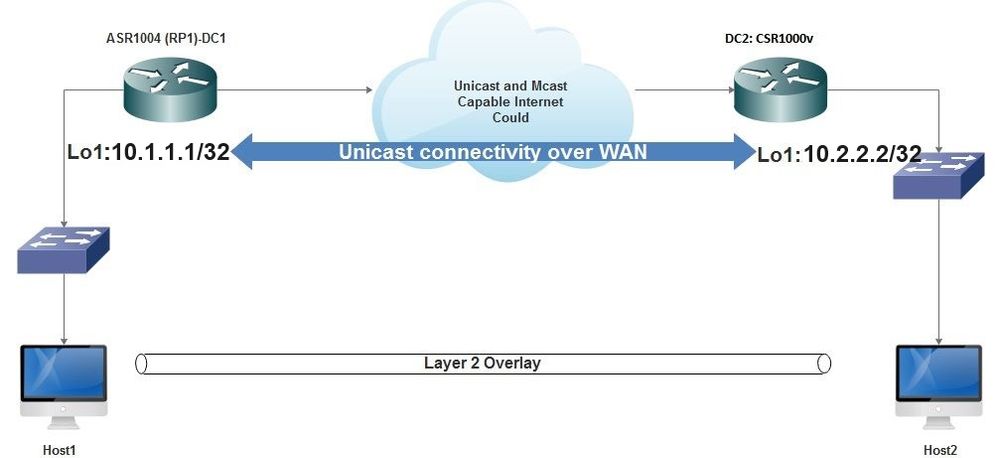

Situación B: Configuración de VXLAN entre dos Data Centers en modo unidifusión

Diagrama de la red

Conectividad unidifusión sobre WAN

Conectividad unidifusión sobre WAN

Configuración de DC1

! interface nve1 no ip address member vni 6001 ! ingress replication shold be configured as peer data centers loopback IP address. ! ingress-replication 10.2.2.2 ! source-interface Loopback1 ! ! interface gig0/2/1 no ip address negotiation auto cdp enable ! service instance 1 ethernet encapsulation untagged ! ! ! bridge-domain 1 member vni 6001 member gig0/2/1 service-instance 1

Configuración de DC2

! interface nve1 no ip address member vni 6001 ingress-replication 10.1.1.1 ! source-interface Loopback1 ! ! interface gig5 no ip address negotiation auto cdp enable ! service instance 1 ethernet encapsulation untagged ! ! bridge-domain 1 member vni 6001 member gig5 service-instance 1

Verificación

Situación A: Configuración de VXLAN entre tres Data Centers en modo multidifusión

Una vez finalizada la configuración para el escenario A, los hosts conectados de cada Data Center deben poder comunicarse entre sí dentro del mismo dominio de difusión.

Utilice estos comandos para verificar las configuraciones. En el escenario B se proporcionan algunos ejemplos.

Router#show nve vni Router#show nve vni interface nve1 Router#show nve interface nve1 Router#show nve interface nve1 detail Router#show nve peers

Situación B: Configuración de VXLAN entre dos Data Centers en modo unidifusión

En DC1:

DC1#show nve vni Interface VNI Multicast-group VNI state nve1 6001 N/A Up DC1#show nve interface nve1 detail Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan source-interface: Loopback1 (primary:10.1.1.1 vrf:0) Pkts In Bytes In Pkts Out Bytes Out 60129 6593586 55067 5303698 DC1#show nve peers Interface Peer-IP VNI Peer state nve1 10.2.2.2 6000 -

En DC2:

DC2#show nve vni

Interface VNI Multicast-group VNI state

nve1 6000 N/A Up

DC2#show nve interface nve1 detail

Interface: nve1, State: Admin Up, Oper Up Encapsulation: Vxlan

source-interface: Loopback1 (primary:10.2.2.2 vrf:0)

Pkts In Bytes In Pkts Out Bytes Out

70408 7921636 44840 3950835

DC2#show nve peers

Interface Peer-IP VNI Peer state

nve 10.1.1.1 6000 Up

DC2#show bridge-domain 1

Bridge-domain 1 (3 ports in all)

State: UP Mac learning: Enabled

Aging-Timer: 300 second(s)

BDI1 (up)

GigabitEthernet0/2/1 service instance 1

vni 6001

AED MAC address Policy Tag Age Pseudoport

0 7CAD.74FF.2F66 forward dynamic 281 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 B838.6130.DA80 forward dynamic 288 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

0 0050.56AD.1AD8 forward dynamic 157 nve1.VNI6001, VxLAN src: 10.1.1.1 dst: 10.2.2.2

Troubleshoot

Los comandos descritos en la sección Verificar proporcionan pasos básicos para la resolución de problemas. Estos diagnósticos adicionales pueden ser útiles cuando el sistema no funciona.

Nota: algunos de estos diagnósticos pueden causar un aumento de la utilización de la memoria y la CPU.

Diagnóstico de depuración

#debug nve error

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.993: NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes cast nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes eer nodes

*Jan 4 20:00:54.995: NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

#show nve log error

[01/01/70 00:04:34.130 UTC 1 3] NVE-MGR-STATE ERROR: vni 6001: error in create notification to Tunnel

[01/01/70 00:04:34.314 UTC 2 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 00:04:34.326 UTC 3 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:50:59.650 UTC 4 3] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:50:59.654 UTC 5 3] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:50:59.701 UTC 6 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:50:59.705 UTC 7 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:54:55.166 UTC 8 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

[01/01/70 01:54:55.168 UTC 9 61] NVE-MGR-PEER ERROR: Intf state force down successful for peer nodes

[01/01/70 01:55:04.432 UTC A 3] NVE-MGR-PEER ERROR: Intf state force up successful for mcast nodes

[01/01/70 01:55:04.434 UTC B 3] NVE-MGR-PEER ERROR: Intf state force up successful for peer nodes

[01/01/70 01:55:37.670 UTC C 61] NVE-MGR-PEER ERROR: Intf state force down successful for mcast nodes

#show nve log event

[01/04/70 19:48:51.883 UTC 1DD16 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD17 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:48:51.884 UTC 1DD18 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD19 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.884 UTC 1DD1A 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1B 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:01.885 UTC 1DD1C 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1D 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.886 UTC 1DD1E 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD1F 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

[01/04/70 19:49:11.887 UTC 1DD20 68] NVE-MGR-DB: Return vni 6001 for pi_hdl[0x437C9B68]

[01/04/70 19:49:21.884 UTC 1DD21 68] NVE-MGR-DB: Return pd_hdl[0x1020010] for pi_hdl[0x437C9B68]

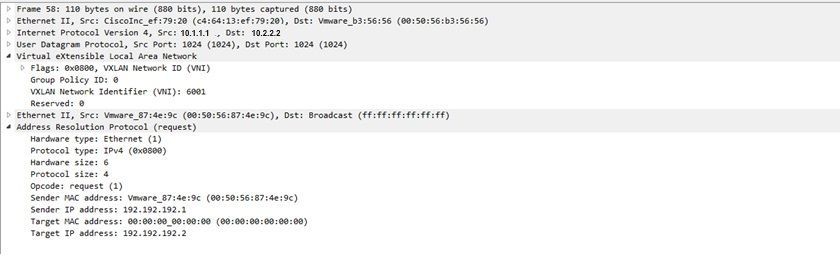

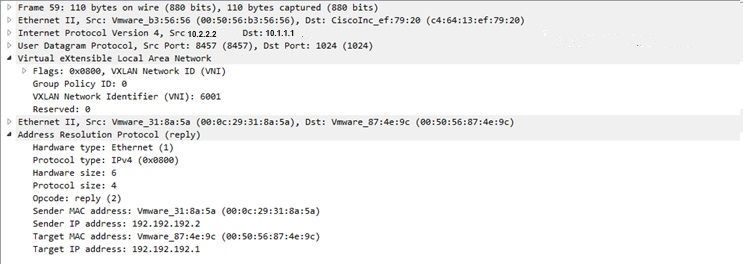

Captura de paquetes integrada

Captura de paquetes integradaLa función Embedded Packet Capture (EPC), disponible en el software Cisco IOS XE, puede proporcionar información adicional para la resolución de problemas.

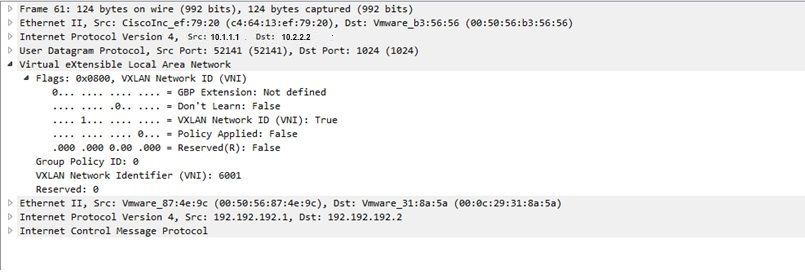

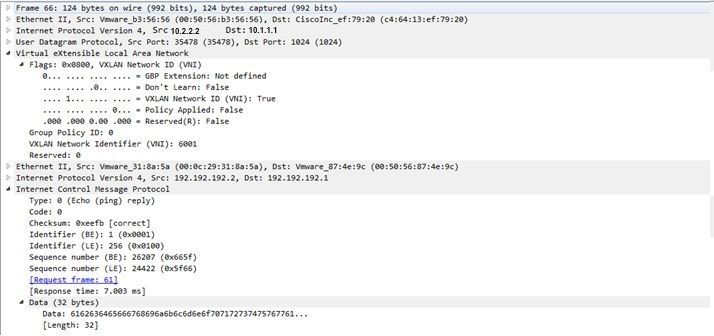

Por ejemplo, esta captura explica el paquete encapsulado por VXLAN:

Configuración EPC (TEST_ACL es la lista de acceso utilizada para filtrar los datos de captura):

#monitor capture TEST access-list TEST_ACL interface gigabitEthernet0/2/0 both #monitor capture TEST buffer size 10 #monitor capture TEST start Aquí está el volcado de paquetes que resulta:

# show monitor capture TEST buffer dump # monitor capture TEST export bootflash:TEST.pcap // with this command you can export the capture in pcap format to the bootflash, which can be downloaded and opened in wireshark. Este es un ejemplo que explica cómo funciona el Protocolo de mensajes de control de Internet (ICMP) simple sobre VXLAN.

Protocolo de resolución de direcciones (ARP) enviado sobre la superposición VXLAN:

Respuesta ARP:

Solicitud ICMP:

Respuesta ICMP:

Comandos adicionales de depuración y solución de problemas

Comandos adicionales de depuración y solución de problemasEn esta sección se describen algunos comandos más de depuración y solución de problemas.

En este ejemplo, las partes resaltadas del debug muestran que la interfaz NVE no pudo unirse al grupo multicast. Por lo tanto, la encapsulación VXLAN no estaba habilitada para VNI 6002. Estos resultados de depuración señalan problemas de multidifusión en la red.

#debug nve all

*Jan 5 06:13:55.844: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:13:55.846: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was failure

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-DB ERROR: Unable to join mcast core tree

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.846: NVE-MGR-STATE ERROR: vni 6002: error in create notification to mcast

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:13:55.849: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:13:55.851: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:13:55.857: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:13:55.857: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Down

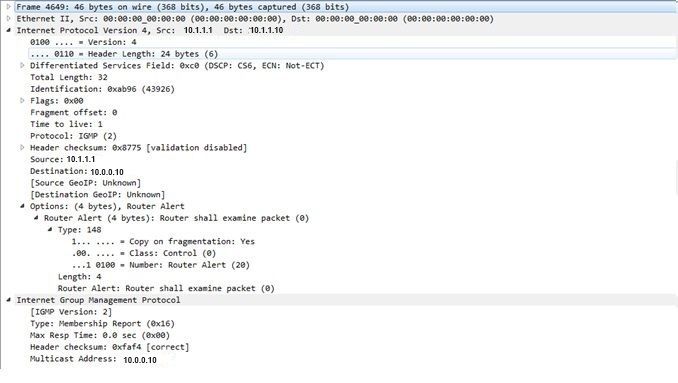

Este es el informe de afiliación al protocolo de administración de grupos de Internet (IGMP) que se puede enviar una vez que el VNI se une al grupo mcast:

Este ejemplo muestra el resultado de depuración esperado después de configurar un VNI en NVE para el modo Multicast, si Multicast está funcionando como se esperaba:

*Jan 5 06:19:20.335: NVE-MGR-DB: [IF 0x14]VNI node creation

*Jan 5 06:19:20.335: NVE-MGR-DB: VNI Node created [437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 create notification to PD

*Jan 5 06:19:20.336: NVE-MGR-PD: VNI 6002 Create notif successful, map [pd 0x1020017] to [pi 0x437C9B28]

*Jan 5 06:19:20.336: NVE-MGR-DB: creating mcast node for 10.0.0.10

*Jan 5 06:19:20.342: NVE-MGR-MCAST: IGMP add for (0.0.0.0,10.0.0.10) was successful

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Tunnel Endpoint 10.0.0.10 added

*Jan 5 06:19:20.345: NVE-MGR-TUNNEL: Endpoint 10.0.0.10 added

*Jan 5 06:19:20.347: NVE-MGR-EI: Notifying BD engine of VNI 6002 create

*Jan 5 06:19:20.347: NVE-MGR-DB: Return pd_hdl[0x1020017] for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.347: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni state Create for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.349: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.351: NVE-MGR-EI: L2FIB query for info 0x437C9B28

*Jan 5 06:19:20.351: NVE-MGR-EI: PP up notification for bd_id 3

*Jan 5 06:19:20.351: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.352: NVE-MGR-STATE: vni 6002: Notify clients of state change Create to Up

*Jan 5 06:19:20.352: NVE-MGR-DB: Return vni 6002 for pi_hdl[0x437C9B28]

*Jan 5 06:19:20.353: NVE-MGR-PD: VNI 6002 Create to Up State update to PD successful

*Jan 5 06:19:20.353: NVE-MGR-EI: VNI 6002: BD state changed to up, vni state to Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: No state change Up

*Jan 5 06:19:20.353: NVE-MGR-STATE: vni 6002: New State as a result of create Up

Información Relacionada

Información Relacionada Historial de revisiones

| Revisión | Fecha de publicación | Comentarios |

|---|---|---|

2.0 |

04-Dec-2023 |

Recertificación |

1.0 |

03-Nov-2016 |

Versión inicial |

Con la colaboración de ingenieros de Cisco

- Shambhu MishraCisco TAC Engineer

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios