Sustitución de la placa base en el servidor Ultra-M UCS 240M4 - CPAR

Opciones de descarga

-

ePub (3.3 MB)

Visualice en diferentes aplicaciones en iPhone, iPad, Android, Sony Reader o Windows Phone -

Mobi (Kindle) (2.7 MB)

Visualice en dispositivo Kindle o aplicación Kindle en múltiples dispositivos

Lenguaje no discriminatorio

El conjunto de documentos para este producto aspira al uso de un lenguaje no discriminatorio. A los fines de esta documentación, "no discriminatorio" se refiere al lenguaje que no implica discriminación por motivos de edad, discapacidad, género, identidad de raza, identidad étnica, orientación sexual, nivel socioeconómico e interseccionalidad. Puede haber excepciones en la documentación debido al lenguaje que se encuentra ya en las interfaces de usuario del software del producto, el lenguaje utilizado en función de la documentación de la RFP o el lenguaje utilizado por un producto de terceros al que se hace referencia. Obtenga más información sobre cómo Cisco utiliza el lenguaje inclusivo.

Acerca de esta traducción

Cisco ha traducido este documento combinando la traducción automática y los recursos humanos a fin de ofrecer a nuestros usuarios en todo el mundo contenido en su propio idioma. Tenga en cuenta que incluso la mejor traducción automática podría no ser tan precisa como la proporcionada por un traductor profesional. Cisco Systems, Inc. no asume ninguna responsabilidad por la precisión de estas traducciones y recomienda remitirse siempre al documento original escrito en inglés (insertar vínculo URL).

Contenido

Introducción

Este documento describe los pasos necesarios para reemplazar la placa base defectuosa de un servidor en una configuración Ultra-M.

Este procedimiento se aplica a un entorno Openstack que utiliza la versión NEWTON en el que ESC no administra CPAR y CPAR se instala directamente en la VM implementada en Openstack.

Antecedentes

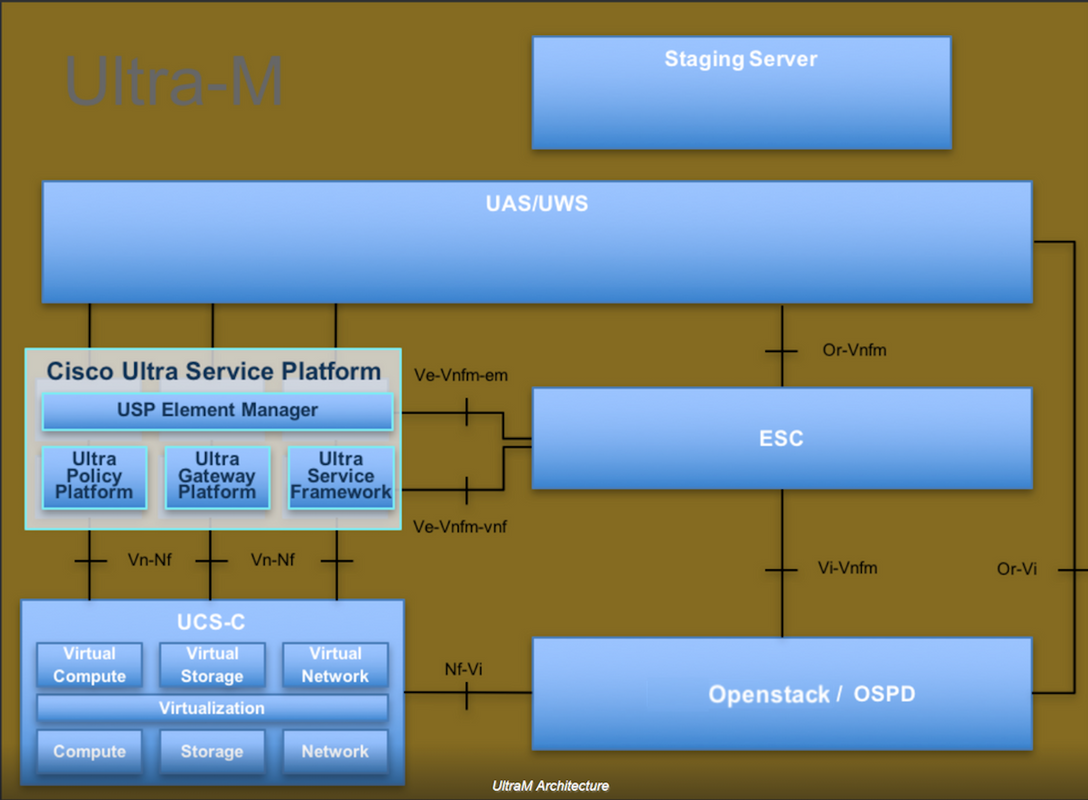

Ultra-M es una solución de núcleo de paquetes móviles virtualizada validada y empaquetada previamente diseñada para simplificar la implementación de VNF. OpenStack es el Virtualized Infrastructure Manager (VIM) para Ultra-M y consta de estos tipos de nodos:

- Informática

- Disco de almacenamiento de objetos - Compute (OSD - Compute)

- Controlador

- Plataforma OpenStack: Director (OSPD)

La arquitectura de alto nivel de Ultra-M y los componentes involucrados se ilustran en esta imagen:

Este documento está dirigido al personal de Cisco que está familiarizado con la plataforma Cisco Ultra-M y detalla los pasos necesarios para llevarse a cabo en OpenStack y Redhat OS.

Nota: Se considera la versión Ultra M 5.1.x para definir los procedimientos en este documento.

Abreviaturas

| MOP | Método de procedimiento |

| OSD | Discos de almacenamiento de objetos |

| OSPD | Director de plataforma OpenStack |

| HDD | Unidad de disco duro |

| SSD | Unidad de estado sólido |

| VIM | Administrador de infraestructura virtual |

| VM | Máquina virtual |

| EM | Administrador de elementos |

| UAS | Servicios de ultra automatización |

| UUID | Identificador único universal |

Flujo de trabajo del MoP

Sustitución de la placa base en la configuración Ultra-M

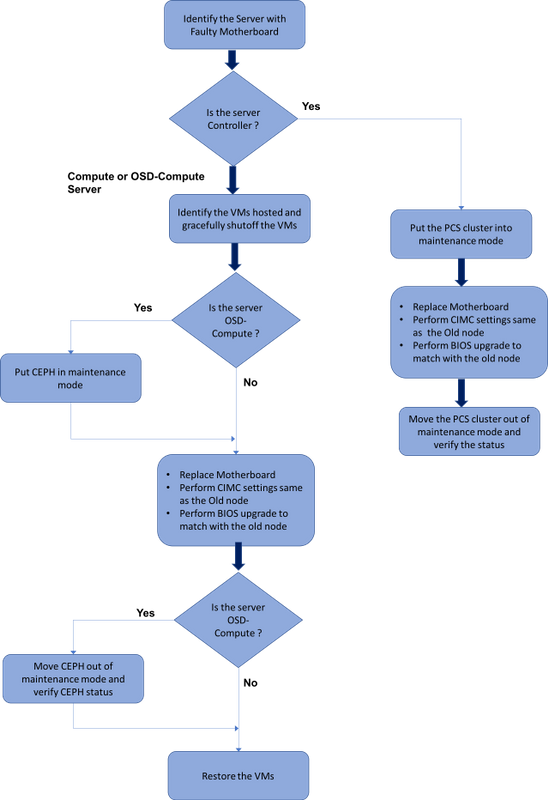

En una configuración Ultra-M, puede haber situaciones en las que se requiera un reemplazo de placa base en los siguientes tipos de servidor: Compute, OSD-Compute y Controller.

Nota: Los discos de arranque con la instalación de openstack se sustituyen después de la sustitución de la placa base. Por lo tanto, no es necesario volver a agregar el nodo a la nube excesiva. Una vez que el servidor se enciende después de la actividad de reemplazo, se inscribe de nuevo en la pila de nube superpuesta.

Prerequisites

Antes de reemplazar un nodo Compute, es importante verificar el estado actual de su entorno Red Hat OpenStack Platform. Se recomienda que verifique el estado actual para evitar complicaciones cuando el proceso Compute de reemplazo está activado. Se puede lograr con este flujo de reemplazo.

En caso de recuperación, Cisco recomienda realizar una copia de seguridad de la base de datos OSPD con estos pasos:

[root@director ~]# mysqldump --opt --all-databases > /root/undercloud-all-databases.sql [root@director ~]# tar --xattrs -czf undercloud-backup-`date +%F`.tar.gz /root/undercloud-all-databases.sql /etc/my.cnf.d/server.cnf /var/lib/glance/images /srv/node /home/stack tar: Removing leading `/' from member names

Este proceso asegura que un nodo se pueda reemplazar sin afectar la disponibilidad de ninguna instancia.

Nota: Asegúrese de tener la instantánea de la instancia para poder restaurar la VM cuando sea necesario. Siga este procedimiento para tomar una instantánea de la VM.

Sustitución de la placa base en el nodo informático

Antes de la actividad, las máquinas virtuales alojadas en el nodo Informática se apagan correctamente. Una vez que se ha reemplazado la placa base, se restauran las máquinas virtuales.

Identificación de las VM alojadas en el nodo de informática

[stack@al03-pod2-ospd ~]$ nova list --field name,host +--------------------------------------+---------------------------+----------------------------------+ | ID | Name | Host | +--------------------------------------+---------------------------+----------------------------------+ | 46b4b9eb-a1a6-425d-b886-a0ba760e6114 | AAA-CPAR-testing-instance | pod2-stack-compute-4.localdomain | | 3bc14173-876b-4d56-88e7-b890d67a4122 | aaa2-21 | pod2-stack-compute-3.localdomain | | f404f6ad-34c8-4a5f-a757-14c8ed7fa30e | aaa21june | pod2-stack-compute-3.localdomain | +--------------------------------------+---------------------------+----------------------------------+

Nota: En el resultado que se muestra aquí, la primera columna corresponde al identificador único universal (UUID), la segunda columna es el nombre de la máquina virtual y la tercera es el nombre de host donde está presente la máquina virtual. Los parámetros de este resultado se utilizan en secciones posteriores.

Copia de seguridad: Proceso de instantánea

Paso 1. Cierre de la aplicación CPAR.

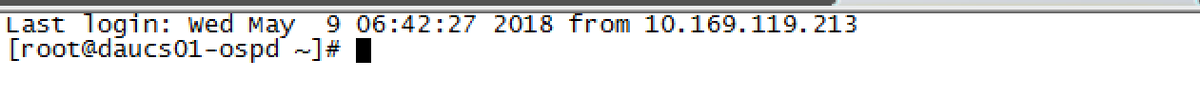

Paso 1.Abra cualquier cliente ssh conectado a la red y conéctese a la instancia CPAR.

Es importante no cerrar las 4 instancias AAA dentro de un sitio al mismo tiempo, hacerlo de una manera a una.

Paso 2.Cierre la aplicación CPAR con este comando:

/opt/CSCOar/bin/arserver stop A Message stating “Cisco Prime Access Registrar Server Agent shutdown complete.” Should show up

Si un usuario dejó abierta una sesión CLI, el comando arserver stop no funcionará y se mostrará este mensaje:

ERROR: You can not shut down Cisco Prime Access Registrar while the CLI is being used. Current list of running CLI with process id is: 2903 /opt/CSCOar/bin/aregcmd –s

En este ejemplo, la ID de proceso resaltada 2903 debe terminar antes de que el CPAR pueda ser detenido. Si este es el caso, complete este proceso con este comando:

kill -9 *process_id*

A continuación, repita el paso 1.

Paso 3.Verifique que la aplicación CPAR se haya apagado de hecho ejecutando el comando:

/opt/CSCOar/bin/arstatus

Estos mensajes deben aparecer:

Cisco Prime Access Registrar Server Agent not running Cisco Prime Access Registrar GUI not running

Tarea de instantánea de VM

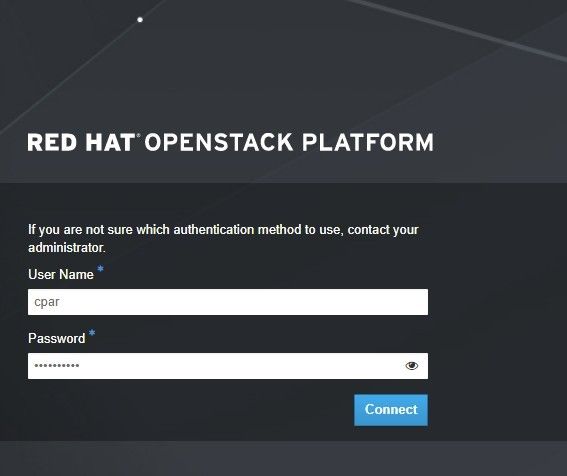

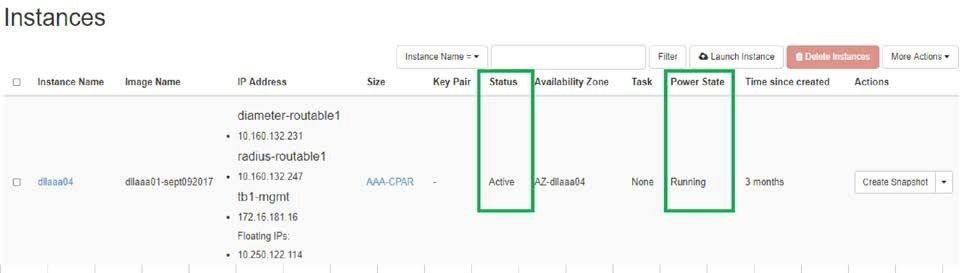

Paso 1.Introduzca el sitio web de la interfaz gráfica de usuario de Horizonte correspondiente al sitio (ciudad) en el que se está trabajando.

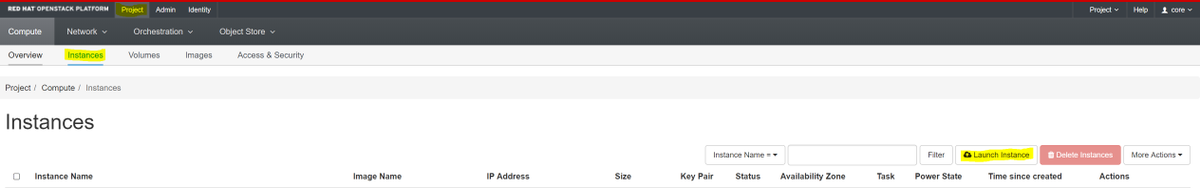

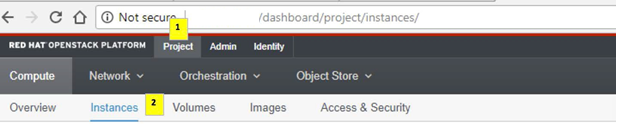

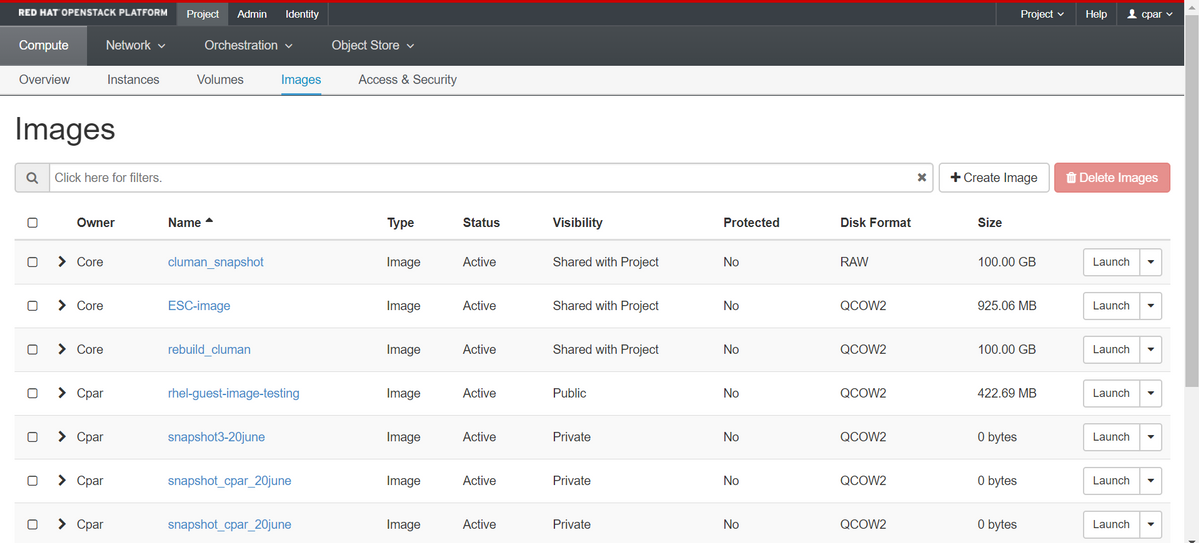

Al acceder a Horizon, se observa esta pantalla:

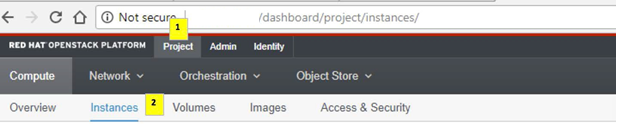

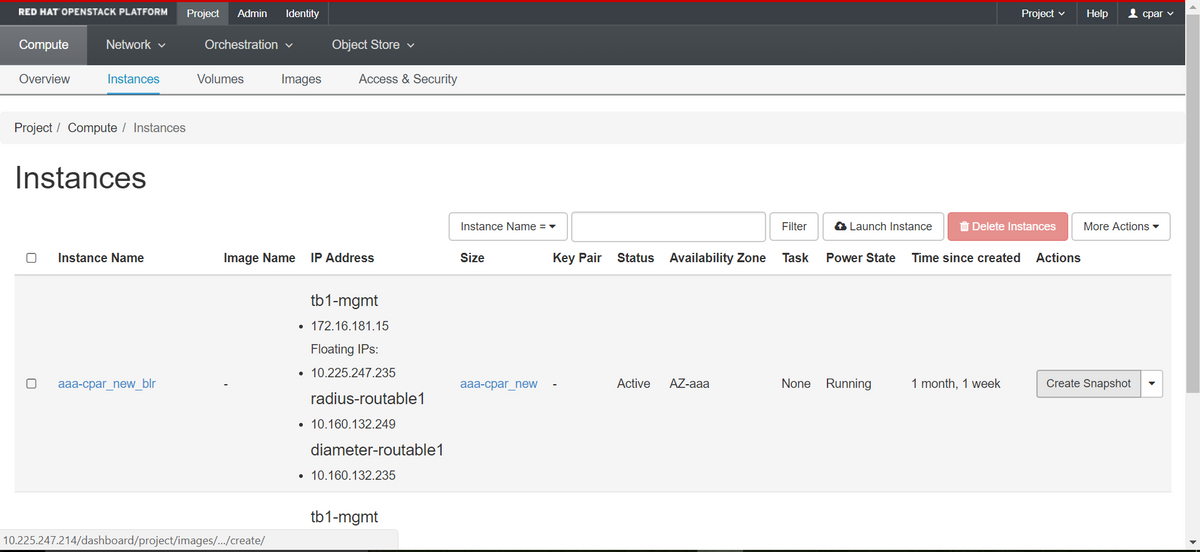

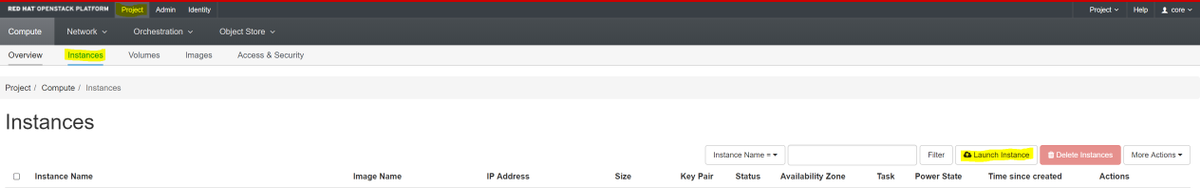

Paso 2.Vaya a Proyecto > Instancias, como se muestra en la imagen.

Si el usuario utilizado fue CPAR, en este menú solo aparecen las 4 instancias AAA.

Paso 3.Cierre sólo una instancia a la vez. Por favor, repita todo el proceso en este documento.

Para apagar la máquina virtual, navegue hasta Acciones > Apagar instancia y confirme su selección.

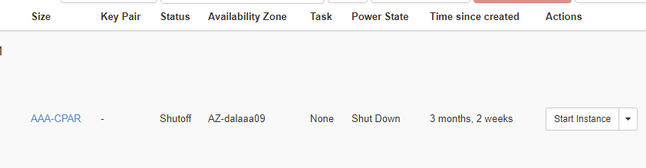

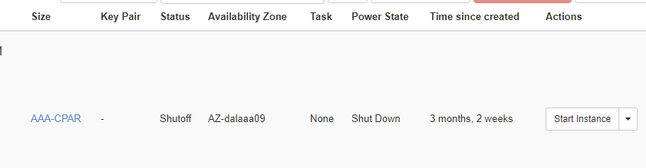

Paso 4.Valide que la instancia se cerró de hecho al verificar el estado = apagado y estado de energía = apagado.

Este paso finaliza el proceso de cierre del CPAR.

Instantánea de VM

Una vez que las máquinas virtuales CPAR están inactivas, las instantáneas pueden tomarse en paralelo, ya que pertenecen a equipos independientes.

Los cuatro archivos QCOW2 se crearán en paralelo.

Toma de una instantánea de cada instancia de AAA (25 minutos -1 hora) (25 minutos para las instancias que usaron una imagen de cola como origen y 1 hora para las instancias que usaron una imagen sin procesar como origen)

Paso 1. Inicie sesión en el horizonte de Openstack de PODGUI.

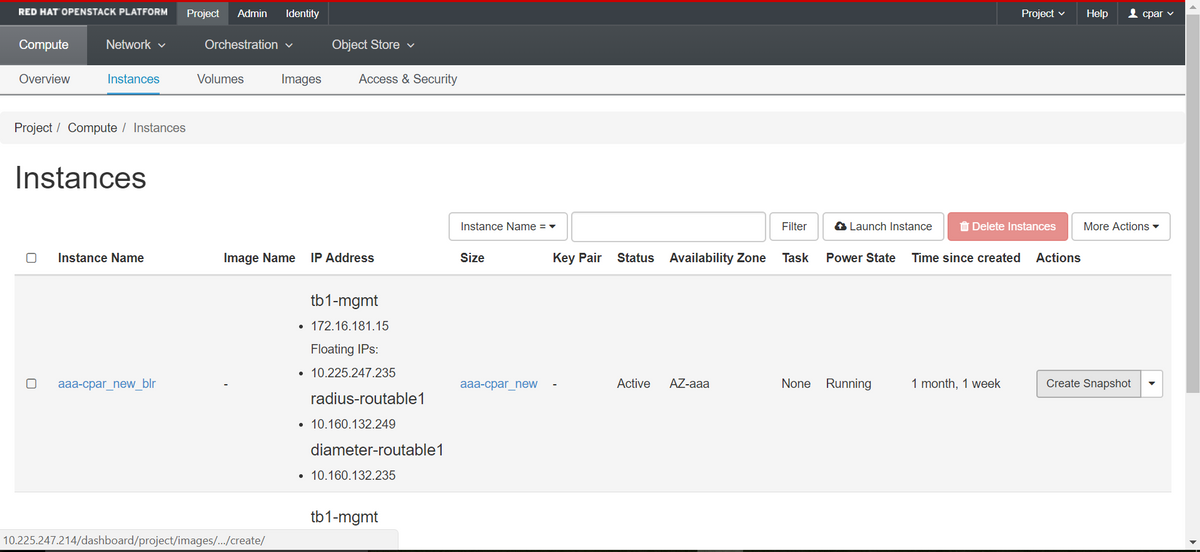

Paso 2. Una vez que haya iniciado sesión, continúe con la sección Project > Compute > Instancias del menú superior y busque las instancias AAA.

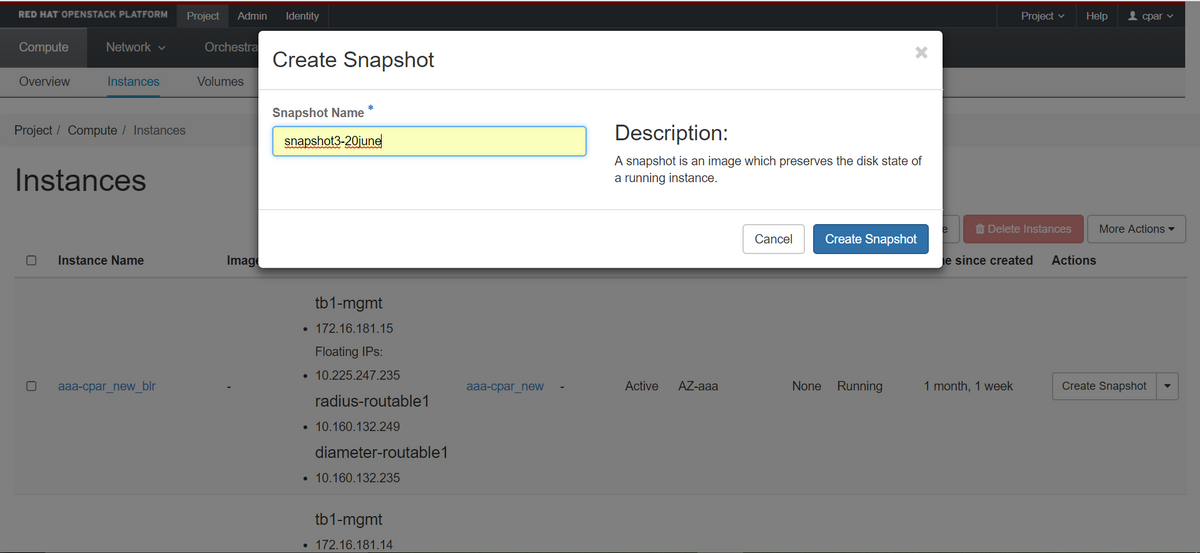

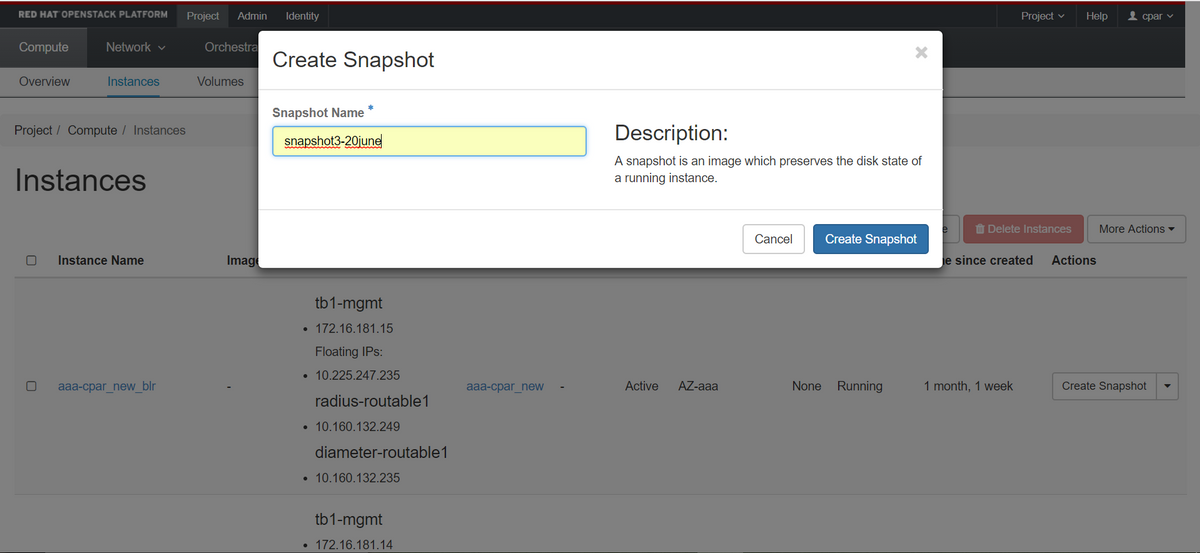

Paso 3. Haga clic en el botón Crear instantánea para continuar con la creación de la instantánea (esto debe ejecutarse en la instancia AAA correspondiente).

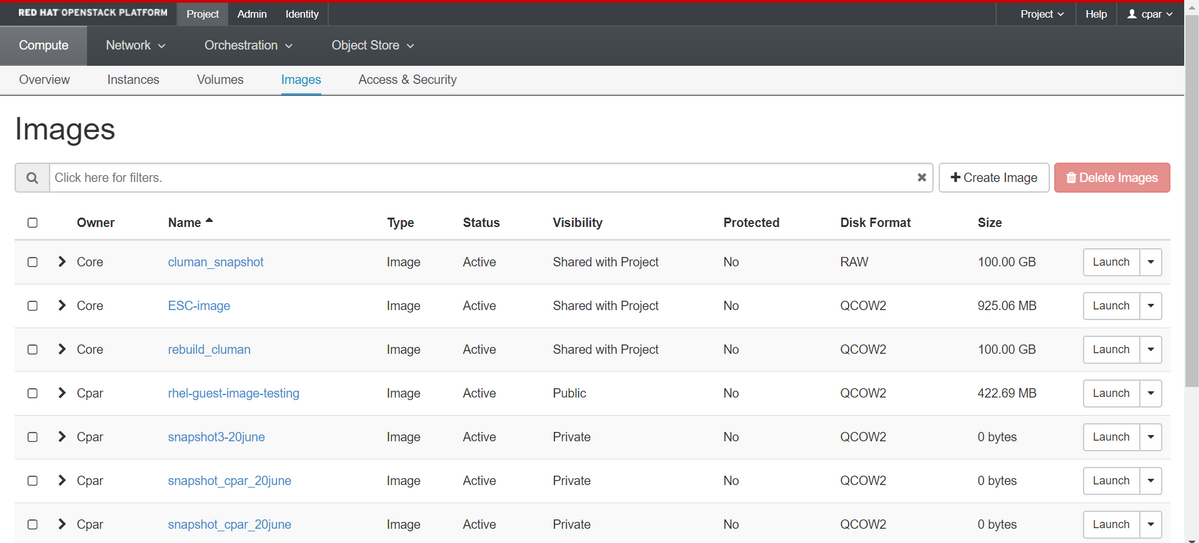

Paso 4. Una vez que se ejecute la instantánea, navegue hasta el menú IMAGES (IMÁGENES) y verifique que todos terminen y no informen de ningún problema.

Paso 5. El siguiente paso es descargar la instantánea en un formato QCOW2 y transferirla a una entidad remota en caso de que la OSPD se pierda durante este proceso. Para lograr esto, identifique la instantánea con este comando glance image-list en el nivel OSPD.

[root@elospd01 stack]# glance image-list +--------------------------------------+---------------------------+ | ID | Name | +--------------------------------------+---------------------------+ | 80f083cb-66f9-4fcf-8b8a-7d8965e47b1d | AAA-Temporary | | 22f8536b-3f3c-4bcc-ae1a-8f2ab0d8b950 | ELP1 cluman 10_09_2017 | | 70ef5911-208e-4cac-93e2-6fe9033db560 | ELP2 cluman 10_09_2017 | | e0b57fc9-e5c3-4b51-8b94-56cbccdf5401 | ESC-image | | 92dfe18c-df35-4aa9-8c52-9c663d3f839b | lgnaaa01-sept102017 | | 1461226b-4362-428b-bc90-0a98cbf33500 | tmobile-pcrf-13.1.1.iso | | 98275e15-37cf-4681-9bcc-d6ba18947d7b | tmobile-pcrf-13.1.1.qcow2 | +--------------------------------------+---------------------------+

Paso 6. Una vez identificada la instantánea que se descargará (en este caso será la marcada arriba en verde), descárguela en formato QCOW2 usando el comando glance image-download como se muestra aquí.

[root@elospd01 stack]# glance image-download 92dfe18c-df35-4aa9-8c52-9c663d3f839b --file /tmp/AAA-CPAR-LGNoct192017.qcow2 &

- El "&" envía el proceso a segundo plano. Esta acción tardará algún tiempo en completarse, una vez que se haya realizado, la imagen se puede encontrar en el directorio /tmp.

- Al enviar el proceso a segundo plano, si se pierde la conectividad, también se detiene el proceso.

- Ejecute el comando "disown -h" para que en caso de que se pierda la conexión SSH, el proceso se ejecute y termine en el OSPD.

Paso 7. Una vez finalizado el proceso de descarga, es necesario ejecutar un proceso de compresión, ya que esa instantánea puede llenarse con ZEROES debido a procesos, tareas y archivos temporales manejados por el sistema operativo. El comando que se utilizará para la compresión de archivos es virt-sparsify.

[root@elospd01 stack]# virt-sparsify AAA-CPAR-LGNoct192017.qcow2 AAA-CPAR-LGNoct192017_compressed.qcow2

Este proceso lleva algún tiempo (unos 10-15 minutos). Una vez terminado, el archivo resultante es el que debe transferirse a una entidad externa como se especifica en el paso siguiente.

Para lograr esto, se requiere la verificación de la integridad del archivo, ejecute el siguiente comando y busque el atributo "corrupto" al final de su salida.

[root@wsospd01 tmp]# qemu-img info AAA-CPAR-LGNoct192017_compressed.qcow2 image: AAA-CPAR-LGNoct192017_compressed.qcow2 file format: qcow2 virtual size: 150G (161061273600 bytes) disk size: 18G cluster_size: 65536 Format specific information: compat: 1.1 lazy refcounts: false refcount bits: 16 corrupt: false

Para evitar un problema donde se pierde la OSPD, la instantánea creada recientemente en formato QCOW2 debe transferirse a una entidad externa. Antes de iniciar la transferencia de archivos tenemos que verificar si el destino tiene suficiente espacio disponible en disco, utilice el comando df -kh para verificar el espacio de memoria. Nuestro consejo es transferirla temporalmente al OSPD de otro sitio mediante SFTP "sftproot@x.x.x.x" donde x.x.x.x es la IP de un OSPD remoto. Para acelerar la transferencia, el destino se puede enviar a varios OSPD. De la misma manera, podemos utilizar el siguiente comando scp *name_of_the_file*.qcow2 root@ x.x.x.x.x:/tmp (donde x.x.x.x es la IP de un OSPD remoto) para transferir el archivo a otro OSPD.

Apagado Graceful

Apagar el nodo

- Para apagar la instancia: nova stop <INSTANCE_NAME>

- Ahora verá el nombre de la instancia con el estado apagado.

[stack@director ~]$ nova stop aaa2-21 Request to stop server aaa2-21 has been accepted. [stack@director ~]$ nova list +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+ | ID | Name | Status | Task State | Power State | Networks | +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+ | 46b4b9eb-a1a6-425d-b886-a0ba760e6114 | AAA-CPAR-testing-instance | ACTIVE | - | Running | tb1-mgmt=172.16.181.14, 10.225.247.233; radius-routable1=10.160.132.245; diameter-routable1=10.160.132.231 | | 3bc14173-876b-4d56-88e7-b890d67a4122 | aaa2-21 | SHUTOFF | - | Shutdown | diameter-routable1=10.160.132.230; radius-routable1=10.160.132.248; tb1-mgmt=172.16.181.7, 10.225.247.234 | | f404f6ad-34c8-4a5f-a757-14c8ed7fa30e | aaa21june | ACTIVE | - | Running | diameter-routable1=10.160.132.233; radius-routable1=10.160.132.244; tb1-mgmt=172.16.181.10 | +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+

Sustitución de la placa madre

Los pasos para reemplazar la placa base en un servidor UCS C240 M4 se pueden consultar desde la Guía de Instalación y Servicio del Servidor Cisco UCS C240 M4

- Inicie sesión en el servidor con la IP de CIMC.

- Realice la actualización del BIOS si el firmware no se ajusta a la versión recomendada utilizada anteriormente. Los pasos para la actualización del BIOS se indican a continuación: Guía de actualización del BIOS del servidor de montaje en bastidor Cisco UCS C-Series

Restauración de las VM

Recuperación de una Instancia mediante Snapshot

Proceso de recuperación

Es posible volver a implementar la instancia anterior con la instantánea tomada en pasos anteriores.

Paso 1 [OPCIONAL].Si no hay ninguna VMSnapshots anterior, conéctese al nodo OSPD donde se envió la copia de seguridad y devuelva la copia de seguridad a su nodo OSPD original. Usar "sftproot@x.x.x.x" donde x.x.x.x es la IP del OSPD original. Guarde el archivo de instantánea en el directorio /tmp.

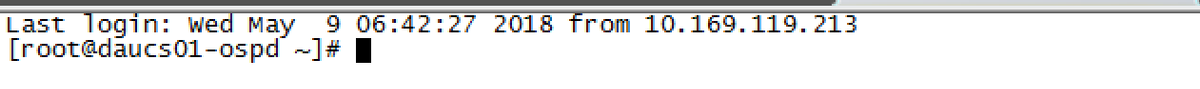

Paso 2.Conéctese al nodo OSPD donde se reimplementa la instancia.

Utilice las variables de entorno con este comando:

Utilice las variables de entorno con este comando:

# source /home/stack/pod1-stackrc-Core-CPAR

Paso 3.Para utilizar la instantánea como una imagen es necesario cargarla en el horizonte como tal. Utilice el siguiente comando para hacerlo.

#glance image-create -- AAA-CPAR-Date-snapshot.qcow2 --container-format bare --disk-format qcow2 --name AAA-CPAR-Date-snapshot

El proceso puede verse en el horizonte.

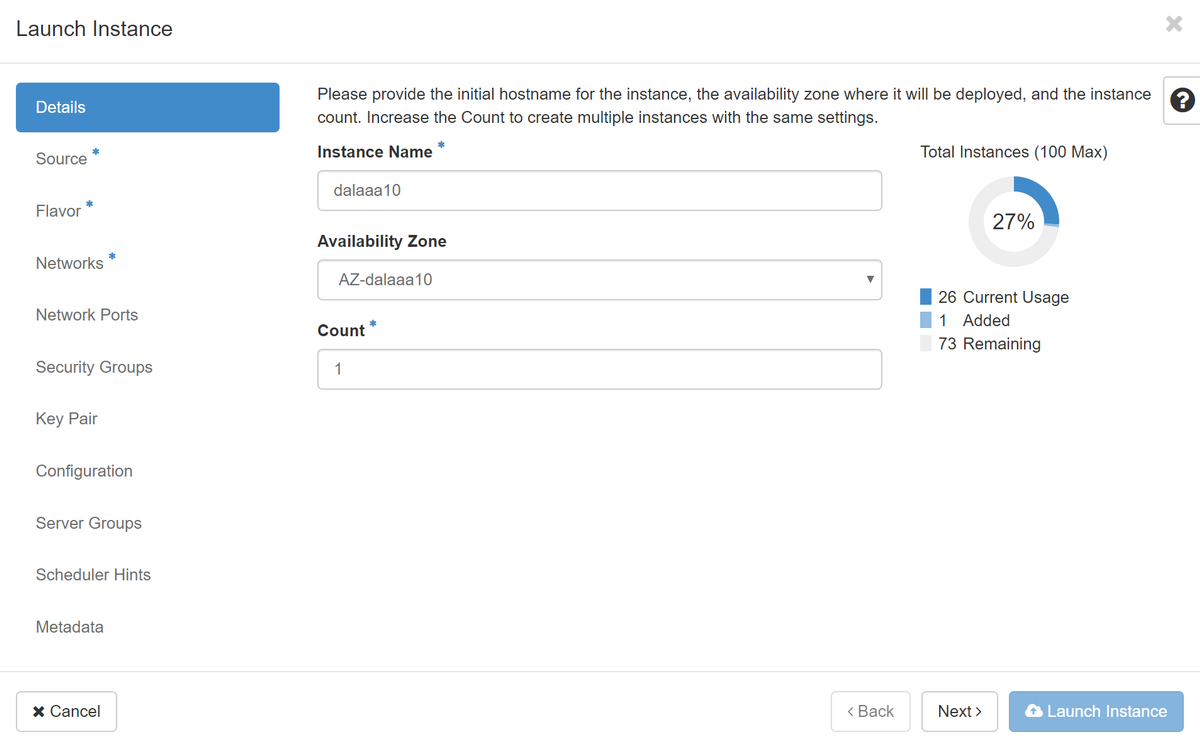

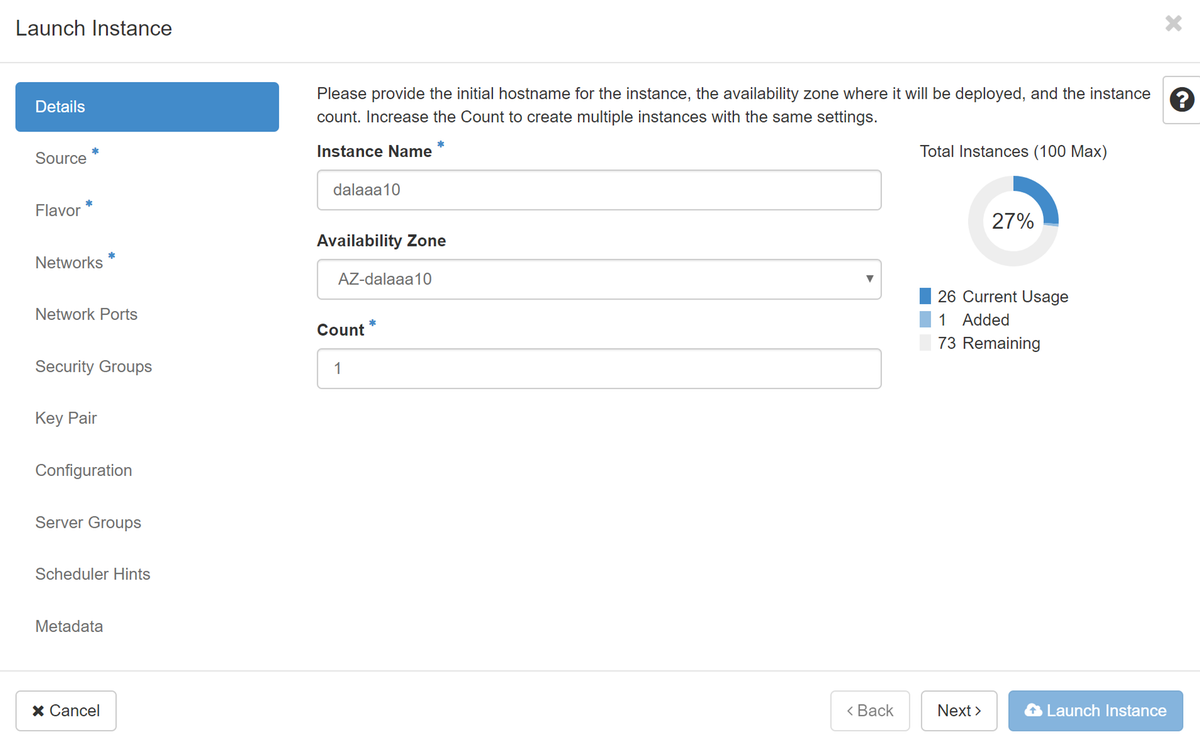

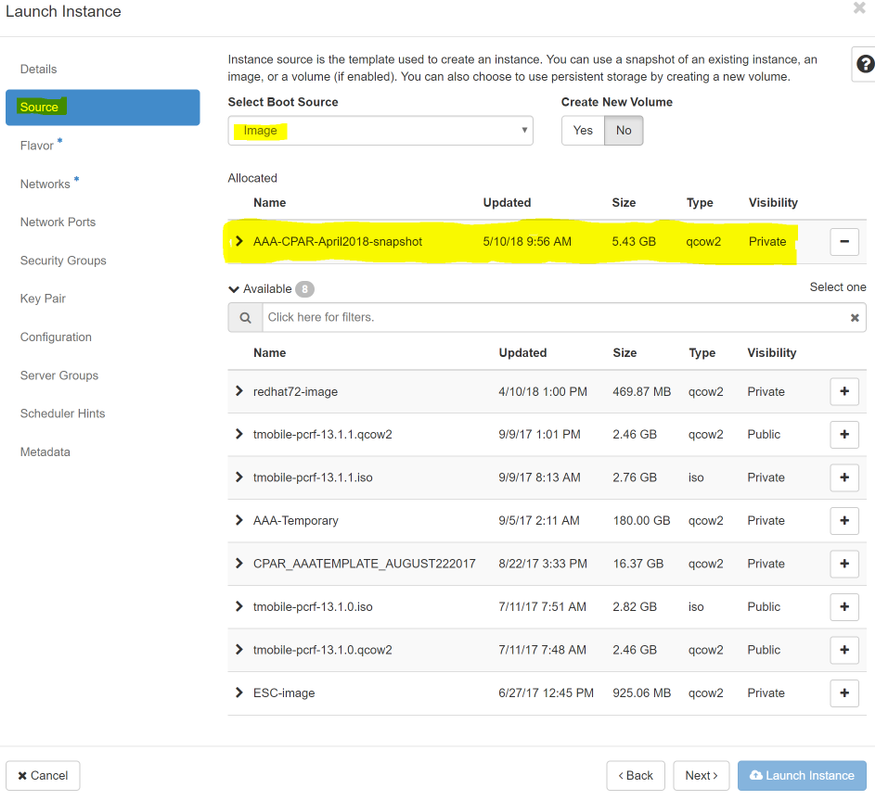

Paso 4.En Horizon, navegue hasta Project > Inases y haga clic en Iniciar instancia.

Paso 5.Rellene el nombre de la instancia y elija la zona de disponibilidad.

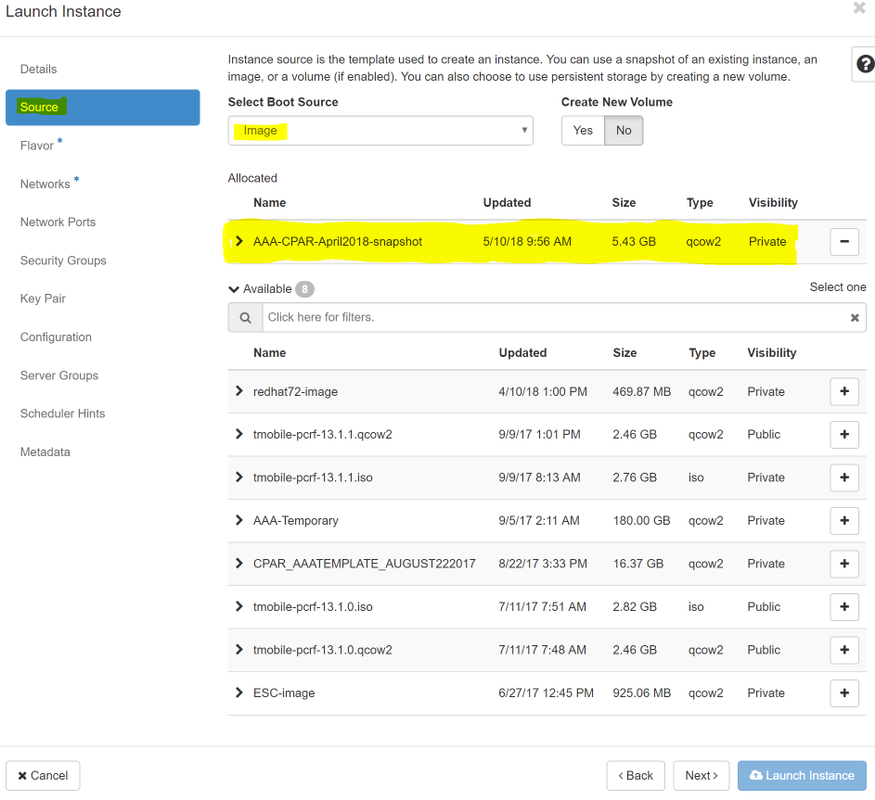

Paso 6.En la ficha Source, elija la imagen para crear la instancia. En el menú Select Boot Source (Seleccionar origen de arranque) seleccione imagen, se muestra una lista de imágenes aquí, elija la que se cargó anteriormente al hacer clic en el + signo.

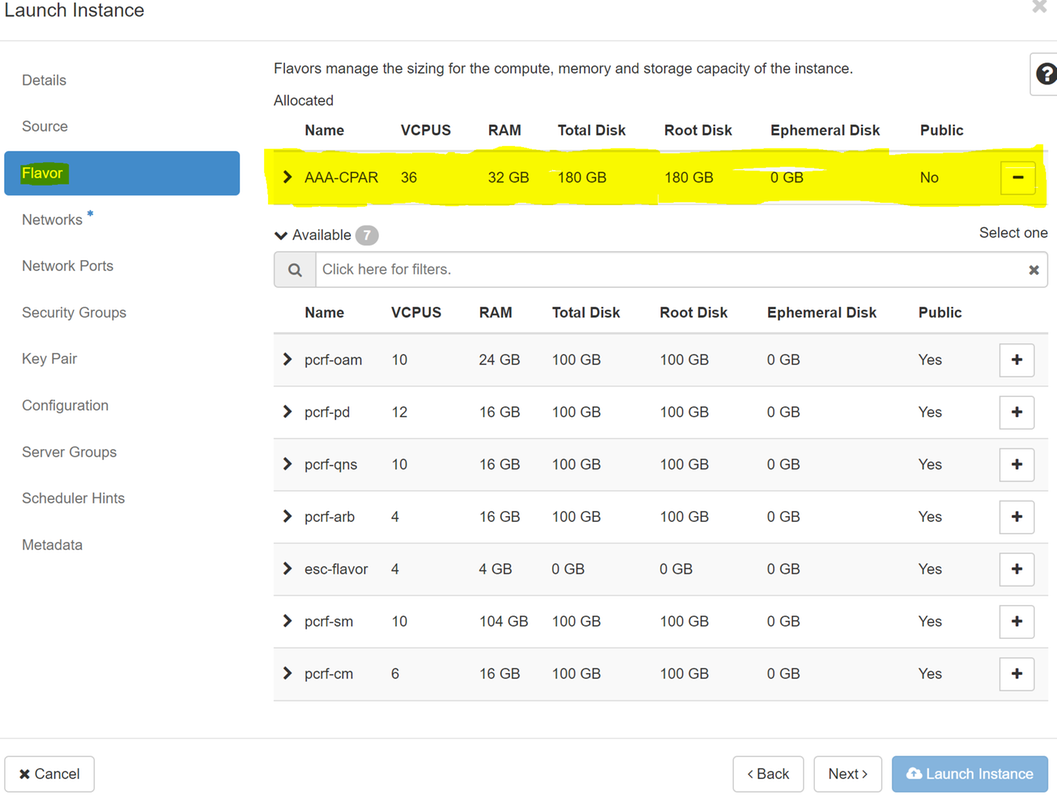

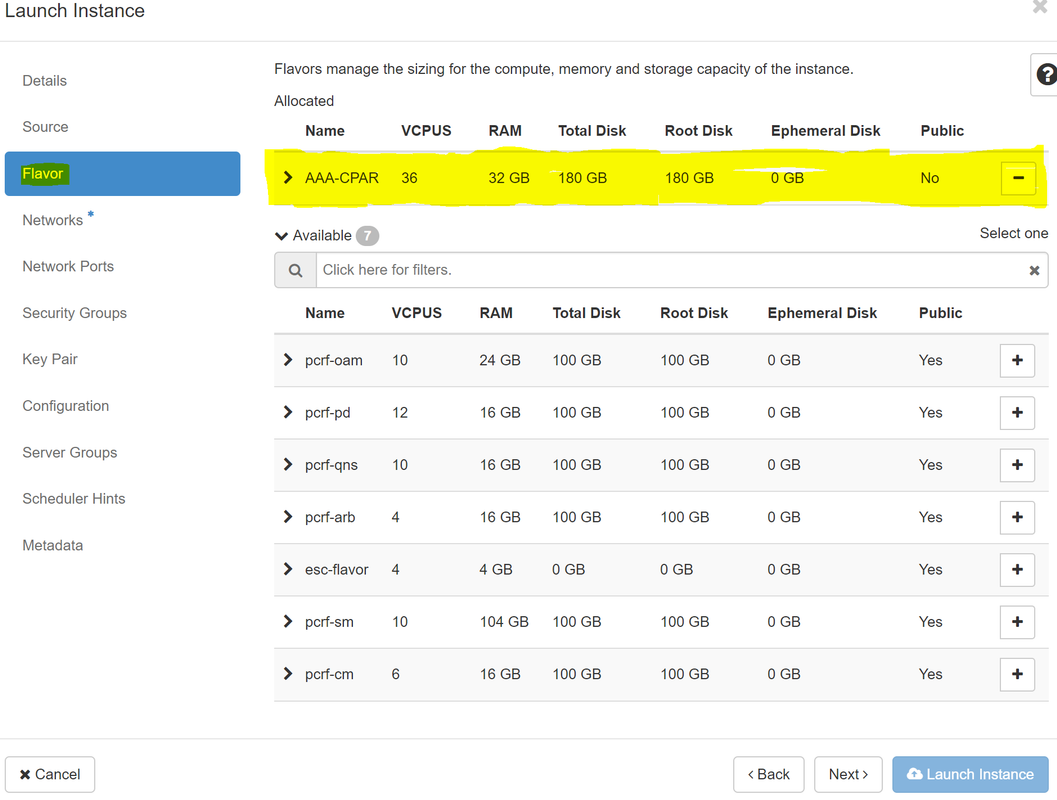

Paso 7.En la pestaña Sabor, elija el sabor de AAA mientras hace clic en el signo +.

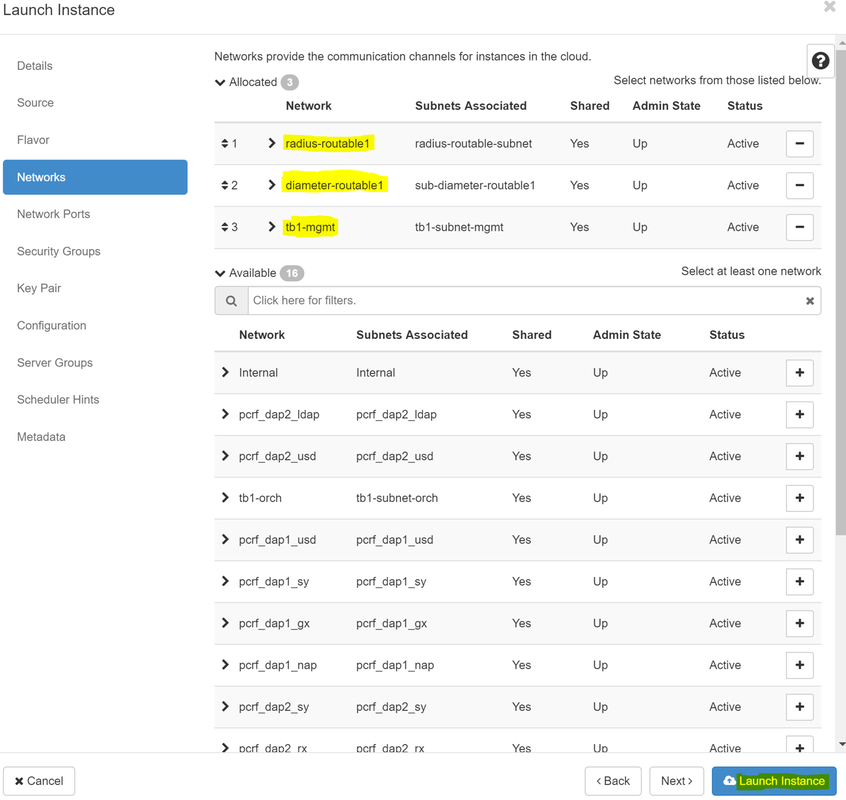

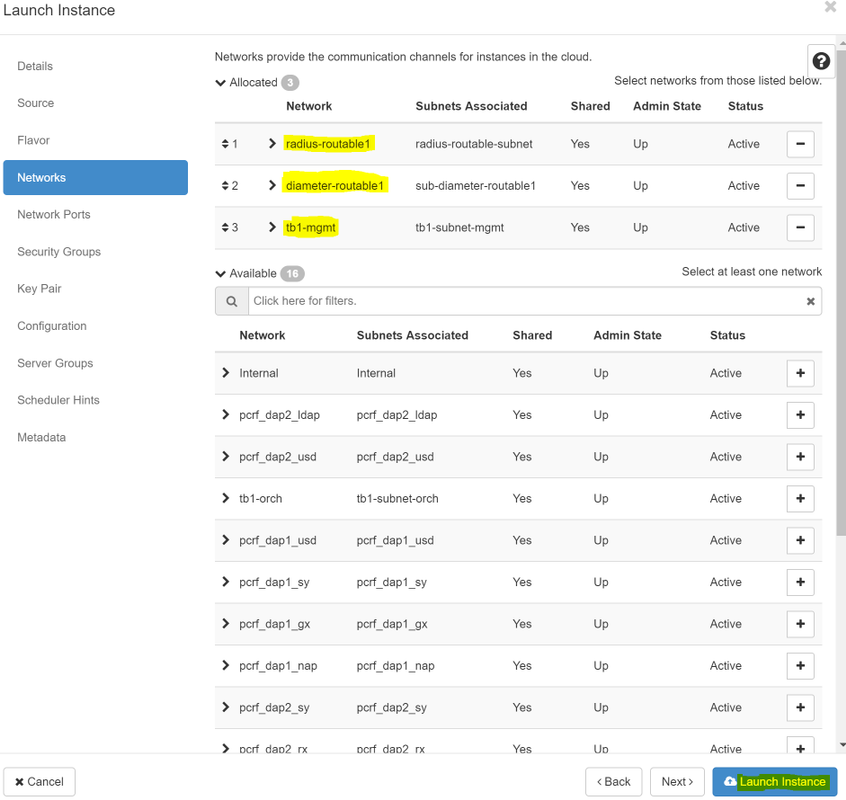

Paso 8.Por último, desplácese a la ficha de red y elija las redes que necesita la instancia a medida que hace clic en el signo +. Para este caso seleccione diámetro-soutable1, radius-routable1 y tb1-mgmt.

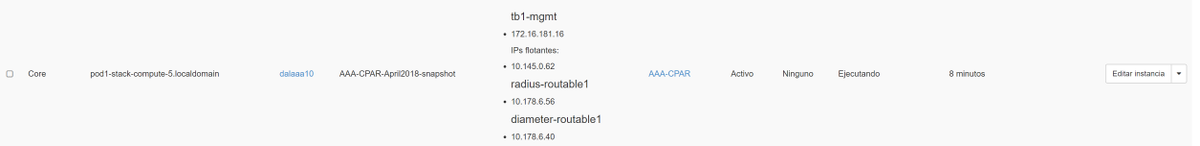

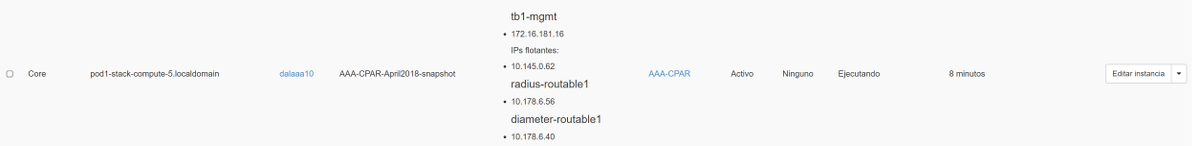

Paso 9. Por último, haga clic en Iniciar instancia para crearla. El progreso se puede supervisar en Horizonte:

Después de unos minutos, la instancia se implementa completamente y está lista para su uso.

Creación y asignación de una dirección IP flotante

Una dirección IP flotante es una dirección enrutable, lo que significa que se puede alcanzar desde el exterior de la arquitectura Ultra M/Openstack, y es capaz de comunicarse con otros nodos desde la red.

Paso 1.En el menú superior Horizonte, vaya aAdmin > Floating IPs.

Paso 2. Haga clic en el botónAsignarIP al proyecto.

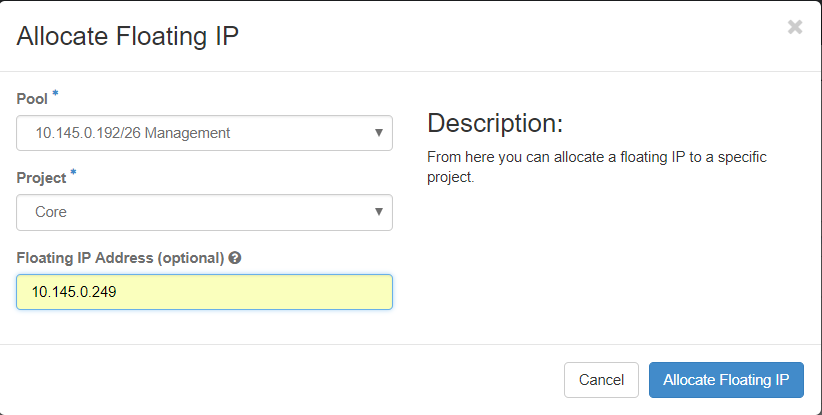

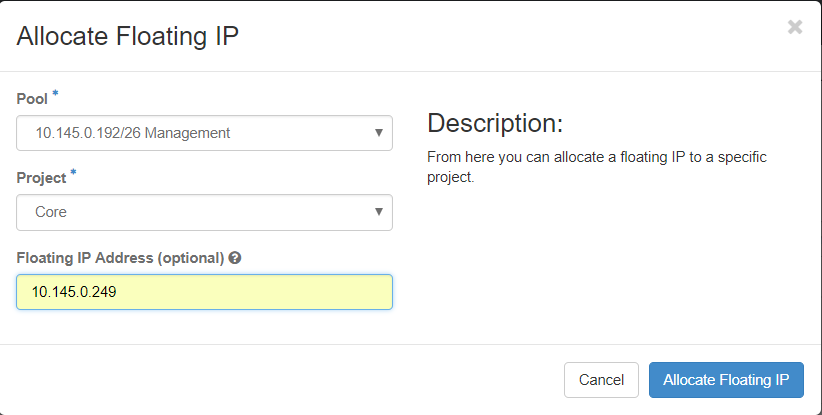

Paso 3. En la ventana IP flotante de asignación, seleccione el grupo desde el que pertenece la nueva IP flotante, elProyecto donde se va a asignar y la nueva dirección IP flotante.

Por ejemplo:

Paso 4.Haga clic en el botón Asignar IP flotante.

Paso 5. En el menú superior Horizonte, vaya aProject > Instancias.

Paso 6.En la columnaAcción, haga clic en la flecha que apunta hacia abajo en el botón Crear instantáneas, se debe mostrar un menú. SeleccionarAsociar opción IP flotante.

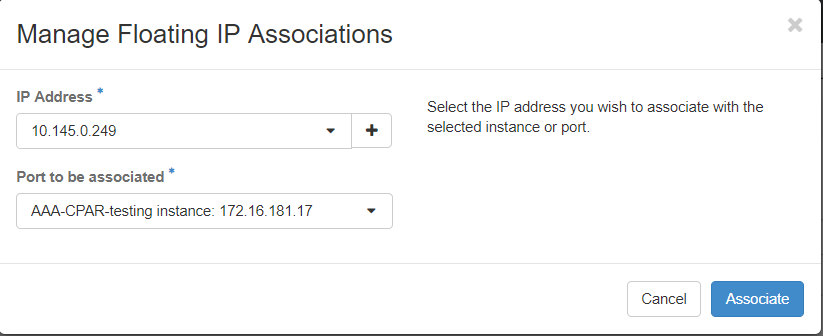

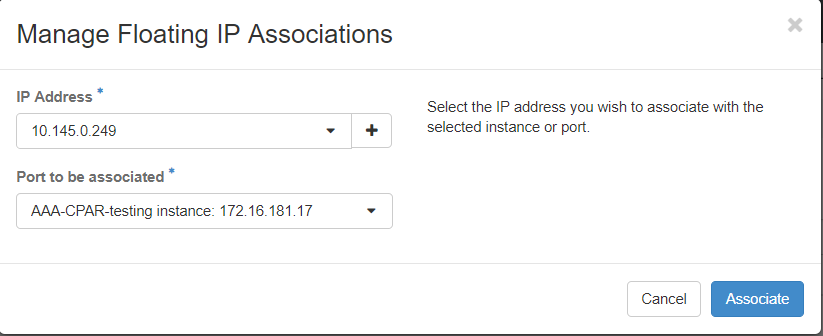

Paso 7. Seleccione la dirección IP flotante correspondiente que se utilizará en el campo Dirección IP y elija la interfaz de administración correspondiente (eth0) de la nueva instancia donde se va a asignar esta IP flotante en elPuerto que se va a asociar. Consulte la siguiente imagen como ejemplo de este procedimiento.

Paso 8.Por último, haga clic en el botón Asociatebutton.

Habilitación de SSH

Paso 1.En el menú superior Horizonte, vaya aProject > Instancias.

Paso 2.Haga clic en el nombre de la instancia/VM que se creó en la secciónAlmorzar una nueva instancia.

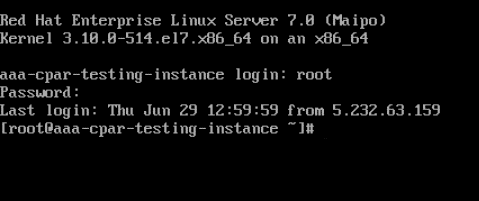

Paso 3. Haga clic en Consoletab. Esto mostrará la interfaz de línea de comandos de la máquina virtual.

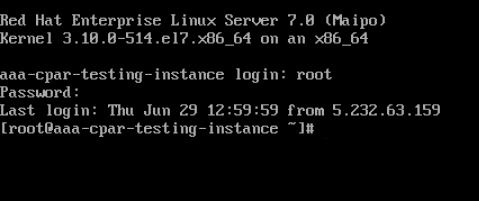

Paso 4.Una vez que se muestre la CLI, introduzca las credenciales de inicio de sesión correctas:

Nombre de usuario:root

Contraseña:cisco123

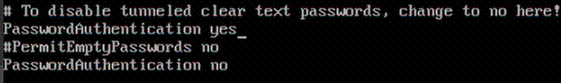

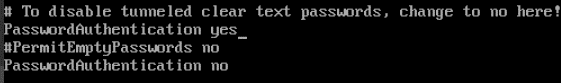

Paso 5.En la CLI, ingrese el comando commandvi /etc/ssh/sshd_configto edit ssh configuration.

Paso 6. Una vez abierto el archivo de configuración ssh, pulse Ito para editar el archivo. A continuación, busque la sección que se muestra a continuación y cambie la primera línea desdePasswordAuthentication notoPasswordAuthentication yes.

Paso 7.Presione ESCe ingrese :wq!para guardar los cambios del archivo sshd_config.

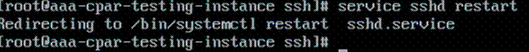

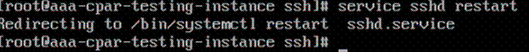

Paso 8. Ejecute el comando service sshd restart.

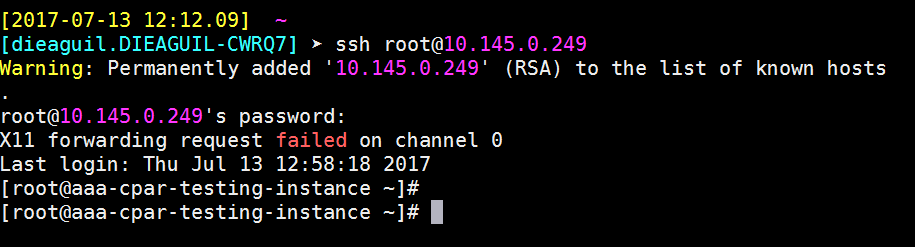

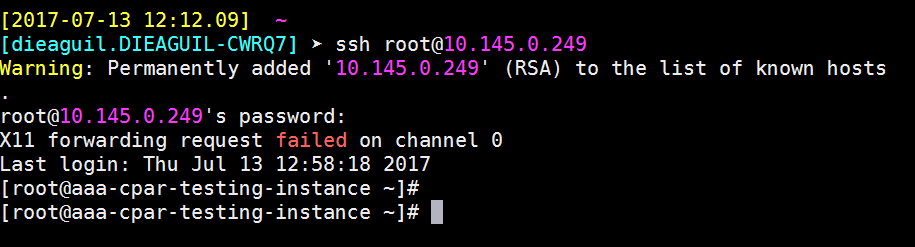

Paso 9.Para probar los cambios de configuración de SSH se han aplicado correctamente, abra cualquier cliente SSH e intente establecer una conexión segura remota usando la IP flotante asignada a la instancia (es decir, 10.145.0.249) y la userroot.

Establecer una Sesión SSH

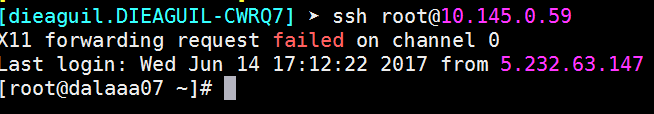

Abra una sesión SSH utilizando la dirección IP de la VM/servidor correspondiente donde está instalada la aplicación.

Inicio de instancia de CPAR

Siga estos pasos, una vez que se haya completado la actividad y los servicios CPAR puedan restablecerse en el Sitio que se cerró.

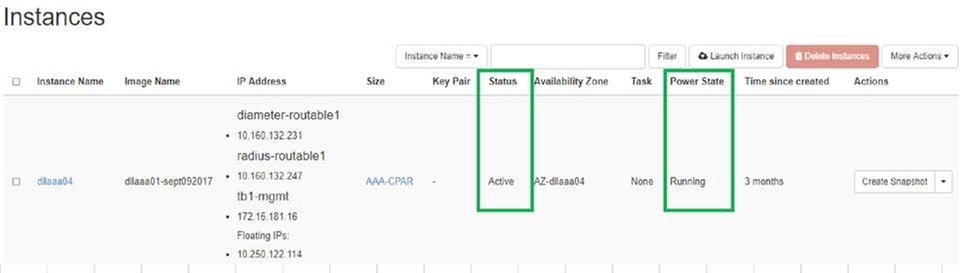

- Para volver a iniciar sesión en Horizon, navegue hasta Project > Instance > Start Instance.

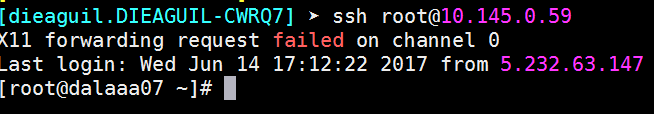

- Verifique que el estado de la instancia esté activo y que el estado de energía esté en ejecución:

Comprobación de estado posterior a la actividad

Paso 1.Ejecute el comando /opt/CSCOar/bin/arstatus a nivel del sistema operativo.

[root@aaa04 ~]# /opt/CSCOar/bin/arstatus Cisco Prime AR RADIUS server running (pid: 24834) Cisco Prime AR Server Agent running (pid: 24821) Cisco Prime AR MCD lock manager running (pid: 24824) Cisco Prime AR MCD server running (pid: 24833) Cisco Prime AR GUI running (pid: 24836) SNMP Master Agent running (pid: 24835) [root@wscaaa04 ~]#

Paso 2.Ejecute el comando /opt/CSCOar/bin/aregcmd a nivel del sistema operativo e ingrese las credenciales de administración. Verifique que CPAR Health sea 10 de 10 y que salga de CPAR CLI.

[root@aaa02 logs]# /opt/CSCOar/bin/aregcmd Cisco Prime Access Registrar 7.3.0.1 Configuration Utility Copyright (C) 1995-2017 by Cisco Systems, Inc. All rights reserved. Cluster: User: admin Passphrase: Logging in to localhost [ //localhost ] LicenseInfo = PAR-NG-TPS 7.2(100TPS:) PAR-ADD-TPS 7.2(2000TPS:) PAR-RDDR-TRX 7.2() PAR-HSS 7.2() Radius/ Administrators/ Server 'Radius' is Running, its health is 10 out of 10 --> exit

Paso 3.Ejecute el comando netstat | diámetro grep y verifique que se hayan establecido todas las conexiones DRA.

El resultado mencionado a continuación es para un entorno en el que se esperan enlaces Diámetro. Si se muestran menos enlaces, esto representa una desconexión del DRA que se debe analizar.

[root@aa02 logs]# netstat | grep diameter tcp 0 0 aaa02.aaa.epc.:77 mp1.dra01.d:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:36 tsa6.dra01:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:47 mp2.dra01.d:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:07 tsa5.dra01:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:08 np2.dra01.d:diameter ESTABLISHED

Paso 4.Compruebe que el registro TPS muestra las solicitudes que está procesando el CPAR. Los valores resaltados representan el TPS y esos son a los que debemos prestar atención.

El valor de TPS no debe exceder de 1500.

[root@wscaaa04 ~]# tail -f /opt/CSCOar/logs/tps-11-21-2017.csv 11-21-2017,23:57:35,263,0 11-21-2017,23:57:50,237,0 11-21-2017,23:58:05,237,0 11-21-2017,23:58:20,257,0 11-21-2017,23:58:35,254,0 11-21-2017,23:58:50,248,0 11-21-2017,23:59:05,272,0 11-21-2017,23:59:20,243,0 11-21-2017,23:59:35,244,0 11-21-2017,23:59:50,233,0

Paso 5.Busque cualquier mensaje de "error" o "alarma" en name_radius_1_log

[root@aaa02 logs]# grep -E "error|alarm" name_radius_1_log

Paso 6.Verifique la cantidad de memoria que está utilizando el proceso CPAR mediante la ejecución del siguiente comando:

arriba | grep radius

[root@sfraaa02 ~]# top | grep radius 27008 root 20 0 20.228g 2.413g 11408 S 128.3 7.7 1165:41 radius

Este valor resaltado debe ser menor que: 7 Gb, que es el máximo permitido en un nivel de aplicación.

Sustitución de la placa base en el nodo de cómputo OSD

Antes de la actividad, las VM alojadas en el nodo Compute se apagan con gracia y el CEPH se pone en modo de mantenimiento. Una vez que se ha reemplazado la placa base, se restauran las máquinas virtuales y se elimina el CEPH del modo de mantenimiento.

Identificación de las VM alojadas en el nodo Osd-Compute

Identifique las VM alojadas en el servidor informático OSD.

[stack@director ~]$ nova list --field name,host | grep osd-compute-0 | 46b4b9eb-a1a6-425d-b886-a0ba760e6114 | AAA-CPAR-testing-instance | pod2-stack-compute-4.localdomain |

Copia de seguridad: Proceso de instantánea

Cierre de la aplicación CPAR

Paso 1.Abra cualquier cliente ssh conectado a la red y conéctese a la instancia CPAR.

Es importante no cerrar las 4 instancias AAA dentro de un sitio al mismo tiempo, hacerlo de una manera a una.

Paso 2.Cierre la aplicación CPAR con este comando:

/opt/CSCOar/bin/arserver stop A Message stating “Cisco Prime Access Registrar Server Agent shutdown complete.” Should show up

Nota: Si un usuario dejó abierta una sesión CLI, el comando arserver stop no funcionará y se mostrará el siguiente mensaje:

ERROR: You can not shut down Cisco Prime Access Registrar while the CLI is being used. Current list of running CLI with process id is: 2903 /opt/CSCOar/bin/aregcmd –s

En este ejemplo, la ID de proceso resaltada 2903 debe terminar antes de que el CPAR pueda ser detenido. Si este es el caso, complete este proceso con este comando:

kill -9 *process_id*

A continuación, repita el paso 1.

Paso 3.Verifique que la aplicación CPAR se haya apagado realmente con este comando:

/opt/CSCOar/bin/arstatus

Aparecen estos mensajes:

Cisco Prime Access Registrar Server Agent not running Cisco Prime Access Registrar GUI not running

tarea Instantánea de VM

Paso 1.Introduzca el sitio web de la interfaz gráfica de usuario de Horizonte correspondiente al sitio (ciudad) en el que se está trabajando.

Al acceder a Horizon, se observa la imagen mostrada:

Paso 2. Vaya a Proyecto > Instancias, como se muestra en la imagen.

Si el usuario utilizado fue CPAR, en este menú solo aparecen las 4 instancias AAA.

Paso 3.Cierre sólo una instancia a la vez. Por favor, repita todo el proceso en este documento.

Para apagar la máquina virtual, navegue hasta Acciones > Apagar instancia y confirme su selección.

Paso 4.Valide que la instancia se cerró de hecho al verificar el estado = apagado y estado de energía = apagado.

Este paso finaliza el proceso de cierre del CPAR.

Instantánea de VM

Una vez que las máquinas virtuales CPAR están inactivas, las instantáneas pueden tomarse en paralelo, ya que pertenecen a equipos independientes.

Los cuatro archivos QCOW2 se crean en paralelo.

Tome una instantánea de cada instancia de AAA (25 minutos -1 hora) (25 minutos para las instancias que usaron una imagen de cola como origen y 1 hora para las instancias que usaron una imagen sin procesar como origen)

Paso 1. Inicie sesión en la GUI de Openstack de POD.

Paso 2. Una vez que haya iniciado sesión, continúe con la sección Project > Compute > Instancias del menú superior y busque las instancias AAA.

Paso 3. Haga clic en el botón Crear instantánea para continuar con la creación de la instantánea (esto debe ejecutarse en la instancia AAA correspondiente).

Paso 4. Una vez que se ejecute la instantánea, navegue hasta el menú IMAGES (IMÁGENES) y verifique que todos terminen y no informen de ningún problema.

Paso 5. El siguiente paso es descargar la instantánea en un formato QCOW2 y transferirla a una entidad remota en caso de que la OSPD se pierda durante este proceso. Para lograr esto, identifique la instantánea con este comando glance image-list en el nivel OSPD.

[root@elospd01 stack]# glance image-list +--------------------------------------+---------------------------+ | ID | Name | +--------------------------------------+---------------------------+ | 80f083cb-66f9-4fcf-8b8a-7d8965e47b1d | AAA-Temporary | | 22f8536b-3f3c-4bcc-ae1a-8f2ab0d8b950 | ELP1 cluman 10_09_2017 | | 70ef5911-208e-4cac-93e2-6fe9033db560 | ELP2 cluman 10_09_2017 | | e0b57fc9-e5c3-4b51-8b94-56cbccdf5401 | ESC-image | | 92dfe18c-df35-4aa9-8c52-9c663d3f839b | lgnaaa01-sept102017 | | 1461226b-4362-428b-bc90-0a98cbf33500 | tmobile-pcrf-13.1.1.iso | | 98275e15-37cf-4681-9bcc-d6ba18947d7b | tmobile-pcrf-13.1.1.qcow2 | +--------------------------------------+---------------------------+

Paso 6. Una vez identificada la instantánea se descargará (en este caso será la marcada arriba en verde), ahora descargue en formato QCOW2 con este comando glance image-download como se muestra aquí.

[root@elospd01 stack]# glance image-download 92dfe18c-df35-4aa9-8c52-9c663d3f839b --file /tmp/AAA-CPAR-LGNoct192017.qcow2 &

- El "&" envía el proceso a segundo plano. Esta acción tardará algún tiempo en completarse, una vez que se haya realizado, la imagen se puede encontrar en el directorio /tmp.

- Al enviar el proceso a segundo plano, si se pierde la conectividad, también se detiene el proceso.

- Ejecute el comando "disown -h" para que en caso de que se pierda la conexión SSH, el proceso se ejecute y termine en el OSPD.

7. Una vez finalizado el proceso de descarga, es necesario ejecutar un proceso de compresión, ya que esa instantánea puede llenarse con ZEROES debido a procesos, tareas y archivos temporales manejados por el sistema operativo. El comando que se utilizará para la compresión de archivos es virt-sparsify.

[root@elospd01 stack]# virt-sparsify AAA-CPAR-LGNoct192017.qcow2 AAA-CPAR-LGNoct192017_compressed.qcow2

Este proceso lleva algún tiempo (unos 10-15 minutos). Una vez terminado, el archivo resultante es el que debe transferirse a una entidad externa como se especifica en el paso siguiente.

Para lograr esto, se requiere la verificación de la integridad del archivo, ejecute el siguiente comando y busque el atributo "corrupto" al final de su salida.

[root@wsospd01 tmp]# qemu-img info AAA-CPAR-LGNoct192017_compressed.qcow2 image: AAA-CPAR-LGNoct192017_compressed.qcow2 file format: qcow2 virtual size: 150G (161061273600 bytes) disk size: 18G cluster_size: 65536 Format specific information: compat: 1.1 lazy refcounts: false refcount bits: 16 corrupt: false

Para evitar un problema donde se pierde la OSPD, la instantánea creada recientemente en formato QCOW2 debe transferirse a una entidad externa. Antes de iniciar la transferencia de archivos tenemos que verificar si el destino tiene suficiente espacio disponible en disco, utilice el comando df -kh para verificar el espacio de memoria. Nuestro consejo es transferirla temporalmente al OSPD de otro sitio mediante SFTP "sftproot@x.x.x.x" donde x.x.x.x es la IP de un OSPD remoto. Para acelerar la transferencia, el destino se puede enviar a varios OSPD. De la misma manera, podemos utilizar el siguiente comando scp *name_of_the_file*.qcow2 root@ x.x.x.x.x:/tmp (donde x.x.x.x es la IP de un OSPD remoto) para transferir el archivo a otro OSPD.

Poner CEPH en modo de mantenimiento

Paso 1. Verificar que el estado del árbol ODS de la ceph esté activo en el servidor

[heat-admin@pod2-stack-osd-compute-0 ~]$ sudo ceph osd tree

ID WEIGHT TYPE NAME UP/DOWN REWEIGHT PRIMARY-AFFINITY

-1 13.07996 root default

-2 4.35999 host pod2-stack-osd-compute-0

0 1.09000 osd.0 up 1.00000 1.00000

3 1.09000 osd.3 up 1.00000 1.00000

6 1.09000 osd.6 up 1.00000 1.00000

9 1.09000 osd.9 up 1.00000 1.00000

-3 4.35999 host pod2-stack-osd-compute-1

1 1.09000 osd.1 up 1.00000 1.00000

4 1.09000 osd.4 up 1.00000 1.00000

7 1.09000 osd.7 up 1.00000 1.00000

10 1.09000 osd.10 up 1.00000 1.00000

-4 4.35999 host pod2-stack-osd-compute-2

2 1.09000 osd.2 up 1.00000 1.00000

5 1.09000 osd.5 up 1.00000 1.00000

8 1.09000 osd.8 up 1.00000 1.00000

11 1.09000 osd.11 up 1.00000 1.00000

Paso 2. Inicie sesión en el nodo OSD Compute y coloque CEPH en el modo de mantenimiento.

[root@pod2-stack-osd-compute-0 ~]# sudo ceph osd set norebalance

[root@pod2-stack-osd-compute-0 ~]# sudo ceph osd set noout

[root@pod2-stack-osd-compute-0 ~]# sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_WARN

noout,norebalance,sortbitwise,require_jewel_osds flag(s) set

monmap e1: 3 mons at {pod2-stack-controller-0=11.118.0.10:6789/0,pod2-stack-controller-1=11.118.0.11:6789/0,pod2-stack-controller-2=11.118.0.12:6789/0}

election epoch 10, quorum 0,1,2 pod2-stack-controller-0,pod2-stack-controller-1,pod2-stack-controller-2

osdmap e79: 12 osds: 12 up, 12 in

flags noout,norebalance,sortbitwise,require_jewel_osds

pgmap v22844323: 704 pgs, 6 pools, 804 GB data, 423 kobjects

2404 GB used, 10989 GB / 13393 GB avail

704 active+clean

client io 3858 kB/s wr, 0 op/s rd, 546 op/s wr

Nota: Cuando se elimina CEPH, el RAID HD VNF entra en el estado Degradado, pero el disco duro aún debe estar accesible

Apagado Graceful

Apagar el nodo

- Para apagar la instancia: nova stop <INSTANCE_NAME>

- Aparece el nombre de la instancia con el estado apagado.

[stack@director ~]$ nova stop aaa2-21 Request to stop server aaa2-21 has been accepted. [stack@director ~]$ nova list +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+ | ID | Name | Status | Task State | Power State | Networks | +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+ | 46b4b9eb-a1a6-425d-b886-a0ba760e6114 | AAA-CPAR-testing-instance | ACTIVE | - | Running | tb1-mgmt=172.16.181.14, 10.225.247.233; radius-routable1=10.160.132.245; diameter-routable1=10.160.132.231 | | 3bc14173-876b-4d56-88e7-b890d67a4122 | aaa2-21 | SHUTOFF | - | Shutdown | diameter-routable1=10.160.132.230; radius-routable1=10.160.132.248; tb1-mgmt=172.16.181.7, 10.225.247.234 | | f404f6ad-34c8-4a5f-a757-14c8ed7fa30e | aaa21june | ACTIVE | - | Running | diameter-routable1=10.160.132.233; radius-routable1=10.160.132.244; tb1-mgmt=172.16.181.10 | +--------------------------------------+---------------------------+---------+------------+-------------+------------------------------------------------------------------------------------------------------------+

Sustitución de la placa madre

Los pasos para reemplazar la placa base en un servidor UCS C240 M4 se pueden consultar desde la Guía de Instalación y Servicio del Servidor Cisco UCS C240 M4

- Inicie sesión en el servidor con la IP de CIMC.

- Realice la actualización del BIOS si el firmware no se ajusta a la versión recomendada utilizada anteriormente. Los pasos para la actualización del BIOS se indican a continuación: Guía de actualización del BIOS del servidor de montaje en bastidor Cisco UCS C-Series

Sacar CEPH del modo de mantenimiento

Inicie sesión en el nodo OSD Compute y mueva CEPH fuera del modo de mantenimiento.

[root@pod2-stack-osd-compute-0 ~]# sudo ceph osd unset norebalance

[root@pod2-stack-osd-compute-0 ~]# sudo ceph osd unset noout

[root@pod2-stack-osd-compute-0 ~]# sudo ceph status

cluster eb2bb192-b1c9-11e6-9205-525400330666

health HEALTH_OK

monmap e1: 3 mons at {pod2-stack-controller-0=11.118.0.10:6789/0,pod2-stack-controller-1=11.118.0.11:6789/0,pod2-stack-controller-2=11.118.0.12:6789/0}

election epoch 10, quorum 0,1,2 pod2-stack-controller-0,pod2-stack-controller-1,pod2-stack-controller-2

osdmap e81: 12 osds: 12 up, 12 in

flags sortbitwise,require_jewel_osds

pgmap v22844355: 704 pgs, 6 pools, 804 GB data, 423 kobjects

2404 GB used, 10989 GB / 13393 GB avail

704 active+clean

client io 3658 kB/s wr, 0 op/s rd, 502 op/s wr

Restauración de las VM

Recuperación de una Instancia mediante Snapshot

Proceso de recuperación:

Es posible volver a implementar la instancia anterior con la instantánea tomada en pasos anteriores.

Paso 1 [OPCIONAL].Si no hay ninguna VMSnapshots anterior, conéctese al nodo OSPD donde se envió la copia de seguridad y devuelva la copia de seguridad a su nodo OSPD original. Usar "sftproot@x.x.x.x" donde x.x.x.x es la IP del OSPD original. Guarde el archivo de instantánea en el directorio /tmp.

Paso 2.Conéctese al nodo OSPD donde se vuelve a implementar la instancia.

Utilice las variables de entorno con este comando:

# source /home/stack/pod1-stackrc-Core-CPAR

Paso 3.Para utilizar la instantánea como una imagen es necesario cargarla en el horizonte como tal. Utilice el siguiente comando para hacerlo.

#glance image-create -- AAA-CPAR-Date-snapshot.qcow2 --container-format bare --disk-format qcow2 --name AAA-CPAR-Date-snapshot

El proceso puede verse en el horizonte.

Paso 4.En Horizon, navegue hasta Project > Inases y haga clic en Iniciar instancia.

Paso 5.Rellene el nombre de la instancia y elija la zona de disponibilidad.

Paso 6.En la ficha Origen, elija la imagen para crear la instancia. En el menú Select Boot Source (Seleccionar origen de arranque) seleccione image, se muestra una lista de imágenes aquí, elija la que se cargó anteriormente al hacer clic en el + signo.

Paso 7.En la pestaña Sabor, elija el sabor AAA mientras hace clic en el signo +.

Paso 8.Por último, desplácese a la ficha de red y elija las redes que necesita la instancia a medida que hace clic en el signo +. Para este caso seleccione diámetro-soutable1, radius-routable1 y tb1-mgmt.

Paso 9. Por último, haga clic en Iniciar instancia para crearla. El progreso se puede supervisar en Horizonte:

Después de unos minutos, la instancia se implementa completamente y está lista para su uso.

Creación y asignación de una dirección IP flotante

Una dirección IP flotante es una dirección enrutable, lo que significa que se puede alcanzar desde el exterior de la arquitectura Ultra M/Openstack, y es capaz de comunicarse con otros nodos desde la red.

Paso 1.En el menú superior Horizonte, vaya aAdmin > Floating IPs.

Paso 2.Haga clic en el botónAsignarIP al proyecto.

Paso 3. En la ventana IP flotante de asignación, seleccione el grupo desde el que pertenece la nueva IP flotante, elProyecto donde se va a asignar y la nueva dirección IP flotante.

Por ejemplo:

Paso 4.Haga clic en el botón Asignar IP flotante.

Paso 5. En el menú superior Horizonte, vaya aProject > Instancias.

Paso 6. En la columnaAcción, haga clic en la flecha que apunta hacia abajo en el botón Crear instantáneas, se debe mostrar un menú. SeleccionarAsociar opción IP flotante.

Paso 7. Seleccione la dirección IP flotante correspondiente que se utilizará en el campo Dirección IP y elija la interfaz de administración correspondiente (eth0) de la nueva instancia donde se va a asignar esta IP flotante en elPuerto que se va a asociar. Consulte la siguiente imagen como ejemplo de este procedimiento.

Paso 8.Por último, haga clic en el botón Asociado.

Habilitación de SSH

Paso 1.En el menú superior Horizonte, vaya aProject > Instancias.

Paso 2.Haga clic en el nombre de la instancia/VM que se creó en la secciónAlmorzar una nueva instancia.

Paso 3.Haga clic en Consoletab. Muestra la CLI de la máquina virtual.

Paso 4. Una vez que se muestre la CLI, introduzca las credenciales de inicio de sesión correctas:

Nombre de usuario:root

Contraseña:cisco123

Paso 5.En la CLI, ingrese el comando commandvi /etc/ssh/sshd_configto edit ssh configuration.

Paso 6. Una vez abierto el archivo de configuración ssh, pulse Ito para editar el archivo. A continuación, busque la sección que se muestra aquí y cambie la primera línea desdePasswordAuthentication notoPasswordAuthentication yes.

Paso 7.Presione ESCe ingrese :wq!para guardar los cambios del archivo sshd_config.

Paso 8. Ejecute el comando sshd restart.

Paso 9.Para probar los cambios de configuración de SSH se han aplicado correctamente, abra cualquier cliente SSH e intente establecer una conexión segura remota usando la IP flotante asignada a la instancia (es decir, 10.145.0.249) y la userroot.

Establecer una sesión SSH

Abra una sesión SSH utilizando la dirección IP de la VM/servidor correspondiente donde está instalada la aplicación.

Inicio de instancia de CPAR

Siga estos pasos, una vez que se haya completado la actividad y los servicios CPAR puedan restablecerse en el Sitio que se cerró.

- Vuelva a iniciar sesión en Horizon, navegue hasta Project > Instance > Start Instance.

- Verifique que el estado de la instancia esté activo y que el estado de energía esté en ejecución:

Comprobación de estado posterior a la actividad

Paso 1. Ejecute el comando /opt/CSCOar/bin/arstatus a nivel del SO.

[root@aaa04 ~]# /opt/CSCOar/bin/arstatus Cisco Prime AR RADIUS server running (pid: 24834) Cisco Prime AR Server Agent running (pid: 24821) Cisco Prime AR MCD lock manager running (pid: 24824) Cisco Prime AR MCD server running (pid: 24833) Cisco Prime AR GUI running (pid: 24836) SNMP Master Agent running (pid: 24835) [root@wscaaa04 ~]#

Paso 2. Ejecute el comando /opt/CSCOar/bin/aregcmd a nivel del sistema operativo e ingrese las credenciales de administración. Verifique que CPAR Health sea 10 de 10 y que salga de CPAR CLI.

[root@aaa02 logs]# /opt/CSCOar/bin/aregcmd Cisco Prime Access Registrar 7.3.0.1 Configuration Utility Copyright (C) 1995-2017 by Cisco Systems, Inc. All rights reserved. Cluster: User: admin Passphrase: Logging in to localhost [ //localhost ] LicenseInfo = PAR-NG-TPS 7.2(100TPS:) PAR-ADD-TPS 7.2(2000TPS:) PAR-RDDR-TRX 7.2() PAR-HSS 7.2() Radius/ Administrators/ Server 'Radius' is Running, its health is 10 out of 10 --> exit

Paso 3.Ejecute el comando netstat | diámetro grep y verifique que se hayan establecido todas las conexiones DRA.

El resultado mencionado aquí es para un entorno en el que se esperan links Diámetro. Si se muestran menos enlaces, esto representa una desconexión del DRA que se debe analizar.

[root@aa02 logs]# netstat | grep diameter tcp 0 0 aaa02.aaa.epc.:77 mp1.dra01.d:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:36 tsa6.dra01:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:47 mp2.dra01.d:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:07 tsa5.dra01:diameter ESTABLISHED tcp 0 0 aaa02.aaa.epc.:08 np2.dra01.d:diameter ESTABLISHED

Paso 4.Compruebe que el registro TPS muestra las solicitudes que está procesando el CPAR. Los valores resaltados representan el TPS y esos son a los que debemos prestar atención.

El valor de TPS no debe exceder de 1500.

[root@wscaaa04 ~]# tail -f /opt/CSCOar/logs/tps-11-21-2017.csv 11-21-2017,23:57:35,263,0 11-21-2017,23:57:50,237,0 11-21-2017,23:58:05,237,0 11-21-2017,23:58:20,257,0 11-21-2017,23:58:35,254,0 11-21-2017,23:58:50,248,0 11-21-2017,23:59:05,272,0 11-21-2017,23:59:20,243,0 11-21-2017,23:59:35,244,0 11-21-2017,23:59:50,233,0

Paso 5.Busque cualquier mensaje de "error" o "alarma" en name_radius_1_log

[root@aaa02 logs]# grep -E "error|alarm" name_radius_1_log

Paso 6.Verifique la cantidad de memoria que el proceso CPAR utiliza con este comando:

arriba | grep radius

[root@sfraaa02 ~]# top | grep radius 27008 root 20 0 20.228g 2.413g 11408 S 128.3 7.7 1165:41 radius

Este valor resaltado debe ser menor que: 7 Gb, que es el máximo permitido en un nivel de aplicación.

Sustitución de la placa madre en el nodo controlador

Verifique el estado del controlador y coloque el clúster en modo de mantenimiento

Desde OSPD, inicie sesión en el controlador y verifique que los pc estén en buen estado - los tres controladores Online y galera muestran los tres controladores como Master.

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod2-stack-controller-2 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

Last updated: Fri Jul 6 09:02:52 2018Last change: Mon Jul 2 12:49:52 2018 by root via crm_attribute on pod2-stack-controller-0

3 nodes and 19 resources configured

Online: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Full list of resources:

ip-11.120.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-192.200.0.110(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

ip-11.120.0.44(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

ip-11.118.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-10.225.247.214(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Master/Slave Set: redis-master [redis]

Masters: [ pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-0 pod2-stack-controller-1 ]

ip-11.119.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

openstack-cinder-volume(systemd:openstack-cinder-volume):Started pod2-stack-controller-1

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

Ponga el clúster en modo de mantenimiento

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs cluster standby

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod2-stack-controller-2 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

Last updated: Fri Jul 6 09:03:10 2018Last change: Fri Jul 6 09:03:06 2018 by root via crm_attribute on pod2-stack-controller-0

3 nodes and 19 resources configured

Node pod2-stack-controller-0: standby

Online: [ pod2-stack-controller-1 pod2-stack-controller-2 ]

Full list of resources:

ip-11.120.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod2-stack-controller-1 pod2-stack-controller-2 ]

Stopped: [ pod2-stack-controller-0 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-192.200.0.110(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

ip-11.120.0.44(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

ip-11.118.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

ip-10.225.247.214(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Master/Slave Set: redis-master [redis]

Masters: [ pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-1 ]

Stopped: [ pod2-stack-controller-0 ]

ip-11.119.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

openstack-cinder-volume(systemd:openstack-cinder-volume):Started pod2-stack-controller-1

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

Sustitución de la placa madre

El procedimiento para sustituir la placa base en un servidor UCS C240 M4 puede derivarse de la Guía de Instalación y Servicio del Servidor Cisco UCS C240 M4

- Inicie sesión en el servidor con la IP de CIMC.

- Realice la actualización del BIOS si el firmware no se ajusta a la versión recomendada utilizada anteriormente. Los pasos para la actualización del BIOS se indican a continuación:

Guía de actualización del BIOS del servidor de montaje en bastidor Cisco UCS C-Series

Restaurar estado del clúster

Inicie sesión en el controlador afectado, quite el modo en espera configurando unstandby. Verify controller viene Online con cluster y galera muestra los tres controladores como Master. Esto puede tardar unos minutos.

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs cluster unstandby

[heat-admin@pod2-stack-controller-0 ~]$ sudo pcs status

Cluster name: tripleo_cluster

Stack: corosync

Current DC: pod2-stack-controller-2 (version 1.1.15-11.el7_3.4-e174ec8) - partition with quorum

Last updated: Fri Jul 6 09:03:37 2018Last change: Fri Jul 6 09:03:35 2018 by root via crm_attribute on pod2-stack-controller-0

3 nodes and 19 resources configured

Online: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Full list of resources:

ip-11.120.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Clone Set: haproxy-clone [haproxy]

Started: [ pod2-stack-controller-0 pod2-stack-controller-1 pod2-stack-controller-2 ]

Master/Slave Set: galera-master [galera]

Masters: [ pod2-stack-controller-1 pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-0 ]

ip-192.200.0.110(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

ip-11.120.0.44(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

ip-11.118.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

Clone Set: rabbitmq-clone [rabbitmq]

Started: [ pod2-stack-controller-1 pod2-stack-controller-2 ]

Stopped: [ pod2-stack-controller-0 ]

ip-10.225.247.214(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-1

Master/Slave Set: redis-master [redis]

Masters: [ pod2-stack-controller-2 ]

Slaves: [ pod2-stack-controller-0 pod2-stack-controller-1 ]

ip-11.119.0.49(ocf::heartbeat:IPaddr2):Started pod2-stack-controller-2

openstack-cinder-volume(systemd:openstack-cinder-volume):Started pod2-stack-controller-1

Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

Con la colaboración de ingenieros de Cisco

- Karthikeyan DachanamoorthyCisco Advance Services

- Harshita BhardwajCisco Advance Services

Contacte a Cisco

- Abrir un caso de soporte

- (Requiere un Cisco Service Contract)

Comentarios

Comentarios