Introducción

Este documento describe el análisis de la conectividad de red o la vida útil del paquete para un dominio de Unified Computing System (UCS) en el modo administrado de Intersight e identifica la conexión interna de los servidores con los comandos API Explorer y NXOS.

Colaborado por Luis Uribe, ingeniero del TAC de Cisco.

Prerequisites

Requirements

Cisco recomienda que tenga conocimiento sobre estos temas:

- Intersight

- Conectividad de red física

- Interfaz de programación de aplicaciones (API)

Componentes Utilizados

La información que contiene este documento se basa en las siguientes versiones de software y hardware.

- Fabric Interconnect Cisco UCS 6454, firmware 4.2(1e)

- Servidor blade UCSB-B200-M5, firmware 4.2(1a)

- Software de interconexión como servicio (SaaS)

The information in this document was created from the devices in a specific lab environment. All of the devices used in this document started with a cleared (default) configuration. Si tiene una red en vivo, asegúrese de entender el posible impacto de cualquier comando.

Antecedentes

La conexión entre Fabric Interconnects y Virtual Network Interface (vNIC) se establece a través de circuitos virtuales, llamados Virtual Interface (VIF). Tales VIF están anclados a enlaces ascendentes y permiten la comunicación con la red ascendente

En el Modo administrado de Intersight no hay ningún comando que mapee las interfaces virtuales con cada servidor como show service-profile circuit. Los comandos API Explorer/NXOS se pueden utilizar para determinar la relación de los circuitos internos creados dentro del dominio UCS.

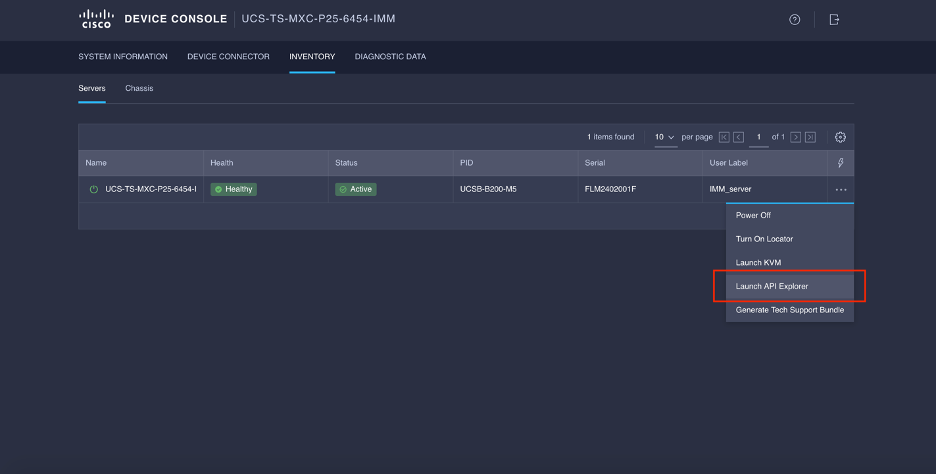

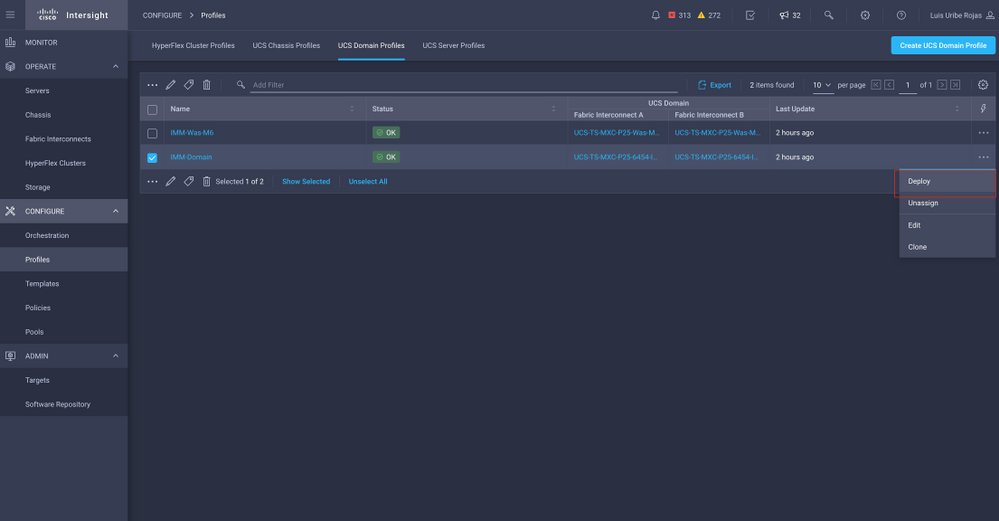

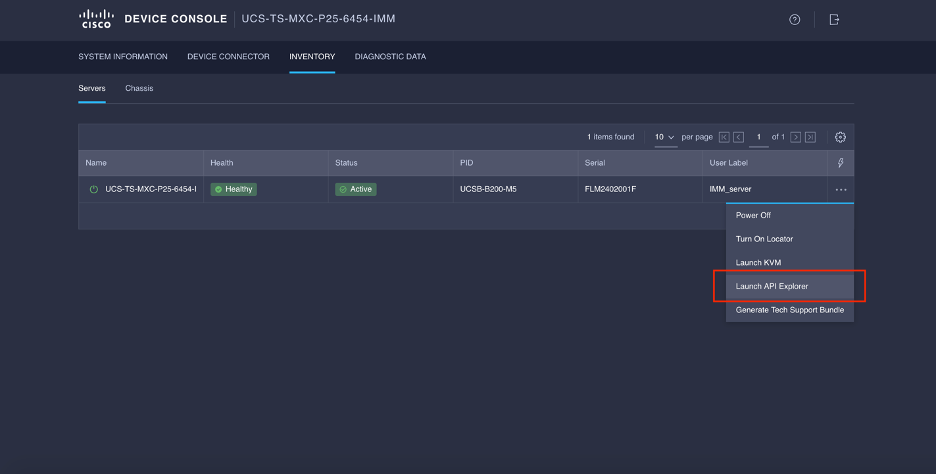

Explorador de API

API Explorer está disponible en la interfaz gráfica de usuario (GUI) de cualquiera de los fabric interconnects (principal o subordinado). Una vez que haya iniciado sesión en la consola, vaya a Inventory (Inventario), seleccione el servidor y, a continuación, haga clic en Launch API Explorer (Iniciar el Explorador de API).

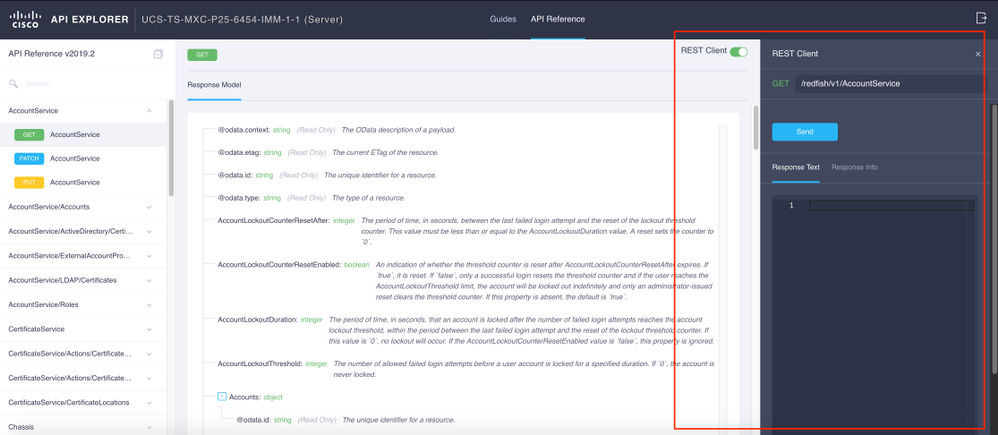

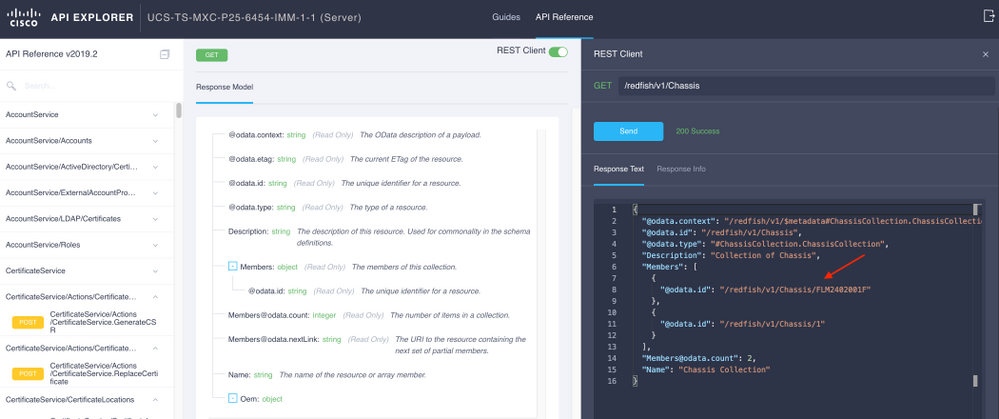

El Explorador de la API contiene una Referencia de la API, que muestra las llamadas disponibles. También incluye una interfaz de cliente de transferencia de estado representacional (REST) para probar las llamadas de API.

Identificación de VIF mediante llamadas API

Puede utilizar un conjunto de llamadas API para determinar qué VIF corresponde a cada vNIC virtual. Esto le permite resolver problemas de NXOS de manera más eficaz.

A los efectos de este documento, la navegación con llamadas API se realiza a través de estos elementos: Chasis, servidor, adaptador de red, vNIC/vHBA.

| Llamada de API |

Sintaxis |

| ID del chasis GET |

/redfish/v1/Chassis |

| ID del adaptador GET |

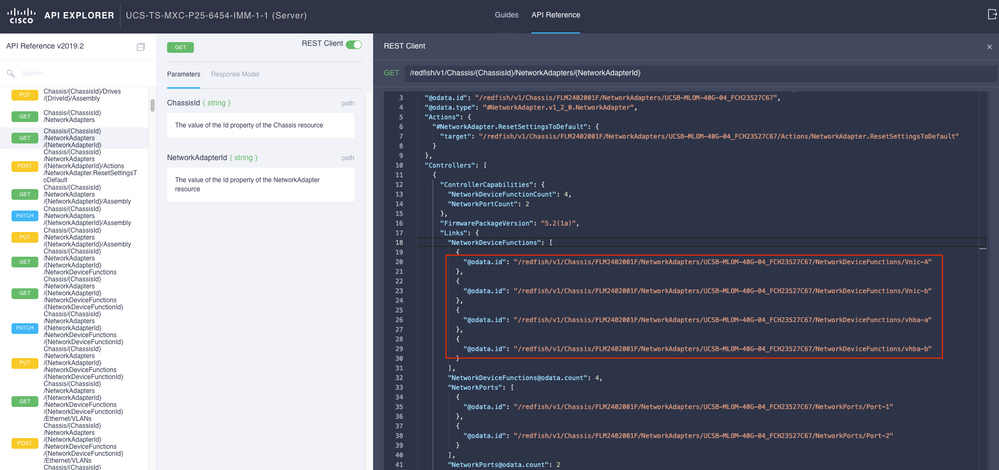

/redfish/v1/Chassis/{ChassisId}/Network Adapters |

| GET Network details (lista de vnics/vhbas) |

/redfish/v1/Chassis/{ChassisId}/Network Adapters/{NetworkAdapterId} |

| Funciones de dispositivos de red GET (configuración vNIC) |

/redfish/v1/Chassis/{ChassisId}/NetworkAdapters/{NetworkAdapterId}/NetworkDeviceFunctions |

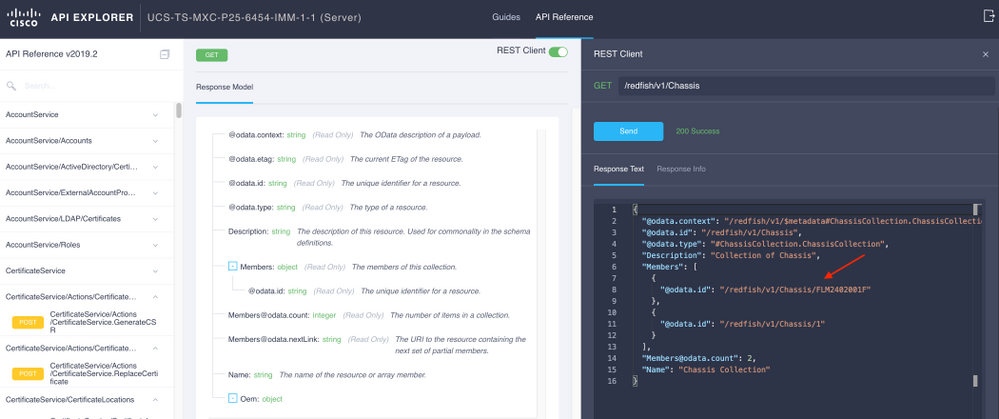

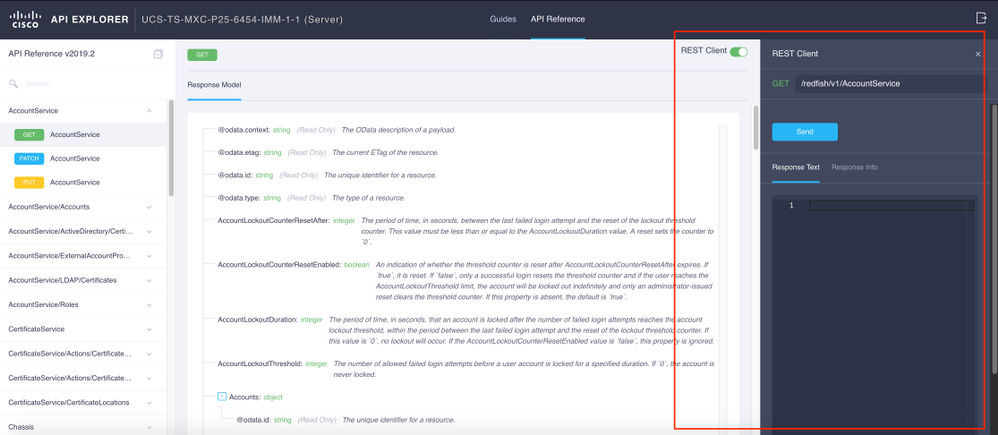

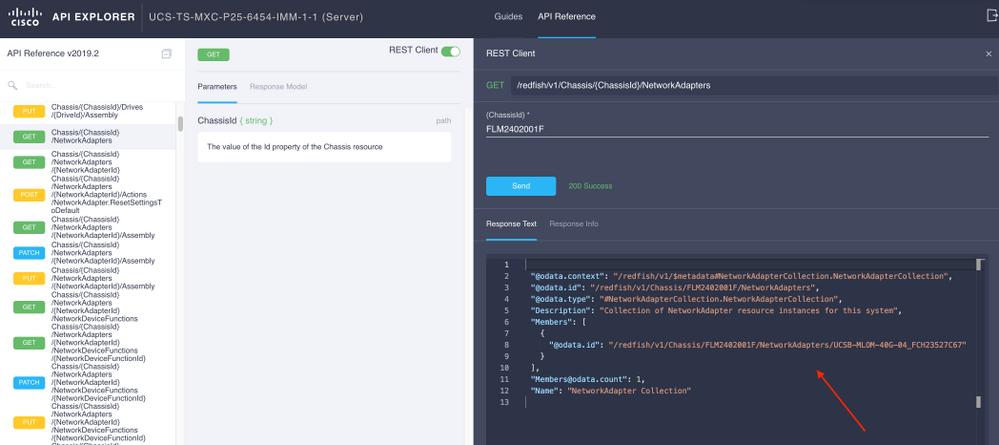

Recuperar ID del chasis

Copie el ID del chasis para la llamada de la API.

/redfish/v1/Chassis/FLM2402001F

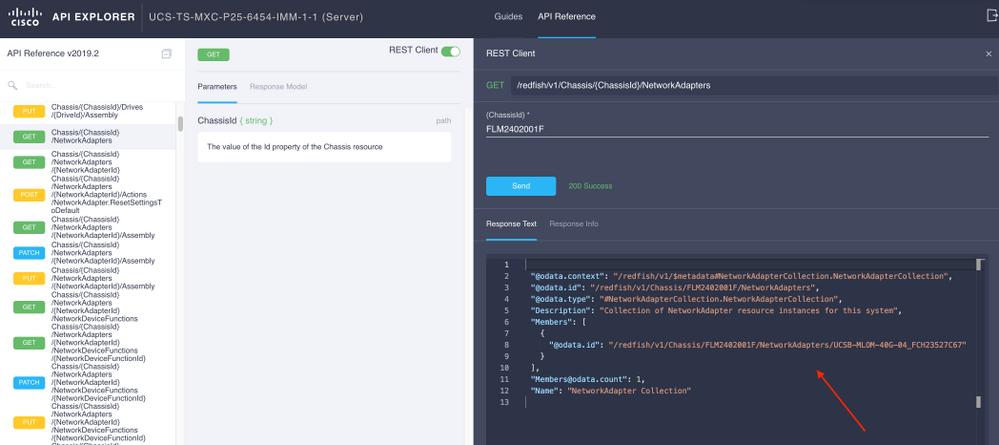

Recuperar la ID del adaptador de red

Copie el ID de red para la próxima llamada de API.

/redfish/v1/Chassis/FLM2402001F/NetworkAdapters/UCSB-MLOM-40G-04_FCH23527C67

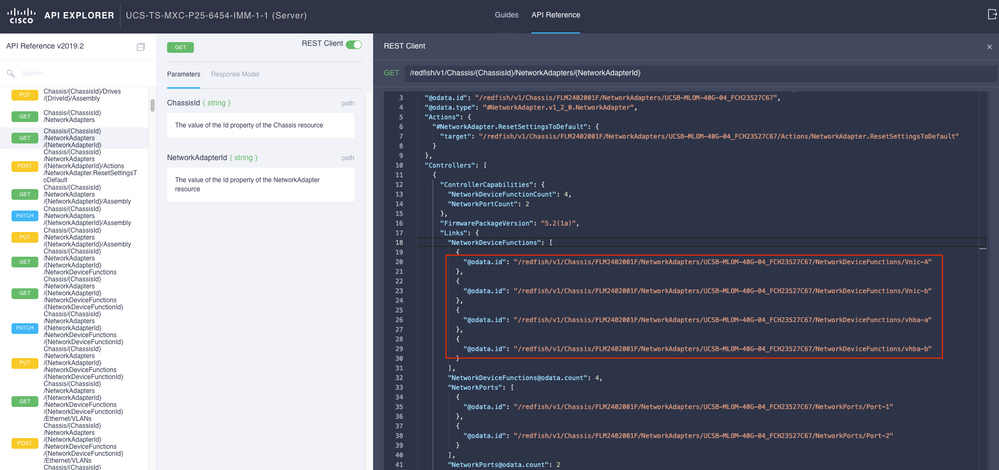

Recuperar ID vNIC

Copie la ID del adaptador de red.

/redfish/v1/Chassis/FLM2402001F/NetworkAdapters/UCSB-MLOM-40G-04_FCH23527C67/NetworkDeviceFunctions/Vnic-A

/redfish/v1/Chassis/FLM2402001F/NetworkAdapters/UCSB-MLOM-40G-04_FCH23527C67/NetworkDeviceFunctions/Vnic-B

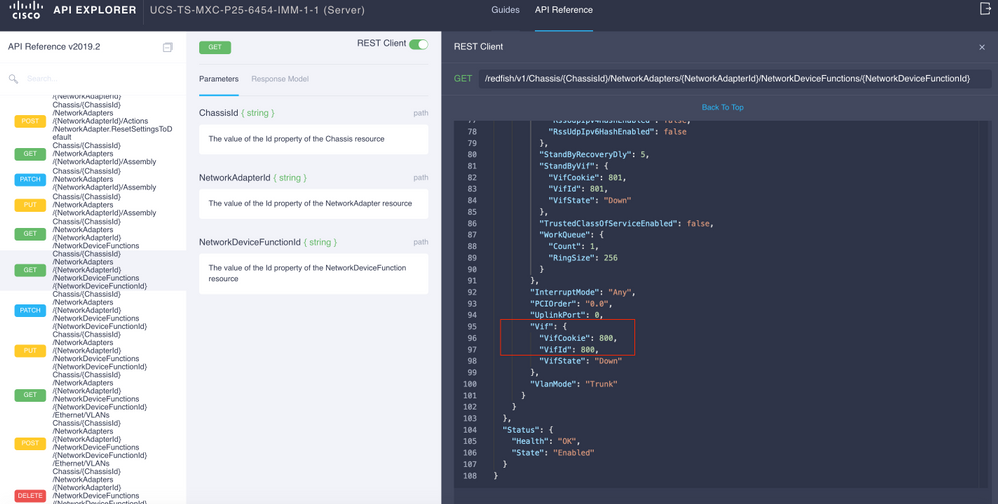

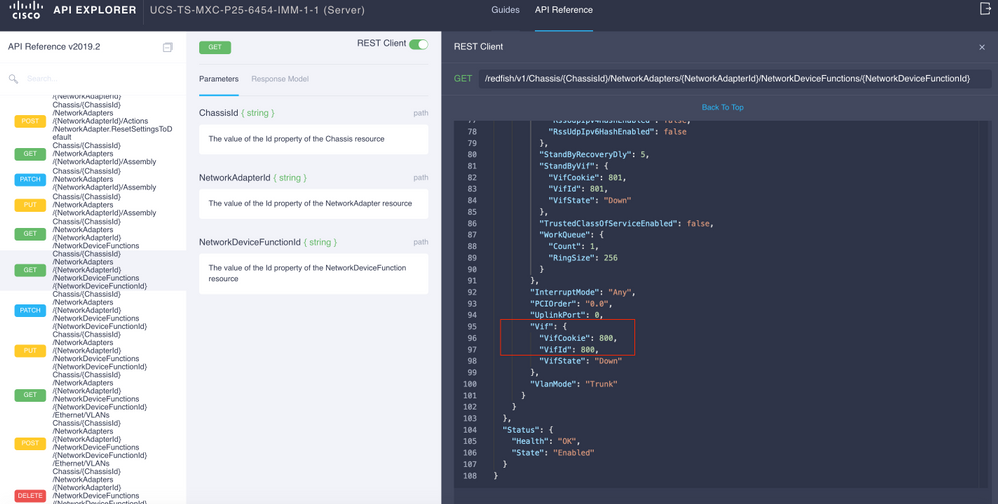

Recuperar el ID de VIF del vNIC correspondiente

En este caso, vNIC-A se mapea a VIF 800. Desde aquí, los comandos NXOS contienen esta interfaz virtual.

Identificación de VIF con NXOS y Filtros Grep

Si el Explorador de API no está disponible o no tiene acceso a la GUI, se pueden utilizar comandos CLI para recuperar información de VIF.

Nota: Debe conocer el perfil del servidor para utilizar estos comandos.

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show run interface | grep prev 1 IMM-Server-1

switchport trunk allowed vsan 1

switchport description SP IMM-Server-1, vHBA vhba-a, Blade:FLM2402001F

--

interface Vethernet800

description SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

--

interface Vethernet803

description SP IMM-Server-1, vNIC Vnic-b, Blade:FLM2402001F

--

interface Vethernet804

description SP IMM-Server-1, vHBA vhba-a, Blade:FLM2402001F

| Sintaxis del comando |

Uso |

| show run interface | grep prev 1 <nombre del perfil del servidor> |

Muestra las redes asociadas a cada vNIC/vHBA |

| show run interface | grep prev 1 next 10 <server profile name> |

Muestra la configuración detallada de Ethernet |

Solución de problemas de NXOS

Una vez que el vNIC se ha asignado a la Ethernet correspondiente, se puede realizar un análisis en NXOS con los mismos comandos que se utilizan para resolver problemas de interfaces físicas.

La notación para vNIC es veth - Vethernet.

show interface brief muestra Veth800 en estado descendente con ENM Source Pin Failure como la razón.

UCS-TS-MXC-P25-6454-IMM-A# connect nxos

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show interface brief | grep -i Veth800

Veth800 1 virt trunk down ENM Source Pin Fail auto

show interface muestra que la Ethernet 800 está en un estado de inicialización.

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show interface Vethernet 800

Vethernet800 is down (initializing)

Port description is SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

Hardware is Virtual, address is 0000.abcd.dcba

Port mode is trunk

Speed is auto-speed

Duplex mode is auto

300 seconds input rate 0 bits/sec, 0 packets/sec

300 seconds output rate 0 bits/sec, 0 packets/sec

Rx

0 unicast packets 0 multicast packets 0 broadcast packets

0 input packets 0 bytes

0 input packet drops

Tx

0 unicast packets 0 multicast packets 0 broadcast packets

0 output packets 0 bytes

0 flood packets

0 output packet drops

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show running-config interface Vethernet 800

!Command: show running-config interface Vethernet800

!Running configuration last done at: Mon Sep 27 16:03:46 2021

!Time: Tue Sep 28 14:35:22 2021

version 9.3(5)I42(1e) Bios:version 05.42

interface Vethernet800

description SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

no lldp transmit

no lldp receive

no pinning server sticky

pinning server pinning-failure link-down

no cdp enable

switchport mode trunk

switchport trunk allowed vlan 1,470

hardware vethernet mac filtering per-vlan

bind interface port-channel1280 channel 800

service-policy type qos input default-IMM-QOS

no shutdown

Un VIF necesita estar anclado a una interfaz de link ascendente, en este escenario show pinning border interface no muestra el Vethernet conectado a ningún link ascendente.

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show pinning border-interfaces

--------------------+---------+----------------------------------------

Border Interface Status SIFs

--------------------+---------+----------------------------------------

Eth1/45 Active sup-eth1

Eth1/46 Active Eth1/1/33

Esto indica que los enlaces ascendentes requieren configuración adicional. Esta salida corresponde a la configuración show running del link ascendente Ethernet 1/46.

UCS-TS-MXC-P25-6454-IMM-B(nx-os)# show running-config interface ethernet 1/45

!Command: show running-config interface Ethernet1/45

!No configuration change since last restart

!Time: Wed Sep 29 05:15:21 2021

version 9.3(5)I42(1e) Bios:version 05.42

interface Ethernet1/45

description Uplink

pinning border

switchport mode trunk

switchport trunk allowed vlan 69,470

no shutdown

show mac address-table detalla que Veth800 utiliza VLAN 1 que no está presente en los links ascendentes.

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show mac address-table

Legend:

* - primary entry, G - Gateway MAC, (R) - Routed MAC, O - Overlay MAC

age - seconds since last seen,+ - primary entry using vPC Peer-Link,

(T) - True, (F) - False, C - ControlPlane MAC, ~ - vsan

VLAN MAC Address Type age Secure NTFY Ports

---------+-----------------+--------+---------+------+----+------------------

* 1 0025.b501.0036 static - F F Veth800

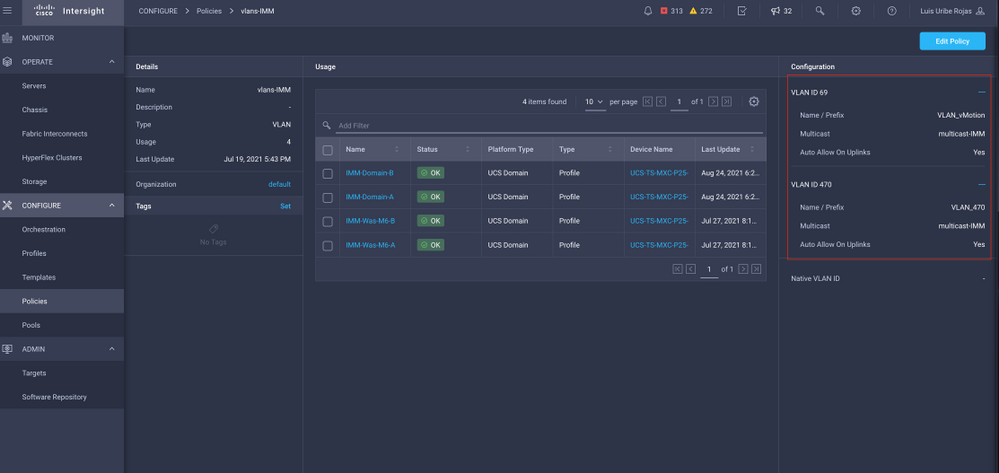

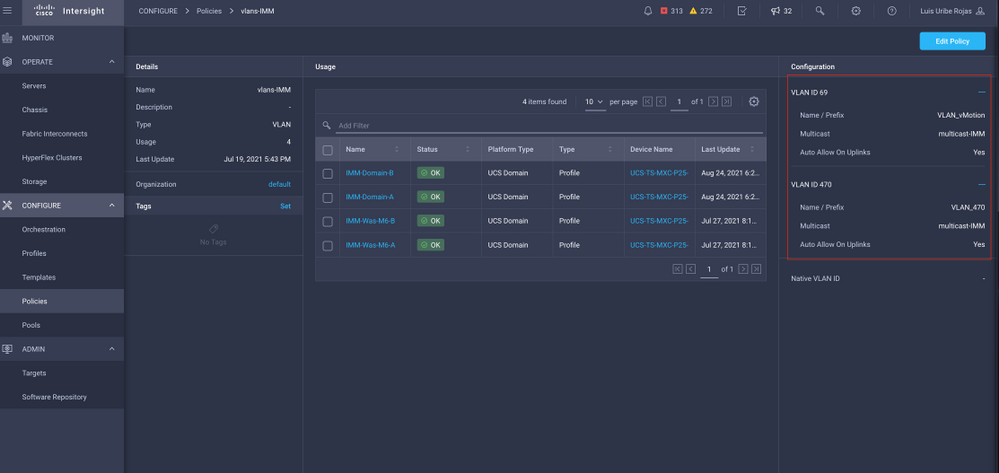

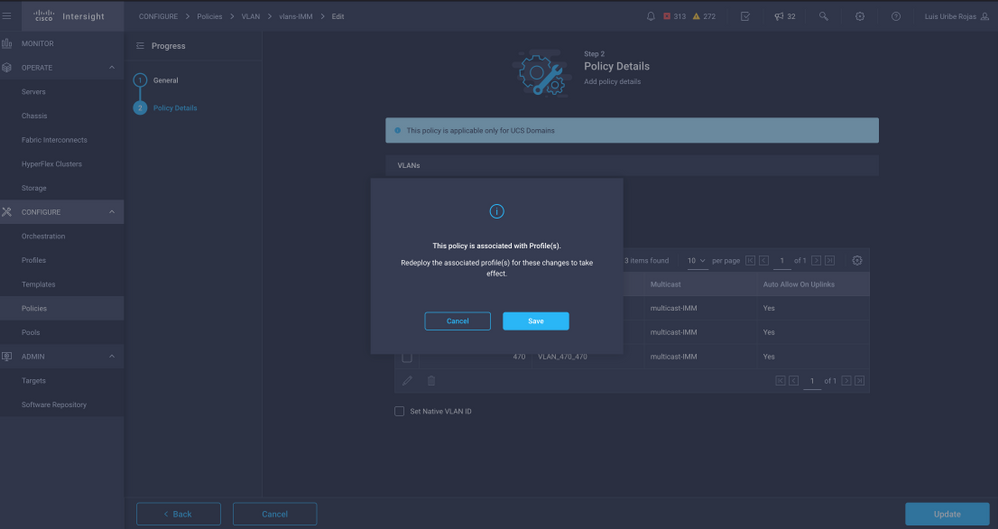

En un dominio UCS, la VLAN en uso se debe incluir también en el vNIC y en los enlaces ascendentes. La política de VLAN configura las VLAN en los fabric interconnects. La imagen muestra la configuración de este dominio UCS.

La VLAN 1 no está presente en la política, por lo que se debe agregar.

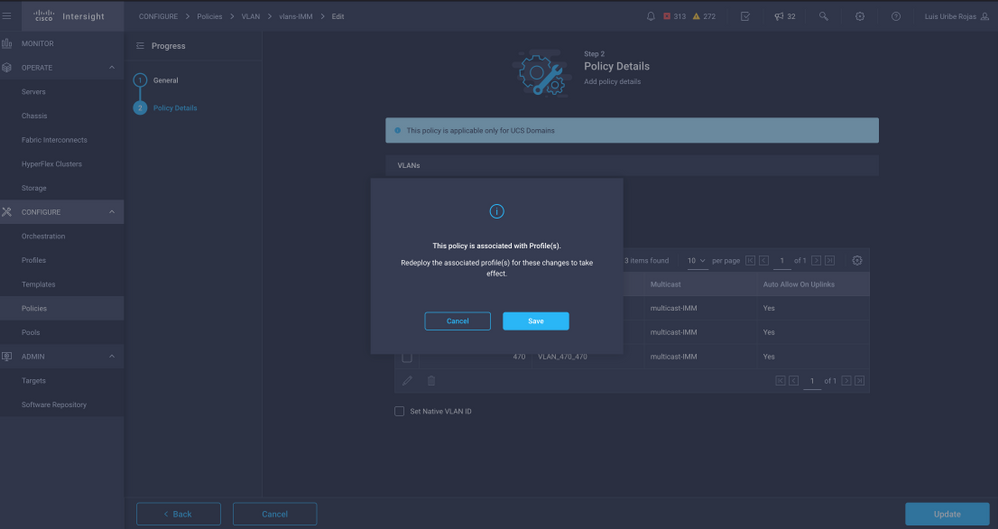

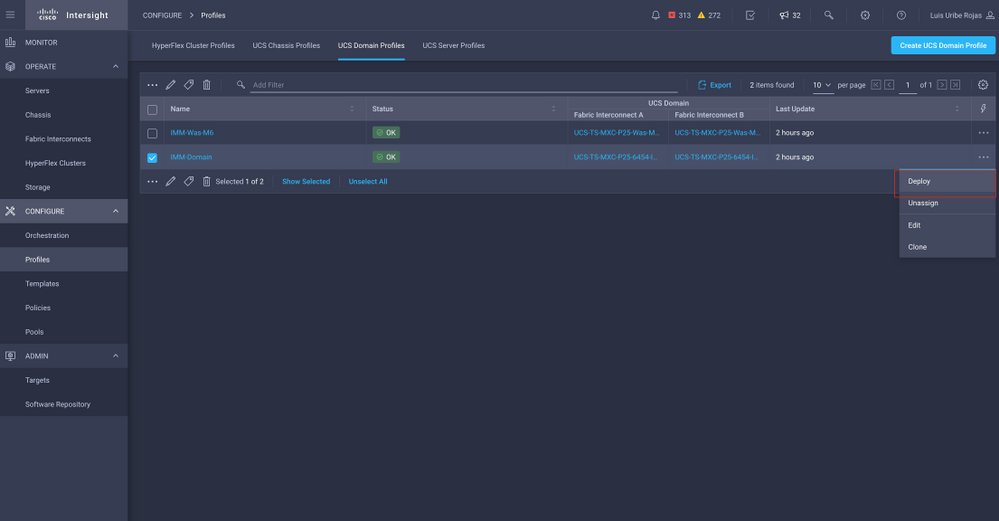

Seleccione Editar política para permitir la conectividad. Este cambio requiere la implementación del perfil de dominio de UCS.

La asignación de VLAN se puede verificar mediante CLI:

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show running-config interface ethernet 1/45

!Command: show running-config interface Ethernet1/45

!Running configuration last done at: Wed Sep 29 07:50:43 2021

!Time: Wed Sep 29 07:59:31 2021

version 9.3(5)I42(1e) Bios:version 05.42

interface Ethernet1/45

description Uplink

pinning border

switchport mode trunk

switchport trunk allowed vlan 1,69,470

udld disable

no shutdown

UCS-TS-MXC-P25-6454-IMM-A(nx-os)#

Ahora que se agregan las VLAN necesarias, se puede utilizar el mismo conjunto de comandos para verificar la conectividad en Vethernet800:

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show interface brief | grep -i Veth800

Veth800 1 virt trunk up none auto

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show interface Vethernet 800

Vethernet800 is up

Port description is SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

Hardware is Virtual, address is 0000.abcd.dcba

Port mode is trunk

Speed is auto-speed

Duplex mode is auto

300 seconds input rate 0 bits/sec, 0 packets/sec

300 seconds output rate 0 bits/sec, 0 packets/sec

Rx

0 unicast packets 1 multicast packets 6 broadcast packets

7 input packets 438 bytes

0 input packet drops

Tx

0 unicast packets 25123 multicast packets 137089 broadcast packets

162212 output packets 11013203 bytes

0 flood packets

0 output packet drops

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show running-config interface Vethernet 800

!Command: show running-config interface Vethernet800

!Running configuration last done at: Wed Sep 29 07:50:43 2021

!Time: Wed Sep 29 07:55:51 2021

version 9.3(5)I42(1e) Bios:version 05.42

interface Vethernet800

description SP IMM-Server-1, vNIC Vnic-A, Blade:FLM2402001F

no lldp transmit

no lldp receive

no pinning server sticky

pinning server pinning-failure link-down

switchport mode trunk

switchport trunk allowed vlan 1,69,470

hardware vethernet mac filtering per-vlan

bind interface port-channel1280 channel 800

service-policy type qos input default-IMM-QOS

no shutdown

Veth800 aparece en las interfaces fijadas a las interfaces Ethernet de enlace ascendente:

UCS-TS-MXC-P25-6454-IMM-A(nx-os)# show pinning border-interfaces

--------------------+---------+----------------------------------------

Border Interface Status SIFs

--------------------+---------+----------------------------------------

Eth1/45 Active sup-eth1 Veth800 Veth803

Eth1/46 Active Eth1/1/33

Total Interfaces : 2

UCS-TS-MXC-P25-6454-IMM-A(nx-os)#

Las VIF ya están listas para transmitir tráfico a la red ascendente.

Información Relacionada

Comentarios

Comentarios