Nexus 5500 VM-FEX - Konfigurationsbeispiel

Inhalt

Einführung

In diesem Dokument wird beschrieben, wie die VM-FEX-Funktion (Virtual Machine Fabric Extender) auf Cisco Nexus 5500-Switches konfiguriert, betrieben und Fehler behoben werden.

Voraussetzungen

Anforderungen

Cisco empfiehlt, über grundlegende Kenntnisse dieser Themen zu verfügen.

- Nexus Virtual Port Channel (VPC)

- VMware vSphere

Verwendete Komponenten

Die Informationen in diesem Dokument basieren auf den folgenden Hardware- und Softwareversionen:

- Nexus 5548UP mit Version 5.2(1)N1(4)

- Unified Computing System (UCS)-C C210 M2 Rack-Server mit UCS P81E Virtual Interface Card, auf der Firmware-Version 1.4(2) ausgeführt wird

- vSphere Version 5.0 (ESXi und vCenter)

Die Informationen in diesem Dokument wurden von den Geräten in einer bestimmten Laborumgebung erstellt. Alle in diesem Dokument verwendeten Geräte haben mit einer leeren (Standard-)Konfiguration begonnen. Wenn Ihr Netzwerk in Betrieb ist, vergewissern Sie sich, dass Sie die potenziellen Auswirkungen eines Befehls oder einer Paketerfassung kennen.

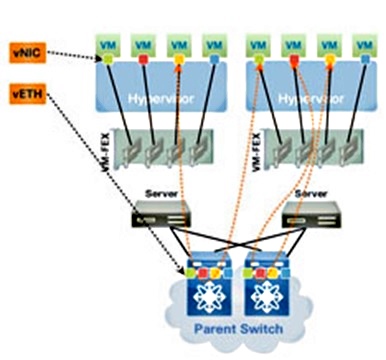

VM-FEX im Überblick

VM-FEX kombiniert virtuelle und physische Netzwerkfunktionen in einer einzigen Infrastruktur. Sie ermöglicht die Bereitstellung, Konfiguration und Verwaltung des Netzwerkverkehrs virtueller Systeme und des Bare-Metal-Netzwerkverkehrs in einer einheitlichen Infrastruktur.

Die VM-FEX-Software erweitert die Cisco Fabric Extender-Technologie auf das virtuelle System mit folgenden Funktionen:

- Jedes virtuelle System verfügt über eine dedizierte Schnittstelle am übergeordneten Switch.

- Der gesamte Datenverkehr virtueller Systeme wird direkt an die dedizierte Schnittstelle auf dem Switch gesendet.

- Der Standard-vSwitch im Hypervisor wird eliminiert.

VM-FEX ist ein Typ von verteiltem virtuellen Switch (DVS oder VDS). Der DVS stellt eine Abstraktion eines einzelnen Switches über mehrere ESX-Server hinweg dar, die Teil desselben Rechenzentrums-Containers in vCenter sind. Die Konfiguration des Virtual Machine (VM) Virtual Network Interface Controller (VNIC) wird zentral verwaltet (Nexus 5000 oder UCS in VM-FEX; in diesem Dokument wird der auf Nexus 5000 basierende VM-FEX veranschaulicht).

VM-FEX kann in zwei Modi betrieben werden:

- Passthrough: Dies ist der Standardmodus, in dem das VEM am Datenpfad für den VM-Datenverkehr beteiligt ist.

- Hohe Leistung: Der VM-Datenverkehr wird nicht vom VEM verarbeitet, sondern direkt an den Network IO Virtualization (NIV)-Adapter weitergeleitet.

Um den Hochleistungsmodus zu verwenden, sollte er von der Portprofilkonfiguration angefordert und vom VM-Betriebssystem und vom virtuellen Adapter unterstützt werden. Weitere Informationen hierzu finden Sie weiter unten in diesem Dokument.

Definitionen

- Virtuelles Ethernet-Modul (VEM) Cisco Software-Modul, das im ESX-Hypervisor ausgeführt wird und die VNLink-Implementierung in einem einzigen Paket ermöglicht

- Network IO Virtualization (NIV) verwendet VNtagging, um mehrere Virtual Network Links (VN-Link) über denselben physischen Ethernet-Kanal bereitzustellen.

- Data Center Bridging Capability Exchange (DCBX)

- VNIC Interface Control (VIC)

- Virtuelle NIC (VNIC), die einen Host-Endpunkt angibt. Er kann einer aktiven VIF oder einer Standby-VIF zugeordnet werden.

- Verteilter virtueller Port (DVPort) VNIC ist mit dem DVP-Port im VEM verbunden.

- NIV Virtual Interface (VIF), das an einem Netzwerkendpunkt angezeigt wird

- Virtual Ethernet (vEth)-Schnittstelle stellt VIF am Switch dar

- Passthrough-Switch (PTS) VEM-Modul im Hypervisor installiert

Konfigurieren

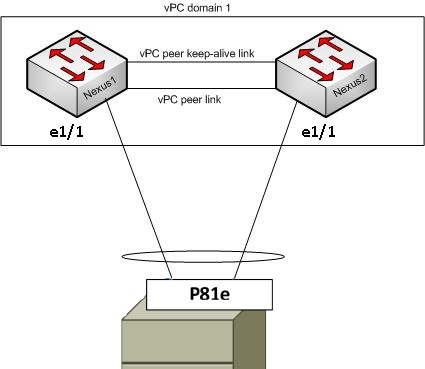

Die Topologie ist ein UCS-C-Server mit P81E VIC Dual-Homed zu zwei Nexus 5548 VPC-Switches.

Netzwerkdiagramm

Diese erforderlichen Komponenten müssen bereits vorhanden sein:

- Der VPC wird zwischen den beiden Nexus 5000-Switches richtig konfiguriert und initialisiert.

- VMWare vCenter wird installiert und über einen vSphere-Client verbunden.

- ESXi wird auf dem UCS-C-Server installiert und dem vCenter hinzugefügt.

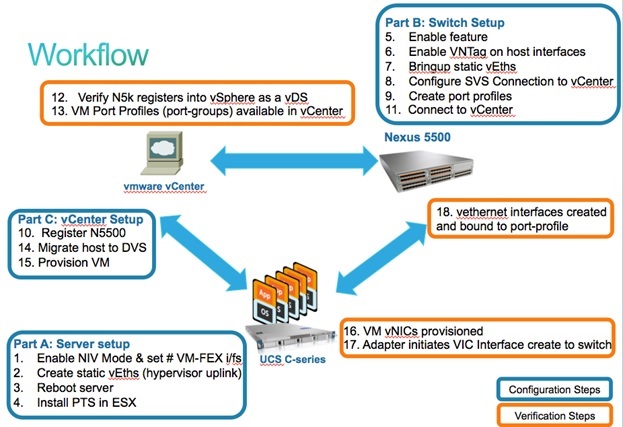

Die Konfigurationsschritte werden hier zusammengefasst:

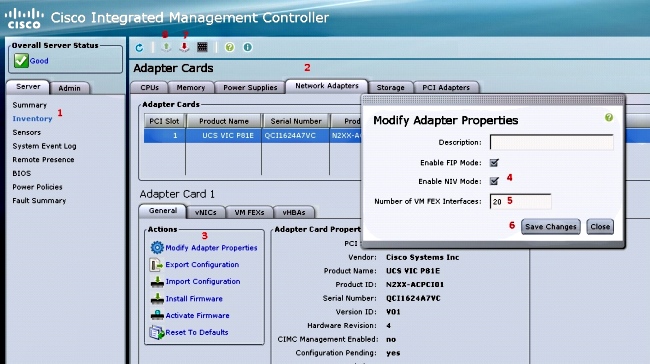

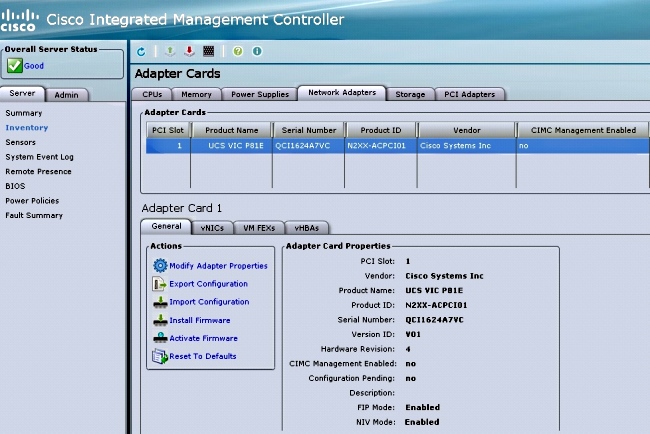

- Aktivieren Sie den NIV-Modus auf dem Server-Adapter:

- Stellen Sie über HTTP eine Verbindung zur Cisco Integrated Management Controller (CIMC)-Schnittstelle her, und melden Sie sich mit den Administratorberechtigungen an.

- Wählen Sie Bestand > Netzwerkadapter > Adaptereigenschaften ändern aus.

- Aktivieren Sie den NIV-Modus, legen Sie die Anzahl der VM-FEX-Schnittstellen fest, und speichern Sie die Änderungen.

- Schalten Sie den Server aus und dann ein.

Wenn der Server wieder online ist, stellen Sie sicher, dass NIV aktiviert ist:

- Stellen Sie über HTTP eine Verbindung zur Cisco Integrated Management Controller (CIMC)-Schnittstelle her, und melden Sie sich mit den Administratorberechtigungen an.

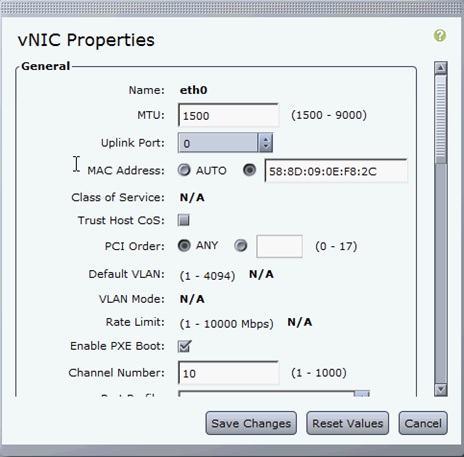

- Erstellen Sie zwei statische vEths auf dem Server.

Um zwei VNICs zu erstellen, wählen Sie Inventory > Network Adapters > VNICs > Add aus.

Dies sind die wichtigsten Felder, die definiert werden müssen:

- Zu verwendender VIC-Uplink-Port (P81E verfügt über zwei Uplink-Ports, auf die 0 und 1 verwiesen wird).

- Kanalnummer: Dies ist eine eindeutige Channel-ID der VNIC auf dem Adapter. Dies wird im Befehl bind unter der vEth-Schnittstelle auf dem Nexus 5000 referenziert. Der Umfang der Kanalnummer ist auf die physische VNTag-Verbindung beschränkt. Der Kanal kann als "virtuelle Verbindung" auf der physischen Verbindung zwischen Switch und Server-Adapter betrachtet werden.

- Portprofil: Die Liste der auf dem Upstream Nexus 5000 definierten Portprofile kann ausgewählt werden. Wenn der Nexus 5000 mit dem Befehl zum automatischen Erstellen von vEthernet konfiguriert ist, wird automatisch eine vEth-Schnittstelle auf dem Nexus 5000 erstellt. Beachten Sie, dass nur die vEthernet-Portprofilnamen an den Server übergeben werden (keine Portprofilkonfiguration). Dies geschieht, nachdem die VNTag-Link-Verbindung hergestellt und die ersten Handshake- und Verhandlungsschritte zwischen dem Switch und dem Server-Adapter ausgeführt wurden.

- Uplink-Failover aktivieren: Die VNICs führen ein Failover auf den anderen P81E-Uplink-Port durch, wenn der konfigurierte Uplink-Port offline geht.

- Zu verwendender VIC-Uplink-Port (P81E verfügt über zwei Uplink-Ports, auf die 0 und 1 verwiesen wird).

- Starten Sie den Server neu.

- Installieren Sie das VEM auf dem ESXi-Host.

Ein Beispiel für die VEM-Installation auf dem ESXi-Host finden Sie im Installing or Upgrade the Cisco VEM Software Bundle on an ESX or ESXi Host in Cisco UCS Manager VM-FEX for VMware GUI Configuration Guide, Release 2.1. - Virtualisierungsfunktionen und VM-FEX- und HTTP-Funktionen:

(config)# install feature-set virtualization

(config)# feature-set virtualization

(config)# feature vmfex

(config)# feature http-server

(Optional) Allow the Nexus 5000 to auto-create its Vethernet interfaces when the

corresponding vNICs are defined on the server:

(config)# vethernet auto-create - Aktivieren Sie VNTag auf Host-Schnittstellen.

Configure the N5k interface that connects to the servers in VNTAG mode:

(config)# interface Eth 1/1

(config-if)# switchport mode vntag

(config-if)# no shutdown - Aufrufen von statischen vEths.

Aktivieren Sie auf beiden Nexus 5500-Switches die statischen virtuellen vEth-Schnittstellen, die mit den beiden statischen VNICs verbunden werden sollen, die auf der Server-VIC aktiviert sind.

Geben Sie auf dem Nexus 5548-A Folgendes ein:interface vethernet 1

bind interface eth 1/1 channel 10

no shutdown

Geben Sie auf dem Nexus 5548-B Folgendes ein:interface vethernet 2

bind interface eth 1/1 channel 11

no shutdown

Alternativ können diese vEth-Schnittstellen automatisch mit dem Befehl vethernet auto-create erstellt werden.

Hier ein Beispiel.

Konfigurieren Sie auf jedem der beiden Nexus 5000:interface Vethernet1

description server_uplink1

bind interface Ethernet101/1/1 channel 11

bind interface Ethernet102/1/1 channel 11

interface Vethernet2

description server_uplink2

bind interface Ethernet101/1/1 channel 12

bind interface Ethernet102/1/1 channel 12 - Konfigurieren Sie die SVS-Verbindung mit vCenter, und stellen Sie eine Verbindung her.

Konfigurieren Sie auf beiden Nexus 5500-Switches Folgendes:svs connection <name>

protocol vmware-vim

remote ip address <vCenter-IP> vrf <vrf>

dvs-name <custom>

vmware dvs datacenter-name <VC_DC_name>

Stellen Sie nur auf dem primären VPC-Switch eine Verbindung mit vCenter her:svs connection <name>

connect

Sample configuration on VPC primary:

svs connection MyCon

protocol vmware-vim

remote ip address 10.2.8.131 port 80 vrf management

dvs-name MyVMFEX

vmware dvs datacenter-name MyVC

connect

Nachfolgend finden Sie eine Beispielkonfiguration für sekundäre VPC:svs connection MyCon

protocol vmware-vim

remote ip address 10.2.8.131 port 80 vrf management

dvs-name MyVMFEX

vmware dvs datacenter-name MyVC - Erstellen Sie auf dem Nexus 5000 Portprofile.

Konfigurieren Sie auf beiden Nexus 5500-Switches Portprofile für die VM-FEX-VNICs. Diese Portprofile werden als Portgruppen des DVS-Switches in vCenter angezeigt.

Hier ein Beispiel:vlan 10,20

port-profile type vethernet VM1

dvs-name all

switchport mode access

switchport access vlan 10

no shutdown

state enabled

port-profile type vethernet VM2

dvs-name all

switchport mode access

switchport access vlan 20

no shutdown

state enabled

VM-Hochleistungsmodus

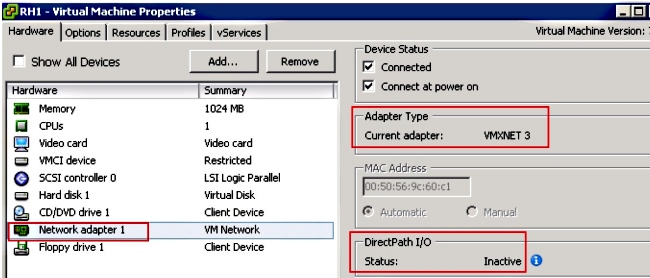

Um den High-Performance-Modus (DirectPath IO) zu implementieren und den Hypervisor für den VM-Datenverkehr zu umgehen, konfigurieren Sie das vEthernet-Port-Profil mit dem Befehl High Performance Host Network. Bei VPC-Topologien sollte das Portprofil immer auf beiden VPC Peer-Switches bearbeitet werden. Beispiel:port-profile type vethernet VM2

high-performance host-netio

Um den Hochleistungsmodus betreiben zu können, muss Ihr VM über folgende zusätzliche Voraussetzungen verfügen:

- Der virtuelle VM-Adapter muss vom Typ vmxnet3 sein (in vCenter einchecken: Klicken Sie mit der rechten Maustaste im rechten Menü auf VM > Einstellungen bearbeiten > Netzwerkadapter > Adaptertyp.)

- Die VM muss über eine vollständige Speicherreservierung verfügen (in vCenter: Klicken Sie mit der rechten Maustaste auf VM > Einstellungen bearbeiten > Registerkarte Resources (Ressourcen) > Memory (Speicher > Schieberegler für die Reservierung nach rechts).

- Das Betriebssystem, das auf der VM ausgeführt wird, sollte diese Funktion unterstützen.

Hier sehen Sie, wie Sie den Hochleistungsmodus (DirectPath IO) bei der Verwendung überprüfen.

Unter den VM-Hardwareeinstellungen wird im rechten Menü das DirectPath-I/O-Feld als aktiv angezeigt, wenn der VM-Hochleistungsmodus verwendet wird, und als inaktiv, wenn der Standard-VM-Passthrough-Modus verwendet wird.

- Der virtuelle VM-Adapter muss vom Typ vmxnet3 sein (in vCenter einchecken: Klicken Sie mit der rechten Maustaste im rechten Menü auf VM > Einstellungen bearbeiten > Netzwerkadapter > Adaptertyp.)

- Registrieren Sie den primären VPC Nexus 5548 in vCenter:

Stellen Sie über HTTP eine Verbindung zum primären Nexus 5548 VPC her, und laden Sie die XML-Erweiterungsdatei herunter:

Registrieren Sie anschließend das Plug-in für die Erweiterung in vCenter: Wählen Sie Plug-ins > Plug-ins verwalten > klicken Sie mit der rechten Maustaste > Neues Plug-in. - Verbindung mit vCenter herstellen (Siehe Schritt 8.)

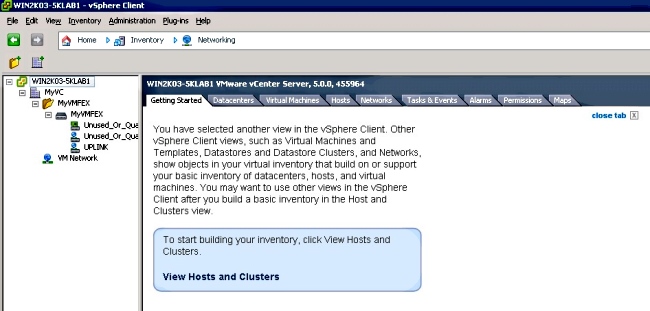

- Überprüfen Sie, ob der Nexus 5000 als vDS in vSphere registriert wird:

Überprüfen Sie die Erstellung eines neuen DVS unter vCenter mit dem unter "dvs-name" unter "svs connection" (SVS-Verbindung) definierten Namen auf dem Nexus 5000: Wählen Sie Home > Inventory > Networking aus.

Überprüfen Sie auf dem primären Nexus 5000 VPC-Switch mit dem folgenden Befehl, ob die SVS-Verbindung online ist:n5k1# show svs connections

Local Info:

-----------

connection MyCon:

ip address: 10.2.8.131

remote port: 80

vrf: management

protocol: vmware-vim https

certificate: default

datacenter name: MyVC

extension key: Cisco_Nexus_1000V_126705946

dvs name: MyVMFEX

DVS uuid: 89 dd 2c 50 b4 81 57 e4-d1 24 f5 28 df e3 d2 70

config status: Enabled

operational status: Connected

sync status: in progress

version: VMware vCenter Server 5.0.0 build-455964

Peer Info:

----------

connection MyCon:

ip address: 10.2.8.131

remote port: 80

vrf: management

protocol: vmware-vim https

extension key: Cisco_Nexus_1000V_126705946

certificate: default

certificate match: TRUE

datacenter name: MyVC

dvs name: MyVMFEX

DVS uuid: -

config status: Disabled

operational status: Disconnected

n5k1# - Stellen Sie sicher, dass VM-Portgruppen in vCenter verfügbar sind.

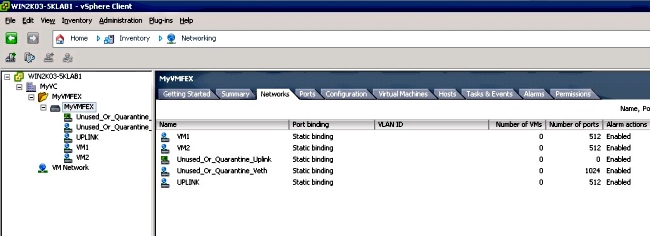

Die auf dem Nexus 5000 definierten vEthernet-Portprofile sollten in vCenter in der Netzwerkansicht unter dem DVS als Portgruppen angezeigt werden:

- Migration von ESXi-Hosts auf den DVS

Wählen Sie in VSphere Home > Inventory > Networking aus, klicken Sie mit der rechten Maustaste auf den DVS-Namen, und fügen Sie Host hinzu, um die ESXi-Hosts dem DVS hinzuzufügen.

Die virtuellen Adapter-FEX-Schnittstellen sind die ESXi-Hosts-Uplinks. Wählen Sie die Standard-Uplink-Port-Gruppe (Unused_or_Quarantine_Uplink) für diese Uplink-Ports aus. - Bereitstellung des virtuellen Systems

Wählen Sie eine VM-FEX-Portgruppe für den Netzwerkadapter einer VM aus (klicken Sie mit der rechten Maustaste auf VM > Edit Settings > Network Adapter > Network Label (Einstellungen bearbeiten > Netzwerkadapter > Netzwerkbezeichnung im rechten Menü). - Bereitstellung von VM-VNICs

- Adapter initiiert VIC-Schnittstelle, die zum Switch erstellt wird.

Wenn ein VM-Netzwerkadapter einer VM-FEX-Portgruppe zugeordnet wird, wird auf dem Nexus 5000 dynamisch eine vEthernet-Schnittstelle erstellt. Der Bereich der dynamisch erstellten vEth-Schnittstellen beginnt bei 32769.

Diese Schnittstellen können über folgende Befehle überprüft werden:# show interface virtual status

# show interface virtual summary

Überprüfung und Fehlerbehebung

In diesem Abschnitt überprüfen Sie, ob Ihre Konfiguration ordnungsgemäß funktioniert, und beheben Sie alle auftretenden Probleme.

- Geben Sie den folgenden Befehl ein, um zu überprüfen, ob die beiden statischen VNICs des UCS-C-Servers mit dem VN-Link mit den statischen festen vEth-Schnittstellen auf dem Nexus 5500 verbunden sind:

n5k1# show system internal dcbx info interface e1/1

Interface info for if_index: 0x1a001000(Eth1/1)

tx_enabled: TRUE

rx_enabled: TRUE

dcbx_enabled: TRUE

DCX Protocol: CEE

DCX CEE NIV extension: enabled

<output omitted> - Bei Aktiv/Standby-Topologien zu zwei Dual-Homed FEXs muss die vEth-Schnittstelle auf den beiden Nexus 5000 VPC-Switches entweder als Aktiv- oder Standby-Modus angezeigt werden.

Der Modus wird hier als unbekannt angezeigt:

n5k1# show int virtual status

Interface VIF-index Bound If Chan Vlan Status Mode Vntag

-------------------------------------------------------------------------

Veth1 VIF-16 Eth101/1/1 11 1 Up Active 2

Veth1 None Eth102/1/1 11 0 Init Unknown 0

Veth2 None Eth101/1/1 12 0 Init Unknown 0

Veth2 None Eth102/1/1 12 0 Init Unknown 0

Veth3 VIF-18 Eth101/1/2 11 1 Up Active 2

Veth3 None Eth102/1/2 11 0 Init Unknown 0

Veth4 None Eth101/1/2 12 0 Init Unknown 0

Veth4 VIF-19 Eth102/1/2 12 1 Up Active 3

Wenn Sie auf einen unbekannten Modus stoßen, müssen Sie den Uplink-Failover-Modus auf der VNIC aktivieren. Stellen Sie außerdem sicher, dass die im CIMC angegebene Kanalnummer mit der in der vEthernet-Konfiguration angegebenen Kanalnummer übereinstimmt.

Die richtige Ausgabe sollte wie folgt aussehen:n5k1# show int virtual status

Interface VIF-index Bound If Chan Vlan Status Mode Vntag

-------------------------------------------------------------------------

Veth1 VIF-27 Eth101/1/1 11 1 Up Active 2

Veth1 VIF-35 Eth102/1/1 11 1 Up Standby 2

Veth2 VIF-36 Eth101/1/1 12 1 Up Standby 3

Veth2 VIF-33 Eth102/1/1 12 1 Up Active 3

Veth3 VIF-30 Eth101/1/2 11 1 Up Active 2

Veth3 VIF-21 Eth102/1/2 11 1 Up Standby 2

Veth4 VIF-24 Eth101/1/2 12 1 Up Standby 3

Veth4 VIF-31 Eth102/1/2 12 1 Up Active 3 - vEth-Schnittstellen werden nicht auf dem Switch angezeigt.

Überprüfen Sie im Menü UCS-C-Server CIMC HTTP, ob:

- NIV ist auf dem Adapter aktiviert.

- Auf dem Adapter wird eine Anzahl von VM-FEX-Schnittstellen konfiguriert, die nicht null sind.

- Adapter-Failover ist auf der VNIC aktiviert.

- Der UCS-C-Server wurde neu gestartet, nachdem die obige Konfiguration vorgenommen wurde.

- NIV ist auf dem Adapter aktiviert.

- Ethernet-Schnittstellen sind nicht online.

Überprüfen Sie, ob VIF_CREATE in diesem Befehl angezeigt wird:# show system internal vim info logs interface veth 1

03/28/2014 16:31:47.770137: RCVD VIF CREATE request on If Eth1/32 <<<<<<<

03/28/2014 16:31:53.405004: On Eth1/32 - VIC CREATE sending rsp for msg_id 23889

to completion code SUCCESS

03/28/2014 16:32:35.739252: On Eth1/32 - RCVD VIF ENABLE. VIF-index 698 msg id 23953

VIF_ID: 0, state_valid: n, active

03/28/2014 16:32:35.802019: On Eth1/32 - VIC ENABLE sending rsp for msg_id 23953 to

completion code SUCCESS

03/28/2014 16:32:36.375495: On Eth1/32 - Sent VIC SET, INDEX: 698, msg_id 23051, up,

enabled, active, cos 0VIF_ID: 50 vlan:

1 rate 0xf4240, burst_size 0xf

03/28/2014 16:32:36.379441: On Eth1/32 - RCVD VIC SET resp, INDEX: 698, msg_id 23051,

up, enabled,active, cos 0, completion

code: 100

Wenn VIF_CREATE nicht angezeigt wird oder der Switch nicht ordnungsgemäß reagiert, führen Sie die folgenden Schritte aus:

- Überprüfen Sie in vCenter, ob der DVS-Switch ordnungsgemäß mit zwei physischen Uplinks für den ESX-Host konfiguriert wurde (klicken Sie mit der rechten Maustaste auf den DVS-Switch > Hosts verwalten > Physische Adapter auswählen).

- Überprüfen Sie in vCenter, ob VMNIC das richtige Netzwerklabel/Portprofil ausgewählt hat (klicken Sie mit der rechten Maustaste auf VM > Einstellungen bearbeiten > klicken Sie auf Netzwerkadapter > aktivieren Sie das Netzwerklabel).

- Überprüfen Sie in vCenter, ob der DVS-Switch ordnungsgemäß mit zwei physischen Uplinks für den ESX-Host konfiguriert wurde (klicken Sie mit der rechten Maustaste auf den DVS-Switch > Hosts verwalten > Physische Adapter auswählen).

- Die SVS-Verbindung mit vCenter ist nicht online.

Wie in Schritt 12 im vorherigen Abschnitt gezeigt, können Sie mithilfe dieses Verfahrens überprüfen, ob der Nexus 5000 mit vCenter verbunden war:

- Überprüfen Sie in vCenter, ob der DVS in der Netzwerkansicht angezeigt wird.

- Überprüfen Sie auf dem primären Nexus 5000 VPC, ob das SVS verbunden ist (verwenden Sie den Befehl show svs connection).

Falls die Verbindung nicht hergestellt wird, überprüfen Sie Folgendes:

- Die SVS-Konfiguration ist auf beiden VPC-Peers identisch.

- VPC wird initialisiert und die Rollen sind korrekt eingerichtet.

- Das XML-Zertifikat für den primären VPC-Switch wird in vCenter installiert.

- Für den primären VPC-Switch ist "Connect" im Konfigurationsmodus "SVS connection" konfiguriert.

- Der Name des Rechenzentrums entspricht dem für vCenter verwendeten Namen.

- Der Befehl SVS remote konfiguriert das richtige VRF (Virtual Routing and Forwarding), und der Switch verfügt über IP-Verbindungen zur vCenter-IP-Adresse.

Wenn alle diese Bedingungen erfüllt sind, die SVS-Verbindung aber immer noch nicht erfolgreich ist, holen Sie diese Ausgabe ein und wenden Sie sich an das Cisco Technical Assistance Center (TAC):show msp port-profile vc sync-status

show msp internal errors

show msp internal event-history msgs

show vms internal errors

show vms internal event-history msgs - Überprüfen Sie in vCenter, ob der DVS in der Netzwerkansicht angezeigt wird.

- Der Nexus 5500-Switch ist nicht über HTTP erreichbar.

Überprüfen Sie, ob das http-Serverfeature aktiviert ist:n5k1# show feature | i http

http-server 1 disabled

n5k1# conf t

Enter configuration commands, one per line. End with CNTL/Z.

n5k1(config)# feature http-server

n5k1(config)#

Revisionsverlauf

| Überarbeitung | Veröffentlichungsdatum | Kommentare |

|---|---|---|

1.0 |

15-May-2014 |

Erstveröffentlichung |

Cisco kontaktieren

- Eine Supportanfrage öffnen

- (Erfordert einen Cisco Servicevertrag)

Feedback

Feedback